【卷积神经网络的并行计算】:提升训练速度的秘诀

发布时间: 2024-09-03 13:02:31 阅读量: 226 订阅数: 89

# 1. 卷积神经网络(CNN)简介

## 1.1 CNN 的起源与发展

卷积神经网络(CNN)是一种深度学习架构,它在图像识别、视频分析、自然语言处理等领域取得了突破性进展。CNN 通过模拟人类视觉系统的工作方式,利用卷积层提取图像特征,并结合池化层降低参数数量,显著提高了处理效率。

## 1.2 CNN 的核心组件

CNN 主要由卷积层、激活函数、池化层、全连接层等核心组件构成。卷积层通过滤波器捕捉局部特征,激活函数如ReLU引入非线性,池化层降低特征维度,全连接层用于最后的分类或回归任务。

```python

# 一个简单的CNN模型实现示例

from keras.models import Sequential

from keras.layers import Conv2D, MaxPooling2D, Flatten, Dense

model = Sequential()

model.add(Conv2D(filters=32, kernel_size=(3, 3), activation='relu', input_shape=(64, 64, 3)))

model.add(MaxPooling2D(pool_size=(2, 2)))

model.add(Flatten())

model.add(Dense(units=10, activation='softmax'))

```

## 1.3 CNN 的应用领域

CNN 不仅在计算机视觉中有着广泛应用,也扩展到了医疗图像分析、自动驾驶汽车、智能监控和推荐系统等多个领域。它的灵活性和高效的特征提取能力使其成为AI研究和工业界的核心技术之一。

# 2. 并行计算基础

### 2.1 并行计算的理论基础

#### 2.1.1 并行计算的概念与模型

并行计算是一种计算方法,它涉及到同时使用多个计算资源解决计算问题。在并行计算中,计算任务被拆分成更小的部分,这些部分可以同时在多核处理器或多个处理器之间执行。并行计算的目的是缩短求解问题的时间,并处理大型数据集,这些是传统串行计算难以应对的。

并行计算模型分为多种类型,包括但不限于:

- SIMD(单指令多数据):单个指令流控制多个数据流,一般用于相同的操作并行处理。

- MIMD(多指令多数据):每个处理器可以执行不同的指令流,处理不同的数据流,适用于需要大量并行处理的复杂任务。

- SPMD(单程序多数据):每个处理器执行相同的程序但对不同的数据集进行操作,这是一种常见的并行编程模型。

并行计算的效率取决于算法、硬件和数据的特性。为了实现有效的并行计算,开发者必须了解如何设计算法和程序以适应不同的并行计算模型。

#### 2.1.2 硬件加速器与并行性提升

硬件加速器是用来加速特定计算任务的专用硬件。它们通过执行特定的并行操作来提高性能。常见的硬件加速器包括:

- GPU(图形处理单元):最初设计用于图形渲染,但因其高度并行的结构,现在广泛用于科学计算和深度学习。

- FPGA(现场可编程门阵列):通过编程来自定义硬件逻辑,以并行方式执行特定算法。

- ASIC(专用集成电路):为特定应用定制的集成电路,提供最优的性能和能效。

这些加速器通过提供大量的并行处理能力,大大提升了并行计算的效率。例如,GPU拥有多达数千个核心,可以同时处理大量的并行计算任务。在使用这些硬件进行并行计算时,关键是找到它们的最优使用方法,以最大化并行性带来的性能提升。

### 2.2 并行计算的实践工具

#### 2.2.1 GPU在并行计算中的应用

GPU在并行计算中的应用已经成为现代计算不可或缺的一部分,尤其是在图像和视频处理、科学计算以及深度学习领域。

GPU具有大量的并行执行单元,可以同时处理成千上万的线程。利用这一特性,它能够极大地加速矩阵乘法和其他在深度学习中常见的数学运算。深度学习框架如TensorFlow和PyTorch都支持GPU加速,使得训练深度神经网络的时间大为减少。

在实现GPU并行计算时,开发者必须了解如何将计算任务有效地映射到GPU的线程和块中,并确保内存访问模式高效,以减少延迟和带宽消耗。正确使用GPU并行计算还需要考虑任务分配的负载均衡,避免出现空闲核心。

#### 2.2.2 常用的并行计算框架和库

随着并行计算需求的增长,出现了多种并行计算框架和库,它们简化了并行编程的复杂性,使得开发者能够更高效地利用并行计算资源。

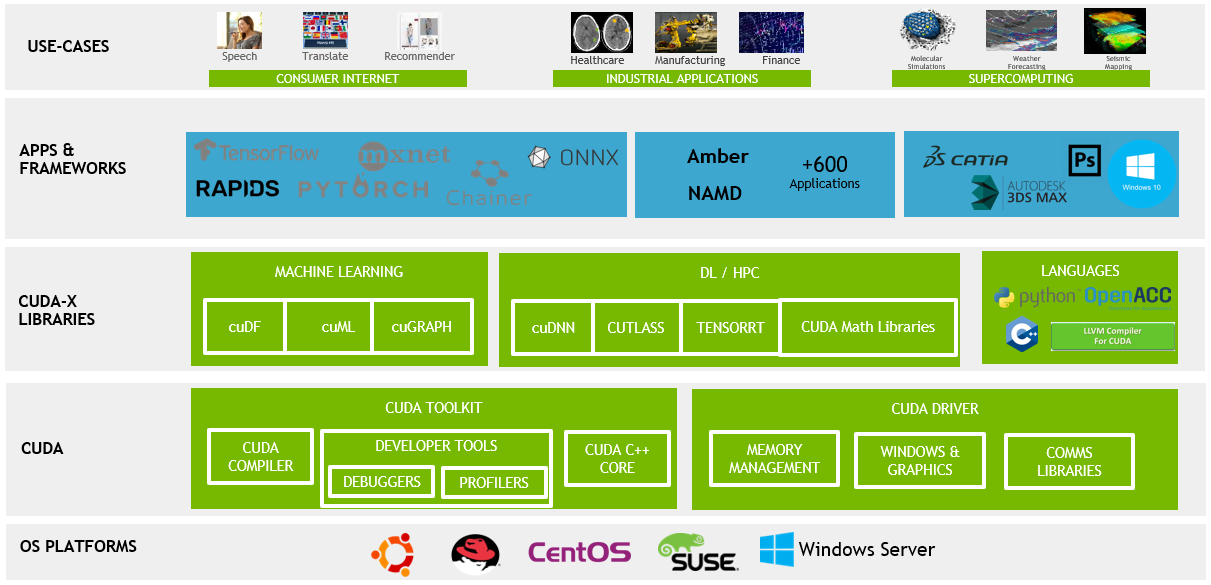

- CUDA:NVIDIA提供的一个并行计算平台和编程模型,允许开发者使用C、C++以及其他语言直接利用GPU进行高性能计算。

- OpenCL(Open Computing Language):一个开放标准,用于编写在不同平台(包括CPU、GPU以及其他处理器)上执行的程序。

- MPI(消息传递接口):一个库规范,用于在多台计算机上进行并行编程。

- Intel TBB(Threading Building Blocks):一个C++模板库,用于多核处理器的并行编程。

选择合适的框架和库,开发者可以基于自己的需求和硬件条件,更有效地实现并行计算。不同的框架和库可能在性能、易用性和适用范围上有所差异,了解它们的特点对于并行计算的实现至关重要。

### 2.3 并行计算中的数据管理

#### 2.3.1 数据并行与模型并行的区别

数据并行与模型并行是两种常见的并行策略,它们在不同层次上分割计算任务。

- 数据并行:在数据并行中,同一个模型在多个计算单元上执行,每个单元处理整个数据集的不同部分。这种方法适用于大规模数据集,可以快速扩展。

- 模型并行:在模型并行中,模型的不同部分在不同的计算单元上执行。当模型太大无法放入单个处理器时,就需要使用模型并行。模型并行更适用于模型维度非常高或者结构非常复杂的情况。

两种策略各有优劣。数据并行易于实现,但可能受到内存大小的限制;模型并行在内存和带宽管理上更灵活,但设计和实现复杂度更高。

#### 2.3.2 数据加载和预处理的并行策略

在并行计算中,数据加载和预处理过程也需要并行化以提高效率。通常,这涉及到将大规模数据集分解成较小的批次,并并行地进行加载和预处理。

一种常见的数据加载策略是使用多线程或异步I/O操作。在Python中,可以使用`concurrent.futures`模块来实现多线程数据加载。

```python

from concurrent.futures import ThreadPoolExecutor

import numpy as np

def load_data(file_path):

# 加载数据的逻辑

pass

# 使用线程池并行加载数据

def parallel_load_data(file_paths):

with ThreadPoolExecutor() as executor:

# 提交任务给线程池

future_to_file = {executor.submit(load_data, path): path for path in file_paths}

for future in concurrent.futures.as_completed(future_to_file):

file_path = future_to_file[future]

try:

data = future.result()

# 处理数据

except Exception as exc:

print(f'{file_path} generated an exception: {exc}')

# 输出所有数据

# ...

# 示例文件路径列表

file_paths = [...]

parallel_load_data(file_paths)

```

并行数据预处理可能包括数据归一化、标准化、增强等操作。这些操作可以通过编写支持并行处理的代码库来实现,并使用诸如Python的`multiprocessing`模块或`joblib`库。

并行数据加载和预处理可以显著缩短数据准备阶段的时间,为训练阶段做好准备,特别是在处理大型数据集时。需要注意的是,过多的并行线程可能导致资源竞争和调度开销,因此需要根据实际硬件配置和数据特性,合理设计并行策略和线程数。

# 3. CNN并行化的关键技术

## 3.1 数据并行策略

数据并行是并行化CNN最常用的一种策略,能够显著加快训练速度并提高模型性能。通过将数据集分散到多个计算单元上,每个计算单元可以在其部分数据集上独立进行前向传播和反向传播,然后同步更新模型参数。

### 3.1.1 单GPU与多GPU数据并行

单GPU训练在处理大规模数据集时常常受限于计算能力和内存容量。多GPU数据并行通过在多个GPU上分配数据子集来解决这一问题。在单GPU训练中,模型参数只有一份拷贝;而在多GPU训练中,每个GPU保存一份模型参数的本地拷贝。

### 3.1.2 同步与异步梯度更新机制

多GPU训练时需要解决的是如何同步各个GPU上的模型参数。同步梯度更新机制会

0

0