【CNN模型压缩】:减少模型大小的实用技巧

发布时间: 2024-09-03 12:38:08 阅读量: 72 订阅数: 70

java+sql server项目之科帮网计算机配件报价系统源代码.zip

# 1. CNN模型压缩概述

随着深度学习技术的飞速发展,卷积神经网络(CNN)已在多个领域取得了显著成就。然而,高精度CNN模型通常需要大量的计算资源和存储空间,这使得它们在资源受限的设备上部署变得困难。为了克服这一挑战,模型压缩技术应运而生。模型压缩不仅能够减小模型尺寸,还可以提高计算效率,从而使得深度学习模型能够在移动设备和边缘计算设备上高效运行。在这一章中,我们将概述CNN模型压缩的概念,并简要介绍后续章节将深入探讨的理论基础和应用技巧。

# 2. 理论基础与模型压缩技术

### 深度学习模型压缩的必要性

深度学习模型,尤其是卷积神经网络(CNN),在图像识别、语音识别、自然语言处理等领域取得突破性进展。然而,这些模型通常包含数百万甚至数十亿的参数,这导致了几个关键问题,尤其是在部署模型到资源受限的设备时。

#### 模型大小对部署的影响

一个未经压缩的大型深度学习模型需要大量的存储空间,这在移动设备或嵌入式系统上可能并不现实。例如,在智能手机上运行一个深度学习模型可能因为存储限制而变得困难,即使该设备具备足够的计算能力。大型模型还意味着需要更长的加载时间,这在需要快速响应的应用场景中是不可接受的。

#### 计算资源的限制

除了存储限制,大型模型也需要显著更多的计算资源。这意味着更长的推理时间,增加了能耗,这在移动设备和边缘计算环境中尤其成问题。为了使深度学习模型能够在这些资源受限的设备上运行,模型压缩技术变得至关重要。

### 模型压缩的基础理论

#### 参数冗余与剪枝

参数冗余是指在深度学习模型中存在一些不重要的参数,这些参数对模型的输出几乎没有影响。剪枝是一种通过移除这些冗余参数来减小模型大小的技术。剪枝可以通过不同的策略实现,例如基于重要性的剪枝,其中参数按照其对输出的影响程度进行排序,然后移除影响最小的参数。

#### 量化理论基础

量化是另一种模型压缩技术,它将模型中的浮点数参数转换为整数。这种转换通常基于线性变换,以保持输出分布的一致性。量化可以显著减少模型的存储需求和计算量,同时在一些情况下还能提高推理速度。

#### 低秩近似与矩阵分解

低秩近似是通过找到一个近似矩阵,该矩阵的秩低于原始矩阵,以表示原始模型的参数。这可以通过矩阵分解技术如奇异值分解(SVD)实现。低秩近似可以减少模型中参数的数量,从而实现压缩。

### 常见模型压缩技术

#### 权重共享与参数共享

权重共享是通过让多个连接共享相同的权重来减少模型的参数数量。在卷积层中,一个常见的技术是使用具有相同权重的滤波器。在循环神经网络(RNN)中,参数共享是通过让模型的不同时间步使用相同的参数实现的。

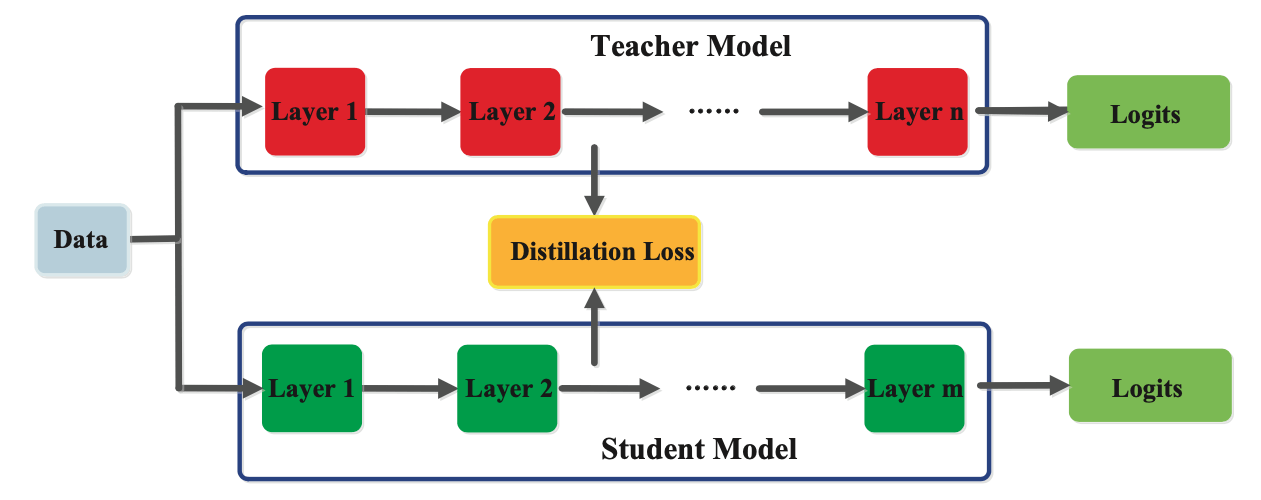

#### 知识蒸馏

知识蒸馏是将一个大型的“教师”模型的知识转移到一个更小的“学生”模型中的过程。这个过程通常涉及到在训练“学生”模型时,不仅使用真实的标签,还使用来自“教师”模型的输出(即软标签)。这种方法能够保持模型性能的同时实现显著的压缩。

#### 稀疏化技术

稀疏化技术通过构建稀疏网络来减少模型中的非零参数数量。这些技术可以基于剪枝、结构化剪枝(移除整个滤波器或神经元),或通过神经架构搜索(NAS)自动找到稀疏结构。稀疏化可以大幅降低计算成本,但需要精心设计的存储和计算策略来高效利用稀疏性。

模型压缩技术的探讨不仅限于算法层面,还需要考虑到其对模型性能的影响以及在实际应用中的可行性。在接下来的章节中,我们将深入讨论模型压缩的实践技巧,并展示如何在不同场景下应用这些技术以达到优化效果。

# 3. 模型压缩实践技巧

模型压缩的实践技巧是将理论转化为实际应用的关键步骤。在这一章节中,我们将深入探讨如何实现权重剪枝与稀疏化、量化技术的应用以及参数共享与转换。通过案例分析和代码演示,我们将了解如何在实际应用中优化深度学习模型,从而达到减少模型大小和提高运行效率的目的。

## 3.1 权重剪枝与稀疏化实现

权重剪枝是一种减少模型冗余的有效技术。它通过删除网络中的某些参数来实现模型的稀疏性,进而减少模型的大小和提高推断速度。剪枝的策略和方法直接影响到模型压缩的效果。

### 3.1.1 剪枝的策略与方法

剪枝策略通常基于参数的重要性。重要性可以依据权重的绝对值大小、激活值的大小或对输出的影响等指标来定义。剪枝方法可以分为以下几种:

- **结构化剪枝**:按照一定的结构(如通道、层、核大小)进行剪枝,通常采用贪心算法或强化学习等方法。

- **非结构化剪枝**:剪枝过程中不考虑参数的结构,这通常会导致稀疏矩阵的产生。

以下是一个简单的权重剪枝算法的伪代码实现:

```python

import torch

def prune_weights(model, pruning_rate):

# 获取模型参数

weights = model.parameters()

# 对模型参数进行排序

sorted_weights = torch.sort(torch.abs(weights).flatten(), descending=True)

# 计算剪枝阈值

pruning_threshold = sorted_weights.values[pruning_rate * len(sorted_weights)]

# 应用剪枝阈值

for param in weights:

new_weights = torch.where(torch.abs(param) < pruning_threshold, 0, param)

# 更新参数

param.data = new_weights

```

在上述代码中,`prune_weights` 函数接受一个模型和剪枝率作为输入,计算出剪枝阈值,并将低于该阈值的参数设置为零,从而实现剪枝。需要注意的是,剪枝后可能需要对模型进行微调,以恢复因剪枝导致的性能下降。

### 3.1.2 稀疏矩阵的存储技巧

稀疏矩阵的存储是模型压缩中的重要环节,直接影响到模型在运行时的性能。稀疏矩阵的存储方式可以分为以下几种:

- **压缩行存储(Compressed Sparse Row, CSR)**:这是一种常用的稀疏矩阵存储格式,它将矩阵的非零元素存储在一个一维数组中,并记录每行非零元素的位置和行索引。

- **坐标列表(Coordinate List, COO)**:COO格式直接存储非零元素的行索引、列索引和值。

以下是使用CSR格式存储稀疏矩阵的示例代码:

```python

import torch

def to_csr_matrix(matrix):

# 非零元素的行索引

row_indices = torch.nonzero(matrix, as_tuple=True)[0]

# 非零元素的列索引

```

0

0