【深度卷积网络的注意力机制】:提升模型焦点的关键技术

发布时间: 2024-09-03 12:31:10 阅读量: 89 订阅数: 70

基于深度卷积神经网络的物体识别算法

# 1. 深度卷积网络的注意力机制概述

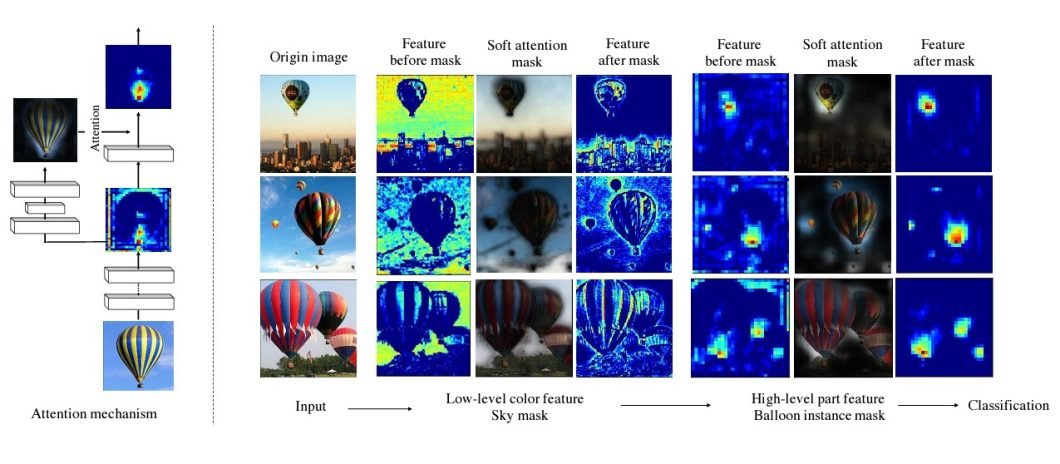

在现代深度学习模型中,注意力机制已经成为一种提高模型性能和效率的关键技术。特别是在深度卷积网络中,注意力机制可以帮助模型专注于图像的关键区域,从而提高识别和分类的准确性。通过赋予网络“集中注意力”的能力,它能够在处理数据时动态地调整其关注点,从而更有效地利用计算资源。随着深度学习技术的发展,注意力机制正逐渐成为各领域研究者关注的焦点,无论是在计算机视觉还是自然语言处理中,它的应用都极大地推动了智能算法的进步。

# 2. 注意力机制的理论基础

## 2.1 注意力机制在深度学习中的作用

### 2.1.1 传统深度学习模型的局限性

在深度学习的早期阶段,大多数模型依赖于重复的卷积层或循环层来提取特征和捕捉数据中的模式。然而,这种结构存在一些局限性。首先,它们往往需要大量的参数和计算资源,这在处理非常大的数据集时会造成性能瓶颈。此外,对于那些需要长时间序列依赖的学习任务,传统模型往往无法很好地捕捉长距离的依赖关系,因为这些模型通常只能在有限的范围内传播信息。

深度学习模型中的这些局限性,促使研究者们寻求更有效的机制来提高模型的性能,注意力机制应运而生。注意力机制允许模型在处理数据时动态地聚焦于最重要的部分,从而提高模型在各种任务中的表现。

### 2.1.2 注意力机制的概念和重要性

注意力机制可以看作是一种动态的信息过滤系统,它模仿了人类的注意力集中过程。在深度学习中,注意力机制的核心思想是为模型的每个输入赋予不同的权重。这些权重可以根据模型的当前状态和输入数据动态计算,使得模型能够专注于那些对当前任务最重要的信息。

引入注意力机制的重要性在于它能够增加模型的表达能力。通过注意力权重,模型不仅能够学习到数据中的局部特征,还能理解和利用数据之间的长距离依赖关系。这种机制对于需要理解复杂上下文的任务尤其重要,比如自然语言处理和图像识别。

## 2.2 注意力机制的核心组件

### 2.2.1 查询(Query)、键(Key)、值(Value)

注意力机制的核心组件包括三个部分:查询(Query)、键(Key)和值(Value)。它们通常来源于同一输入数据的不同方面,且它们之间的关系可以由以下数学表达式定义:

\[

\text{Attention}(Q, K, V) = \text{softmax}\left(\frac{QK^T}{\sqrt{d_k}}\right)V

\]

这里的 $Q$、$K$、$V$ 分别代表查询、键、值矩阵。注意力权重是通过 $Q$ 和 $K$ 的点积来计算的,然后通过 softmax 函数进行归一化处理,得到的权重用于加权 $V$。其中,$d_k$ 是键向量的维度。

- **查询(Query)**:它代表了模型当前需要处理的部分,如在机器翻译任务中,它可以是当前输出词的表示。

- **键(Key)**:它与查询相对应,用来评估和计算注意力权重,即确定哪些部分是重要的。

- **值(Value)**:它是实际用于更新的信息,通常与键相关联。

### 2.2.2 注意力权重的计算方法

注意力权重的计算方法直接影响到模型的性能和效率。最简单和最常见的方法是基于点积的注意力,其中查询和键的点积被用来计算匹配度。然后,将匹配度通过 softmax 函数进行归一化,得到最终的注意力权重。

计算过程如下:

- 首先,对于每个查询 $q_i$,计算它与所有键 $k_j$ 的点积 $q_i \cdot k_j$。

- 接着,为了防止点积过大导致softmax函数中数值不稳定,通常会除以 $\sqrt{d_k}$,其中 $d_k$ 是键向量的维度。

- 然后,将归一化的点积通过softmax函数进行处理,得到注意力权重 $a_{ij}$。

- 最后,将注意力权重应用到值向量上,得到加权的输出 $o_i = \sum_j a_{ij}v_j$。

这种方法有效地赋予了模型动态地关注输入数据某些部分的能力,这在处理复杂和长距离依赖的任务时特别有用。

## 2.3 注意力机制的类型和模型

### 2.3.1 硬注意力和软注意力的区别

在注意力机制的发展历程中,研究人员提出了不同类型的关注方式,其中最著名的两种是硬注意力(Hard Attention)和软注意力(Soft Attention)。它们的主要区别在于注意力权重的表示和应用方式。

- **硬注意力**:硬注意力模型会从输入数据中选择一个子集作为重要的部分,并忽略其它部分。选择的过程通常是随机的或者通过学习得到,这使得模型在训练时变得非常复杂和不稳定。

- **软注意力**:软注意力模型为输入数据的每个部分计算一个权重,并使用这些权重来加权输入数据的表示。这种方法使得模型在训练过程中更加稳定和可靠,因为梯度可以通过所有的输入数据传递。

尽管硬注意力在理论上能够为模型提供更强的表达能力,但软注意力因为其易于优化和实现,目前被广泛应用于各种深度学习任务中。

### 2.3.2 Squeeze-and-Excitation Networks (SENet)

Squeeze-and-Excitation Networks (SENet) 是一种特殊的注意力机制,它通过重新校准通道特征的表示来提升网络性能。SENet 的关键思想在于关注和增强对当前任务最有用的特征通道。

具体来说,SENet 引入了两个操作:Squeeze 和 Excitation。

- **Squeeze**:这部分的操作是全局平均池化,它将每个特征通道上的空间信息压缩到一个单一的值,这样就得到了一个全局分布的描述。

- **Excitation**:接下来是一个可学习的门控机制,它基于全局分布信息来调整各个通道的权重。这通常通过两个全连接层实现,最后用 sigmoid 激活函数得到最终的权重。

通过这种机制,SENet 不仅提高了模型的性能,还显著减少了模型的参数量,是注意力机制在卷积神经网络中的一种有效应用。

### 2.3.3 Transformer和自注意力机制

Transformer 模型是近年来深度学习领域的一个重大突破,它完全基于自注意力机制构建,并且没有使用任何循环层。Transformer 模型的成功极大地推动了注意力机制在自然语言处理(NLP)领域的广泛应用。

自注意力(Self-Attention)是一种特殊的注意力机制,允许模型对输入序列中的不同位置进行加权,使得每个位置都能够考虑整个序列的信息。在自注意力中,查询、键和值通常都来自输入序列本身。

Transformer 的关键特性包括:

- **多头注意力**:这是对自注意力的一种扩展,允许模型在不同的表示子空间中并行地学习信息。每个“头”学习输入数据的不同方面,然后将所有的头拼接起来,形成最终的输出。

- **位置编码**:由于自注意力本身不包含对序列中位置信息的考虑,Transformer 使用位置编码来引入位置信息。这通常是通过在输入表示中添加一个特定的编码来实现的,这个编码能够反映不同位置的信息。

Transformer 模型的出现,为许多 NLP 任务带来了前所未有的性能提升,并且它已经成为了构建复杂 NLP 系统的基石。

```mermaid

graph LR

A[输入序列] -->|位置编码| B[自注意力层]

B --> C[多头注意力]

C -->|拼接| D[前馈网络]

D -->|加权| A[输入序列]

```

上图展示了 Transformer 中自注意力和多头注意力的基本流程。通过这种结构,模型能够在处理每个词时都考虑到整个句子的上下文,显著提升了模型的理解能力。

# 3. 注意力机制的实现技术

## 3.1 注意力机制的参数化方法

### 3.1.1 多头注意力机制

在深度学习中,多头注意力机制(Multi-Head Attention, MHA)是一种广泛应用的参数化技术,它能够让模型在不同的表示子空间中并行地学习信息。多头注意力由多个“头”组成,每个头执行独立的注意力计算,之后将各个头的输出拼接起来,并通过一个线性层生成最终输出。

该技术的核心思想是,每个“头”可能会关注输入数据的不同部分,这样模型就能够捕捉到更加丰富和复杂的特征。例如,在处理自然语言时,一个“头”可能关注词的语法角色,而另一个“头”可能关注词的语义信息。

以 Transformer 模型为例,其核心编码器层使用了多头注意力,以下是其伪代码表示:

```python

import torch

import torch.nn as nn

import torch.nn.functional as F

class MultiHeadAttention(nn.Module):

def __init__(self, n_heads, d_model, dropout=0.1):

super().__

```

0

0