【卷积神经网络的模型部署】:从实验室到生产环境的无缝迁移

发布时间: 2024-09-03 13:11:09 阅读量: 262 订阅数: 89

有迁移学习的卷积神经网络模型冻结卷积层方法

# 1. 卷积神经网络基础回顾

在当今的深度学习领域,卷积神经网络(CNN)已成为图像识别和处理的核心技术之一。本章将对卷积神经网络的基础知识进行回顾,为后续章节中更深入的技术讨论和案例分析打下坚实的基础。

## 1.1 卷积神经网络的基本结构

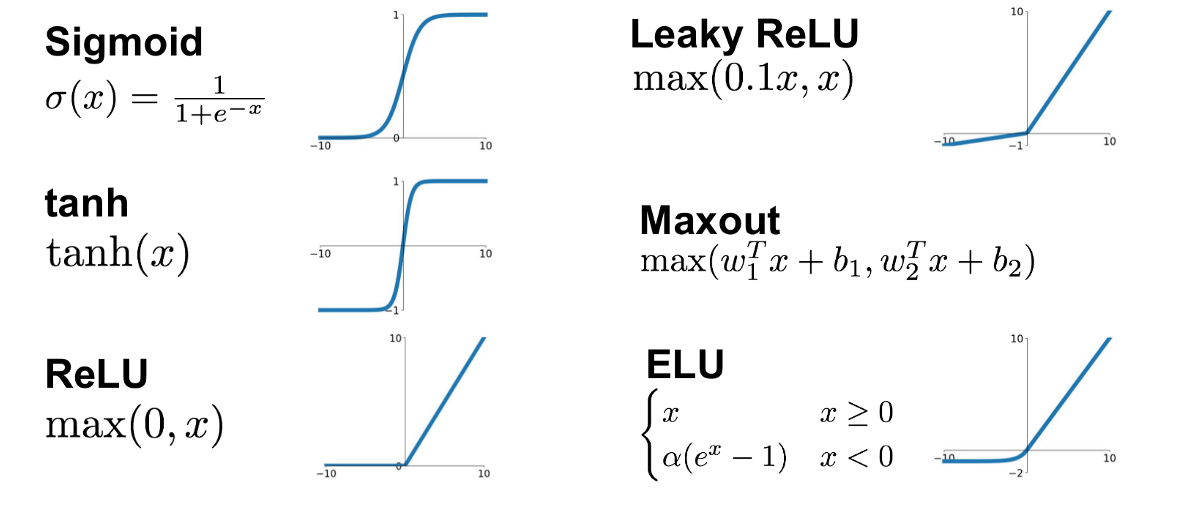

CNN的核心组成通常包括卷积层、激活函数、池化层和全连接层。卷积层负责特征的提取,激活函数引入非线性,池化层降低数据维度并增强模型泛化能力,而全连接层则实现特征到输出的映射。

```python

# 伪代码展示基本的CNN结构

import tensorflow as tf

model = tf.keras.Sequential([

tf.keras.layers.Conv2D(filters=32, kernel_size=(3, 3), activation='relu', input_shape=(64, 64, 3)),

tf.keras.layers.MaxPooling2D(pool_size=(2, 2)),

tf.keras.layers.Flatten(),

tf.keras.layers.Dense(units=128, activation='relu'),

tf.keras.layers.Dense(units=10, activation='softmax')

])

```

## 1.2 卷积操作的数学原理

卷积操作在数学上可以理解为一种特殊的积分变换,它通过在输入数据上滑动一个卷积核(或滤波器)来提取局部特征。卷积核的权重在训练过程中通过反向传播算法进行优化。

## 1.3 卷积神经网络的优势

与传统的全连接网络相比,CNN具有参数共享和局部感知两大优势。参数共享减少了模型的复杂度和训练所需的资源,而局部感知则使得网络能够保持图像的空间结构不变性,从而更好地处理图像数据。

通过本章的内容回顾,读者应能理解CNN的组成及核心工作原理,为深入了解模型训练、压缩、部署等更复杂的话题奠定基础。

# 2. 模型训练与验证

## 2.1 数据预处理与增强

### 2.1.1 数据集的划分与标准化

在构建卷积神经网络(CNN)模型的过程中,数据集的划分与标准化是模型训练前的关键步骤。数据集的划分可以确保模型在训练过程中不会看到验证或测试数据,避免了潜在的信息泄露问题,并允许我们评估模型在未知数据上的泛化能力。常见的数据集划分方法包括训练集、验证集和测试集的划分。

**数据标准化**(也称为归一化)是提高模型训练效率和收敛速度的重要预处理步骤。标准化通常通过减去数据的均值并除以标准差来实现,从而使得数据分布接近标准正态分布。这有助于避免梯度消失或爆炸的问题,尤其是在使用了梯度下降相关优化算法时。

在 Python 中,可以使用 scikit-learn 库来简单实现标准化:

```python

from sklearn.preprocessing import StandardScaler

# 假设 X_train, X_val, X_test 为原始数据集的划分

scaler = StandardScaler()

X_train = scaler.fit_transform(X_train)

X_val = scaler.transform(X_val)

X_test = scaler.transform(X_test)

```

### 2.1.2 数据增强技术及其应用

数据增强是一种提高模型鲁棒性和泛化能力的有效策略,通过对训练数据进行各种变换,生成新的训练样本。数据增强技术包括但不限于旋转、缩放、平移、翻转、裁剪、颜色变换等。这些技术可以在不改变图像标签的前提下,增加数据集的多样性。

使用 Python 中的 imgaug 库,可以方便地对数据集应用多种数据增强技术:

```python

import imgaug.augmenters as iaa

# 应用数据增强技术

seq = iaa.Sequential([

iaa.Fliplr(0.5), # 水平翻转概率为50%

iaa.Affine(

scale={"x": (0.8, 1.2), "y": (0.8, 1.2)},

rotate=(-45, 45)

), # 缩放和旋转

])

# 对图像应用增强

aug_images = seq.augment_images(X_train)

```

## 2.2 模型训练技巧

### 2.2.1 优化算法的选择与调整

在模型训练中,选择合适的优化算法对于提高训练速度和模型性能至关重要。常用的优化算法包括随机梯度下降(SGD)、Adam、RMSprop 等。每种算法都有其特定的超参数,例如学习率、动量、衰减率等,这些超参数的调整对于训练结果的影响很大。

以 Adam 优化算法为例,其包含两个主要的超参数,即学习率 (`lr`) 和一阶矩估计的指数衰减速率 (`beta1`),二阶矩估计的指数衰减速率 (`beta2`)。这些参数的默认值为 `lr=0.001`, `beta1=0.9`, `beta2=0.999`,但这些值并不一定适合所有问题。通过调整这些参数,可以优化模型的收敛速度和最终性能。

### 2.2.2 模型正则化与防止过拟合

模型正则化技术通过向模型的损失函数添加额外的项来避免过拟合。常见的正则化方法包括 L1 和 L2 正则化。L1 正则化倾向于产生稀疏的权重矩阵,有助于特征选择;而 L2 正则化倾向于限制权重的大小,通常可以提高模型的泛化能力。

除了正则化,还可以通过提前停止(early stopping)、使用 dropout 层和批量归一化(batch normalization)等技术来防止过拟合。例如,dropout 层可以在训练过程中随机地暂时“丢弃”一部分神经元,从而减少神经元之间的依赖性,并使得网络更加健壮。

## 2.3 模型验证与测试

### 2.3.1 交叉验证与模型评估指标

交叉验证是一种评估模型泛化能力的技术,其过程涉及将数据集分成k个大小相同的子集,然后依次使用k-1个子集作为训练数据,剩余的一个子集作为验证数据。通过这种方式,可以有效减少模型评估的方差,确保评估结果更加稳定可靠。

**模型评估指标**是衡量模型性能的量化手段,常见的指标有准确率(Accuracy)、精确率(Precision)、召回率(Recall)、F1分数和ROC-AUC等。不同指标根据实际问题的需求具有不同的优先级。例如,在医疗诊断任务中,召回率可能比精确率更为重要,因为它关乎遗漏诊断的风险。

### 2.3.2 测试集上的模型性能检验

在模型训练完成后,需要在测试集上评估模型性能。测试集是独立于训练和验证集的第三方数据集,它帮助我们估计模型在实际应用场景中的表现。在测试集上得到的性能指标通常是模型部署前的最终性能指标。

性能检验不仅限于得到一个准确率分数,它还应该包括对模型输出的综合分析,例如混淆矩阵、ROC曲线和精度-召回率曲线等。这些工具可以帮助我们更深入地理解模型的优劣之处,为后续的模型优化提供指导。

在本章中,我们重点介绍了模型训练与验证的关键环节,涵盖了数据预处理、模型训练技巧、以及模型验证和测试的方法。通过这些策略,可以确保模型在训练过程中表现出色,并在未知数据上具有良好的泛化能力。接下来,我们将进一步探讨模型压缩与优化,以提高模型在生产环境中的适用性和效率。

# 3. 模型压缩与优化

在本章中,我们将深入探讨如何对训练好的深度学习模型进行压缩和优化,以适应不同的应用场景,比如移动设备、嵌入式系统以及需要高效推理的服务器。我们将从网络剪枝、量化技术和模型转换与加速三个方面进行详细讲解。

## 3.1 网络剪枝技术

### 3.1.1 剪枝的基本原理与方法

网络剪枝技术主要通过对模型中冗余和不重要的参数进行剔除,来减小模型的规模和提高推理速度,同时尽可能维持模型的准确率。剪枝可以分为非结构化剪枝和结构化剪枝。

非结构化剪枝通常指任意剔除单个参数,由于剪枝后的模型不符合常规硬件的矩阵运算加速特性,导致实际加速效果有限。结构化剪枝则是在保持矩阵结构的前提下进行剪枝,例如剔除整个卷积核或过滤器,这样可以更容易地在硬件上实现加速。

剪枝的步骤通常包括:

1. 选择剪枝指标,如参数的重要性。

2. 剪枝过程,剔除低重要性的参数。

3. 重新训练或微调模型,以恢复因剪枝造成的性能损失。

### 3.1.2 剪枝对模型性能的影响分析

剪枝对模型的性能有着直接的影响,这些影响可以分为正面和负面两方面。正面影响包括:

- **模型大小的减小**:移除部分参数后,模型占用的空间更少。

0

0