Word2Vec词嵌入在文本去重中的应用:消除重复文本,提升数据效率

发布时间: 2024-08-20 13:54:01 阅读量: 44 订阅数: 37

# 1. Word2Vec词嵌入简介

Word2Vec是一种神经网络模型,用于将单词映射到低维稠密向量空间中。这些向量捕获了单词的语义和语法信息,使它们能够用于各种自然语言处理任务。Word2Vec词嵌入在文本去重中具有广泛的应用,因为它可以有效地识别具有相似语义的重复文本。

# 2. Word2Vec词嵌入在文本去重中的理论基础

### 2.1 Word2Vec词嵌入的原理

#### 2.1.1 词汇表和共现矩阵

Word2Vec词嵌入是一种将单词映射到低维向量的技术。它的原理是基于这样一个假设:在文本语料库中,经常出现在相似的上下文中(即共现)的单词往往具有相似的语义。

为了构建词嵌入,首先需要构建一个词汇表,其中包含语料库中出现的所有唯一单词。然后,对于每个单词,计算其与词汇表中其他所有单词的共现频率。共现频率矩阵是一个对称矩阵,其中行和列表示词汇表中的单词,而单元格的值表示两个单词的共现频率。

#### 2.1.2 神经网络模型

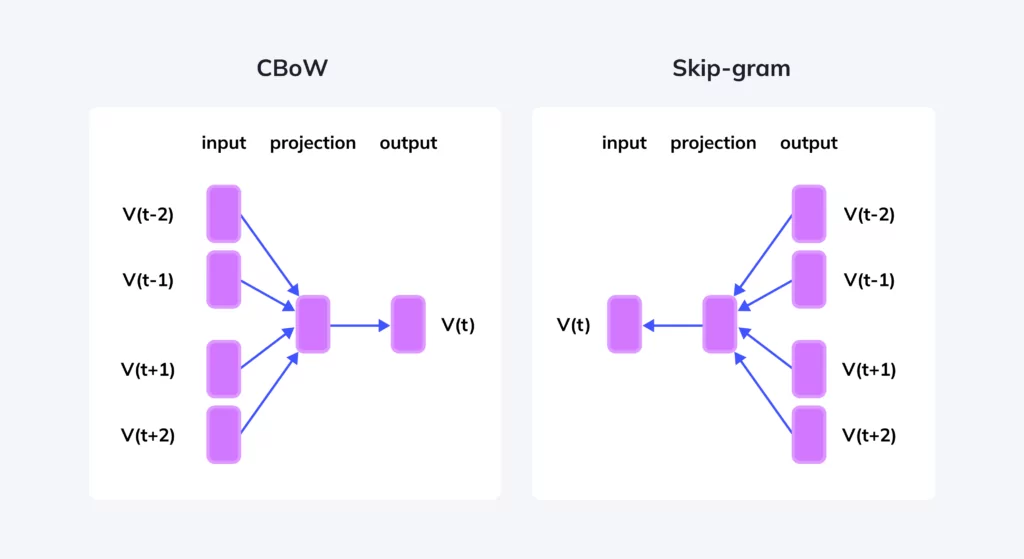

Word2Vec使用神经网络模型来学习单词嵌入。有两种主要的神经网络模型:连续袋中词(CBOW)和跳字语法(Skip-gram)。

**CBOW模型**:给定一个目标单词及其上下文单词,CBOW模型预测目标单词。它通过将上下文单词的嵌入向量求和,然后使用一个线性层和一个softmax激活函数来预测目标单词。

**Skip-gram模型**:与CBOW相反,Skip-gram模型给定一个目标单词,预测其上下文单词。它通过将目标单词的嵌入向量作为输入,然后使用一个线性层和一个softmax激活函数来预测上下文单词。

### 2.2 文本去重的基本概念

#### 2.2.1 重复文本的定义

重复文本是指语义相同或高度相似的文本。它可能以不同的方式出现,例如:

* **完全重复**:两个文本完全相同。

* **近似重复**:两个文本在内容和结构上非常相似,但可能包含一些小的差异。

* **语义重复**:两个文本具有相同的含义,但可能使用不同的单词和表达方式。

#### 2.2.2 文本去重的目的和意义

文本去重旨在识别和删除重复文本。它的主要目的是:

* **提高数据质量**:重复文本会影响数据分析和处理的准确性。

* **节省存储空间**:重复文本会占用不必要的存储空间。

* **提高搜索效率**:在搜索引擎中,重复文本会降低相关结果的可见性。

* **防止数据冗余**:重复文本会造成数据冗余,导致数据管理和维护困难。

# 3. Word2Vec词嵌入在文本去重中的实践应用

### 3.1 Word2Vec词嵌入的训练

#### 3.1.1 语料库的选择和预处理

语料库的选择是Word2Vec词嵌入训练的关键步骤,因为它决定了词嵌入的质量和适用性。对于文本去重任务,语料库应包含丰富且

0

0