揭秘Word2Vec词嵌入:自然语言处理的秘密武器,解锁文本数据价值

发布时间: 2024-08-20 13:10:26 阅读量: 43 订阅数: 37

# 1. 词嵌入简介

词嵌入是一种将单词表示为向量的方法,它可以捕捉单词之间的语义和语法关系。词嵌入技术在自然语言处理 (NLP) 任务中发挥着至关重要的作用,因为它可以将文本数据转换为机器可理解的格式。

词嵌入的目的是将单词映射到一个低维空间中,在这个空间中,单词之间的距离反映了它们的语义相似性。这使得机器学习模型能够学习单词之间的关系,并执行诸如文本分类、文本聚类和信息检索等任务。

# 2. Word2Vec模型

### 2.1 Word2Vec的原理和算法

Word2Vec是一种神经网络语言模型,用于学习单词的分布式表示。它通过预测单词的上下文来训练,从而捕捉单词之间的语义和语法关系。

Word2Vec有两种主要的模型:

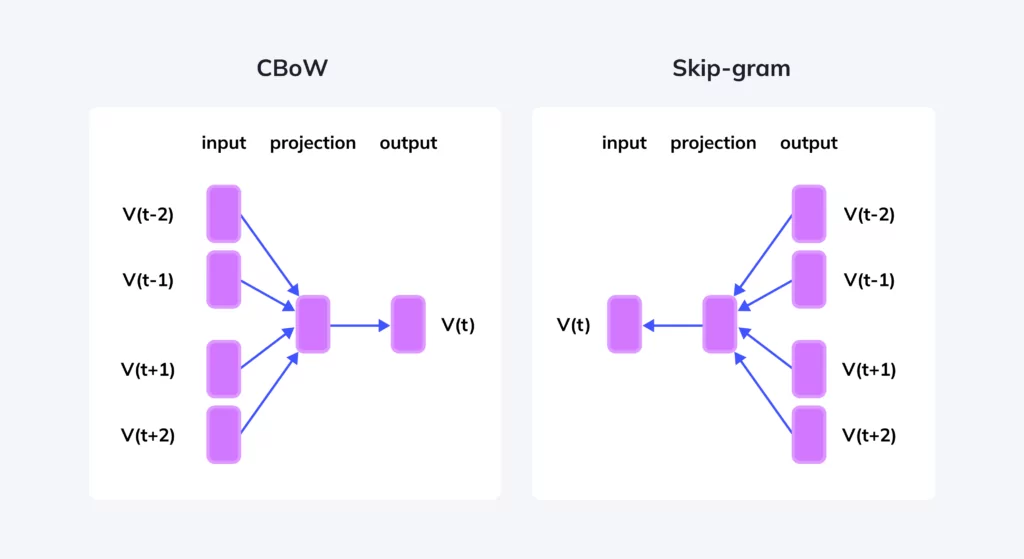

#### 2.1.1 CBOW模型(Continuous Bag-of-Words)

CBOW模型预测中心词,给定其周围的上下文单词。它使用一个输入层来表示上下文单词,一个隐藏层来学习单词表示,以及一个输出层来预测中心词。

#### 2.1.2 Skip-Gram模型

Skip-Gram模型预测上下文单词,给定中心词。它使用一个输入层来表示中心词,一个隐藏层来学习单词表示,以及多个输出层来预测上下文单词。

### 2.2 Word2Vec模型的训练和评估

#### 2.2.1 训练数据集的准备

Word2Vec模型的训练需要一个大型的文本语料库。语料库应包含各种文本类型,以确保模型学习到丰富的语言特征。

#### 2.2.2 模型训练参数的设置

Word2Vec模型的训练涉及多个参数,包括:

- **窗口大小:**上下文单词的范围。

- **词向量维度:**单词表示的维度。

- **负采样:**用于减少训练时间和提高模型效率的技术。

- **学习率:**模型更新权重的速度。

#### 2.2.3 模型评估指标

Word2Vec模型的评估通常使用以下指标:

- **余弦相似度:**测量单词表示之间的相似性。

- **词类比准确率:**评估模型预测单词关系的能力。

- **语义相似性:**衡量模型学习单词语义含义的能力。

**代码块:**

```python

import gensim, logging

# 设置日志级别

logging.basicConfig(format='%(asctime)s : %(levelname)s : %(message)s', level=logging.INFO)

# 训练语料库

sentences = gensim.models.word2vec.LineSentence('text_corpus.txt')

# 训练Word2Vec模型

model = gensim.models.Word2Vec(sentences, min_count=1, size=100, window=5, sg=1, negative=5, workers=4)

# 保存模型

model.save('word2vec_model.bin')

```

**代码逻辑分析:**

1. 导入Gensim库并设置日志级别。

2. 加载训练语料库。

3. 使用Gensim的Word2Vec类训练Word2Vec模型,并设置模型参数。

4. 保存训练好的模型。

**参数说明:**

- `min_count`: 最小单词出现次数,低于此阈值的单词将被忽略。

- `size`: 词向量维度。

- `window`: 上下文单词的窗口大小。

- `sg`: 模型类型,1表示Skip-Gram,0表示CBOW。

- `negative`: 负采样数量。

- `workers`: 并行训练的线程数。

# 3.1 文本分类

#### 3.1.1 文本特征提取

文本分类是自然语言处理中一项基本任务,其目的是将文本文档分配到预定义的类别中。Word2Vec词嵌入在文本分类中扮演着至关重要的角色,因为它可以将文本文档转换为数字向量,这些向量包含文本语义信息。

使用Word2Vec进行文本特征提取的步骤如下:

1. **将文本文档转换为词序列:**将文本文档中的所有单词按顺序排列,形成一个单词序列。

2. **将单词转换为词嵌入:**使用训练好的Word2Vec模型,将单词序列中的每个单词转换为对应的词嵌入向量。

3. **聚合词嵌入:**将单词嵌入向量聚合为一个文档向量,代表整个文本文档的语义信息。

聚合词嵌入的方法有多种,包括:

- **平均值聚合:**将所有单词嵌入向量求平均值,得到文档向量。

- **加权平均值聚合:**根据单词在文档中的重要性对单词嵌入向量进行加权平均,得到文档向量。

- **最大值聚合:**取所有单词嵌入向量中的最大值作为文档向量。

#### 3.1.2 分类模型的训练和评估

一旦文本文档被转换为文档向量,就可以使用各种分类算法对文档进行分类。常见的分类算法包括:

- **逻辑回归:**一种线性分类器,通过拟合一条将文档向量映射到类别标签的直线来工作。

- **支持向量机(SVM):**一种非线性分类器,通过在高维特征空间中找到一个超平面来工作,该超平面将不同类别的文档分隔开来。

- **决策树:**一种树形分类器,通过递归地将文档向量分配到不同的子节点来工作,直到达到叶节点(类别标签)。

分类模型的训练和评估过程如下:

1. **训练数据集的划分:**将文本文档数据集划分为训练集和测试集。

2. **模型训练:**使用训练集训练分类模型,学习文档向量和类别标签之间的映射关系。

3. **模型评估:**使用测试集评估训练好的模型,计算模型在分类任务上的准确率、召回率和F1值等指标。

通过优化Word2Vec模型的训练参数和分类模型的超参数,可以进一步提高文本分类的准确性。

# 4. Word2Vec的扩展**

**4.1 FastText**

FastText是Word2Vec的扩展,它通过考虑单词的子词(字符n元组)来提高词嵌入的质量。这对于处理稀有词和拼写错误特别有用。

**4.1.1 FastText的原理和算法**

FastText使用一个称为Skip-Gram with Negative Sampling(SGNS)的算法来训练词嵌入。该算法通过预测一个单词的上下文单词来学习单词的表示。与Word2Vec不同,FastText将单词表示为其子词的和。

**4.1.2 FastText模型的训练和评估**

FastText模型的训练与Word2Vec模型的训练类似。可以使用FastText库或Gensim等库来训练模型。模型评估指标也与Word2Vec模型的评估指标类似,例如余弦相似度和准确率。

**4.2 ELMo**

ELMo(Embeddings from Language Models)是另一种Word2Vec的扩展,它使用双向语言模型来学习单词的上下文表示。与Word2Vec和FastText不同,ELMo为每个单词生成一个多层表示,其中每一层捕获单词在不同上下文中的不同方面。

**4.2.1 ELMo的原理和算法**

ELMo使用一个双向语言模型来学习单词的表示。该模型在正向和反向两个方向上处理文本,并使用注意力机制来捕获单词在不同上下文中的重要性。

**4.2.2 ELMo模型的训练和评估**

ELMo模型的训练需要大量的文本数据和强大的计算资源。可以使用TensorFlow或PyTorch等库来训练模型。模型评估指标包括单词相似度、文本分类和问答任务的准确率。

**代码示例:**

```python

import gensim

# 训练FastText模型

model = gensim.models.FastText(sentences, size=100, window=5, min_count=1)

# 训练ELMo模型

model = Elmo(options_file="elmo_options.json", weight_file="elmo_weights.hdf5")

```

**参数说明:**

* `sentences`:要训练的文本语料库。

* `size`:词嵌入的维度。

* `window`:上下文窗口的大小。

* `min_count`:要考虑的最小单词频次。

* `options_file`:ELMo模型选项文件的路径。

* `weight_file`:ELMo模型权重文件的路径。

**逻辑分析:**

FastText模型通过将单词表示为其子词的和来提高词嵌入的质量。ELMo模型通过使用双向语言模型来学习单词的上下文表示,从而为每个单词生成一个多层表示。

# 5. Word2Vec的未来发展

### 5.1 Word2Vec在NLP中的新应用

随着自然语言处理(NLP)领域的不断发展,Word2Vec在NLP中的应用也在不断扩展。以下是一些Word2Vec在新领域的应用:

- **机器翻译:**Word2Vec可以用于机器翻译中,通过学习源语言和目标语言之间的词语嵌入,提高翻译质量。

- **问答系统:**Word2Vec可以用于问答系统中,通过将问题和答案嵌入到向量空间,实现语义匹配,提高问答系统的准确性。

- **文本生成:**Word2Vec可以用于文本生成中,通过预测下一个单词的概率分布,生成连贯且语义合理的文本。

### 5.2 Word2Vec模型的优化和改进

为了提高Word2Vec模型的性能,研究人员不断提出新的优化和改进方法。以下是一些常见的优化方法:

- **负采样:**负采样是一种减少训练时间和内存消耗的优化方法,它通过对低频词进行负采样,降低了训练复杂度。

- **分层Softmax:**分层Softmax是一种优化Softmax分类器的算法,它通过构建一个二叉树结构,将分类问题分解为一系列二分类问题,从而提高了分类效率。

- **上下文窗口大小:**上下文窗口大小是Word2Vec模型的一个重要参数,它决定了模型考虑的上下文信息范围。通过调整上下文窗口大小,可以优化模型对不同长度文本的处理能力。

### 5.3 Word2Vec与其他NLP技术的结合

Word2Vec可以与其他NLP技术相结合,以发挥协同效应。以下是一些常见的结合方法:

- **Word2Vec与深度学习:**Word2Vec的词嵌入可以作为深度学习模型的输入,为模型提供语义信息,提高模型的性能。

- **Word2Vec与图神经网络:**Word2Vec的词嵌入可以用于构建图神经网络,将文本数据表示为图结构,从而利用图神经网络的强大表示能力进行文本分析。

- **Word2Vec与语言模型:**Word2Vec的词嵌入可以用于初始化语言模型,为语言模型提供语义先验知识,提高语言模型的训练效率和性能。

0

0