Word2Vec词嵌入在文本相似度计算中的应用:文本相似度度量的新篇章

发布时间: 2024-08-20 13:24:42 阅读量: 54 订阅数: 46

word2vec词向量训练及中文文本相似度计算

# 1. 文本相似度度量的演变**

文本相似度度量是自然语言处理(NLP)中的一项基本任务,旨在量化两段文本之间的相似程度。随着NLP技术的不断发展,文本相似度度量的方法也经历了显著的演变。

早期,文本相似度通常基于词频统计,如Jaccard相似系数和余弦相似度。这些方法简单易用,但无法捕捉文本中语义和语法的细微差别。

随着机器学习的兴起,文本相似度度量迎来了新的发展。词嵌入技术,如Word2Vec,将单词映射到高维向量空间,可以有效地表示单词的语义和语法信息。基于词嵌入的文本相似度度量方法,如余弦相似度和欧氏距离,可以更准确地衡量文本之间的相似性。

# 2. Word2Vec词嵌入的理论基础

### 2.1 词嵌入的概念和发展

**词嵌入**(Word Embedding)是一种将单词映射到向量空间的技术,它能够捕捉单词的语义和语法信息。与传统的one-hot编码相比,词嵌入可以有效地减少维度,同时保留单词之间的相似性和关系。

词嵌入的发展经历了多个阶段:

- **早期方法:**基于计数的方法,如词频-逆向文件频率(TF-IDF)和共现矩阵。

- **神经网络方法:**基于神经网络的模型,如Word2Vec、GloVe和ELMo。

### 2.2 Word2Vec模型的原理和算法

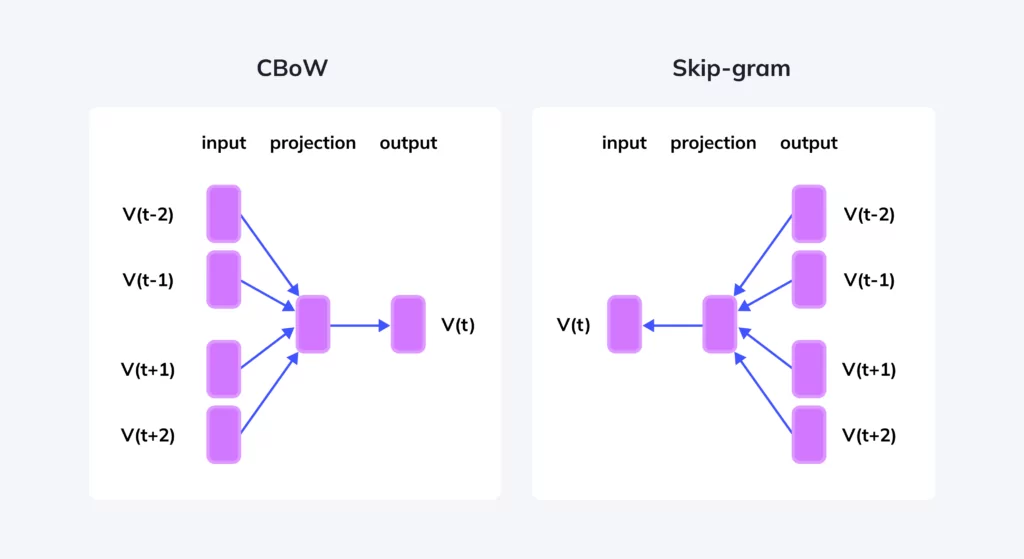

Word2Vec是一种神经网络模型,它通过学习单词的上下文来生成词嵌入。它有两种主要的模型:

**1. CBOW(连续词袋模型)**

CBOW模型预测一个单词的上下文单词。给定一个中心词,它会使用其周围的上下文单词来预测该中心词。

**2. Skip-gram模型**

Skip-gram模型预测一个单词的上下文单词。给定一个中心词,它会使用该中心词来预测其周围的上下文单词。

**算法流程:**

1. **输入:**一个文本语料库。

2. **预处理:**对文本进行分词、去停用词和词干化。

3. **构建词表:**创建语料库中所有单词的词表。

4. **训练神经网络:**使用CBOW或Skip-gram模型训练神经网络。

5. **输出:**训练好的神经网络模型,它包含每个单词的词嵌入。

**代码示例:**

```python

import gensim

# 加载语料库

sentences = gensim.models.word2vec.LineSentence('text_corpus.txt')

# 训练Word2Vec模型

model = gensim.models.Word2Vec(sentences, min_count=1)

# 获取单词的词嵌入

word_vector = model.wv['word']

```

**参数说明:**

- `min_count`: 最小单词频次,低于该频次的单词将被忽略。

- `size`: 词嵌入向量的维度。

- `window`: 上下文窗口大小,表示考虑中心词周围多少个单词。

**逻辑分析:**

- `gensim.models.word2vec.LineSentence`类将文本语料库加载为一个生成器,它可以逐行生成句子。

- `Word2Vec`类使用Skip-gram模型训练神经网络。

- `wv`属性返回一个KeyedVectors对象,它包含每个单词的词嵌入。

# 3.1 基于余弦相似度的文本相似度计算

**3.1.1 余弦相似度的概念**

余弦相似度是一种衡量两个向量的相似程度的度量,它计算两个向量的夹角的余弦值。余弦相似度范围在[-1, 1]之间,其中-1表示完全相反,0表示正交,1表示完全相同。

**3.1.2 Word2Vec词嵌入中的余弦相似度**

在Word2Vec词嵌入中,每个单词都表示为一个向量。我们可以通过计算两个单词向量的余弦相似度来衡量它们的相似程度。

**3.1.3 计算步骤**

基于余弦相似度的文本相似度计算步骤如下:

1. 将文本转换为Word2Vec词嵌入。

2. 计算每个单词对的余弦相似度。

3. 对所有单词对的余弦相似度求平均值。

**3.1.4 代码示例**

```python

import gensim

from sklearn.metrics.pairwise import cosine_similarity

# 加载Word2Vec模型

model = gensim.models.Word2Vec.load("word2vec.model")

# 计算两个单词的余弦相似度

word1 = "apple"

word2 = "banana"

similarity = cosine_similarity([model[word1]], [model[word2]])[0][0]

print(similarity)

```

**3.1.5 逻辑分析**

* `gensim.models.Word2Vec.load("word2vec.model")`:加载预训练的Word2Vec模型。

* `model[word1]`:获取单词`word1`的词嵌入向量。

* `cosine_similarity([model[word1]], [model[word2]])[0][0]`:计算两个单词向量的余弦相似度。

### 3.2 基于欧氏距离的文本相似度计算

**3.2.1 欧氏距离的概念**

欧氏距离是两个点之间的直线距离。它计算两个向量的各个元素之间的差值的平方和的平方根。

**3.2.2 Word2Vec词嵌入中的欧氏距离**

在Word2Vec词嵌入中,我们可以通过计算两个单词向量的欧氏距离来衡量它们的相似程度。

**3.2.3 计算步骤**

基于欧氏距离的文本相似度计算步骤如下:

1. 将文本转换为Word2Vec词嵌入。

2. 计算每个单词对的欧氏距离。

3. 对所有单词对的欧氏距离求平均值。

**3.2.4 代码示例**

```python

import gensim

from sklearn.metrics.pairwise import euclidean_distances

# 加载Word2Vec模型

model = gensim.models.Word2Vec.load("word2vec.model")

# 计算两个单词的欧氏距离

word1 = "apple"

word2 = "banana"

distance = euclidean_distances([model[wor

```

0

0