提升模型鲁棒性:MATLAB中的随机森林集成,打造稳健预测模型

发布时间: 2024-06-15 08:31:41 阅读量: 116 订阅数: 70

随机森林算法的matlab实现

# 1. MATLAB中随机森林的理论基础

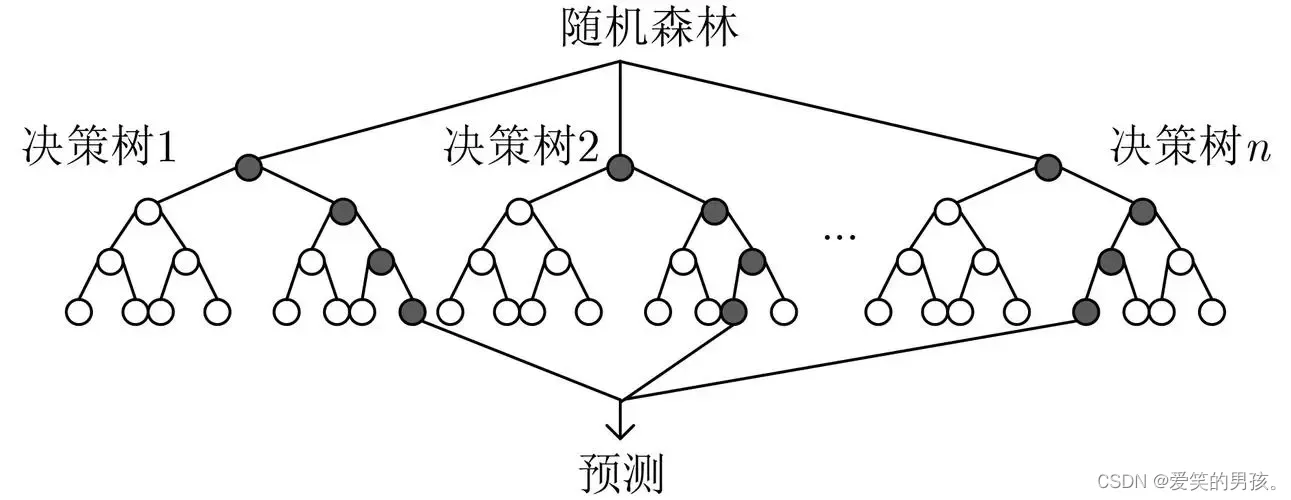

随机森林是一种强大的机器学习算法,它通过集成多棵决策树来提高预测精度和鲁棒性。在MATLAB中,可以使用TreeBagger类来构建和训练随机森林模型。

### 随机森林的构建原理

随机森林由多个决策树组成,每个决策树都是从训练数据集的随机子集上训练的。在训练过程中,每个决策树都使用不同的随机特征子集,这有助于减少模型的方差和过拟合。

### 集成方法的优势和选择

集成方法通过结合多个模型来提高预测精度。随机森林是一种集成方法,因为它将多棵决策树集成在一起。集成方法的优势包括:

* **减少方差:**集成多个模型可以降低方差,从而提高预测的稳定性。

* **提高鲁棒性:**集成模型可以减少对异常值和噪声的敏感性,从而提高模型的鲁棒性。

* **更好的泛化能力:**集成模型通常具有更好的泛化能力,因为它可以从不同的模型中学习不同的模式。

# 2. 随机森林集成技术

### 2.1 随机森林的构建原理

随机森林是一种集成学习算法,它通过构建多个决策树并对其结果进行平均,以提高模型的预测准确性和鲁棒性。其构建原理如下:

1. **数据采样:**从原始训练数据集中随机抽取 `n` 个样本(有放回)。

2. **特征子集选择:**从所有特征中随机选择 `m` 个特征子集(无放回)。

3. **决策树构建:**使用抽取的样本和特征子集构建一棵决策树。

4. **重复步骤 1-3:**重复上述步骤 `B` 次,构建 `B` 棵决策树。

### 2.2 集成方法的优势和选择

集成学习方法通过组合多个模型来提高预测性能,具有以下优势:

* **降低方差:**集成方法通过平均多个模型的预测,可以减少预测结果的方差。

* **提高鲁棒性:**不同的模型可能对不同的数据子集表现较好,集成方法可以提高模型对不同数据分布的鲁棒性。

* **防止过拟合:**集成方法可以防止单个模型过拟合训练数据,从而提高模型的泛化能力。

常见的集成方法包括:

* **Bagging:**对训练数据进行有放回的采样,并使用相同的特征集构建多个模型。

* **Boosting:**对训练数据进行有放回的采样,并根据模型的预测结果调整后续模型的权重。

* **随机森林:**对训练数据进行有放回的采样,并随机选择特征子集构建多个决策树。

### 2.3 随机森林超参数的调优

随机森林的超参数包括:

* **决策树数量(`B`):**决策树的数量影响模型的准确性和泛化能力。

* **特征子集大小(`m`):**特征子集大小影响模型的方差和偏差。

* **决策树最大深度:**决策树的最大深度影响模型的复杂性和过拟合风险。

超参数的调优可以通过以下方法进行:

* **网格搜索:**在给定的超参数范围内进行网格搜索,找到最优的超参数组合。

* **随机搜索:**在给定的超参数范围内随机采样,找到最优的超参数组合。

* **贝叶斯优化:**使用贝叶斯优化算法,通过迭代更新超参数分布,找到最优的超参数组合。

**代码块:**

```matlab

% 导入数据

data = readtable('data.csv');

% 设置超参数

num_trees = 100;

num_features = sqrt(size(data, 2));

max_depth = 10;

% 构建随机森林模型

rf = TreeBagger(num_trees, data, 'OOBPrediction', 'On', ...

'NumPredictorsToSample', num_features, 'MaxDepth', max_depth);

% 评估模型

oobError = rf.oobError;

disp(['袋外错误率:' num2str(oobError)]);

```

**逻辑分析:**

这段代码使用 `TreeBagger` 函数构建了一个随机森林模型。`num_trees` 参数指定了决策树的数量,`num_features` 参数指定了特征子集的大小,`max_depth` 参数指定了决策树的最大深度。`OOBPrediction` 参数指定了使用袋外数据进行错误率估计。

**参数说明:**

* `TreeBagger`:MATLAB 中用于构建随机森林模型的函数。

* `num_trees`:决策树的数量。

* `data`:训练数据。

* `OOBPrediction`:指定是否使用袋外数据进行错误率估计。

* `NumPredictorsToSample`:特征子集的大小。

* `MaxDepth`:决策树的最大深度。

* `oobError`:袋外错误率,用于评估模型的泛化能力。

# 3. MATLAB中随机森林的实践应用

### 3.1 数据预处理和特征工程

在应用随机森林模型之前,数据预处理和特征工程是至关重要的步骤。数据预处理涉及清除异常值、处理缺失值和标准化数据。特征工程包括选择和转换特征,以提高模型的性能。

**数据预处理**

* **清除异常值:**异常值是明显偏离数据集中其他点的极端值。它们可能会扭曲模型并导致错误的预测。可以使用各种方法来检测和清除异常值,例如 Z 分数或 Grubbs 检验。

* **处理缺失值:**缺失值是数据集中的未知或缺失数据点。它们可以通过多种方式处理,例如删除缺失值、用平均值或中位数填充缺失值,或使用插值技术估计缺失值。

* **标准化数据:**标准化数据将数据转换到具有零均值和单位方差的标准分布。这有助于提高模型的性能,因为特征的尺度和单位不再影响模型的预测。

**特征工程**

* **特征选择:**特征选择涉及选择对预测目标最相关的特征。这有助于减少模型的复杂性,提高其可解释性,并防止过拟合。可以使用各种特征选择方法,例如过滤法(基于特征统计信息)或包装法(基于模型性能)。

* **特征转换:**特征转换涉及将原始特征转换为新的特征,以提高模型的性能。这可以通过各种方式实现,例如创建二进制特征、对数转换或使用主成分分析 (PCA) 提取特征。

### 3.2 随机森林模型的训练和评估

数据预处理和特

0

0