预测连续值:MATLAB中的随机森林回归,揭秘预测连续数据的奥秘

发布时间: 2024-06-15 08:17:59 阅读量: 112 订阅数: 61

基于随机森林算法的数据回归预测-matlab程序

# 1. 随机森林回归概述

随机森林回归是一种强大的机器学习算法,用于预测连续数值。它是一种集成学习算法,通过组合多个决策树来提高预测准确性。随机森林回归广泛应用于各种领域,包括金融、医疗和制造业。

本指南将深入探讨随机森林回归的理论基础、实践应用、高级技术和案例研究。我们将涵盖从算法原理到模型评估、优化和部署的各个方面。通过本指南,您将获得对随机森林回归的全面理解,并能够在自己的项目中有效地应用它。

# 2. 随机森林回归理论基础

### 2.1 决策树算法简介

决策树是一种监督学习算法,它通过一系列嵌套的决策规则将特征空间划分为多个区域,每个区域对应一个目标变量值。决策树的构建过程从根节点开始,通过不断地分割特征空间,形成子节点,直到满足停止条件。

决策树的优点包括:

- 易于理解和解释

- 能够处理数值和分类特征

- 不需要特征缩放或归一化

### 2.2 随机森林算法原理

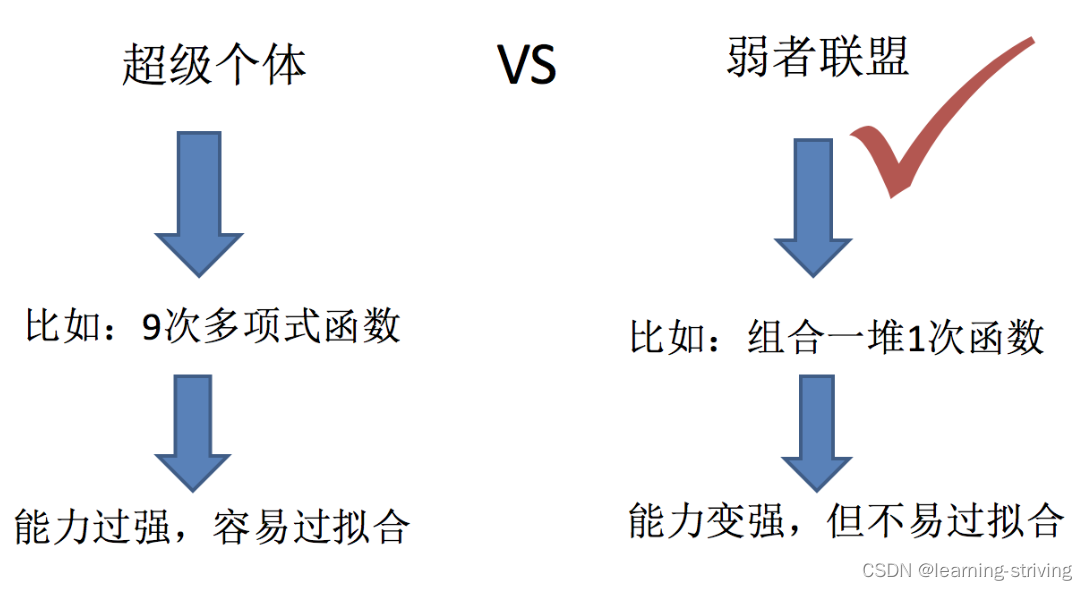

随机森林算法是一种集成学习算法,它通过构建多个决策树并对它们的预测结果进行组合来提高模型的预测精度。随机森林的原理如下:

#### 2.2.1 Bagging和随机子空间

随机森林采用 Bagging(Bootstrap Aggregating)技术,即从训练集中有放回地抽取多个子集,每个子集用于训练一个决策树。这种方法可以减少决策树之间的相关性,提高模型的泛化能力。

此外,随机森林还使用随机子空间技术,即在训练每个决策树时,只使用训练集中的部分特征。这可以防止决策树过拟合训练数据,提高模型的鲁棒性。

#### 2.2.2 特征随机选择

在训练每个决策树时,随机森林会随机选择一个特征子集。这可以防止决策树过分依赖某些特征,提高模型的稳定性和预测精度。

### 2.3 随机森林回归模型评估

#### 2.3.1 评估指标

随机森林回归模型的评估指标与其他回归模型类似,包括:

- 均方根误差(RMSE)

- 平均绝对误差(MAE)

- 最大绝对误差(MAE)

- 决定系数(R^2)

#### 2.3.2 模型选择和调参

模型选择和调参对于提高随机森林回归模型的性能至关重要。常用的调参参数包括:

- 树的数量(n_estimators)

- 最大树深度(max_depth)

- 最小叶子节点样本数(min_samples_leaf)

- 最大特征数量(max_features)

可以通过交叉验证或网格搜索等方法优化这些参数,以获得最佳的模型性能。

**代码块:**

```python

from sklearn.ensemble import RandomForestRegressor

# 设置模型参数

params = {

'n_estimators': 100,

'max_depth': 5,

'min_samples_leaf': 5,

'max_features': 'sqrt'

}

# 创建随机森林回归模型

model = RandomForestRegressor(**params)

# 训练模型

model.fit(X_train, y_train)

# 评估模型

score = model.score(X_test, y_test)

print('模型得分:', score)

```

**代码逻辑解读:**

这段代码使用 Scikit-Learn 库创建了一个随机森林回归模型,并使用指定的参数对其进行训练。然后,它使用测试集评估模型的性能,并打印模型得分。

**参数说明:**

- `n_estimators`:树的数量,越大模型越复杂,但过大会导致过拟合。

- `max_depth`:树的最大深度,越大模型越复杂,但过大会导致过拟合。

- `min_samples_leaf`:叶子节点的最小样本数,越大模型越保守,但过大

0

0