优化随机森林超参数:提升MATLAB模型性能,解锁数据洞察

发布时间: 2024-06-15 08:14:07 阅读量: 155 订阅数: 62

MATLAB实现的随机森林算法:高效分类模型代码下载

# 1. 随机森林算法简介**

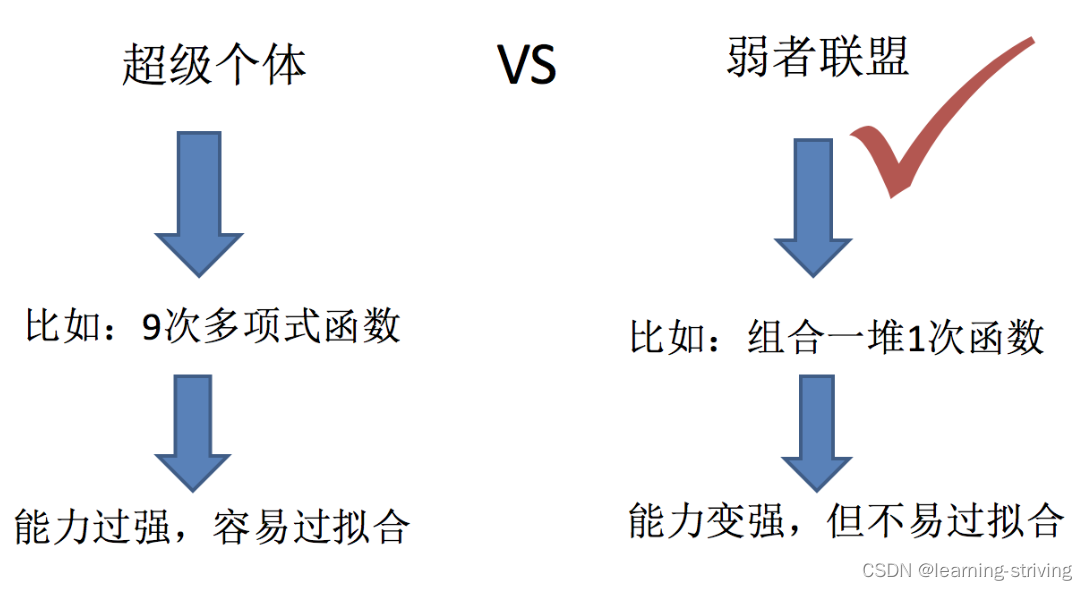

随机森林是一种机器学习算法,它通过集成多个决策树来创建强大的预测模型。每个决策树都是根据训练数据的不同子集训练的,并使用随机特征子集进行分割。通过将多个决策树的预测结果组合起来,随机森林可以提高预测的准确性和鲁棒性。

随机森林算法具有以下优点:

- **高准确性:**通过集成多个决策树,随机森林可以减少方差并提高预测准确性。

- **鲁棒性:**由于决策树是根据训练数据的不同子集训练的,因此随机森林对异常值和噪声数据具有鲁棒性。

- **可解释性:**随机森林可以提供对模型预测的特征重要性,这有助于理解模型的行为。

# 2. 随机森林超参数优化

### 2.1 超参数概述

随机森林算法中的超参数是指在训练过程中需要手动设置的参数,它们对算法的性能有重大影响。最常见的超参数包括:

#### 2.1.1 树的数量

树的数量(n_estimators)决定了随机森林中决策树的数量。树的数量越多,模型越复杂,但过拟合的风险也越大。

#### 2.1.2 最大树深度

最大树深度(max_depth)限制了决策树的最大深度。深度越深,模型越复杂,但过拟合的风险也越大。

### 2.2 超参数优化方法

超参数优化旨在找到最佳的超参数组合,以最大化模型性能。常用的优化方法包括:

#### 2.2.1 网格搜索

网格搜索是一种穷举搜索方法,它遍历超参数的预定义网格,并评估每个组合的性能。这种方法简单易用,但计算成本高,尤其是当超参数空间较大时。

#### 2.2.2 随机搜索

随机搜索是一种基于随机采样的优化方法,它从超参数空间中随机选择组合,并评估它们的性能。这种方法比网格搜索更有效,但可能无法找到最优解。

#### 2.2.3 贝叶斯优化

贝叶斯优化是一种基于贝叶斯统计的优化方法,它使用贝叶斯定理来指导超参数搜索。这种方法比网格搜索和随机搜索更有效,但需要对超参数分布进行先验假设。

### 2.3 超参数优化示例

考虑一个使用随机森林对鸢尾花数据集进行分类的任务。超参数优化过程如下:

**代码块 1:超参数优化**

```python

from sklearn.model_selection import GridSearchCV

from sklearn.ensemble import RandomForestClassifier

# 定义超参数网格

param_grid = {

'n_estimators': [10, 50, 100],

'max_depth': [2, 5, 10]

}

# 创建随机森林分类器

rf = RandomForestClassifier()

# 执行网格搜索

grid_search = GridSearchCV(rf, param_grid, cv=5)

grid_search.fit(X, y)

# 获取最佳超参数

best_params = grid_search.best_params_

```

**逻辑分析:**

代码块 1 使用 `GridSearchCV` 函数执行网格搜索。它定义了超参数网格,创建了随机森林分类器,并使用 5 折交叉验证执行网格搜索。 `best_params_` 属性包含最佳超参数组合。

**参数说明:**

* `param_grid`:超参数网格,指定要搜索的超参数及其值。

* `cv`:交叉验证折数。

**代码块 2:评估优化结果**

```python

from sklearn.metrics import accuracy_score

# 评估最佳超参数模型

best_model = RandomForestClassifier(**best_params)

best_model.fit(X, y)

y_pred = best_model.predict(X)

accuracy = accuracy_score(y, y_pred)

# 打印精度

pr

```

0

0