揭秘随机森林算法:从入门到精通,MATLAB实战指南

发布时间: 2024-06-15 08:06:57 阅读量: 105 订阅数: 61

MATLAB从入门到精通

# 1. 随机森林算法基础**

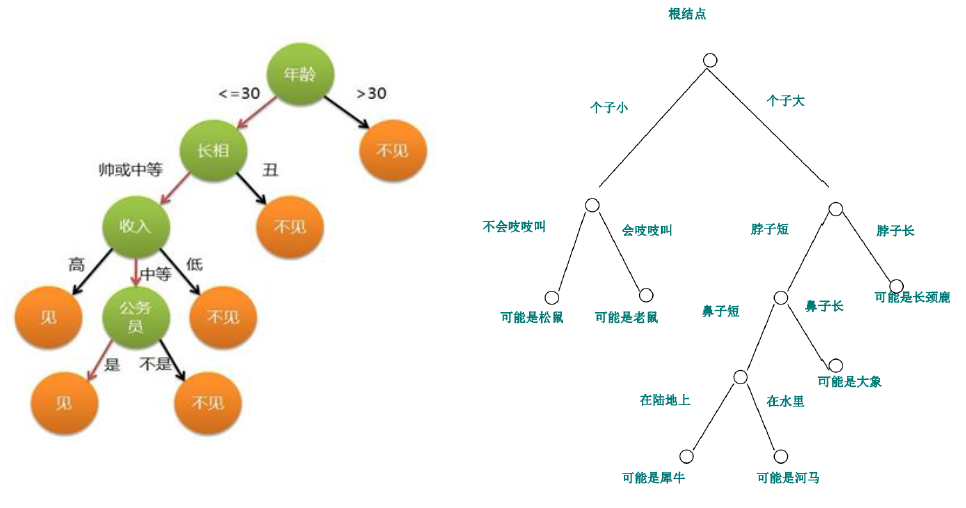

随机森林算法是一种强大的机器学习算法,用于分类和回归任务。它由多个决策树组成,每个决策树都基于训练数据的不同子集构建。通过将这些决策树的预测组合起来,随机森林算法可以提高准确性和鲁棒性。

随机森林算法的关键思想是使用随机性来创建多样化的决策树集合。具体来说,它通过以下方式引入随机性:

- **特征子集采样:**对于每个决策树,随机选择训练数据的特征子集。这有助于减少过拟合并提高泛化能力。

- **数据子集采样:**对于每个决策树,随机选择训练数据的子集。这称为自助法,它有助于创建更多样化的决策树集合。

# 2. MATLAB中随机森林算法实现

### 2.1 MATLAB中随机森林算法的包和函数

MATLAB中提供了用于实现随机森林算法的包和函数,主要包括以下几个:

- **TreeBagger**:用于创建和训练随机森林分类器或回归器。

- **predict**:用于使用训练好的随机森林模型进行预测。

- **oobPredict**:用于使用训练数据进行袋外预测,评估模型的泛化性能。

- **oobError**:用于计算袋外预测误差。

### 2.2 随机森林算法的参数设置

随机森林算法的参数设置对模型的性能有很大影响。主要参数包括:

- **NumTrees**:指定随机森林中树的数量。

- **MinLeafSize**:指定每个叶节点中的最小样本数。

- **MaxNumSplits**:指定每个节点的最大分裂次数。

- **SplitCriterion**:指定用于分裂节点的准则,如“gini”或“entropy”。

### 2.3 随机森林算法的训练和预测

**训练随机森林分类器**

```matlab

% 导入数据

data = readtable('data.csv');

% 创建随机森林分类器

classifier = TreeBagger(100, data, 'NumTrees', 100, 'MinLeafSize', 5, 'SplitCriterion', 'gini');

% 训练分类器

classifier = train(classifier, data.Features, data.Label);

```

**预测分类结果**

```matlab

% 导入新数据

newData = readtable('new_data.csv');

% 使用分类器进行预测

predictedLabels = predict(classifier, newData.Features);

```

**训练随机森林回归器**

```matlab

% 创建随机森林回归器

regressor = TreeBagger(100, data, 'NumTrees', 100, 'MinLeafSize', 5, 'SplitCriterion', 'mse');

% 训练回归器

regressor = train(regressor, data.Features, data.Label);

```

**预测回归结果**

```matlab

% 导入新数据

newData = readtable('new_data.csv');

% 使用回归器进行预测

predictedValues = predict(regressor, newData.Features);

```

# 3. 随机森林算法在MATLAB中的应用

### 3.1 随机森林算法在分类问题中的应用

#### 3.1.1 分类数据的准备和预处理

在使用随机森林算法进行分类任务之前,需要对分类数据进行准备和预处理。数据准备和预处理步骤包括:

- **数据加载和探索:**使用MATLAB的`readtable`函数加载分类数据,并使用`head`和`info`函数探索数据结构和数据类型。

- **数据清洗:**处理缺失值、异常值和重复数据。可以使用`ismissing`函数查找缺失值,使用`fillmissing`函数填充缺失值,使用`unique`函数查找重复数据,并使用`rmmissing`函数删除缺失值或重复数据。

- **数据标准化:**将数据特征值标准化到均值为0、标准差为1的范围内。这有助于提高算法的性能,因为它消除了特征值之间的尺度差异。可以使用`zscore`函数进行数据标准化。

- **数据分割:**将数据分为训练集和测试集。训练集用于训练分类器,测试集用于评估分类器的性能。可以使用`cvpartition`函数进行数据分割。

#### 3.1.2 随机森林分类器的训练和评估

数据准备和预处理完成后,就可以使用MATLAB的`TreeBagger`函数训练随机森林分类器。`TreeBagger`函数的参数包括:

- `NumTrees`:指定随机森林中树的数量。

- `Method`:指定树的类型,例如`classification`或`regression`。

- `OOBPredictorImportance`:指定是否使用袋外数据来计算特征重要性。

训练完成后,可以使用`oobError`函数计算分类器的袋外误差,并使用`predict`函数对测试集进行预测。可以使用`classificationReport`函数评估分类器的性能,包括准确率、召回率和F1分数。

### 3.2 随机森林算法在回归问题中的应用

#### 3.2.1 回归数据的准备和预处理

与分类问题类似,在使用随机森林算法进行回归任务之前,需要对回归数据进行准备和预处理。数据准备和预处理步骤包括:

- **数据加载和探索:**使用MATLAB的`readtable`函数加载回归数据,并使用`head`和`info`函数探索数据结构和数据类型。

- **数据清洗:**处理缺失值、异常值和重复数据。可以使用`ismissing`函数查找缺失值,使用`fillmissing`函数填充缺失值,使用`unique`函数查找重复数据,并使用`rmmissing`函数删除缺失值或重复数据。

- **数据标准化:**将数据特征值标准化到均值为0、标准差为1的范围内。这有助于提高算法的性能,因为它消除了特征值之间的尺度差异。可以使用`zscore`函数进行数据标准化。

- **数据分割:**将数据分为训练集和测试集。训练集用于训练分类器,测试集用于评估分类器的性能。可以使用`cvpartition`函数进行数据分割。

#### 3.2.2 随机森林回归器的训练和评估

数据准备和预处理完成后,就可以使用MATLAB的`TreeBagger`函数训练随机森林回归器。`TreeBagger`函数的参数包括:

- `NumTrees`:指定随机森林中树的数量。

- `Method`:指定树的类型,例如`classification`或`regression`。

- `OOBPredictorImportance`:指定是否使用袋外数据来计算特征重要性。

训练完成后,可以使用`oobError`函数计算回归器的袋外误差,并使用`predict`函数对测试集进行预测。可以使用`rsquare`函数评估回归器的性能,包括决定系数R^2。

# 4.1 随机森林算法的超参数优化

### 4.1.1 超参数的意义和影响

随机森林算法中涉及多个超参数,这些超参数对算法的性能有显著影响。主要超参数包括:

- **树木数量 (n_estimators)**:森林中树木的数量。树木数量越多,模型越复杂,但计算成本也越高。

- **树木深度 (max_depth)**:每棵树的最大深度。深度越深,模型越复杂,但过深的树可能导致过拟合。

- **特征子集大小 (max_features)**:在每个节点分裂时考虑的特征子集的大小。较小的子集可以减少过拟合,但可能导致模型欠拟合。

- **最小样本分裂数 (min_samples_split)**:分裂节点所需的最小样本数。较大的值可以减少过拟合,但可能导致模型欠拟合。

- **最小样本叶节点数 (min_samples_leaf)**:叶节点中所需的最小样本数。较大的值可以减少过拟合,但可能导致模型欠拟合。

### 4.1.2 超参数的优化方法

超参数优化旨在找到一组超参数值,使模型在给定数据集上达到最佳性能。常用的超参数优化方法包括:

- **网格搜索**:系统地遍历超参数值范围,并选择在验证集上性能最佳的组合。

- **随机搜索**:在超参数值范围内随机采样,并选择在验证集上性能最佳的组合。

- **贝叶斯优化**:利用贝叶斯推理来指导超参数搜索,通过迭代更新超参数分布来找到最优值。

**代码块:**

```matlab

% 导入数据

data = load('data.mat');

% 定义超参数搜索范围

param_grid = {

'n_estimators', [10, 50, 100, 200],

'max_depth', [2, 5, 10, 15],

'max_features', ['auto', 'sqrt', 'log2'],

'min_samples_split', [2, 5, 10],

'min_samples_leaf', [1, 2, 5]

};

% 使用网格搜索进行超参数优化

[best_params, best_score] = grid_search_cv(data.X, data.y, param_grid);

% 训练随机森林模型

model = RandomForestClassifier(best_params);

model.fit(data.X, data.y);

```

**代码逻辑分析:**

1. 导入数据并定义超参数搜索范围。

2. 使用 `grid_search_cv` 函数进行网格搜索,找到验证集上性能最佳的超参数组合。

3. 根据优化后的超参数训练随机森林模型。

**参数说明:**

- `data.X`:训练数据特征矩阵。

- `data.y`:训练数据标签向量。

- `param_grid`:超参数搜索范围。

- `best_params`:优化后的超参数组合。

- `best_score`:优化后的模型在验证集上的最佳性能。

# 5.1 随机森林算法的并行化实现

### 5.1.1 并行化的原理和方法

并行化是一种通过同时使用多个处理器或计算机来提高计算速度的技术。在随机森林算法中,并行化可以应用于训练和预测过程。

训练过程中的并行化主要通过并行构建决策树来实现。每个决策树的训练可以分配给不同的处理器或计算机,从而同时进行。

预测过程中的并行化主要通过并行计算每个样本的预测结果来实现。每个样本的预测可以分配给不同的处理器或计算机,从而同时进行。

### 5.1.2 MATLAB中随机森林算法的并行化实现

MATLAB提供了并行计算工具箱,可以方便地实现随机森林算法的并行化。下面是一个使用并行计算工具箱并行化随机森林算法训练过程的示例代码:

```

% 导入并行计算工具箱

parpool;

% 创建随机森林分类器对象

classifier = TreeBagger(100, data, labels, 'OOBPrediction', 'on');

% 设置并行选项

classifier.Parallel = true;

% 训练随机森林分类器

classifier = train(classifier, data, labels);

```

在这个示例中,`parpool`函数创建了一个并行池,该池包含可用于并行计算的处理器或计算机。`classifier.Parallel`属性设置为`true`,表示训练过程将并行执行。

使用并行计算工具箱并行化随机森林算法预测过程的方法与并行化训练过程的方法类似。

0

0