【集成学习】:结合多个模型提升手写数字识别率

发布时间: 2024-09-06 19:12:00 阅读量: 151 订阅数: 36

# 1. 集成学习的基本概念与原理

集成学习是一种通过构建并结合多个学习器来完成学习任务的技术。基本思想是通过组合多个独立的预测模型来获得比单一模型更好的泛化性能。这种策略在多个领域中被广泛应用于提升模型的准确性和鲁棒性。本章将介绍集成学习的理论基础,并探讨其背后的核心原理。

## 1.1 集成学习的定义与目标

集成学习的核心目标是结合多个模型的优势,通过一定的策略来改善单一模型的性能。它将多个学习器的预测结果结合起来,形成一个整体的预测,通常能显著提高预测精度和减少过拟合的风险。

## 1.2 集成学习的两种主要策略

集成学习主要分为两大策略:Bagging和Boosting。前者通过并行地训练多个独立的模型并进行简单的平均或投票来提高准确度和鲁棒性;而后者则是通过顺序地训练模型,每个模型都集中于前一个模型分类错误的样本,逐步提升整体性能。

## 1.3 集成学习的理论基础

集成学习的理论基础源于概率论和统计学。核心原理是弱学习器通过一定的策略组合成强学习器,这一过程符合偏差-方差权衡的理论。即通过集成多个模型,可以有效降低方差,提高模型的预测性能。

接下来的章节中,我们将深入探讨集成学习中的核心算法,并了解如何应用这些算法来解决实际问题。

# 2. 集成学习中的核心算法详解

集成学习是一种机器学习范式,它通过构建并结合多个学习器来完成学习任务。核心思想是将多个模型的优点结合起来,以期获得比单一模型更好的泛化性能。下面,我们将深入探讨集成学习中的几大核心算法家族,并详细解析其工作原理与应用技巧。

## 2.1 Bagging家族成员

### 2.1.1 随机森林的工作原理

随机森林(Random Forest,RF)是一种结合多个决策树进行预测的集成学习算法。每棵决策树在训练时,都是从样本集中随机挑选样本来构建的,且从候选的特征集中随机选择特征进行分裂。这种方法增加了模型的多样性,从而提高模型的泛化能力。

随机森林通过投票机制(分类任务)或平均机制(回归任务)来集成所有决策树的预测结果。因此,它能在一定程度上避免过拟合的问题,而且由于其并行计算的优势,随机森林在大数据集上训练时具有较好的效率。

```python

from sklearn.ensemble import RandomForestClassifier

from sklearn.datasets import load_iris

# 加载数据集

iris = load_iris()

X, y = iris.data, iris.target

# 构建随机森林模型

rf = RandomForestClassifier(n_estimators=100, random_state=42)

rf.fit(X, y)

# 模型训练完成后,可以进行预测等后续工作

```

### 2.1.2 如何构建高效的随机森林模型

构建高效的随机森林模型,涉及对模型参数的精确调整。核心参数包括但不限于树的数量(n_estimators)、树深度(max_depth)、分裂所需最小样本数(min_samples_split)等。调整这些参数可以有效地控制模型的复杂度,避免过拟合或欠拟合。

```python

# 参数优化示例代码

from sklearn.model_selection import GridSearchCV

# 设定参数网格

param_grid = {

'n_estimators': [10, 50, 100, 200],

'max_depth': [None, 10, 20, 30],

'min_samples_split': [2, 5, 10]

}

# 使用网格搜索对随机森林模型进行参数优化

grid_search = GridSearchCV(estimator=rf, param_grid=param_grid, cv=5)

grid_search.fit(X, y)

# 输出最佳参数

print("Best parameters found: ", grid_search.best_params_)

```

## 2.2 Boosting家族成员

### 2.2.1 AdaBoost的工作机制

AdaBoost(Adaptive Boosting)是一种提升方法,通过改变样本权重,使得之前分类错误的样本在后续分类器中具有更大的权重。其核心思想是逐步关注难以正确分类的样本,并使用这些加权后的样本训练新的分类器,将这些分类器的预测结果以一定权重融合起来,形成最终预测。

```python

from sklearn.ensemble import AdaBoostClassifier

from sklearn.datasets import load_breast_cancer

# 加载数据集

cancer = load_breast_cancer()

X, y = cancer.data, cancer.target

# 构建AdaBoost分类器

ada = AdaBoostClassifier(n_estimators=50, random_state=42)

ada.fit(X, y)

# 模型训练完成后,可以进行预测等后续工作

```

### 2.2.2 提升模型性能的技巧与实践

为了提升AdaBoost模型的性能,需要关注不同方面的调整。例如,可以调整单个分类器的类型(如决策树的深度)、迭代次数(n_estimators)以及学习率(learning_rate)。此外,样本权重的初始分布与每次迭代后的权重更新方式也是调优的重要方面。

```python

# 参数优化示例代码

from sklearn.model_selection import GridSearchCV

# 设定参数网格

param_grid = {

'n_estimators': [50, 100, 200],

'learning_rate': [0.01, 0.1, 1.0],

'algorithm': ['SAMME', 'SAMME.R']

}

# 使用网格搜索对AdaBoost模型进行参数优化

grid_search = GridSearchCV(estimator=ada, param_grid=param_grid, cv=5)

grid_search.fit(X, y)

# 输出最佳参数

print("Best parameters found: ", grid_search.best_params_)

```

## 2.3 Stacking与Blending策略

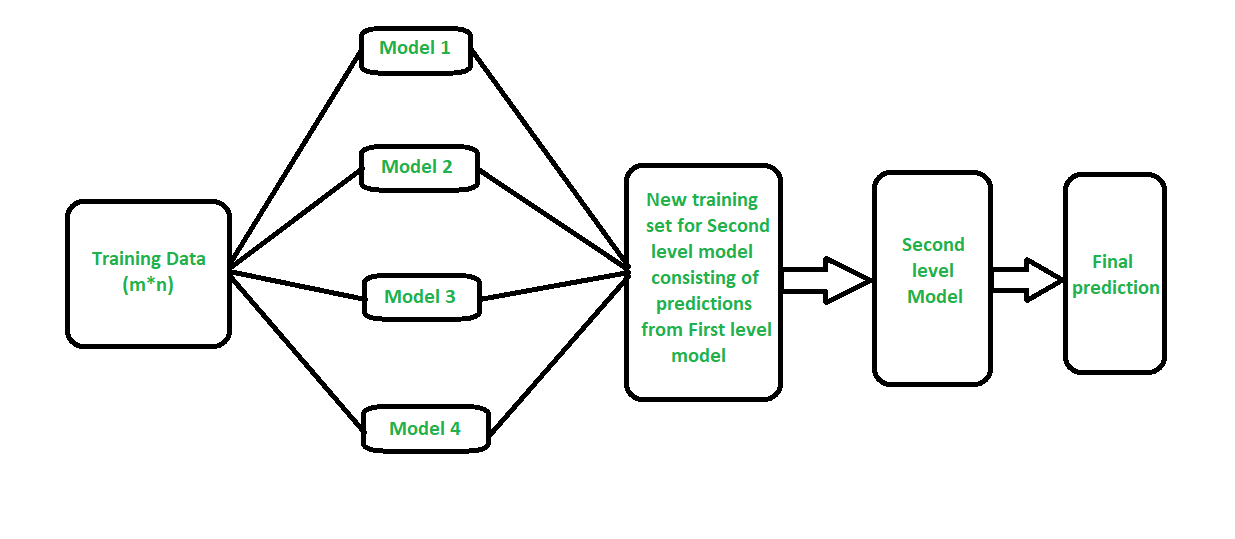

### 2.3.1 Stacking的层次组合方法

Stacking是一种集成学习策略,它通过将多个学习器的预测结果作为输入,来训练一个新的学习器(也称为元学习器)。该方法的核心在于从不同角度捕捉数据的不同特征,并通过元学习器来整合这些不同层面的信息,从而达到提升模型性能的目的。

```python

from sklearn.ensemble import StackingClassifier

from sklearn.linear_model import LogisticRegression

from sklearn.neighbors import KNeighborsClassifier

from sklearn.svm import SVC

from sklearn.datasets import make_classification

# 生成模拟数据集

X, y = make_classification(n_samples=1000, n_features=20, n_informative=15, n_redundant=5, random_state=42)

# 定义基础学习器

estimators = [

('knn', KNeighborsClassifier()),

('tree', DecisionTreeClassifier()),

('svm', SVC())

]

# 定义元学习器

meta_model = LogisticRegression()

# 构建Stacking集成模型

stacking_model = StackingClassifier(estimators=estimators, final_estimator=meta_model)

stacking_model.fit(X, y)

# 模型训练完成后,可以进行预测等后续工作

```

### 2.3.2 Blending的混合模型实践

Blending和Stacking类似,也是一种将多个模型的预测结果结合起来的方法。然而,它通常使用一部分数据来训练基础学习器,而用另一部分未参与训练的数据来训练元学习器,这样可以防止模型对训练数据过拟合。通过合理设计数据分割策略,Blending方法可以进一步提升模型的泛化能力。

```python

import numpy as np

from sklearn.model_selection import train_test_split

from sklearn.ensemble import GradientBoostingClassifier, ExtraTreesClassifier

from sklearn.linear_model import LogisticRegression

from sklearn.metrics import accuracy_score

# 定义基础学习器和元学习器

base_learners = [GradientBoostingClassifier(), ExtraTreesClassifier()]

meta_learner = LogisticRegression()

# 将数据集分为训练集和测试集

X_t

```

0

0