手写数字识别的优化策略:超参数调优与模型改进

发布时间: 2024-09-06 18:30:37 阅读量: 137 订阅数: 36

# 1. 手写数字识别的背景与挑战

## 1.1 背景介绍

随着信息技术的快速发展,手写数字识别技术已成为人工智能领域研究的热点之一。它在自动化办公、金融支付、邮政编码识别等多个领域中扮演着关键角色。随着深度学习技术的成熟,手写数字识别的准确率得到了显著提升,为传统识别方法带来了创新突破。

## 1.2 应用价值

手写数字识别技术能够将非结构化的手写数据转换为结构化的数字信息,极大地提高了数据录入和处理的效率。在银行、证券等金融机构,该技术能自动识别支票和表单上的数字信息,减少人力需求,降低出错率,提升业务处理速度。此外,在教育领域,通过手写数字识别技术,可以自动批改选择题和填空题,极大地减轻教师的工作负担。

## 1.3 面临的挑战

尽管手写数字识别已经取得了一定的进展,但其应用过程中仍面临诸多挑战。首先,手写数字的风格多样,个人书写习惯差异大,导致识别难度增加。其次,不同光照、背景、纸张质量等因素均可能影响识别效果。最后,如何设计出既准确又高效的识别算法,依然是一个值得深入研究的问题。针对这些挑战,本文将从理论基础、模型优化、超参数调优和应用前景等多个方面进行探讨,以期为手写数字识别技术的发展提供参考。

# 2. 手写数字识别的理论基础

## 2.1 机器学习在数字识别中的应用

### 2.1.1 机器学习模型概述

机器学习是一种实现人工智能的方法,它使计算机能够从数据中学习并改进自身的性能。在手写数字识别任务中,机器学习模型通过分析大量手写数字的图像样本,从中学习到识别数字的规则。这一过程通常分为以下几个步骤:

1. 数据准备:收集并预处理手写数字的图像数据集,如MNIST数据集。

2. 特征提取:从图像中提取有助于分类的特征,例如边缘、角点、环等。

3. 模型训练:使用提取的特征训练分类器,比如支持向量机(SVM)、决策树、随机森林等。

4. 模型评估:利用测试集评估训练好的模型性能,通过准确率、召回率、F1分数等指标来衡量。

5. 预测与应用:将训练好的模型部署到实际应用中,进行手写数字的识别。

### 2.1.2 常见的手写数字识别算法

手写数字识别算法通常分为传统机器学习方法和深度学习方法。下面简要介绍几种典型的算法:

#### k-最近邻(k-NN)算法

k-NN是基于实例的学习方法,其工作原理是找出待分类项的k个最近邻样本,然后根据这些邻近样本的类别信息来确定待分类项的类别。

```python

from sklearn.neighbors import KNeighborsClassifier

from sklearn.datasets import load_digits

from sklearn.model_selection import train_test_split

# 加载数据集

digits = load_digits()

X_train, X_test, y_train, y_test = train_test_split(digits.data, digits.target, test_size=0.2, random_state=0)

# 初始化k-NN分类器

knn = KNeighborsClassifier(n_neighbors=3)

# 训练模型

knn.fit(X_train, y_train)

# 进行预测并评估

print(knn.score(X_test, y_test))

```

上述代码展示了如何使用sklearn库中的KNeighborsClassifier来训练一个k-NN分类器,并使用MNIST数据集进行训练和测试。

#### 支持向量机(SVM)算法

SVM是建立在统计学习理论基础上的分类模型,核心思想是找到一个超平面来将不同类别的样本进行正确的划分。

```python

from sklearn.svm import SVC

# 初始化SVM分类器

svm = SVC(gamma=0.001)

# 训练模型

svm.fit(X_train, y_train)

# 进行预测并评估

print(svm.score(X_test, y_test))

```

代码中展示了如何使用sklearn中的SVC类来训练一个SVM模型,并对数据进行分类。

## 2.2 深度学习基础

### 2.2.1 神经网络的构建与训练

神经网络是一种模仿人脑神经元结构的计算模型,它是深度学习的核心组成部分。一个基本的神经网络由输入层、隐藏层和输出层组成。每层包含若干神经元,神经元之间通过权重连接。

#### 神经网络的构建步骤:

1. 初始化网络结构:确定网络的层数、每层的神经元数目、激活函数等。

2. 前向传播:输入数据通过每一层的权重矩阵和激活函数进行计算,最后得到输出结果。

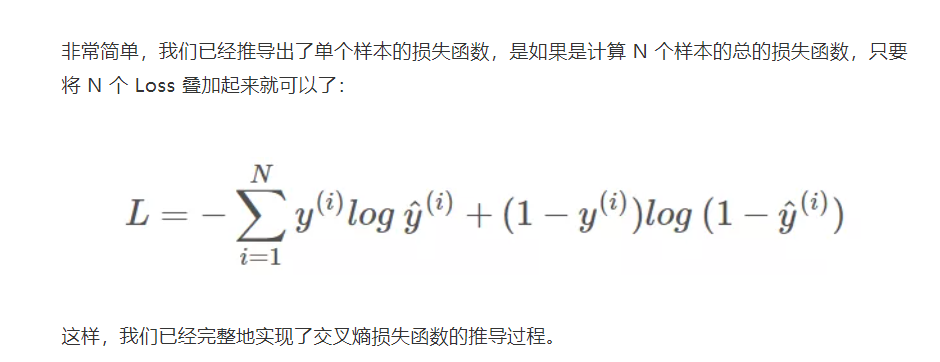

3. 计算损失:使用损失函数(如交叉熵损失)计算预测结果与真实值之间的差异。

4. 反向传播:根据损失函数的梯度更新网络的权重,以减少预测误差。

5. 参数优化:通过优化算法(如梯度下降)进行权重更新,直到收敛。

```python

import numpy as np

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense

from tensorflow.keras.optimizers import SGD

# 定义一个简单的神经网络模型

model = Sequential([

Dense(512, activation='relu', input_shape=(784,)),

Dense(10, activation='softmax')

])

# 编译模型

***pile(loss='sparse_categorical_crossentropy',

optimizer=SGD(learning_rate=0.01),

metrics=['accuracy'])

# 准备数据

X_train, X_test, y_train, y_test = ... # 加载数据

X_train = X_train.reshape(-1, 784).astype('float32') / 255.0

X_test = X_test.reshape(-1, 784).astype('float32') / 255.0

# 训练模型

model.fit(X_train, y_train, epochs=10, batch_size=32, validation_split=0.1)

# 评估模型

loss, accuracy = model.evaluate(X_test, y_test)

print(f'Loss: {loss}, Accuracy: {accuracy}')

```

上述代码展示了如何使用TensorFlow和Keras库构建一个简单的全连接神经网络,并进行MNIST数据集的训练和测试。

### 2.2.2 卷积神经网络(CNN)的原理与优势

卷积神经网络是深度学习中用于处理具有网格结构的数据的神经网络,例如图像。CNN通过卷积层提取局部特征,并通过池化层降低特征维度,这使得网络对图像中的细节和变化更加敏感。

#### CNN的工作原理主要包括:

1. 卷积层:通过卷积操作提取图像的局部特征。

2. 激活层:通常使用ReLU函数为网络引入非线性。

3. 池化层:降低特征图的空间尺寸,减少参数数量。

4. 全连接层:将局部特征综合为全局特征。

5. 输出层:进行分类决策。

```mermaid

graph TD;

A[输入图像] -->|卷积| B[卷积层]

B -->|激活| C[激活层]

C -->|池化| D[池化层]

D -->|全连接| E[全连接层]

E -->|输出| F[分类结果]

```

下面的代码展示了一个简单的CNN模型,用于进行手写数字识别:

```python

from tensorflow.keras.layers import Conv2D, MaxPooling2D

model = Sequential([

Conv2D(32, (3, 3), activation='relu', input_shape=(28, 28, 1)),

MaxPooling2D((2, 2)),

Flatten(),

Dense(10, activation='softmax')

])

***pile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

# 训练与评估过程与上述类似

```

## 2.3 超参数的作用与选择

### 2.3.1 学习率与批量大小的调整

超参数是机器学习模型训练前设定的参数,它们不会在训练过程中自动优化。学习率和批量大小是训练深度学习模型时需要仔细调整的两个关键超参数。

#### 学习率

学习率决定了模型权重更新的步长。设置过大的学习率可能导致模型无法收敛,而设置过小的学习率可能导致训练过程缓慢或陷入局部最小值。

调整学习率可以使用如下策略:

- **静态学习率**:选择一个较小的固定学习率。

- **动态学习率调整**:例如,根据验证集的表现逐渐减少学习率。

#### 批量大小

批量大小指的是每次迭代中用于训练的样本数。较小的批量大小可以提供更准确的梯度估计,但是可能会增加噪声,而较大的批量大小能够更快地收敛,但可能会导致梯度估计不够准确。

调整批量大小的策略包括:

- **小批量训练**:通常使用32、64或128这样的小批量大小,以利用其对模型正则化的影响。

- **批量归一化**:通过批量归一化技术减轻不同批量大小对模型的影响。

### 2.3.2 正则化技术与防止过拟合

过拟合是机器学习中一个常见问题,指的是模型在训练数据上表现良好,但在新的、未见过的数据上表现不佳。

#### 正则化技术

正则化是一种防止过拟合的策略,它通过对模型复杂度的额外约束来工作,常用的正则化技术包括:

- **权重衰减**(L2正则化):通过在损失函数中加入权重的L2范数来防止权重过大。

- **Dropout**:在训练过程中随机丢弃一部分神经元,以减少模型对特定神经元的依赖。

下面展示了如何在Keras模型中使用Dro

0

0