深度学习 vs 迁移学习:揭秘图像识别的最强组合

发布时间: 2024-09-02 12:21:29 阅读量: 19 订阅数: 32

# 1. 深度学习和迁移学习的理论基础

## 1.1 机器学习到深度学习的发展

深度学习是从传统的机器学习发展而来的一种更先进的技术,其通过模拟人脑的神经网络结构,使用大规模的数据进行学习,以此来解决复杂的问题。在机器学习领域,传统的模型如支持向量机(SVM)和决策树等,通常需要人工特征提取,而深度学习则通过多层神经网络自动提取特征,大大简化了这一过程。

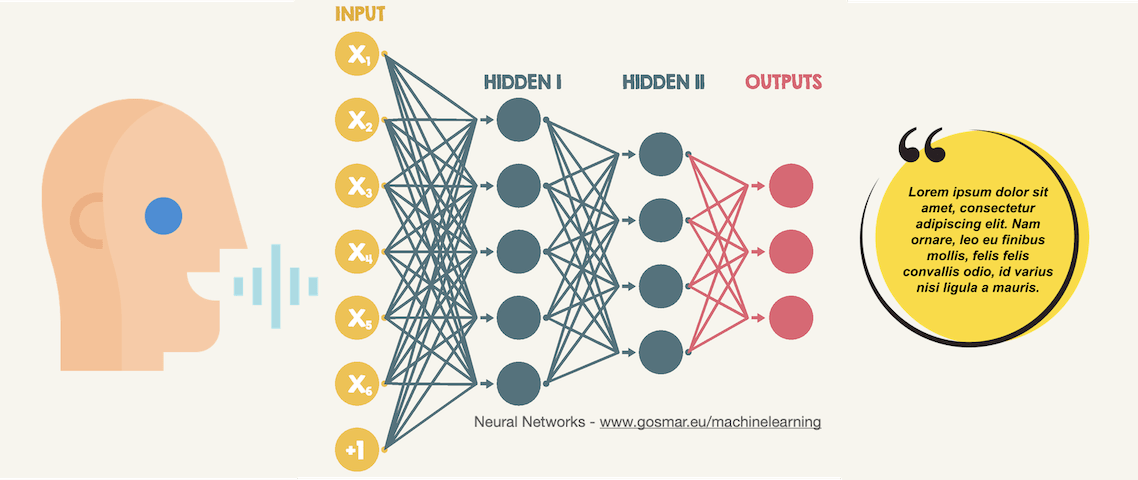

## 1.2 深度学习的核心概念

深度学习的核心概念包括神经网络、权重、偏置和激活函数等。神经网络由多层节点组成,包括输入层、隐藏层和输出层。每个节点是一个神经元,其可以对输入信息进行线性变换并应用非线性激活函数,通过权重和偏置调整信息的流动。多层的结构使得网络能够逐层抽象数据,学习到从简单到复杂的特征表示。

## 1.3 迁移学习的引入

迁移学习是一种机器学习范式,它利用一个任务上已经学习得到的知识,应用到另一个相关但不同的任务上。在深度学习中,迁移学习通常表现为利用一个预训练模型在大规模数据集(如ImageNet)上学习到的特征,来帮助新任务中的学习过程,这样可以显著减少模型训练所需要的数据量和时间,同时提高学习效果。

在此基础上,深度学习和迁移学习在各种应用领域,尤其是图像识别中,展现了其强大的能力。后续章节将深入探讨这些理论如何应用到图像识别等具体任务中,并分析其效果和优化策略。

# 2. 深度学习在图像识别中的应用

### 2.1 卷积神经网络(CNN)的基本原理

#### 2.1.1 CNN的架构和关键组件

卷积神经网络(CNN)是一种深度学习模型,特别适用于处理具有网格状拓扑结构的数据,如时间序列数据(时间网格)和图像数据(空间网格)。其架构受人类视觉系统的启发,可以通过特征提取逐步构建高层次的抽象。CNN的三个主要组成部分是卷积层、池化层(下采样层)和全连接层。

卷积层是CNN的核心,它使用一组可学习的过滤器(也称为卷积核),这些过滤器在输入数据上滑动以计算特征图(feature maps)。每个过滤器捕捉输入数据中的不同特征,如边缘、角点等。卷积操作的数学基础是离散卷积,它通过卷积核与输入数据进行元素级乘积并求和来实现。

池化层则用来降低特征图的空间尺寸,减少参数数量和计算量,同时保持特征图中的重要信息。最常见的池化操作包括最大池化和平均池化。通过池化,CNN可以对特征进行平移不变性处理,使得特征检测更加健壮。

全连接层位于CNN的末端,作用是将前面层次的输出整合并进行分类或其他类型的输出。为了防止过拟合,CNN在全连接层之前通常会加入Dropout层,随机地丢弃一部分神经元。

下面是一个简单的CNN结构示例代码块,用于构建一个基本的卷积神经网络模型:

```python

from keras.models import Sequential

from keras.layers import Conv2D, MaxPooling2D, Flatten, Dense

model = Sequential()

model.add(Conv2D(32, kernel_size=(3, 3), activation='relu', input_shape=(64, 64, 3)))

model.add(MaxPooling2D(pool_size=(2, 2)))

model.add(Flatten())

model.add(Dense(128, activation='relu'))

model.add(Dense(1, activation='sigmoid'))

```

在这个例子中,我们首先添加了一个卷积层,该层使用32个大小为(3x3)的过滤器进行卷积操作,激活函数使用ReLU。随后是一个最大池化层,池化窗口大小为(2x2)。最后,我们使用全连接层进行分类,输出层只有一个神经元,使用sigmoid激活函数,通常用于二分类问题。

#### 2.1.2 CNN在图像识别中的作用

CNN在图像识别任务中的作用主要体现在其能够自动地从数据中学习层次化的特征表示。在传统机器学习中,图像特征需要人工设计,包括边缘检测器、SIFT、HOG等。而CNN能够自动学习到这些有用的特征,而且无需人工干预,减少了人为错误。

图像识别通常指的是识别图像中的对象,并将其分类到不同的类别。例如,检测一个图像是猫还是狗。CNN通过逐层提取图像特征,从最简单的边缘和纹理到越来越复杂的形状和图案,最终能够识别出图像中的具体对象。这使得CNN在图像识别中取得了重大成功,尤其是在大规模数据集如ImageNet上的识别任务。

下面是一个使用Keras框架进行图像识别的完整代码示例:

```python

from keras.datasets import cifar10

from keras.utils import to_categorical

# 加载数据集

(x_train, y_train), (x_test, y_test) = cifar10.load_data()

# 数据预处理

x_train = x_train.astype('float32')

x_test = x_test.astype('float32')

x_train /= 255

x_test /= 255

y_train = to_categorical(y_train, 10)

y_test = to_categorical(y_test, 10)

# 模型构建和训练(省略了模型构建部分)

# 模型评估

scores = model.evaluate(x_test, y_test, verbose=1)

print('Test loss:', scores[0])

print('Test accuracy:', scores[1])

```

在这个例子中,我们使用了CIFAR-10数据集,这是一个包含10个类别的小图像数据集。我们对数据进行了归一化处理,并将标签转换为独热编码格式。模型的构建和训练过程在这里被省略了,但它通常会涉及到调用上面提到的卷积层、池化层和全连接层。

### 2.2 深度学习模型的训练和优化

#### 2.2.1 模型的前向传播和反向传播

前向传播是指在深度学习模型中,输入数据从输入层经过中间层(隐藏层)的逐层处理,直至输出层产生预测结果的过程。在CNN中,前向传播涉及到卷积操作、池化操作和非线性激活函数等步骤。前向传播是理解网络如何从输入数据中提取信息并生成预测的关键。

反向传播是训练深度学习模型的关键算法,用于根据损失函数(如均方误差或交叉熵损失)对模型的权重进行更新。反向传播通过计算损失函数关于网络权重的梯度,这些梯度指示了损失函数对权重的敏感度。在每次迭代中,这些梯度被用来通过梯度下降或其他优化算法更新权重,从而减少损失函数的值。

反向传播算法可以分为以下几个主要步骤:

1. 初始化网络权重。

2. 对输入数据执行前向传播,计算输出。

3. 计算损失函数关于输出的梯度。

4. 通过链式法则计算损失函数关于每层权重的梯度。

5. 使用梯度下降或其变体来更新权重。

6. 重复步骤2-5直到模型收敛。

下面是一个简化的反向传播过程的伪代码描述:

```python

# 假设 X 是输入数据, Y 是真实标签, y 是预测标签, loss 是损失函数

# W 表示权重, b 表示偏置, α 是学习率, δ 是梯度

# 前向传播计算输出 y

y = forward_propagation(X, W, b)

# 计算损失函数关于输出 y 的梯度

delta_loss = compute_gradient(Y, y)

# 反向传播计算每个参数的梯度

W_grad = backward_propagation(delta_loss, X)

b_grad = backward_propagation(delta_loss, 1)

# 更新权重和偏置

W -= α * W_grad

b -= α * b_grad

# 继续训练直到收敛

```

#### 2.2.2 正则化和优化算法

深度学习模型在训练过程中很容易发生过拟合现象,即模型在训练数据上表现很好,但在未见过的数据上表现差。正则化是防止过拟合的一种方法,它通过向损失函数添加额外的惩罚项,限制模型复杂度,从而提高泛化能力。

常见的正则化技术包括L1和L2正则化、Dropout、Batch Normalization等。L1和L2正则化通过在损失函数中添加权重的绝对值或平方值来惩罚大的权重值,而Dropout通过随机关闭一部分神经元来防止网络过度依赖于特定的特征,Batch Normalization通过调整层的输入来缓解内部协变量偏移问题。

优化算法负责更新网络权重以最小化损失函数。常见的优化算法包括梯度下降(及其变种如SGD、Adam、RMSprop等),这些算法根据损失函数关于网络权重的梯度进行权重更新。

下面是一个简化的权重更新过程,使用梯度下降算法:

```python

# 假设 W 是权重, δ 是损失函数关于 W 的梯度, α 是学习率

while (未达到终止条件):

# 计算损失函数关于 W 的梯度

delta = compute_gradient_loss(W)

# 更新权重 W

W -= α * delta

# 检查是否达到收敛

if (loss_converged(W)):

break

```

### 2.3 深度学习模型的性能评估

#### 2.3.1 常见的评估指标

深度学习模型的性能评估通常依赖于一些标准指标,这些指标可以提供模型在测试数据上的表现,帮助开发者了解模型的泛化能力。以下是一些常用的评估指标:

- 准确率(Accuracy):正确分类的样本数占总样本数的比例。

- 精确率(Precision):在模型预测为正的样本中,实际为正的比例。

- 召回率(Recall):在所有实际为正的样本中,模型正确预测为正的比例。

- F1 分数(F1 Score):精确率和召回率的调和平均数。

- ROC曲线(Receiver Operating Characteristic)和AUC值(Area Under Curve):ROC曲线通过调整阈值来展示模型的真正例率与假正例率之间的关系,AUC值提供了一个单一的评价指标来衡量模型的整体性能。

#### 2.3.2 过拟合和欠拟合的处理

处理过拟合和欠拟合是提高模型性能的重要步骤。过拟合通常可以通过正则化方法、使用更多的训练数据、减少模型复杂度、提前停止训练等方法来解决。欠拟合可能意味着模型过于简单,不能捕捉数据的复杂度,可以通过增加模型复杂度、使用更先进的模型架构、改善数据质量或数量来解

0

0