图像识别算法选择指南:迁移学习的决策关键

发布时间: 2024-09-02 13:13:47 阅读量: 22 订阅数: 32

# 1. 图像识别算法的基础

## 1.1 图像识别的定义

图像识别是一种通过计算机算法分析和理解数字图像内容的技术。该技术的目标是从图像中提取信息,然后进行分类、检测或跟踪。图像识别领域的进步,与机器学习特别是深度学习的进步密切相关。

## 1.2 图像识别的关键组成部分

图像识别系统通常包括以下关键部分:图像预处理、特征提取、分类器设计与模型训练。图像预处理涉及调整图像的大小、增强对比度等,以提高后续处理步骤的效率。特征提取是从图像中提取有区分力的信息,这些信息可由人工设计特征或深度学习方法自动生成。分类器设计与模型训练是构建能够基于提取的特征对图像进行分类的算法。

## 1.3 图像识别算法的类型

图像识别算法主要分为传统机器学习方法和深度学习方法。传统方法如支持向量机(SVM)、随机森林等,通常依赖于手工设计的特征提取。而深度学习方法,尤其是卷积神经网络(CNNs),能够自动从大量数据中学习特征,通常在复杂的图像识别任务上表现更佳。

通过这一章,我们将为读者提供一个关于图像识别技术基本原理和关键算法的概述。下一章将引入迁移学习,这是一种提高图像识别性能的重要方法。

# 2. 迁移学习理论与图像识别

### 2.1 迁移学习的基本概念

#### 2.1.1 迁移学习的定义和重要性

迁移学习(Transfer Learning)是一种机器学习方法,它利用一个领域中得到的知识来解决另一个领域的问题。在机器学习中,特别是在图像识别领域,数据往往需要大量的标注,这不仅耗时而且成本高昂。迁移学习允许我们利用已有的大量标注数据来训练模型,并将这些模型应用到数据匮乏的新领域中,从而显著减少所需的训练数据量和时间。

迁移学习的重要性在于其有效解决了数据稀缺和计算资源有限的问题。它通过迁移先验知识,加速了模型的学习速度,并且提高了模型的泛化能力。特别是在深度学习领域,预训练模型已经成为了研究与应用中的标准实践,从图像识别到自然语言处理,迁移学习都发挥着关键作用。

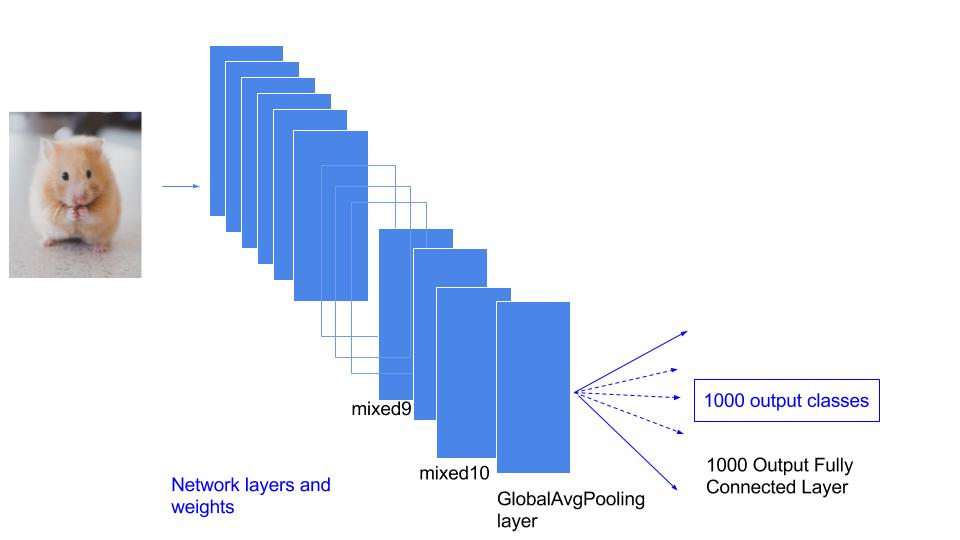

#### 2.1.2 迁移学习在图像识别中的作用

在图像识别任务中,迁移学习帮助我们应对了数据集不平衡和多样性的问题。例如,我们可以使用在大规模数据集(如ImageNet)上预训练的卷积神经网络(CNN)模型作为起点,针对特定任务进行微调(fine-tuning)。这样,即使是对于那些只有少量标记样本的任务,也能够训练出鲁棒性较强和准确率较高的模型。

迁移学习还使得图像识别技术能够跨领域应用。举个例子,一个在医疗影像上预训练的模型,可以被迁移应用于工业缺陷检测。这不仅节约了时间,还能在有限的数据条件下实现较高的识别准确性。

### 2.2 迁移学习的关键技术

#### 2.2.1 知识迁移策略

知识迁移策略是指从源任务中提取知识,并将这些知识应用到目标任务中的过程。在图像识别中,这一过程包括了从源数据集中提取特征表示,然后将这些表示应用到目标任务中。这一策略的关键在于选择合适的源任务和目标任务,以及确定合适的知识迁移时机和方式。

一个常用的知识迁移策略是特征迁移,这涉及到了预训练模型的特定层的参数和结构的迁移。另一策略是模型迁移,其中包括了整个网络结构及其参数的迁移,适用于当目标任务与源任务非常相似时。

#### 2.2.2 模型微调与特征提取

模型微调(Fine-tuning)和特征提取是迁移学习中的两种主要技术。模型微调指的是在目标任务数据上继续训练预训练模型的部分或全部层,以便模型能够更好地适应新的任务。特征提取则是在不更新预训练模型参数的情况下,仅使用预训练模型作为固定特征提取器。

微调能够充分利用预训练模型的权重,通过进一步优化来提高模型在新任务上的性能。而特征提取则适用于数据量较少或者训练时间有限的情况。微调的策略包括决定哪些层需要进行微调以及学习率的选择等。

### 2.3 迁移学习与传统方法的比较

#### 2.3.1 传统图像识别方法概述

在迁移学习出现之前,图像识别大多依赖于传统的机器学习方法。传统方法通常需要手工设计特征,然后基于这些特征进行分类器的训练。这些方法包括SIFT、HOG等局部特征描述符结合SVM等分类器。传统方法依赖于领域知识,且往往对于特征的提取和选择具有很强的依赖性。这不仅需要大量的专家知识,而且在不同任务间的适应性较差。

#### 2.3.2 迁移学习对比传统方法的优势

与传统方法相比,迁移学习具有显著优势。首先,迁移学习减少了对大量标注数据的需求,预训练模型的使用使得模型能够快速适应新任务。其次,深度学习模型能够自动学习到高层次的特征表示,减少了手工特征设计的复杂性。此外,迁移学习还具有更好的泛化能力,能够处理更广泛的任务和场景。

迁移学习的核心优势在于其模型的泛化能力,它不仅能够提升模型训练的效率,还能在一定程度上提高模型的准确率和鲁棒性。通过在大型数据集上的预训练,迁移学习为深度学习的应用提供了便利,使得在特定领域内,即便是有限数据的条件下,也能够得到不错的识别性能。

# 3. 图像识别中迁移学习的实践

## 3.1 迁移学习工具和框架选择

### 3.1.1 常用的深度学习框架概述

在本节中,我们先介绍几个流行的深度学习框架,包括TensorFlow、PyTorch、Keras等,并对比其在迁移学习中的应用特点。

TensorFlow由Google开发,是一个开源的机器学习框架,适用于大规模分布式训练和推断。TensorFlow提供了丰富的API,支持多种语言,如Python、C++等,并且具有良好的可扩展性。在迁移学习领域,TensorFlow提供了多种预训练模型,并允许用户方便地进行模型微调。

PyTorch由Facebook的人工智能研究团队开发,是一个开源的机器学习库,基于动态计算图,非常受研究人员的欢迎。PyTorch直观的接口设计让模型构建和调试更加容易,非常适合快速实验和原型开发。对于迁移学习,PyTorch同样提供了预训练的模型和加载模型的简便方法。

Keras是一个高层神经网络API,它可以使用TensorFlow、CNTK或者Theano作为后端运行。Keras设计用于快速实验,能够以最小的延迟将想法转换为结果。对于迁移学习,Keras内置了简单易用的API来加载预训练的模型和进行微调。

### 3.1.2 迁移学习框架的实现比较

在实现迁移学习时,不同的框架具有不同的优势和特点。我们来对比一下这些框架在迁移学习中的应用。

TensorFlow提供了大量的API来支持迁移学习,例如使用`tf.keras.applications`模块可以直接加载预训练的模型,使用`model.fit()`可以方便地进行微调。此外,TensorFlow还提供了`tf.data`来高效处理数据,适用于大规模数据集。

PyTorch的迁移学习实现非常灵活,用户可以自由选择是否冻结某些层的权重,或者只训练顶层。`torchvision.models`模块包含了多个预训练模型,并且可以直接用`torch.nn.Sequential`来组合模型的层,非常方便。

Keras作为高层API,其迁移学习实现的门槛相对较低。用户可以使用`keras.applications`来加载预训练模型,并通过简单配置`model.trainable`属性来控制模型层的训练状态。Keras的易用性和直观性使其成为初学者进行迁移学习实践的优选。

### 代码块和逻辑分析

```python

import tensorflow as tf

from tensorflow.keras.applications import VGG16

from tensorflow.keras.layers import Dense, Flatten

from tensorflow.keras.models import Model

# 加载VGG16预训练模型,不包括顶层

base_model = VGG16(weights='imagenet', include_top=False, input_shape=(224, 224, 3))

# 冻结预训练模型的卷积层

for layer in base_model.layers:

layer.trainable = False

# 添加自定义顶层进行微调

x = Flatten()(base_model.output)

x = Dense(1024, activation='relu')(x)

predictions = Dense(10, activation='softmax')(x)

# 构建最终模型

model = Model(inputs=base_model.input, outputs=predictions)

# 编译模型

***pile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])

# 打印模型结构

model.summary()

```

在这段代码中,我们首先使用`VGG16`的预训练模型,并设置`include_top=False`以排除顶层,这样我们就可以在顶层添加我们自己的层。然后,我们将所有预训练的卷积层的`trainable`属性设置为`False`,这表示在训练过程中这些层的权重不会被更新,这有助于保护学习到的特征。接着,我们添加了一个自定义的顶层网络,用于分类任务,并编译了模型。最后,使用`model.summary()`打印模型的结构,以确保模型被正确构建。

## 3.2 数据准备和预处理

### 3.2.1 数据集的选择与分析

在迁移学习中,数据集的选择至关重要。高质量的数据集可以帮助模型更有效地学习和迁移知识。以下是一些常用的数据集选择原则和分析方法。

选择数据集时需要考虑以下因素:

- 数据集的大小:足够大的数据集可以提供丰富的信息,使模型更好地泛化。

- 数据集的多样性:数据应该覆盖目标任务的所有变化,以减少过拟合的风险。

- 数据标注的质量:精确的数据标注对于训练准确的模型至关重要。

- 数据集的代表性:数据集应能代表实际应用场景,以便模型可以正确迁移学到的知识。

### 3.2.2 数据增强与预处理技术

数据增强和预处理是图像识别中的重要步骤。它们能够扩大数据集的规模和多样性,从而提高模型的泛化能力。以下是一些常见的数据增强和预处理技术。

数据增强包括:

- 旋转

- 缩放

- 剪裁

- 颜色变换

预处理技术包括:

- 归一化

- 标准化

- 中心化

### 代码块和逻辑分析

```python

from tensorflow.keras.preprocessing.image import ImageDataGenerator

# 设置图像数据增强

train_datagen = ImageDataGenerator(

rescale=1./255,

rotation_range=40,

width_shift_range=0.2,

height_shift_range=0.2,

shear_range=0.2,

zoom_range=0.2,

horizontal_flip=True,

fill_mode='nearest'

)

# 从目录读取数据并

```

0

0