【数据变换秘籍】:机器学习模型性能提升的8个方法

发布时间: 2024-09-02 19:47:28 阅读量: 24 订阅数: 27

# 1. 数据变换的必要性与目标

在数据分析和机器学习的整个生命周期中,数据变换是一个至关重要的环节。**数据变换**是将原始数据转换成更适合分析、理解和模型训练的过程。它旨在增强数据的质量,提高模型性能,使数据适应特定算法的要求。

### 1.1 数据变换的必要性

在数据科学实践中,数据往往包含噪声、异常值和缺失值,这些都会影响分析的准确性和模型的性能。此外,数据的量纲、尺度和分布不同,也可能导致某些算法无法正常工作。因此,进行数据变换是为了**规范化数据特征**,使其具有统一的尺度和分布,这对于算法的高效运行至关重要。

### 1.2 数据变换的目标

数据变换的主要目标是:

- **提升准确性**:通过减少噪声和偏差,提高预测或分类的准确性。

- **简化模型**:减少特征的复杂性和冗余度,简化模型结构。

- **加速学习**:缩短训练时间并提高模型训练的效率。

- **增强可解释性**:使得模型的结果更易于理解和解释。

通过本章的学习,读者将理解数据变换的必要性,并掌握其目标,为后续章节中具体的数据预处理方法和特征工程技巧的学习奠定基础。

# 2. 第二章 数据预处理技巧

## 2.1 缺失值处理

### 2.1.1 缺失值的识别与统计

在处理数据集时,识别和统计缺失值是预处理的第一步。缺失值是指数据集中应该有值但却为空的情况。这些空值可能是由于数据录入错误、设备故障、数据传输问题等多种原因造成的。识别和统计缺失值可以帮助我们了解数据集的质量以及可能需要采取的处理措施。

在Python中,我们可以使用Pandas库来识别和统计缺失值。以下是一个简单的示例代码,展示了如何统计数据集中各列的缺失值数量:

```python

import pandas as pd

# 假设df是已经加载的DataFrame数据集

missing_values_count = df.isnull().sum()

print(missing_values_count)

```

逻辑分析:上述代码首先导入了Pandas库,然后使用`isnull()`函数检测DataFrame中的缺失值,最后用`sum()`函数对每一列中的缺失值进行求和,从而得到每列的缺失值总数。

### 2.1.2 缺失值填补策略

在统计了缺失值之后,接下来需要采取策略填补这些缺失值。常见的填补策略包括删除含有缺失值的记录、用均值或中位数填补、用众数填补,或者根据数据的分布情况使用更加复杂的插值方法。

以下是一个用均值填补缺失值的示例代码:

```python

# 使用均值填补数值型列的缺失值

df_numeric = df.select_dtypes(include=[np.number])

for column in df_numeric.columns:

df[column].fillna(df[column].mean(), inplace=True)

print(df.isnull().sum())

```

逻辑分析:这段代码首先选取数据集中的数值型列,然后遍历这些列,使用`fillna()`函数以各自的均值进行缺失值填充。代码最后再次统计每列的缺失值数量以确认填充是否成功。

## 2.2 异常值处理

### 2.2.1 异常值检测方法

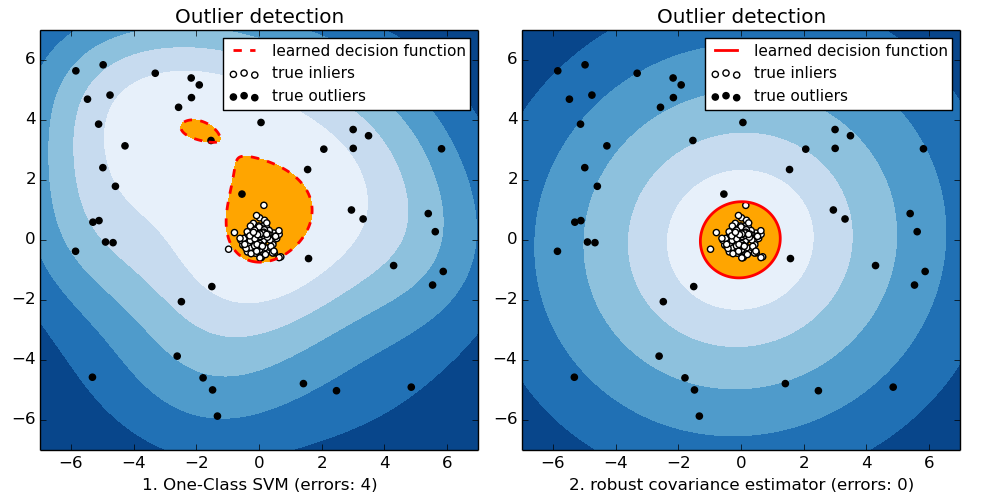

异常值是指那些与数据集中的大多数数据显著不同的值。它们可能是数据收集或录入过程中的错误,也可能是真正的异常情况。异常值的检测对于数据分析和建模至关重要,因为它们可能会对分析结果造成误导。

一个常用的异常值检测方法是基于箱形图的四分位数范围(IQR)规则。IQR是指数据的第25百分位数(Q1)与第75百分位数(Q3)之差,而异常值通常被认为是在 Q1-1.5*IQR 或 Q3+1.5*IQR 之外的值。

以下是一个基于IQR规则检测异常值的示例代码:

```python

import numpy as np

import matplotlib.pyplot as plt

# 假设df_numeric是已经处理了缺失值的数值型DataFrame

Q1 = df_numeric.quantile(0.25)

Q3 = df_numeric.quantile(0.75)

IQR = Q3 - Q1

# 异常值检测

outliers = ((df_numeric < (Q1 - 1.5 * IQR)) | (df_numeric > (Q3 + 1.5 * IQR)))

outliers_list = df_numeric[outliers.any(axis=1)]

print(outliers_list)

# 绘制箱形图

df_numeric.boxplot()

plt.show()

```

逻辑分析:代码中首先计算了Q1和Q3值,然后求得IQR。之后使用这些统计量来识别异常值,并将它们打印出来。最后,使用Matplotlib绘制了一个箱形图,以便可视化地展示数据的分布情况和识别出的异常值。

### 2.2.2 异常值的处理策略

一旦检测到异常值,如何处理这些值便成了一个问题。处理策略通常取决于异常值的成因以及它们对分析目标的影响。

一种简单的处理方法是将异常值视为缺失值并用类似的方法进行填补,例如用均值或中位数填补。另一种方法是直接删除含有异常值的记录,尤其是在异常值是由于输入错误造成的,且记录的数量不是很多时。在某些情况下,也可以通过变换数据来减少异常值的影响。

以下是一个处理异常值的示例代码,这里我们选择用均值替换异常值:

```python

# 使用均值替换异常值

for column in df_numeric.columns:

if df_numeric[column].isnull().sum() > 0:

df_numeric[column].fillna(df_numeric[column].mean(), inplace=True)

print(df_numeric.isnull().sum())

```

逻辑分析:在这段代码中,我们遍历所有数值型列,检查它们是否存在缺失值。如果存在,则用该列的均值替换这些缺失值。代码最后再次统计每列的缺失值数量以确认替换是否成功。

## 2.3 数据标准化与归一化

### 2.3.1 标准化和归一化的概念

数据标准化(Standardization)和归一化(Normalization)是用于调整数据集范围和分布的方法,使不同量级和单位的数据能够在同一个模型中进行比较和组合。

数据标准化通常指的是使数据具有零均值(mean)和单位方差(standard deviation)。例如,对于一组数据,我们通过减去均值并除以标准差来得到标准分数(z-score)。

数据归一化则是将数据缩放到一个特定的范围,通常是[0,1]。这种转换有时也被称作最小-最大标准化,是通过将数据减去最小值并除以最大值与最小值的范围来实现的。

### 2.3.2 应用标准化和归一化提升模型性能

标准化和归一化在很多机器学习算法中非常关键,尤其是在那些受特征尺度影响较大的算法中。例如,在使用基于梯度的优化算法时,标准化可以帮助加快收敛速度。同样,归一化通常可以用于提升基于距离计算的算法性能,比如k-最近邻算法(KNN)。

以下是使用Scikit-learn库进行数据标准化的一个示例代码:

```python

from sklearn.preprocessing import StandardScaler

# 假设X_train是训练数据集的特征部分

scaler = StandardScaler()

X_train_scaled = scaler.fit_transform(X_train)

```

逻辑分析:上述代码使用了Scikit-learn库中的`StandardScaler`,首先对训练数据集的特征进行拟合(`fit`),然后执行变换(`transform`),使其均值为0,方差为1。经过这个标准化处理后,X_train_scaled中的数据就可以用于训练模型了。

在实际应用中,标准化和归一化之后的模型训练结果往往比未经处理的数据更加稳定和准确。这是因为标准化和归一化减少了不同特征之间的尺度差异,避免了模型在迭代过程中收敛到局部最优解。

# 3. 特征工程实战

### 3

0

0