【文本数据预处理全攻略】:自然语言处理的关键步骤

发布时间: 2024-09-02 20:04:43 阅读量: 49 订阅数: 43

# 1. 文本数据预处理概述

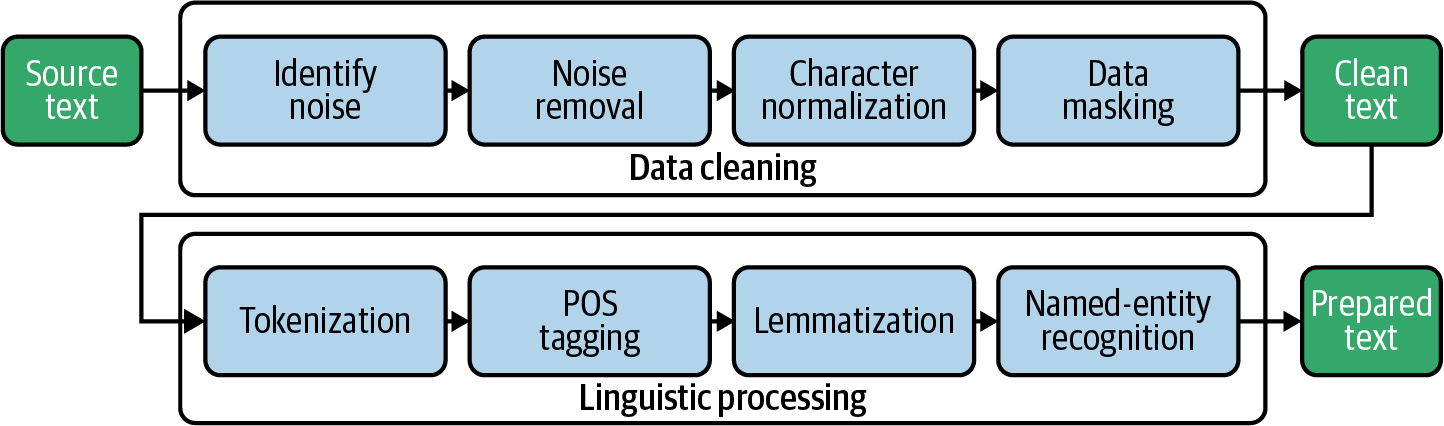

文本数据预处理是自然语言处理(NLP)任务的基础和重要环节,它影响着后续分析和模型训练的质量。预处理包括数据清洗、特征提取和数据增强等步骤,旨在将原始文本转化为适合机器学习算法使用的格式。

在开始预处理之前,我们需要理解数据的特点。文本数据通常是非结构化的,它包含各种格式和语言的文本,包括但不限于电子邮件、社交媒体帖子、书籍和文章。为了将这些文本转换成有意义的数据集,需要进行以下核心操作:

1. **文本清洗**:移除无关信息,如空白字符、特殊符号、停用词等。

2. **标准化处理**:将文本转换为统一格式,例如规范化文本和词形还原。

3. **语言检测与纠正**:识别文本使用的语言并进行拼写检查和纠正。

这些步骤简化了数据集,去除了可能对模型性能产生负面影响的噪声。接下来的章节将深入探讨这些预处理步骤,揭示如何更有效地处理文本数据,使其能够被计算机处理并提取有价值的信息。

# 2. 文本清洗技术

在本章中,我们深入探讨了文本清洗技术的实践应用,这一步骤对于后续的文本特征提取、模型训练和数据分析至关重要。文本清洗的目标是去除数据中的噪声和无关信息,保留对分析最有用的部分,确保数据的质量和分析的准确性。

## 2.1 清除无用信息

文本数据往往夹杂着各种无用的信息,如多余的空白字符、特殊符号等,这些不仅会干扰分析过程,还可能降低数据处理的效率。因此,在进行深入分析之前,我们首先需要对这些无用信息进行清除。

### 2.1.1 去除空白字符和特殊符号

空白字符包括空格、制表符、换行符等。这些字符可能会隐藏在文本中不易被发现,但在进行文本分析时,这些多余的空白字符可能会干扰词的分割和词频统计。清除特殊符号也是重要的一步,因为特殊符号通常不携带任何实际的文本信息。

Python代码示例:

```python

import re

# 假设原始文本字符串如下

text = " Hello, World! This is a text with various whitespace and punctuation. "

# 清除空白字符和特殊符号

cleaned_text = re.sub(r'[\s]+', ' ', text)

cleaned_text = re.sub(r'[^\w\s]', '', cleaned_text)

print(cleaned_text)

```

逻辑分析与参数说明:

- `re.sub(r'[\s]+', ' ', text)`:这部分代码使用正则表达式匹配一个或多个连续的空白字符,并将它们替换为单个空格。

- `re.sub(r'[^\w\s]', '', cleaned_text)`:此代码段删除所有非单词字符和非空白字符,即特殊符号。

### 2.1.2 删除停用词和低信息量的词汇

停用词是指在文本中频繁出现,但通常不携带任何实际信息的词,如英语中的“the”、“is”、“and”等。低信息量的词汇包括一些常见的代词、介词或副词,这些词在文本分析中的作用不大。

```python

from nltk.corpus import stopwords

import string

# 加载停用词列表

stop_words = set(stopwords.words('english'))

# 假设已经分词后的文本列表如下

words = ['hello', ',', 'world', 'text', 'punctuation', '.']

# 过滤停用词和标点符号

filtered_words = [word for word in words if word.lower() not in stop_words and word not in string.punctuation]

print(filtered_words)

```

逻辑分析与参数说明:

- `stopwords.words('english')`:从自然语言处理工具包NLTK中加载英语停用词列表。

- `filtered_words = [word for word in words if word.lower() not in stop_words and word not in string.punctuation]`:代码中使用列表推导式去除所有小写的停用词和标点符号。

## 2.2 标准化处理

文本标准化处理是文本预处理中的关键步骤,它通过统一文本中的词汇形式,以减少文本的复杂性和歧义性。常见的标准化处理方法包括文本规范化、词形还原和词干提取。

### 2.2.1 文本规范化

文本规范化通常指的是将文本转换为某种标准形式,例如,统一大小写、数字等。大小写规范可以确保词汇的一致性,而数字的规范化通常是为了保持文本的语义一致性。

```python

# 假设原始文本字符串如下

text = " This is an Example with SOME NUMBERS: 12345. "

# 规范化文本:统一为小写,处理数字

normalized_text = text.lower() # 统一为小写

normalized_text = re.sub(r'\d+', '', normalized_text) # 移除数字

print(normalized_text)

```

逻辑分析与参数说明:

- `text.lower()`:将所有文本转换为小写,以消除大小写带来的差异。

- `re.sub(r'\d+', '', normalized_text)`:使用正则表达式匹配文本中的数字并将其移除。

### 2.2.2 词形还原与词干提取

词形还原和词干提取是减少词汇形式多样性、达到词汇规范化目的的技术。词形还原是将词汇还原为其基本形式(lemma),而词干提取则旨在提取词汇的词干(stem),这两种技术在处理文本时往往相互补充。

```python

from nltk.stem import WordNetLemmatizer

lemmatizer = WordNetLemmatizer()

# 假设已经分词后的文本列表如下

words = ['running', 'ran', 'runner', 'fastest']

# 词形还原

lemmas = [lemmatizer.lemmatize(word) for word in words]

print(lemmas)

```

逻辑分析与参数说明:

- `WordNetLemmatizer()`:实例化NLTK库中的词形还原器,用于获取单词的基本形式。

- `lemmas = [lemmatizer.lemmatize(word) for word in words]`:使用列表推导式进行词形还原。

## 2.3 语言检测与纠正

语言检测与纠正是文本预处理的重要步骤,特别是在处理多语言文本时。准确地识别文本的语言可以有助于后续的处理,而拼写检查和自动纠错则能进一步提升文本质量。

### 2.3.1 检测文本的语言

检测文本的语言是理解文本内容的前提,许多库和工具可以实现这一功能。在实际应用中,可以使用开源工具如`langdetect`或`langid.py`来进行语言检测。

```python

# 使用langid.py库进行语言检测

from langid.langid import LanguageIdentifier, model

identifier = LanguageIdentifier.from_modelstring(model, norm_probs=True)

# 假设待检测的文本是多语言混合的

text = "Ceci est un texte en français avec quelques mots en anglais."

# 检测文本语言

language, confidence = identifier.classify(text)

print("Language detected:", language)

print("Confidence:", confidence)

```

逻辑分析与参数说明:

- `LanguageIdentifier.from_modelstring(model, norm_probs=True)`:创建语言识别器实例,`model`参数指定所使用的模型。

- `identifier.classify(text)`:对给定的文本进行语言检测,并返回检测到的语言和置信度。

### 2.3.2 拼写检查与自动纠错

拼写检查和自动纠错可以发现并修正文本中的拼写错误,这对于提高文本质量至关重要。Python中`pyenchant`库可以用于拼写检查。

```python

import enchant

# 初始化拼写检查器

d = enchant.Dict("en_US")

# 假设待检查的文本有拼写错误

text = "Ths s a tezt with a mispelings."

# 拼写检查

for wo

```

0

0