【数据集划分与交叉验证】:机器学习模型评估的4个实战策略

发布时间: 2024-09-02 20:25:50 阅读量: 128 订阅数: 56

《COMSOL顺层钻孔瓦斯抽采实践案例分析与技术探讨》,COMSOL模拟技术在顺层钻孔瓦斯抽采案例中的应用研究与实践,comsol顺层钻孔瓦斯抽采案例 ,comsol;顺层钻孔;瓦斯抽采;案例,COM

# 1. 数据集划分与交叉验证概述

## 1.1 为何要进行数据集划分

在机器学习项目中,我们面临的一个核心挑战是如何评估模型在现实世界中的表现。直接使用全部可用数据进行模型训练并评估其性能是不够的,因为模型可能会出现过拟合——即在训练数据上表现良好,但在未见过的新数据上效果差强人意。

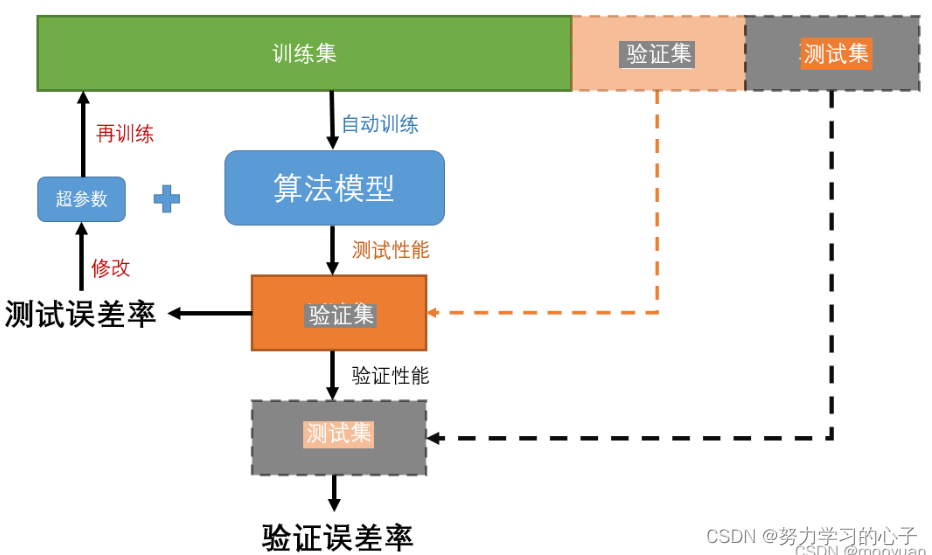

数据集划分作为机器学习的一个重要步骤,目的是将原始数据划分为独立的三部分:训练集、验证集和测试集。这样做的目的是利用训练集来学习模型参数,通过验证集来调整模型超参数,最后用测试集来模拟模型在未知数据上的泛化能力。这一过程不仅能够帮助我们评估模型的性能,还能指导我们进行模型选择和调优。

## 1.2 交叉验证的必要性

在现实场景中,数据集往往不是很大,单一的数据划分方法可能会导致评估结果的偶然性较大,无法准确反映出模型的真实性能。交叉验证(Cross-Validation)是解决这一问题的有效方法,它通过将数据集重复地分成训练集和验证集来多次评估模型,从而减小了评估误差,使得模型性能的评估更加稳定和可靠。

总的来说,数据集划分与交叉验证是机器学习模型训练和评估的关键步骤,对模型的最终效果具有重要影响。接下来的章节将详细讨论各种数据集划分策略、它们的优势与局限性,以及如何在不同场景中应用这些策略。

# 2. 理论基础:数据集划分方法

### 2.1 基本概念和重要性

#### 2.1.1 数据集划分的目的

数据集的划分是机器学习模型开发过程中的关键步骤,它将原始数据分为至少两个或更多的互斥子集,主要包括训练集(Training Set)、验证集(Validation Set)和测试集(Test Set)。这种划分的目的在于为模型提供独立的数据来源,以便于进行有效的训练、调整和评估。训练集用来学习模型,验证集用于模型的选择和超参数调整,测试集用于对最终选定的模型进行独立的性能评估。通过这种方式可以模拟模型在未来未见数据上的表现,降低模型在实际应用中的过拟合风险。

#### 2.1.2 交叉验证的理论基础

交叉验证是一种统计方法,用于评估并提高模型泛化能力的准确性。基本思想是通过多个训练/验证过程的组合,使得模型训练和评估更加全面和稳定。在交叉验证中,将数据集划分为k个大小相似的互斥子集,每一个子集轮流作为验证集,其余k-1个子集作为训练集。这种方法使得每个样本都有机会被用来验证模型,从而减少了模型评估结果的方差。在k-折交叉验证中,k的取值一般为5或10,具体取决于数据集的大小。

### 2.2 常用的数据集划分策略

#### 2.2.1 训练集、验证集和测试集

- **训练集**:是模型学习特征和参数的主要数据来源。一般情况下,训练集需要占总数据量的较大比例,以确保模型能从足够的数据中学习到规律。

- **验证集**:用于选择模型和调整超参数。验证集的大小通常小于训练集,足以反映模型性能,又不至于过多地消耗数据资源。

- **测试集**:独立于训练集和验证集,用于对模型进行最终评估。其目的是评估模型对未知数据的预测能力。

#### 2.2.2 留出法(Holdout)

留出法是一种简单直接的数据集划分策略。按照一定的比例(例如:80%训练集、10%验证集、10%测试集),随机划分数据集为三部分。留出法容易实现且计算成本低,但缺点是分割的随机性可能导致数据分布不均,从而影响模型的评估结果。

#### 2.2.3 k-折交叉验证(k-Fold Cross-Validation)

k-折交叉验证是一种更为科学的数据集划分方法,通过将数据集分为k个大小相同的子集,每个子集轮流作为验证集,其余作为训练集。它能更好地利用有限的数据资源,降低由于数据划分带来的随机性,提高模型评估的稳定性和可靠性。同时,k值的选择对模型性能有较大影响,一般情况下k取5或10。

### 2.3 划分策略的评估指标

#### 2.3.1 准确率、精确率和召回率

这些指标从不同的角度评估了分类模型的性能。准确率(Accuracy)指的是正确预测的比例;精确率(Precision)关注正类预测中真正属于正类的比例;召回率(Recall)则关注正类样本中,被正确识别的比例。它们在评估二分类模型时尤为重要。

#### 2.3.2 ROC曲线和AUC值

ROC曲线(接收者操作特征曲线)通过绘制不同阈值下的真正类率(Recall)和假正类率(Fall-out)来评估分类器的性能。AUC值(Area Under the Curve)是ROC曲线下的面积,它提供了一个从0到1的单一数值,用于衡量模型的整体性能。AUC值越接近1,模型性能越好。

### 实现数据集划分的代码示例

在Python中,使用scikit-learn库进行数据集划分是常见的做法。以下是一个简单的示例:

```python

import numpy as np

from sklearn.model_selection import train_test_split

# 假设我们有一个数据集X和对应的目标变量y

X = np.random.rand(100, 10) # 100个样本,每个样本10个特征

y = np.random.randint(2, size=100) # 目标变量为二分类问题

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 划分训练集和验证集

X_train, X_val, y_train, y_val = train_test_split(X_train, y_train, test_size=0.25, random_state=42) # 这里的0.25表示训练集为原训练集的75%

# 输出划分后各部分数据集的形状

print(f"X_train shape: {X_train.shape}, X_val shape: {X_val.shape}, X_test shape: {X_test.shape}")

```

在上述代码中,我们首先导入了`numpy`库来生成随机数据,然后从`sklearn.model_selection`模块导入了`train_test_split`函数。利用这个函数,我们可以方便地进行数据集的划分。参数`test_size=0.2`表示我们划分出了20%的数据作为测试集,而`random_state=42`保证了每次划分的一致性,便于结果的复现。

划分数据集是机器学习中的一个基础步骤,它对于后续的模型训练和评估至关重要。通过上述的代码示例和详细解释,我们对如何划分数据集以及为什么要进行数据集划分有了更加深刻的理解。

# 3. 实战策略一:训练集与验证集的划分

### 3.1 实战策略的详细步骤

在这一章节中,我

0

0