【强化学习样本效率提升】:减少训练所需样本的终极指南

发布时间: 2024-11-19 16:53:19 阅读量: 9 订阅数: 11

# 1. 强化学习基础和样本效率问题

在当今的IT领域,强化学习作为机器学习的一个重要分支,以其在复杂决策过程中所表现出来的巨大潜力,正逐渐成为研究的热点。本章将从强化学习的基础知识入手,探讨其核心概念以及面临的样本效率问题。

## 1.1 强化学习简介

强化学习是让机器在交互环境中自我学习、做出决策的一种学习方式。它模仿人类从经验中学习的过程,通过不断地尝试和错误,逐步优化其行为策略以达成既定目标。与监督学习不同,强化学习在学习过程中不依赖于标注数据,而是通过与环境的交互获得反馈。

## 1.2 样本效率问题

样本效率是强化学习领域中一个关键问题,它衡量了算法学习有效策略所需的样本数量。在许多实际应用中,环境交互是昂贵的,限制了学习速度和可扩展性。因此,如何提高样本效率,减少在学习过程中的样本消耗,成为了解决强化学习实际应用难题的一个重要方向。接下来的章节将详细介绍理论框架和提升样本效率的策略。

# 2. 理论框架和样本效率提升策略

## 2.1 强化学习的理论基础

强化学习是一种通过与环境交互来学习的机器学习范式。在本小节中,我们将深入了解强化学习的基础理论,包括马尔可夫决策过程(MDP)以及奖励函数和价值函数的概念。

### 2.1.1 马尔可夫决策过程(MDP)

马尔可夫决策过程是强化学习的数学基础,它将决策问题建模为一个五元组 \(< S, A, P, R, \gamma >\),其中:

- \(S\) 是状态的集合。

- \(A\) 是动作的集合。

- \(P\) 是状态转移概率函数,\(P(s'|s,a)\) 表示在状态 \(s\) 下执行动作 \(a\) 后转移到状态 \(s'\) 的概率。

- \(R\) 是奖励函数,\(R(s,a,s')\) 表示从状态 \(s\) 经过动作 \(a\) 转移到状态 \(s'\) 后获得的即时奖励。

- \(\gamma\) 是折扣因子,用于平衡即时奖励和未来奖励。

在MDP框架中,一个智能体需要学习一个策略 \(\pi: S \rightarrow A\),这个策略会指导智能体在每个状态下选择什么样的动作,以便最大化期望的累积回报。

```mermaid

graph LR

A[开始] --> B[观察环境状态]

B --> C[选择动作]

C --> D[执行动作]

D --> E[环境状态更新]

E --> F[获得回报]

F --> B

```

### 2.1.2 奖励函数和价值函数

奖励函数是强化学习中的核心概念之一,它直接指导智能体学习目标。智能体在与环境交互过程中,每一个动作都会得到一个奖励信号,智能体的目标是学习一个策略,使得从初始状态到终止状态的累积回报最大化。

价值函数是评估在给定策略下,智能体从某个状态或状态-动作对开始获得长期回报的期望值。状态价值函数 \(V^\pi(s)\) 表示在策略 \(\pi\) 下,状态 \(s\) 的价值,而动作价值函数 \(Q^\pi(s,a)\) 表示在策略 \(\pi\) 下,选择动作 \(a\) 在状态 \(s\) 的价值。在离散动作空间中,Q-learning 是一种经典的学习状态-动作价值函数的方法。

```math

Q(s,a) \leftarrow Q(s,a) + \alpha \left[ r + \gamma \max_{a'} Q(s',a') - Q(s,a) \right]

```

其中,\(r\) 是即时奖励,\(s'\) 是新状态,\(\alpha\) 是学习率,\(\gamma\) 是折扣因子。该更新公式表明,新的 \(Q\) 值是基于当前 \(Q\) 值和未来期望奖励的估计值的组合。

## 2.2 提升样本效率的关键方法

样本效率是强化学习中的一个关键问题,它指的是学习一个有效策略所需的样本数量。本小节将介绍几种能够显著提升样本效率的策略。

### 2.2.1 样本回放和经验回放技术

样本回放是一种利用之前收集的经验来提升样本效率的技术。在传统的强化学习中,智能体是顺序地从环境接收状态并做出动作。在样本回放方法中,智能体会从经验回放池(replay buffer)中随机抽取样本,这有助于打破样本之间的时间相关性,并且能够更有效地使用过去的样本。

经验回放池是一个存储智能体与环境交互历史数据的队列,它允许多次使用数据进行学习,这通常能够加速收敛并提高样本利用率。

### 2.2.2 模型预测控制(MPC)

模型预测控制(Model Predictive Control, MPC)是一种基于模型的控制策略,它使用一个预测模型来模拟智能体在未来的行动,并优化这些行动以最大化长期回报。MPC能够提升样本效率,因为它允许智能体在实际与环境交互之前,利用模型来规划多个可能的动作序列。

MPC的关键是预测模型的准确性,如果模型能够较好地预测环境状态的动态变化,则MPC可以显著减少样本收集的数量,提高学习效率。

### 2.2.3 策略优化方法

策略优化方法通过直接改进策略来提升样本效率。与价值函数优化不同,策略优化直接作用于策略函数,而不是通过中间的价值函数。例如,策略梯度方法(Policy Gradient)直接通过梯度上升来改善策略的性能,而不需要经历价值函数的中间步骤。

策略梯度方法的一个重要优势是它们能够处理高维或连续的动作空间,并且具有很好的样本效率。著名的策略梯度算法包括REINFORCE、TRPO(Trust Region Policy Optimization)和PPO(Proximal Policy Optimization)。

## 2.3 过度拟合和泛化能力

在本小节中,我们将探讨过度拟合在强化学习中的表现以及防止过度拟合的策略。

### 2.3.1 过度拟合在强化学习中的表现

过度拟合是指智能体在训练数据(即样本回放池或实际环境交互数据)上表现良好,但在未见过的新数据上性能下降的现象。在强化学习中,过度拟合可能会导致智能体无法泛化到与训练环境相似但不完全相同的环境中。

过度拟合的一种表现是智能体在特定状态或状态下动作序列上表现优异,但是这些行为没有很好的泛化到其他状态上。这通常在复杂的、高维的状态空间中特别明显。

### 2.3.2 防止过度拟合的策略

为防止过度拟合,研究人员采取了多种方法:

1. **正则化技术**:在优化过程中添加正则项,比如L2正则化,可以减少策略参数的大小,从而减少过度拟合的风险。

2. **探索策略**:使用如ε-贪婪等探索策略,确保智能体能够持续地探索环境中的未知区域,从而学习到更一般的行为。

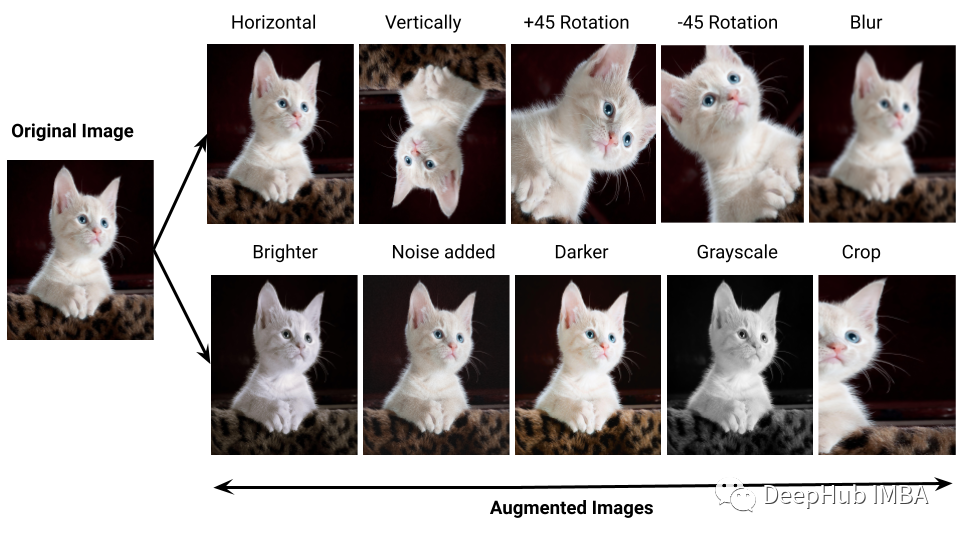

3. **模拟器训练**:在模拟器中训练智能体,并使用领域随机化(domain randomization)技术来模拟不同的环境条件,可以提升智能体对真实世界变化的适应能力。

4. **分层学习**:利用分层结构将学习任务分解成更小的、更容易管理的子任务,以提升泛化能力。

5. **对抗性训练**:引入对抗样本来挑战模型的泛化能力,使模型在这些样例上也能取得良好的性能。

通过上述策略的应用,强化学习模型可以在保持较高训练精度的同时,提升其在新环境中的泛化能力。

在强化学习中,理论框架为我们提供了解决问题的数学基础和工具,而样本效率提升策略是提高学习效率的关键。在下一章中,我们将深入了解强化学习算法如何在实践中应用这些理论,并通过具体的策略来提高样本的使用效率。

# 3. 算法和技术在实践中的应用

## 3.1 常用的强化学习算法

强化学习的算法多样,且各有特点,适合不同的问题和应用。以下将重点探讨三种在工业界和研究领域中广为使用的强化学习算法。

### 3.1.1 Q学习和Deep Q-Network(DQN)

Q学习是最经典的强化学习算法之一,其核心思想是通过不断的试错来学习行为价值函数(Q函数),从而得到最优策略。算法的更新公式如下:

```python

Q(s_t, a_t) = Q(s_t, a_t) + α * (r_t + γ * max(Q(s_{t+1}, a)) - Q(s_t, a_t))

```

其中,\(s_t\) 和 \(a_t\) 分别代表在时间 \(t\) 的状态和动作,\(α\) 是学习率,\(r_t\) 是即时奖励,\(\gamma\) 是折扣因子,而 \(max(Q(s_{t+1}, a))\) 是在下一个状态 \(s_{t+1}\) 可以获得的最大预期回报。

Deep Q-Network(DQN)是Q学习的一个深度学习扩展,其核心是使用卷积神经网络来近似Q值函数。DQN解决了传统Q学习在处理高维状态空间时的局限性。

### 3.1.2 策略梯度方法(Pol

0

0