强化学习的模型预测控制(MPC):理论基础与实践应用

发布时间: 2024-11-19 16:49:58 阅读量: 119 订阅数: 23

基于Matlab实现模型预测控制(MPC).zip

# 1. 强化学习与模型预测控制(MPC)概述

## 引言

在现代工业和自动化领域中,为了应对日益复杂的控制问题,研究者和工程师们不断地寻求新的方法和技术。强化学习与模型预测控制(MPC)作为两种先进控制策略,已经成为解决复杂控制问题的有力工具。本章节将简要介绍这两种方法的背景、原理以及它们在实际应用中的潜力。

## 强化学习简述

强化学习是一种使智能体通过与环境的互动来学习最优策略的方法。它通常被用来解决决策问题,智能体的目标是在尽可能减少预期成本或最大化预期收益的同时,学习出在给定环境中采取哪些行动。由于其在处理不确定性和适应性上的优势,强化学习在游戏、推荐系统和机器人导航等领域获得了广泛的应用。

## 模型预测控制(MPC)简介

模型预测控制是一种基于模型的优化控制策略,它利用一个预测模型来预测未来一段时间内的系统行为,并在此基础上优化控制输入。MPC特别适用于需要处理多变量输入、输出和存在约束条件的系统。由于其在处理非线性系统和约束方面的优势,MPC已经成为工业过程控制中的主流技术。

## 结合强化学习与MPC的必要性

尽管强化学习和MPC各自具有明显的优势,但它们也存在局限性。例如,强化学习需要大量的试错来优化策略,而MPC在处理未知系统动态时可能会受限。将强化学习与MPC相结合,可以充分发挥两种方法的优点,既能够通过强化学习快速适应未知环境,又能利用MPC的模型来进行有效的预测和优化。

在接下来的章节中,我们将深入探讨强化学习与MPC的理论基础,分析它们的结合策略,并通过实例研究来展示它们在解决实际问题中的应用。同时,我们还将探讨未来的发展趋势,包括深度强化学习与MPC的结合,以及在复杂系统中应用这些方法时可能遇到的挑战和前景。

# 2. 强化学习的理论基础

强化学习是机器学习的一个重要分支,它从与环境的交互中学习行为,通过试错来不断优化决策过程。在本章中,我们将深入探讨强化学习的理论基础,包括马尔可夫决策过程(MDP)、核心的强化学习算法以及动态规划在强化学习中的角色。

### 2.1 马尔可夫决策过程(MDP)

#### 2.1.1 MDP的基本概念和数学模型

MDP为强化学习提供了一个数学框架,用于描述智能体与环境交互的决策过程。MDP是一个五元组 (S, A, P, R, γ),其中:

- S 表示状态空间,是所有可能状态的集合。

- A 表示动作空间,是所有可能动作的集合。

- P 是状态转移概率,表示在当前状态下采取某个动作后转移到新状态的概率。

- R 是奖励函数,表示智能体在每个状态下获得的即时奖励。

- γ 是折扣因子,介于0和1之间,用于平衡即时奖励和未来奖励的相对重要性。

MDP的数学模型可以用以下Bellman方程来描述:

V(s) = maxₐ Σₜ P(s'|s, a) [R(s, a, s') + γV(s')]

这里,V(s)是状态值函数,表示在状态s下采取最优策略的期望回报。

#### 2.1.2 策略评估与策略改进

在MDP框架下,我们可以通过策略评估和策略改进两个过程来迭代求解最优策略。

- 策略评估:给定一个策略π,评估该策略下每个状态的价值。可以通过迭代地应用Bellman方程来实现。

- 策略改进:基于当前策略评估的结果,改进策略以获得更好的期望回报。

迭代应用这两个过程将使策略收敛到最优策略。

### 2.2 强化学习算法

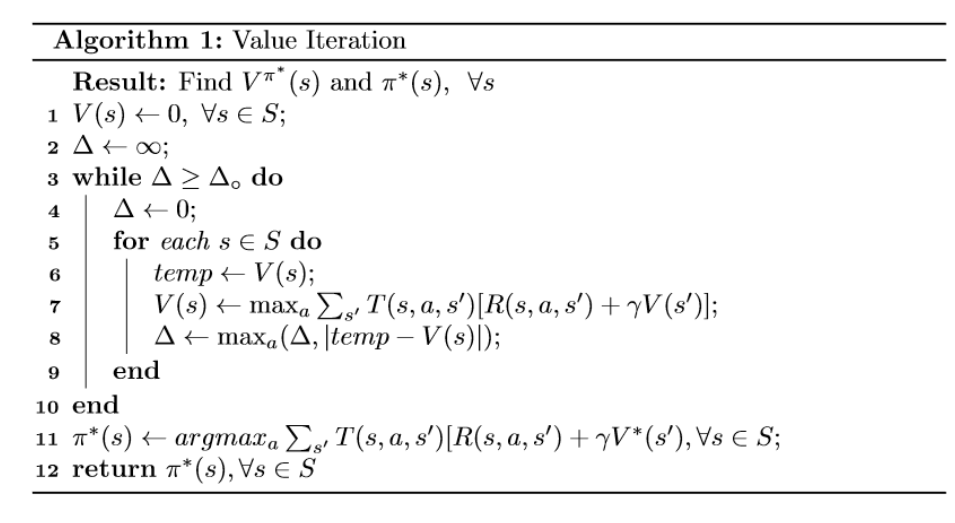

#### 2.2.1 价值迭代和策略迭代

- 价值迭代:通过不断更新价值函数来逼近最优价值函数。每次迭代中,价值函数通过贪心策略来改进。

- 策略迭代:分为策略评估和策略改进两个步骤。策略评估计算当前策略的价值函数,策略改进则是对价值函数进行贪心搜索以改进策略。

策略迭代的优势在于每一步的策略改进都保证了策略的提升。

```python

import numpy as np

# 一个简单的价值迭代过程示例

def value_iteration(P, R, gamma, theta=1e-10):

V = np.zeros(len(S))

while True:

delta = 0

for s in range(len(S)):

v = V[s]

# 策略评估

V[s] = max(sum(P[s][a][s_prime] * (R[s][a][s_prime] + gamma * V[s_prime]) for s_prime in S) for a in A)

delta = max(delta, np.abs(v - V[s]))

if delta < theta:

break

return V

# 在这个例子中,S是状态空间,A是动作空间,P是状态转移概率,R是奖励函数,gamma是折扣因子。

```

在此代码块中,`value_iteration` 函数是强化学习中价值迭代算法的一个实现。代码解释了从状态空间、动作空间到状态转移概率、奖励函数的计算过程。

#### 2.2.2 Q-learning和SARSA算法

Q-learning和SARSA是两种无模型的强化学习算法。

- Q-learning:在每次转移后更新Q值,不依赖于策略模型。

- SARSA:类似于Q-learning,但在更新Q值时考虑了下一个采取的动作。

这两个算法都是通过经验回放来学习最优策略的,它们的更新规则在很多文献中有详细的介绍。

```python

# SARSA算法的伪代码示例

def sarsa(P, R, gamma, alpha, epsilon):

Q = np.zeros((len(S), len(A)))

while True:

s = random.choice(S)

a = epsilon_greedy(Q, s)

s_prime, r = step(s, a, P, R)

a_prime = epsilon_greedy(Q, s_prime)

Q[s][a] = Q[s][a] + alpha * (r + gamma * Q[s_prime][a_prime] - Q[s][a])

```

在这段伪代码中,`sarsa`函数实现了一个简单的SARSA算法。它使用一个Q表来存储每个状态-动作对的值,并通过epsilon贪心策略来选择动作。

### 2.3 强化学习与动态规划

#### 2.3.1 动态规划在强化学习中的应用

动态规划(DP)是解决MDP问题的一个经典方法,其核心在于利用状态转移方程进行递归求解。DP要求对环境的模型完全已知,这在实际应用中往往难以实现。然而,DP为理解强化学习提供了理论基础。

#### 2.3.2 蒙特卡洛方法和时序差分学习

- 蒙特卡洛方法:通过采样完整的情景(episode)来近似值函数。

- 时序差分学习(TD学习):结合蒙特卡洛和DP的特点,可以在单步更新值函数。

TD学习是强化学习中一个非常重要的算法,它在模型未知的情况下依然可以工作,是目前许多强化学习方法的基础。

```mermaid

graph TD

A[开始] --> B[采取动作a

```

0

0