【强化学习算法全解析】:从价值函数到策略梯度的进阶之路

发布时间: 2024-11-19 15:42:08 阅读量: 70 订阅数: 22

深入解析XGBoost算法的目标函数与回归树

# 1. 第一章 强化学习算法概述

强化学习(Reinforcement Learning, RL)是机器学习的一个重要分支,它关注如何基于环境而行动,以取得最大化的预期利益。强化学习与监督学习和无监督学习不同,主要解决在没有明确指导(没有标签数据)的情况下,如何学习在不确定的环境中做出决策的问题。

## 1.1 强化学习的基本原理

强化学习的核心思想是通过试错(Trial and Error)学习。一个智能体(Agent)在与环境交互过程中,通过采取动作(Action),接收环境反馈的奖励(Reward),并基于此更新自己的行为策略(Policy),以达到长期累积奖励最大化的目标。

## 1.2 强化学习的关键组成部分

一个典型的强化学习系统包括几个关键组件:智能体(Agent)、环境(Environment)、状态(State)、动作(Action)和奖励(Reward)。智能体通过观察环境当前状态,选择并执行动作,并根据奖励信号不断调整自己的行为策略,使得未来获得的总奖励最大化。

## 1.3 强化学习的应用场景

强化学习已在多个领域显示出其强大潜力,如游戏AI、机器人控制、推荐系统、交通管理和自动交易等。随着算法的进步和计算能力的提升,我们可以预见强化学习将引领人工智能技术的更多突破。

通过以上章节的简要介绍,我们可以感受到强化学习的强大之处和其在未来技术发展中可能扮演的角色。在后续章节中,我们将深入探讨强化学习的关键算法和技术细节。

# 2. 价值函数的基础与实践

## 2.1 价值函数的核心概念

### 2.1.1 价值函数定义与性质

价值函数是强化学习算法中的核心组成部分,用于评估在特定策略下,从某个状态出发的期望回报。它是对未来奖励的预期,评估了从当前状态采取特定动作的长期利益。价值函数可以是状态价值函数(State Value Function),也可以是动作价值函数(Action Value Function)。

状态价值函数 \(V^\pi(s)\) 表示在策略 \(\pi\) 下,从状态 \(s\) 开始并遵循策略 \(\pi\) 的期望回报。形式化定义为:

\[V^\pi(s) = \mathbb{E}_\pi\left[\sum_{t=0}^\infty \gamma^t R_{t+1} \bigg| S_0 = s \right]\]

其中,\(R_{t+1}\) 是 \(t+1\) 时刻的回报,\(\gamma\) 是折扣因子,取值范围在 0 到 1 之间。

动作价值函数 \(Q^\pi(s,a)\) 表示在策略 \(\pi\) 下,从状态 \(s\) 采取动作 \(a\) 并遵循策略 \(\pi\) 的期望回报。其定义为:

\[Q^\pi(s, a) = \mathbb{E}_\pi\left[\sum_{t=0}^\infty \gamma^t R_{t+1} \bigg| S_0 = s, A_0 = a\right]\]

价值函数有两个主要的性质:一是它们是策略的预期回报,二是它们可以通过贝尔曼方程递归地分解。

### 2.1.2 状态价值函数与动作价值函数

状态价值函数和动作价值函数之间存在密切关系。动作价值函数提供了选择特定动作的价值,而状态价值函数则是在不考虑具体动作的情况下对状态的评价。当动作价值函数对于所有可能的动作都已知时,状态价值函数可以通过所有动作的预期动作价值来计算。

具体来说,状态价值函数 \(V^\pi(s)\) 可以通过动作价值函数 \(Q^\pi(s, a)\) 来表达:

\[V^\pi(s) = \sum_{a \in A} \pi(a|s)Q^\pi(s, a)\]

其中,\(\pi(a|s)\) 表示在状态 \(s\) 下,按照策略 \(\pi\) 选择动作 \(a\) 的概率。

动作价值函数的重要性在于它为选择动作提供了直接依据,尤其是在策略需要根据当前状态动态选择动作时。例如,在一个未知环境中探索时,动作价值函数可以帮助智能体决定在某个状态下尝试哪些动作。

## 2.2 状态值函数与动作值函数的求解

### 2.2.1 动态规划方法

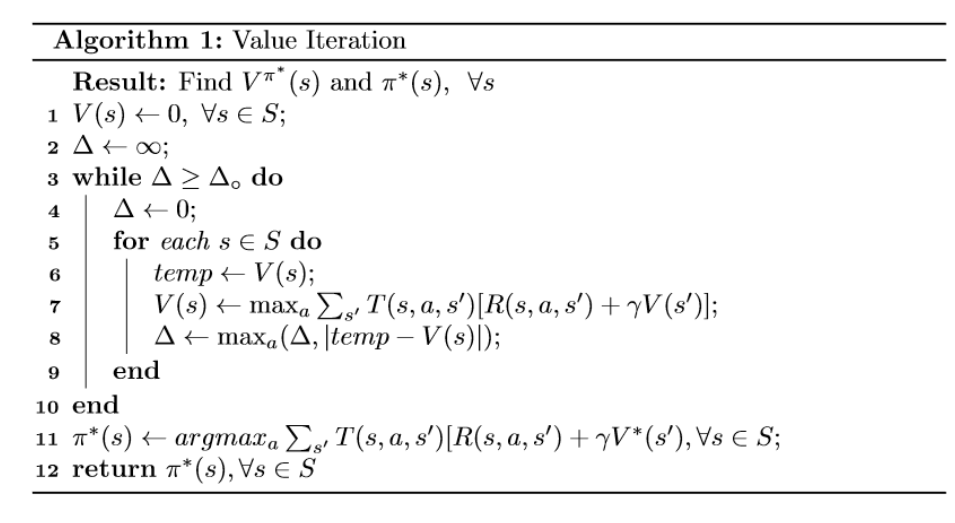

动态规划(Dynamic Programming, DP)是一种利用已知信息来求解复杂问题的方法,它通过将复杂问题分解为更小的子问题并存储这些子问题的解来提高效率。在强化学习中,动态规划被用于求解价值函数。

基本的动态规划方法包括两种算法:

- **策略评估**(Policy Evaluation):在给定策略的情况下,计算这个策略的状态值函数或动作值函数。策略评估是通过迭代地应用贝尔曼期望方程来完成的。

- **策略改进**(Policy Improvement):基于当前策略评估的结果,计算一个新的更好的策略。策略改进是通过选择当前状态下预期回报最高的动作来实现的。

使用动态规划求解价值函数时,可以通过贝尔曼最优方程来确定最优价值函数和最优策略。贝尔曼最优方程没有涉及策略,而是直接寻找最优价值函数,然后通过它来确定最优策略。

### 2.2.2 蒙特卡洛方法

蒙特卡洛方法是一种基于随机抽样的数值计算方法,用于评估价值函数。与动态规划不同,蒙特卡洛方法不需要环境的动态模型,它通过在实际或模拟的环境中进行随机抽样来评估价值函数。

蒙特卡洛方法的基本步骤如下:

1. **采样**:在给定策略下,通过与环境交互产生一系列的样本来模拟环境行为。

2. **平均回报**:对每个状态或状态-动作对的回报进行平均,作为该状态或状态-动作对的价值函数估计。

3. **更新策略**:基于价值函数的估计值,更新策略以期望更高回报。

蒙特卡洛方法的优点是简单且易于实现,特别适用于那些难以使用动态规划求解的环境。缺点是需要大量的样本来确保准确估计,且收敛速度可能较慢。

### 2.2.3 时间差分学习

时间差分学习(Temporal Difference Learning, TD Learning)是介于蒙特卡洛方法和动态规划之间的一种学习方法。它通过结合蒙特卡洛方法的样本生成和动态规划的基于模型的更新来实现价值函数的估计。

TD学习使用了 TD(0) 方法,也称为时序差分方法,它在每个时间步进行局部更新,即在状态 \(s_t\) 到状态 \(s_{t+1}\) 的转移过程中,根据实际获得的回报 \(r_{t+1}\) 和对下一个状态 \(s_{t+1}\) 的估计价值函数 \(V(s_{t+1})\) 来更新当前状态的价值函数 \(V(s_t)\)。更新公式为:

\[V(s_t) \leftarrow V(s_t) + \alpha \left( r_{t+1} + \gamma V(s_{t+1}) - V(s_t) \right)\]

其中,\(\alpha\) 是学习率,\(\gamma\) 是折扣因子。

时间差分学习结合了蒙特卡洛方法的直接利用样本来估计价值函数和动态规划的利用贝尔曼方程进行价值函数更新的优点。它不需要完整的环境模型,而且可以在线学习,因此特别适用于连续任务。

## 2.3 价值函数的估计和提升

### 2.3.1 价值函数估计技术

价值函数的估计是强化学习中至关重要的一环,它对智能体性能的好坏有着直接的影响。正确的估计方法可以提高智能体的决策质量和学习效率。常用的价值函数估计技术包括:

- **线性函数逼近**:使用线性组合的基函数来表示价值函数。这通常需要先验知识来选择合适的基函数,如状态的线性组合或者径向基函数。

- **非线性函数逼近**:使用神经网络、决策树等非线性模型来逼近价值函数,适用于高维和复杂的状态空间。深度学习技术近年来在价值函数逼近方面取得了重大进展。

- **局部逼近方法**:在状态空间的特定区域内逼近价值函数,如 K 近邻、核回归方法等。

### 2.3.2 价值函数的优化方法

价值函数优化的目标是使得估计的值函数能够尽可能地接近真实的值函数。优化方法包括但不限于:

- **贪婪策略**:在每一步选择期望回报最高的动作进行执行。

- **探索策略**:在选择动作时引入一定的随机性,以探索那些价值尚不明确的状态-动作对。

- **正则化**:为了避免过拟合,可以使用L1或L2正则化等技术来约束价值函数的复杂度。

- **经验回放**(Experience Replay):将智能体的经验存储在经验池中,随机抽取经验进行学习,可以打破样本间的时间相关性。

- **目标网络**(Target Networks):通过使用一个或多个固定的目标网络来稳定学习过程,特别是对于非线性函数逼近技术。

在本章节中,我们介绍了价值函数的基本概念、核心性质以及如何求解状态值函数和动作值函数。我们还讨论了多种价值函数的估计和优化技术,这些方法对于强化学习的效率和性能至关重要。通过本章内容的学习,您应该对价值函数及其在强化学习中的作用有了深入的理解,并为后续章节的学习打下了坚实的基础。

# 3. 策略梯度方法的深入探究

策略梯度方法是强化学习中的重要分支,它直接作用于策略函数,使其朝着预期回报最大化的方向进行优化。不同于价值函数方法,策略梯度方法直接参数化策略,并通过梯度上升来改善策略。本章将深入探讨策略梯度方法的原理、实现以及在各种应用场景下的表现。

## 3.1 策略梯度算法原理

策略梯度算法将策略参数化,通常使用神经网络表示,然后通过梯度上升的方法优化策略。它避开了价值函数的估计问题,直接对策略进行优化。

### 3.1.1 策略梯度的数学基础

策略梯度方法的核心是利用策略函数的概率性质,通过梯度上升法直接优化策略。策略函数通常表示为π(a|s; θ),其中s为状态,a为动作,θ为策略参数。我们的目标是最大化期望回报:

E[R(θ)] = ∑π(a|s; θ)R(τ),

这里R(τ)是轨迹τ的回报,而轨迹τ由状态和动作的序列组成。策略梯度的更新公式可以表示为:

Δθ ∝ ∇θE[R(θ)]

其中,∇θ表示关于参数θ的梯度。

### 3.1.2 策略梯度的目标函数

策略梯度的目标函数通常设计为期望回报的无偏估计。在实践中,通过蒙特卡洛方法或时间差分学习来估计这个梯度。目标函数的选择会影响策略梯度算法的性能,常见的目标函数包括对数策略概率乘以回报或优势函数。

## 3.2 策略梯度算法的实现与优化

本小节将介绍几种常见的策略梯度算法,以及它们的优化方法。

### 3.2.1 REINFORCE算法

REINFORCE算法是最基础的策略梯度方法之一。它使用蒙特卡洛方法对策略梯度进行估计。算法步骤如下:

1. 在给定策略下,运行策略生成一系列状态动作对和回报。

2. 计算每个时间步的动作概率与回报的乘积,得到每个动作的梯度估计。

3. 按照梯度更新策略参数。

REINFORCE算法的一个主要缺点是它具有高方差。为了缓解这个问题,可以引入基线(baseline)来减小估计的方差。

### 3.2.2 带基线的策略梯度算法

在REINFORCE算法的基础上,引入基线可以显著减少方差并提高稳定性。基线可以是任意函数,最常见的是状态值函数V(s),也可以是其他可训练的神经网络。带基线的策略梯度公式变为:

Δθ ∝ ∑(r_t - b(s_t))∇θlogπ(a_t|s_t; θ)

这里b(s)是关于状态的基线函数。引入基线后,当回报高于期望回报时,梯度会增加;当回报低于期望回报时,梯度会减少,这样有助于降低方差。

### 3.2.3 策略梯度的稳定性和性能提升

为了进一步提高策略梯度方法的稳定性和性能,研究者们提出了一系列改进方法。例如,使用演员-评论家(Actor-Critic)结构,将学习过程分为两个部分:演员(Actor)负责输出策略,而评论家(Critic)负责评估值函数。这种方法结合了策略梯度方法和价值函数方法的优点,能够有效降低方差,提高学习效率。

```python

class ActorCriticAgent:

def __init__(self):

# 初始化策略网络和值网络

self.policy_network = ...

self.value_network = ...

def update(self, states, actions, rewards, next_states, dones):

# 根据REINFORCE算法更新策略网络

# 使用TD(0)来更新值网络

pass

def act(self, state):

# 根据当前策略选择动作

pass

```

## 3.3 策略梯度的实际应用案例

策略梯度方法已被成功应用于多个领域,下面将探讨其在游戏AI和机器人控制中的具体应用。

### 3.3.1 游戏AI中的应用

游戏AI领域是策略梯度方法应用最为成功的领域之一。例如,AlphaGo利用深度神经网络结合蒙特卡洛树搜索实现了超越人类围棋水平的壮举。而策略梯度方法使得AI能够通过自我对弈进行学习,并在策略上不断进化。

### 3.3.2 机器人控制中的应用

在机器人控制领域,策略梯度方法同样显示出其强大的潜力。通过直接优化机器人的动作策略,可以实现复杂环境下的目标达成,例如自动驾驶车辆的路径规划、工业机器人的精细操作等。

在本章节中,我们详细探讨了策略梯度方法的原理、实现技术和实际应用案例。策略梯度方法的灵活性和直接性使其在许多复杂的任务中显示出优越性,尤其是在处理连续动作空间和具有高度随机性的环境中表现突出。随着深度学习技术的进一步发展,我们可以预见策略梯度方法将在更多领域得到更广泛的应用。

# 4. 高级强化学习算法

高级强化学习算法的发展推动了智能体在复杂环境中的决策能力。本章节将深入探讨演员-评论家(A2C)、深度确定性策略梯度(DDPG)以及软件体(Soft Actor-Critic, SAC)这些先进算法的原理、应用和实现方法。通过详细的分析,我们将会了解每种算法如何在不同的应用场景中发挥作用,并且为读者提供代码示例和案例分析以加深理解。

## 4.1 演员-评论家(A2C)方法

### 4.1.1 演员-评论家算法结构

演员-评论家(A2C)算法是强化学习领域的一大进步,它结合了策略梯度和价值函数的优点,是一种更为高效的训练方法。A2C中,"演员"负责产生动作,而"评论家"则评估状态价值。这种分工合作的架构使得算法能够更快地收敛,并且通过并行化提高训练效率。

在A2C中,策略和价值函数通常通过深度神经网络实现,使得算法能够处理高维状态空间。这种架构利用了策略梯度的优势来直接优化策略,并通过评论家对价值函数进行调整,从而提高了样本效率和稳定性。

### 4.1.2 A2C与A3C的比较与实践

A2C算法与异步优势演员评论家(A3C)算法有着紧密的联系。A3C是A2C的前身,其核心区别在于A3C使用异步训练来增加探索的多样性,而A2C则依赖同步训练和批量更新。A2C相对于A3C来说,更适合于需要高计算资源的环境,因为其可以在一个批量的数据上进行同步更新,从而更好地利用现代GPU的批量处理能力。

在实践上,A2C表现出了其在多个领域中的实用性和有效性。例如,在游戏AI领域,A2C成功地被用于训练能够玩各种游戏的智能体。另外,由于其具有良好的样本效率和训练稳定性,A2C也被应用于机器人控制,尤其在处理连续动作空间的问题上显示出明显的优势。

### 代码示例:实现A2C算法

以下是一个简化的A2C算法实现,使用Python和PyTorch库。请注意,这只是为了说明如何构建A2C算法的代码结构,并不是完整的实现。

```python

import torch

import torch.nn as nn

import torch.optim as optim

class ActorCritic(nn.Module):

def __init__(self, ...):

super(ActorCritic, self).__init__()

# Define actor and critic networks

def forward(self, ...):

# Define forward pass

def act(self, ...):

# Define action selection logic

def evaluate(self, ...):

# Evaluate the policy and value function

# Hyperparameters

learning_rate = ...

num_steps = ...

gamma = ...

# Initialize actor-critic module

ac = ActorCritic(...)

# Optimizer

optimizer = optim.Adam(ac.parameters(), lr=learning_rate)

# Training loop

for _ in range(num_steps):

# Sample environment transitions

# ...

# Compute returns and advantages

# ...

# Update policy and value function

optimizer.zero_grad()

policy_loss, value_loss = ac.evaluate(states, actions, returns, advantages)

(policy_loss + value_loss).backward()

optimizer.step()

```

在上述代码中,我们首先定义了一个`ActorCritic`类,它包含了策略网络("actor")和价值网络("critic")。然后,我们在训练循环中采样环境的过渡,计算回报(returns)和优势函数(advantages),并执行策略和价值函数的更新。

## 4.2 深度确定性策略梯度(DDPG)

### 4.2.1 DDPG的理论基础

深度确定性策略梯度(DDPG)算法是一种结合了深度学习和策略梯度技术的无模型、连续控制算法。DDPG在解决具有高维观测空间和连续动作空间的强化学习问题上表现出色。它采用了一种确定性的策略,这意味着给定状态,策略将决定一个明确的动作,而不是一个动作的概率分布。

DDPG的策略梯度是通过一个目标策略网络和一个在线策略网络实现的,策略梯度通过最大化预期回报来更新。同时,DDPG引入了一个价值网络,用以评估策略的质量,并通过经验回放机制来打破相关性,进一步稳定训练过程。

### 4.2.2 DDPG在连续动作空间的应用

DDPG在连续动作空间中应用广泛,尤其在机器人控制、自动驾驶车辆等领域。例如,DDPG可以被应用于让机器人在物理世界中执行特定的任务,比如抓取物体、在环境中导航等。

连续动作空间中的控制任务通常很难解决,因为动作空间太大,难以探索。DDPG通过采用确定性策略和利用经验回放的方法,能够有效地学习在连续空间中的控制策略。

### 代码示例:实现DDPG算法

以下是一个简化的DDPG算法实现,使用Python和PyTorch库。这个示例仅用于演示算法的核心结构。

```python

import torch

import torch.nn as nn

import torch.optim as optim

class DDPGAgent:

def __init__(self, ...):

# Initialize actor and critic networks

# ...

def act(self, state):

# Select action based on the current state

# ...

def step(self, memory):

# Learn from stored experiences

# ...

# Hyperparameters

memory_capacity = ...

batch_size = ...

... # Other hyperparameters

# Initialize DDPG agent

agent = DDPGAgent(...)

# Training loop

for episode in range(max_episodes):

# Interact with the environment to collect experience

# ...

# Store experience in memory

# ...

# Learn from a random batch of experiences

agent.step(memory.sample(batch_size))

# Evaluate the performance of the agent

# ...

```

在上述代码中,我们首先定义了一个`DDPGAgent`类,它包含了策略网络(actor)和价值网络(critic)。然后,我们在训练循环中让智能体与环境交互,收集经验,并在内存中存储。在随机采样一批经验后,智能体通过这些经验进行学习。

## 4.3 软件体(Soft Actor-Critic, SAC)

### 4.3.1 SAC的原理与优势

Soft Actor-Critic(SAC)算法是一种基于最大熵原理的强化学习算法,它不仅致力于最大化预期回报,还努力增加策略的随机性,这种随机性通过熵正则化来实现。SAC算法引入了一个温度参数来平衡回报最大化和熵最大化之间的关系。

这种熵正则化带来几个优点:首先,它鼓励探索,因为熵的增加对应于探索行为的奖励;其次,它可以提高学习稳定性;最后,SAC算法通常具有更高的样本效率。

### 4.3.2 SAC的算法实现与案例分析

SAC在实现上可以看作是对DDPG算法的一种改进,它使用两个策略网络(一个用于目标策略,一个用于在线策略),并且有两个价值网络来评估当前策略和目标策略。SAC算法通过梯度下降的方法来优化策略,目标函数考虑了回报、价值函数和熵。

SAC已经被成功应用于各种复杂的连续控制任务,例如机器人双足行走。其平衡了探索与利用,并且在很多情况下,相比于DDPG,SAC表现出了更好的收敛性和性能。

### 代码示例:实现SAC算法

下面的代码片段是一个简化版的SAC算法实现,使用Python和PyTorch库。这个示例旨在展示算法的核心思想和实现步骤。

```python

import torch

import torch.nn as nn

import torch.optim as optim

class SACAgent:

def __init__(self, ...):

# Initialize actor, critics and target networks

# ...

def act(self, state):

# Select action with added noise for exploration

# ...

def update_temperature(self, ...):

# Adjust the temperature parameter

# ...

def learn(self, memory):

# Sample a batch of experiences and update networks

# ...

# Hyperparameters

... # Define SAC hyperparameters

# Initialize SAC agent

agent = SACAgent(...)

# Training loop

for episode in range(max_episodes):

# Interact with the environment

# ...

# Update temperature parameter

agent.update_temperature(...)

# Learn from experience

agent.learn(memory.sample(batch_size))

# Evaluate performance

# ...

```

上述代码展示了SAC算法的基本框架,包括策略选择、温度参数调整和学习过程。这种实现方式通过增加熵来鼓励探索,同时通过多次更新策略和价值网络来提高学习效率。

以上内容为第四章的详细介绍。本章通过深入解析演员-评论家(A2C)、深度确定性策略梯度(DDPG)和软件体(SAC)三种先进的强化学习算法,为读者提供了在连续动作空间和高复杂度环境中实现有效控制的方案。通过代码示例、理论分析和案例研究,本章旨在帮助读者建立对高级强化学习算法的深刻理解。

# 5. 强化学习算法的挑战与展望

## 5.1 强化学习面临的主要挑战

在强化学习不断发展的过程中,我们面临着诸多挑战,这些挑战与技术难题密切相关,但也与如何让这些技术在现实世界中发挥作用息息相关。

### 5.1.1 环境的复杂性与动态性

随着强化学习应用领域的不断扩大,算法必须能够处理更为复杂和动态变化的环境。例如,在金融市场中,价格变化的不可预测性,或是自动驾驶中不断变化的道路情况,都要求算法能够适应这些复杂性。

复杂环境下的强化学习需要对现实世界中的不确定性和随机性有很好的适应能力。这就要求算法在面对高维状态空间时依然能够高效学习,并且对新出现的场景或状态变化能够快速适应。

```python

# 伪代码示例:复杂环境中的状态处理

# 假设存在一个复杂环境状态处理函数complex_environment_handler

def complex_environment_handler(state):

# 处理环境状态,提取关键信息

processed_state = process_state(state)

return processed_state

# 应用到强化学习算法中

for episode in episodes:

state = get_initial_state()

while not end_of_episode(state):

processed_state = complex_environment_handler(state)

action = agent.act(processed_state)

state, reward, done = environment.step(action)

agent.learn(state, action, reward)

```

### 5.1.2 探索与利用的平衡问题

探索(explore)与利用(exploit)是强化学习中的经典问题。算法需要在尝试新的、可能更好的动作(探索)和选择已知的最优动作(利用)之间找到平衡。当环境变化快速时,这个平衡变得尤为棘手。

一个经常采用的方法是引入ε-greedy策略,它允许算法有一定概率去探索新的动作,而大多数时间仍然选择当前最优动作。

```python

import numpy as np

def epsilon_greedy(q_table, state, epsilon):

if np.random.random() < epsilon:

# 探索:随机选择一个动作

action = np.random.choice(range(len(q_table[state])))

else:

# 利用:选择当前最优动作

action = np.argmax(q_table[state])

return action

```

## 5.2 未来强化学习的研究方向

随着技术的发展,强化学习的研究正朝着更高级的方向迈进。

### 5.2.1 元学习在强化学习中的应用

元学习,又称“学会学习”,指的是算法能够快速适应新任务的能力。在强化学习中,元学习可以帮助智能体在面对新环境或任务时迅速学习到有效的策略。

### 5.2.2 多智能体强化学习的进展

多智能体强化学习是指多个智能体在同一个环境中学习和决策。这在自动驾驶、机器人足球等场景中有着广泛的应用潜力。在这样的系统中,智能体需要学会与其他智能体沟通、合作或竞争,从而实现共同目标。

## 5.3 强化学习在实际中的机遇与前景

强化学习已经开始在工业界产生实际的影响,并将继续扩展其应用范围。

### 5.3.1 强化学习在工业界的应用趋势

从能源管理到制造过程优化,强化学习正在逐步渗透到工业界的各个角落。在这些应用中,通过与物理过程紧密结合,强化学习不仅提高了效率,还改善了系统的稳定性。

### 5.3.2 人工智能伦理与强化学习的社会影响

随着强化学习在社会决策中的应用增加,比如健康护理、交通管理等领域,对其伦理和法律问题的讨论也变得日益重要。如何确保算法的公平性、透明性和责任归属成为不可回避的问题。

在本章中,我们探讨了强化学习当前和未来可能面临的挑战,同时也展望了它在各个领域中的应用机遇。面对这些挑战,研究者和从业者需要不断创新与合作,以确保强化学习技术能够更好地服务于社会。

0

0