【强化学习进阶秘籍】:深度Q网络(DQN)的原理与应用案例

发布时间: 2024-11-19 15:54:56 阅读量: 142 订阅数: 22

强化学习从基础到进阶-案例与实践含码源-强化学习全系列超详细算法码源齐全.zip

# 1. 深度Q网络(DQN)基础原理

## 1.1 DQN的历史背景与定义

深度Q网络(Deep Q-Network,简称DQN)是一种结合了深度学习和强化学习的算法,它通过使用深度神经网络作为函数逼近器来实现价值函数的近似。DQN解决了传统强化学习中状态空间和动作空间过大时的维度灾难问题,并成功应用于多种高维输入的游戏和现实世界问题中。它的核心思想在于使用深度神经网络来处理复杂的数据输入,从而学习到最优策略。

## 1.2 DQN的工作原理

DQN的工作原理可以概括为通过经验回放和目标网络的机制,提高学习过程的稳定性和收敛性。在DQN中,智能体通过对环境进行探索和利用,生成一系列的(状态,动作,奖励,新状态)四元组数据,这些数据存储在经验回放池中。在训练时,DQN随机抽取这些经验数据进行学习,减少相关性,增加数据的多样性。同时,DQN使用一个稳定的网络(目标网络)来估计目标值,避免训练过程中的不稳定性。

## 1.3 DQN的关键技术组件

DQN的关键技术组件包括经验回放、目标网络、损失函数和梯度下降。经验回放机制允许智能体从过去的经历中随机抽取样本来打破数据的相关性,而目标网络则为策略网络提供稳定的目标参考,以防止训练过程中的目标不断变动。损失函数衡量策略网络的输出与目标值之间的差异,梯度下降方法则是用来更新策略网络的参数以最小化损失函数。这些组件共同构成了DQN强大功能的基础,使得它在处理复杂问题时能够稳定地学习和适应。

# 2. 深度学习在DQN中的应用

## 2.1 神经网络基础知识回顾

### 2.1.1 人工神经网络的结构与功能

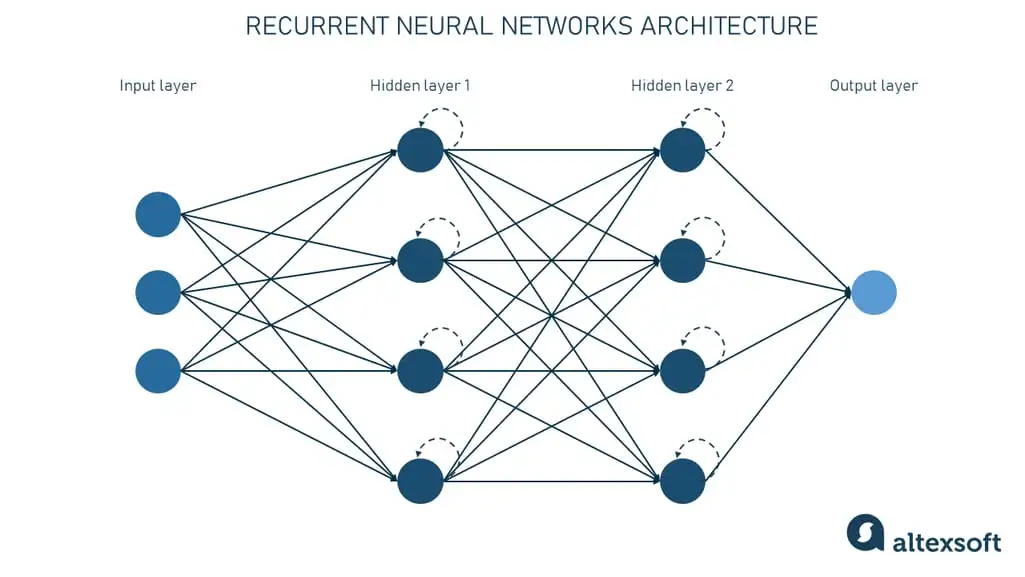

人工神经网络(ANN)是深度学习中的基础构成单元,它模拟了人类大脑中神经元的工作原理。一个典型的神经网络包括输入层(input layer)、隐藏层(hidden layer)和输出层(output layer)。输入层接收数据,隐藏层处理数据,而输出层提供最终的决策或预测。

一个神经网络的节点通常由权重(weight)、偏置(bias)、激活函数(activation function)和输入值组成。权重和偏置是网络在训练过程中学习和调整的参数,激活函数则为网络提供了非线性特征,使得网络能够学习复杂的模式和结构。

神经网络的学习过程,即前向传播(forward propagation)和反向传播(backpropagation)是连续进行的,直到网络的预测误差最小化。前向传播是将输入数据通过各层权重和激活函数进行处理,最终得到输出值。如果输出值与期望值存在误差,则进行反向传播,根据误差对网络权重进行更新。

### 2.1.2 激活函数与损失函数的选择

在神经网络中,激活函数是一个非常关键的组成部分。它负责添加非线性因素,这对于网络学习复杂的模式至关重要。常见的激活函数包括Sigmoid、Tanh、ReLU及其变种等。例如,ReLU(Rectified Linear Unit)函数在正区间内输出输入值,而在负区间内输出0,这种特性使得网络在训练过程中避免了梯度消失的问题。

损失函数用于评估模型的预测值与真实值之间的差异,它是衡量模型性能的主要方式。对于回归问题,均方误差(MSE)是常见的损失函数;而在分类问题中,交叉熵损失函数(cross-entropy loss)则更为常用,因为它能够更有效地衡量概率分布之间的差异。

```python

import numpy as np

# 激活函数例子:ReLU函数

def relu(x):

return np.maximum(0, x)

# 损失函数例子:交叉熵损失函数

def cross_entropy(y_true, y_pred):

return -np.sum(y_true * np.log(y_pred) + (1 - y_true) * np.log(1 - y_pred))

```

在上述代码中,`relu`函数表示ReLU激活函数的实现,`cross_entropy`函数则用于计算交叉熵损失值。在实际应用中,会使用深度学习框架提供的预定义函数,例如TensorFlow或PyTorch,来计算这些值以提高效率和准确性。

## 2.2 强化学习与深度学习的融合

### 2.2.1 强化学习概述

强化学习是一种让机器通过与环境互动并获取奖励来学习的行为的学习方法。在强化学习的框架中,存在一个智能体(Agent)和一个环境(Environment)。智能体在每个时间步骤中观察环境状态(State),采取动作(Action),然后环境给予智能体一个奖励(Reward),智能体的目标是通过最大化长期奖励来学习一个策略(Policy),即如何根据状态选择动作。

### 2.2.2 深度学习在强化学习中的作用

深度学习的引入使得强化学习能够处理更加复杂和高维的状态空间。传统的强化学习方法在处理高维数据时存在困难,因为它们通常需要手工设计特征。而深度学习能够自动从原始数据中学习到高层次的特征表示,这极大地扩展了强化学习的应用范围。

深度学习和强化学习的结合产生了深度强化学习(DRL),它通过深度神经网络(如卷积神经网络CNN和循环神经网络RNN)来近似策略函数或值函数。其中,DQN就是第一个取得突破的DRL算法,它能够利用深度神经网络来估计动作价值,实现了在高维状态空间下的有效学习。

### 2.2.3 DQN的提出与必要性

DQN,全称为Deep Q-Network,由Mnih等人于2015年提出,是深度强化学习领域的一个里程碑。DQN通过结合Q学习与深度神经网络,成功地解决了传统强化学习在连续动作空间和高维状态空间中的学习问题。

Q学习是一种无模型(model-free)的强化学习算法,它通过更新动作价值函数Q来逼近最优策略。在没有深度学习之前,Q学习主要依赖于表格形式存储状态-动作对的价值,这在高维状态下变得不可行。DQN的提出解决了这一问题,它使用深度神经网络来近似Q函数,使得智能体能够处理复杂的、像素化的状态信息,从而在诸如Atari游戏这样的任务上取得了前所未有的成功。

## 2.3 深度Q网络的架构细节

### 2.3.1 状态价值函数与动作价值函数

在强化学习中,状态价值函数(V)和动作价值函数(Q)是核心概念。状态价值函数表示从某个状态开始,遵循策略π直到游戏结束的预期收益。而动作价值函数表示从某个状态开始,采取某个动作,然后遵循策略π直到游戏结束的预期收益。

Q函数是强化学习中的关键,它给出在特定状态下采取特定动作的价值评估。DQN通过学习Q函数来优化策略,使得在每个状态下智能体选择的动作能够最大化累积奖励。

### 2.3.2 经验回放与目标网络

在DQN中,经验回放(Experience Replay)是一个非常重要的技术,它通过存储智能体的每一个状态、动作、奖励和新状态的“经验”(transition),使得这些经验可以被重复利用。这有助于打破时间上的相关性,并且能够以更高效的方式训练网络。

目标网络(target network)是DQN的另一个核心组件,它是一个参数固定一段时间的深度Q网络,用于产生稳定的Q值来减少学习过程中的过拟合和震荡。网络参数在一定步骤后同步更新,提高了算法的稳定性和收敛速度。

### 2.3.3 损失函数的优化与梯度下降

DQN通过最小化均方误差(MSE)损失函数来优化参数。损失函数定义为预测的Q值与目标Q值之间的差距。为了计算这个损失,DQN使用了一个双网络结构,即当前网络和目标网络。目标Q值是由目标网络计算得到的,这使得学习过程更加稳定。

梯度下降是优化损失函数的主要方法,通过计算损失函数相对于网络参数的梯度,然后沿着这个梯度的反方向更新参数,从而减少损失函数值。学习率(learning rate)是控制每一步更新幅度的超参数,它在优化过程中需要仔细选择以确保收敛速度和稳定性。

```python

import tensorflow as tf

# 假设我们已经有一个Q网络和一个目标网络

current_q_net = ... # 当前网络

target_q_net = ... # 目标网络

# 获取经验数据

states, actions, rewards, next_states = ... # 状态,动作,奖励,新状态

with tf.GradientTape() as tape:

# 计算当前网络的Q值

current_q_values = current_q_net(states)

# 选择动作

actions_one_hot = tf.one_hot(actions, num_actions)

q_values_for_actions = tf.reduce_sum(current_q_values * actions_one_hot, axis=1)

# 计算目标网络的Q值

next_q_values = target_q_net(next_states)

# 应用贝尔曼方程计算目标Q值

max_next_q_values = tf.reduce_max(next_q_values, axis=1)

target_q_values = rewards + discount_factor * max_next_q_values

# 计算损失函数

loss = tf.reduce

```

0

0