CNN正则化技术:防止过拟合与提高泛化能力,增强模型鲁棒性

发布时间: 2024-07-20 05:39:35 阅读量: 114 订阅数: 41

正则化算法

# 1. CNN正则化技术概述

正则化技术是机器学习中防止过拟合的重要方法,在卷积神经网络(CNN)中尤为重要。CNN正则化技术通过引入额外的约束来控制模型的复杂度,防止模型过分拟合训练数据,从而提高模型的泛化能力和鲁棒性。

本篇文章将全面介绍CNN正则化技术,包括其理论基础、常用的正则化方法、实践应用、正则化超参数选择以及正则化技术在不同CNN架构中的应用。通过深入了解CNN正则化技术,读者可以有效提高CNN模型的性能,提升模型的泛化能力和鲁棒性。

# 2. 理论基础

### 2.1 过拟合与正则化

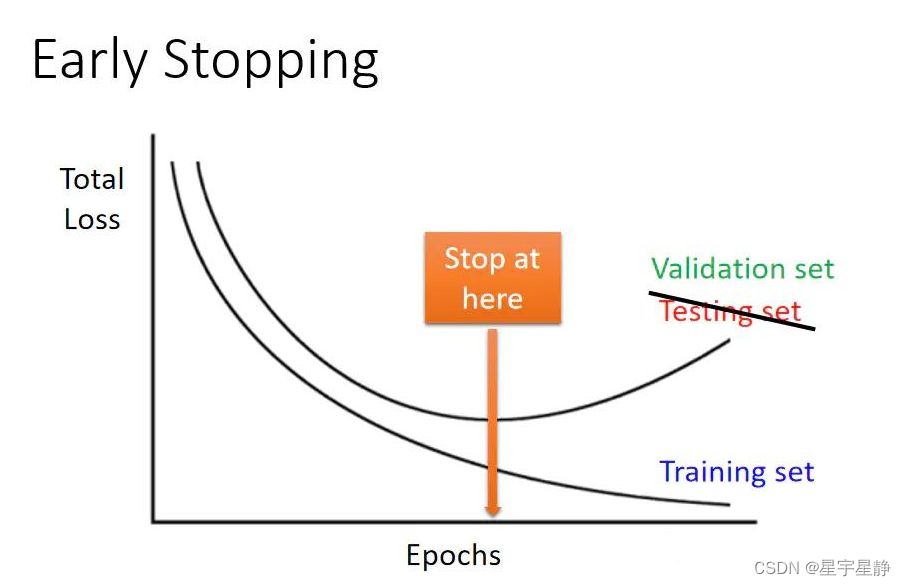

**过拟合**是指机器学习模型在训练数据集上表现良好,但在新数据上表现不佳的现象。这是由于模型过度学习了训练数据的具体细节,导致其无法泛化到未见过的样本。

**正则化**是一种技术,通过惩罚模型的复杂性来防止过拟合。通过向损失函数添加一个正则化项,正则化鼓励模型学习更简单的假设,从而提高其泛化能力。

### 2.2 正则化方法

有许多正则化方法可用于CNN:

#### 2.2.1 L1正则化

**L1正则化**(也称为Lasso正则化)向损失函数中添加权重系数的绝对值之和。它鼓励模型选择稀疏解,其中许多权重为零。

```python

import tensorflow as tf

# L1正则化

l1_regularizer = tf.keras.regularizers.l1(0.01)

# 添加正则化项到损失函数

loss_fn = tf.keras.losses.MeanSquaredError() + l1_regularizer(model)

```

#### 2.2.2 L2正则化

**L2正则化**(也称为岭回归)向损失函数中添加权重系数的平方和。它鼓励模型选择小的权重,从而防止过拟合。

```python

import tensorflow as tf

# L2正则化

l2_regularizer = tf.keras.regularizers.l2(0.01)

# 添加正则化项到损失函数

loss_fn = tf.keras.losses.MeanSquaredError() + l2_regularizer(model)

```

#### 2.2.3 Dropout

**Dropout**是一种正则化技术,通过在训练过程中随机丢弃神经网络中的某些神经元来防止过拟合。这迫使模型学习更鲁棒的特征,减少对特定神经元的依赖。

```python

import tensorflow as tf

# Dropout层

dropout_layer = tf.keras.layers.Dropout(0.2)

# 在训练过程中添加Dropout层

model.add(dropout_layer)

```

#### 2.2.4 数据增强

**数据增强**是一种正则化技术,通过对训练数据进行随机变换(例如翻转、旋转、裁剪)来创建新的训练样本。这增加了训练数据的多样性,迫使模型学习更通用的特征。

```python

import tenso

```

0

0