Python自然语言处理:使用NLTK和spaCy处理文本数据,让机器理解人类语言

发布时间: 2024-06-19 18:01:39 阅读量: 94 订阅数: 30

自然语言处理工具NLTK

# 1. 自然语言处理简介**

自然语言处理(NLP)是计算机科学的一个分支,它涉及让计算机理解和生成人类语言。NLP 的目标是使计算机能够以类似于人类的方式与自然语言进行交互,从而实现人机交互的自然化。

NLP 的应用范围广泛,包括机器翻译、文本分类、信息检索、问答系统和聊天机器人。它在各个行业中都有着重要的作用,例如客户服务、医疗保健和金融。

NLP 是一门复杂且不断发展的领域,它融合了语言学、计算机科学和人工智能等多个学科的知识。随着计算机技术和算法的不断进步,NLP 的能力也在不断提升,为我们带来了更多可能性。

# 2. Python自然语言处理工具

自然语言处理(NLP)是一门计算机科学领域,它专注于计算机与人类语言之间的交互。Python是NLP中最流行的编程语言之一,因为它提供了丰富的库和工具,可以帮助我们轻松高效地处理自然语言数据。

### 2.1 NLTK:自然语言工具包

NLTK(Natural Language Toolkit)是一个开源的Python库,专门用于NLP任务。它提供了一系列功能强大的工具,涵盖从文本预处理到机器学习模型开发的各个方面。

**主要功能:**

* 文本分词、标注和句法分析

* 词汇库和语料库

* 统计自然语言处理

* 机器学习接口

**示例代码:**

```python

import nltk

# 文本分词

sentence = "The quick brown fox jumped over the lazy dog."

tokens = nltk.word_tokenize(sentence)

print(tokens)

```

**逻辑分析:**

* `nltk.word_tokenize()`函数将句子分词为单词列表。

* `tokens`变量存储分词后的结果。

### 2.2 spaCy:工业级自然语言处理库

spaCy是一个开源的Python库,它提供了先进的NLP功能,特别适用于工业级应用。与NLTK相比,spaCy更加注重性能和可扩展性。

**主要功能:**

* 高性能自然语言处理管道

* 预训练语言模型

* 命名实体识别和关系提取

* 文本相似性和分类

**示例代码:**

```python

import spacy

# 加载预训练模型

nlp = spacy.load("en_core_web_sm")

# 文本处理

doc = nlp("The quick brown fox jumped over the lazy dog.")

# 命名实体识别

for ent in doc.ents:

print(ent.text, ent.label_)

```

**逻辑分析:**

* `spacy.load()`函数加载预训练的语言模型。

* `nlp`变量存储加载后的模型。

* `doc`变量存储文本处理后的结果。

* `doc.ents`属性获取文本中的命名实体。

* `ent.text`属性获取命名实体的文本。

* `ent.label_`属性获取命名实体的标签。

**表格:NLTK和spaCy的比较**

| 特征 | NLTK | spaCy |

|---|---|---|

| 性能 | 较低 | 较高 |

| 可扩展性 | 较低 | 较高 |

| 预训练模型 | 有限 | 丰富 |

| 命名实体识别 | 基本 | 优秀 |

| 文本相似性和分类 | 有限 | 优秀 |

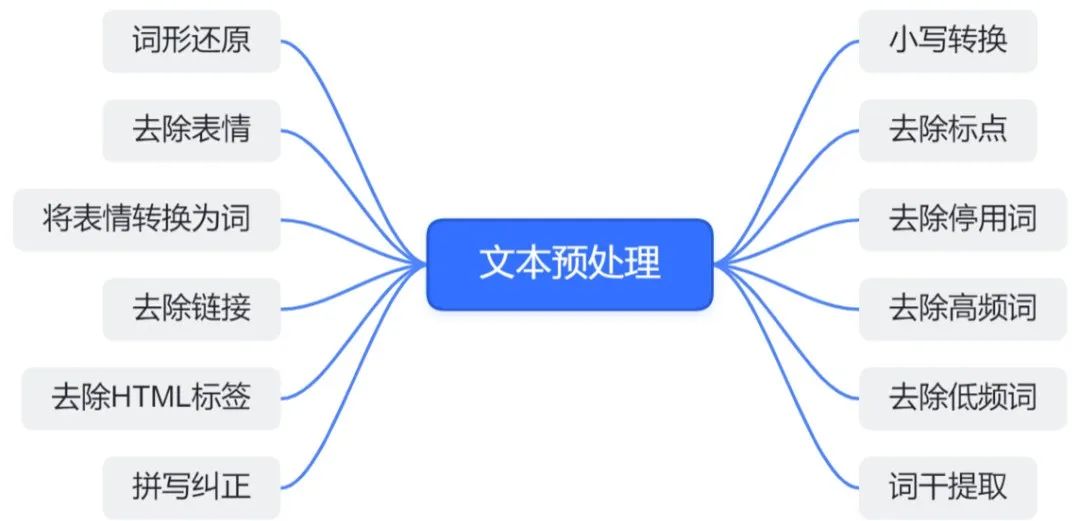

# 3. 文本预处理

### 3.1 文本分词

文本分词是将文本中的句子或段落分解为单个词或词组的过程。它对于自然语言处理任务至关重要,因为它可以帮助提取有意义的特征并提高模型的性能。

**分词方法**

有两种主要的分词方法:

- **基于规则的方法:**使用预定义的规则和词典来识别单词边界。

- **基于统计的方法:**使用统计模型来学习单词边界,例如隐马尔可夫模型(HMM)或条件随机场(CRF)。

**Python中的分词工具**

Python中常用的分词工具包括:

- **NLTK:**提供基于规则和基于统计的分词器。

- **spaCy:**一个工业级的NLP库,提供高级的分词功能。

**代码示例:**

```python

# 使用NLTK进行基于规则的分词

import nltk

text = "Natural language processing is a subfield of linguistics, computer science, and artificial intelligence concerned with the interactions between computers and human (natural) languages."

nltk_tokenizer = nltk.word_tokenize(text)

print(nltk_tokenizer)

# 使用spaCy进行基于统计的分词

import spacy

nlp = spacy.load("en_core_web_sm")

doc = nlp(text)

for token in doc:

print(token.text)

```

**逻辑分析:**

- NLTK的`word_tokenize`函数使用基于规则的分词器,它根据预定义的规则和词典来识别单词边界。

- spaCy的`nlp`对象使用基于统计的分词器,它使用隐马尔可夫模型来学习单词边界。

### 3.2 去除停用词

停用词是自然语言中出现频率很高但意义不大的词,例如“the”、“and”、“of”。去除停用词可以减少文本的噪音,提高特征提取和建模的效率。

**停用词列表**

停用词列表通常是预先定义好的,但也可以根据具体任务进行定制。Python中常用的停用词列表包括:

- **NLTK:**提供了一个包含英语停用词的内置列表。

- **spaCy:**提供了一个基于语言的停用词列表,例如`nlp.Defaults.stop_words`。

**代码示例:**

```python

# 使用NLTK去除停用词

import nltk

stopwords = nltk.corpus.stopwords.words('english')

filtered_text = [word for word in nltk_tokenizer if word not in stopwords]

print(filtered_text)

# 使用spaCy去除停用词

import spacy

nlp = spacy.load("en_core_web_sm")

doc = nlp(text)

filtered_text = [token.text for token in doc if not token.is_stop]

print(filtered_text)

```

**逻辑分析:**

- NLTK的`corpus.stopwords`模块提供了一个英语停用词列表。

- spaCy的`is_stop`属性指示一个词是否是停用词。

### 3.3 词干化和词形还原

词干化和词形还原都是将单词还原为其基本形式的过程。词干化通过去除词缀(前缀和后缀)来实现,而词形还原则通过查找单词在词典中的正确形式来实现。

**词干化和词形还原的区别**

词干化是一个更激进的过程,它可能会产生不正确的单词形式,而词形还原则更准确,但可能无法处理所有单词。

**Python中的词干化和词形还原工具**

Python中常用的词干化和词形还原工具包括:

- **NLTK:**提供`stemmer`和`lemmatizer`类。

- **spaCy:**提供`lemmatizer`属性。

**代码示例:**

```python

# 使用NLTK进行词干化

import nltk

stemmer = nltk.stem.PorterStemmer()

stemmed_text = [stemmer.stem(word) for word in filtered_text]

print(stemmed_text)

# 使用spaCy进行词形还原

import spacy

nlp = spacy.load("en_core_web_sm")

doc = nlp(text)

lemmatized_text = [token.lemma_ for token in doc]

print(lemmatized_text)

```

**逻辑分析:**

- NLTK的`stemmer`类使用波特词干算法,它通过去除词缀来进行词干化。

- spaCy的`lemmatizer`属性使用词典查找来进行词形还原。

# 4. 文本特征提取**

文本特征提取是自然语言处理中至关重要的一步,它将文本数据转换为可用于机器学习模型的数值特征。本文将介绍三种常用的文本特征提取技术:词袋模型、词嵌入和主题建模。

### 4.1 词袋模型(Bag-of-Words)

词袋模型是一种最简单的文本特征提取技术。它将文本表示为一个单词的集合,而忽略单词的顺序和语法结构。

**代码块:**

```python

from sklearn.feature_extraction.text import CountVectorizer

# 创建一个 CountVectorizer 对象

vectorizer = CountVectorizer()

# 拟合和转换文本数据

X = vectorizer.fit_transform(['This is a sample text.', 'This is another sample text.'])

# 打印特征名称

print(vectorizer.get_feature_names_out())

```

**逻辑分析:**

* `CountVectorizer` 类用于创建词袋模型。

* `fit_transform()` 方法拟合和转换文本数据。

* `get_feature_names_out()` 方法返回特征名称(单词)。

**参数说明:**

* `max_features`:限制特征的数量。

* `min_df`:忽略出现次数低于给定阈值的单词。

* `max_df`:忽略出现次数高于给定阈值的单词。

### 4.2 词嵌入(Word Embeddings)

词嵌入是一种将单词表示为低维向量的技术。它可以捕获单词之间的语义和语法关系。

**代码块:**

```python

import gensim

# 加载预训练的 Word2Vec 模型

model = gensim.models.Word2Vec.load('word2vec.model')

# 获取单词的词嵌入

embedding = model['word']

```

**逻辑分析:**

* `Word2Vec` 类用于加载和使用 Word2Vec 模型。

* `load()` 方法加载预训练的模型。

* `__getitem__()` 方法获取单词的词嵌入。

**参数说明:**

* `size`:词嵌入向量的维度。

* `window`:训练模型时考虑的单词上下文大小。

* `min_count`:忽略出现次数低于给定阈值的单词。

### 4.3 主题建模

主题建模是一种将文本数据分解为一系列主题的技术。它可以发现文本中的隐藏模式和结构。

**代码块:**

```python

import sklearn.decomposition.LatentDirichletAllocation as LDA

# 创建一个 LDA 模型

lda = LDA(n_components=10)

# 拟合和转换文本数据

X = lda.fit_transform(['This is a sample text.', 'This is another sample text.'])

# 打印主题

print(lda.components_)

```

**逻辑分析:**

* `LatentDirichletAllocation` 类用于创建 LDA 模型。

* `fit_transform()` 方法拟合和转换文本数据。

* `components_` 属性包含主题。

**参数说明:**

* `n_components`:主题的数量。

* `max_iter`:模型训练的最大迭代次数。

* `learning_offset`:用于优化模型收敛的超参数。

**表格:文本特征提取技术的比较**

| 技术 | 优点 | 缺点 |

|---|---|---|

| 词袋模型 | 简单易用 | 忽略单词顺序和语法 |

| 词嵌入 | 捕获单词关系 | 计算成本高 |

| 主题建模 | 发现隐藏模式 | 解释性差 |

# 5.1 支持向量机(SVM)

### 5.1.1 SVM 原理

支持向量机(SVM)是一种二分类算法,它通过在高维空间中找到一个超平面来将数据点分开。超平面是将数据点分成两类的决策边界。

SVM 的工作原理如下:

1. 将数据点映射到高维空间。

2. 找到一个超平面,使超平面与数据点之间的距离最大。

3. 超平面上的点称为支持向量。

### 5.1.2 SVM 算法

SVM 算法的数学公式如下:

```python

maximize αi - 1/2 ∑i,j=1n αiαjyiyjK(xi, xj)

subject to ∑i=1n αiyi = 0

and 0 ≤ αi ≤ C

```

其中:

* αi 是拉格朗日乘子

* yi 是数据点的标签(+1 或 -1)

* K(xi, xj) 是核函数

* C 是正则化参数

### 5.1.3 SVM 核函数

核函数用于将数据点映射到高维空间。常用的核函数有:

* 线性核函数:K(x, y) = x · y

* 多项式核函数:K(x, y) = (x · y + c)^d

* 高斯径向基核函数:K(x, y) = exp(-γ||x - y||^2)

### 5.1.4 SVM 参数调优

SVM 的主要参数是正则化参数 C 和核函数的参数(如 γ 和 d)。可以通过交叉验证来调优这些参数。

### 5.1.5 SVM 优缺点

**优点:**

* 对高维数据鲁棒

* 可处理非线性数据

* 训练后模型简单

**缺点:**

* 训练时间长

* 对于大数据集,内存消耗大

* 对于噪声数据敏感

### 5.1.6 SVM 应用

SVM 广泛应用于文本分类、图像分类、生物信息学等领域。

**示例:**

```python

from sklearn.svm import SVC

# 训练 SVM 模型

model = SVC()

model.fit(X_train, y_train)

# 预测测试集

y_pred = model.predict(X_test)

```

# 6. 文本生成

文本生成是自然语言处理中的一项重要任务,它旨在根据给定的输入文本生成新的文本。文本生成技术广泛应用于各种领域,如机器翻译、聊天机器人、文本摘要和创意写作。

### 6.1 语言模型

语言模型是文本生成的基础,它可以预测给定文本序列中下一个单词或字符的概率分布。语言模型通常使用神经网络来训练,例如循环神经网络(RNN)或变压器网络。

训练语言模型时,需要使用大量文本语料库。训练完成后,语言模型可以根据输入文本序列生成新的文本,并模拟人类语言的语法和语义结构。

### 6.2 序列到序列模型

序列到序列模型(Seq2Seq)是用于文本生成的一种特定类型的语言模型。Seq2Seq 模型由两个神经网络组成:编码器和解码器。

编码器将输入文本序列编码成一个固定长度的向量,该向量包含输入文本的语义信息。解码器使用编码器的输出向量作为输入,并生成一个新的文本序列。

Seq2Seq 模型广泛应用于机器翻译和聊天机器人等任务。

### 6.3 文本摘要

文本摘要是文本生成的一种应用,它旨在根据给定的长文本生成一个更短、更简洁的摘要。文本摘要技术可以帮助用户快速了解长文本的主要内容。

文本摘要模型通常使用 Seq2Seq 模型或其他神经网络架构。训练文本摘要模型时,需要使用成对的文本数据,其中一个文本是原始文本,另一个文本是相应的摘要。

训练完成后,文本摘要模型可以根据输入文本生成摘要,并提取文本中最重要的信息。

0

0