itertools与大数据:优化内存管理与数据处理的策略

发布时间: 2024-10-08 22:25:22 阅读量: 25 订阅数: 22

大华无插件播放项目111

# 1. itertools库简介及其在大数据处理中的重要性

在当今数据驱动的世界,处理大量数据的能力成为衡量一个系统性能的关键指标。`itertools`是一个在Python标准库中广泛使用的模块,它包含了一组用于创建和操作迭代器的函数。这些函数能够高效地处理数据集合,尤其是在数据流需要排序、组合、筛选或重复的情况下。

随着大数据时代的到来,传统的数据处理方法已经无法满足需求,大数据的特性包括体量大、速度快、种类多、价值密度低和真实性。这些特点要求数据处理方法必须是高效、可扩展和资源友好的。`itertools`通过迭代器模式实现了这一点,迭代器模式延迟计算数据,仅在需要时生成下一个值,从而优化内存使用,提升数据处理速度。

总之,`itertools`在大数据处理中的重要性体现在其提供的高效数据流操作能力,它能够帮助开发者在内存资源受限的情况下,优雅地处理大规模数据集。这使得`itertools`成为在数据密集型应用中不可或缺的工具。在后续章节中,我们将深入探讨`itertools`的工作机制,以及如何在真实世界的大数据处理任务中应用它。

# 2. itertools理论基础与数据流控制

在大数据处理中,数据流的控制是实现效率与性能的关键。itertools库,作为Python标准库的一部分,提供了大量用于创建和使用迭代器的工具,这些工具特别适合于处理潜在无限的数据序列,非常适合于大数据场景。本章节将深入探讨itertools的理论基础及其在数据流控制方面的应用。

## 2.1 itertools的生成器概念和特性

### 2.1.1 生成器的工作原理

生成器是Python中一种特殊的迭代器。它们允许函数返回一个可遍历的序列,但不是一次性生成所有值,而是一次生成一个值,直到达到序列的末尾。生成器的工作原理建立在Python的惰性求值概念之上,即值仅在需要时才会被计算和产生。

生成器函数通过使用关键字`yield`来产生值。每次调用生成器的`.next()`方法时,函数便会从上次`yield`语句的位置继续执行,直到遇到下一个`yield`或函数结束。

```python

def simple_generator():

yield 'First value'

yield 'Second value'

yield 'Third value'

gen = simple_generator()

print(next(gen)) # 输出: First value

print(next(gen)) # 输出: Second value

print(next(gen)) # 输出: Third value

```

### 2.1.2 itertools生成器的优势

itertools库中的生成器具有多个优势:

1. **内存效率高**:由于生成器一次只产生一个值,它们对于处理大量数据流非常高效,不需要将所有数据加载到内存中。

2. **延迟计算**:只有当值真正需要时才进行计算,这与传统的列表不同,列表在创建时就需要计算并存储所有元素。

3. **无限序列的处理**:生成器可以轻松创建无限序列,这对于分析周期性或递归模式特别有用。

## 2.2 itertools的数据管道与组合模式

### 2.2.1 数据管道的构建与应用

数据管道(Data Pipeline)是将一系列的数据处理步骤链接起来的一种模式,每个步骤都是数据流动的一个阶段,最终形成数据处理的流水线。itertools中的一些函数可以用来构建这种数据管道,比如`chain`和`tee`。

```python

import itertools

# 示例数据

a = [1, 2, 3]

b = ['a', 'b', 'c']

# 使用itertools.chain将两个列表串联成一个迭代器

data_pipe = itertools.chain(a, b)

for item in data_pipe:

print(item)

```

输出:

```

1

2

3

a

b

c

```

在构建数据管道时,itertools提供了丰富的工具来连接不同的迭代器,过滤、映射数据,这对于复杂的数据处理流程来说是一个强大的能力。

### 2.2.2 组合模式的深入解析

组合模式(Combinatorics)是itertools库中的强大功能之一,它允许开发者轻松创建元素的所有可能组合和排列。这在需要从数据集中生成候选集进行测试或分析时非常有用。

```python

# 组合所有可能的两元素组合

combinations = ***binations(a, 2)

for comb in combinations:

print(comb)

```

输出:

```

(1, 2)

(1, 3)

(2, 3)

```

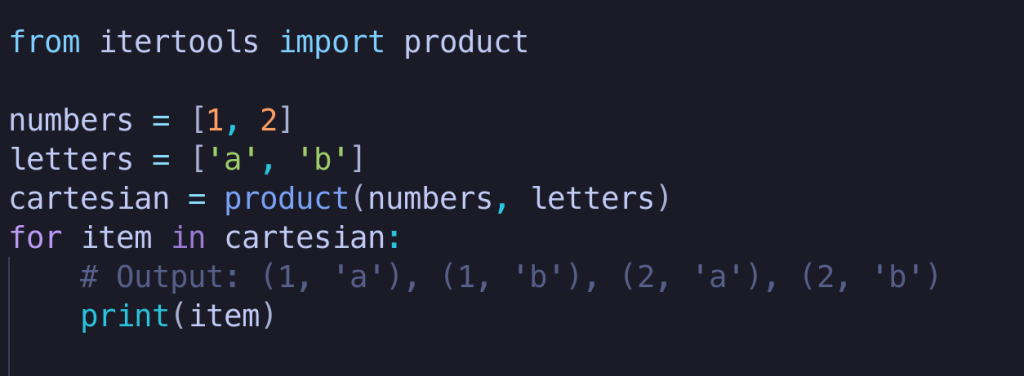

组合模式的函数,如`combinations`、`permutations`和`product`,可以用于生成固定长度的组合、排列和笛卡尔积,这在数据处理和机器学习中特别有用。

## 2.3 Python内存管理基础

### 2.3.1 Python的内存模型

Python的内存模型包括几个关键概念:对象、引用和垃圾回收。Python使用引用计数机制来跟踪对象的使用情况,并通过垃圾回收器周期性地清理不再使用的对象。理解Python的内存管理对于优化数据处理和内存效率至关重要。

### 2.3.2 内存管理的优化技巧

在大数据场景下,合理的内存管理可以显著提升程序性能。以下是一些常见的内存管理优化技巧:

1. **避免全局变量**:尽量减少全局变量的使用,因为它们会长期保持在内存中。

2. **使用生成器**:在可以的情况下使用生成器替代列表,减少内存使用。

3. **逐行处理数据**:对于大文件或数据流,尽量逐行读取处理而不是一次性载入内存。

4. **优化数据结构**:合理选择数据结构可以减少内存的使用,例如,使用集合(set)来去重或查找数据。

5. **及时清理资源**:用`del`语句删除不再使用的对象引用,并确保文件等资源被正确关闭。

```python

# 使用生成器逐行读取文件

def read_file(file_path):

with open(file_path, 'r') as ***

***

***

* 使用生成器逐行处理

for line in read_file('data.txt'):

process(line)

```

在处理大数据时,合理运用这些技巧,可以有效地减少内存压力并提高程序的运行效率。接下来,我们将深入探讨itertools在大数据场景下的实践应用。

# 3. itertools在大数据场景下的实践应用

随着数据量的不断增长,传统的数据处理方式已无法满足日益复杂的需求。itertools作为一个强大的迭代器生成库,在处理大规模数据集时提供了一种内存效率高、代码简洁的解决方案。本章将深入探讨itertools在大数据场景下的具体应用,以及如何在实践中优化数据处理流程以提高内存利用率。

## 3.1 利用itertools进行高效数据迭代

itertools库中的函数可以被看作是“无限”迭代器,这意味着它们可以产生出任意数量的数据,而无需一次性加载整个数据集到内存中。这为大数据处理提供了一种高效的方式。

### 3.1.1 数据迭代的优势与场景

数据迭代的优势在于:

- **内存效率**:迭代器只在需要时才计算下一个元素,从而降低了内存使用。

- **延迟计算**:数据仅在需要时才被生成,允许我们处理无法一次性装入内存的大型数据集。

- **函数组合**:itertools提供了大量组合函数,可以轻松构建复杂的数据处理管道。

常见的使用场景包括:

- 流式数据处理,如日志文件分析。

- 高级数据生成,如随机数据集的创建。

- 在数据转换、筛选、映射等操作中。

### 3.1.2 实际案例分析

假设我们有一个大型CSV文件,其中包含数百万条用户交易记录。我们要对这些数据进行处理,以找到总交易额最高的用户。使用itertools库,我们可以按以下步骤进行操作:

```python

import csv

from itertools import islice

# 创建一个生成器函数来逐行读取CSV文件

def csv_reader(filename):

with open(filename, 'r') as ***

***

***

***

* 使用itertools.islice来只处理前1000条记录

first_1000 = islice(csv_reader('transactions.csv'), 1000)

# 迭代这1000条记录并累加每个用户的交易总额

user_totals = {}

for record in first_1000:

user_totals[recor

```

0

0