itertools高阶技巧:打造高效数据处理的函数式编程艺术

发布时间: 2024-10-08 21:34:21 阅读量: 24 订阅数: 22

# 1. itertools模块概述与数据流基础

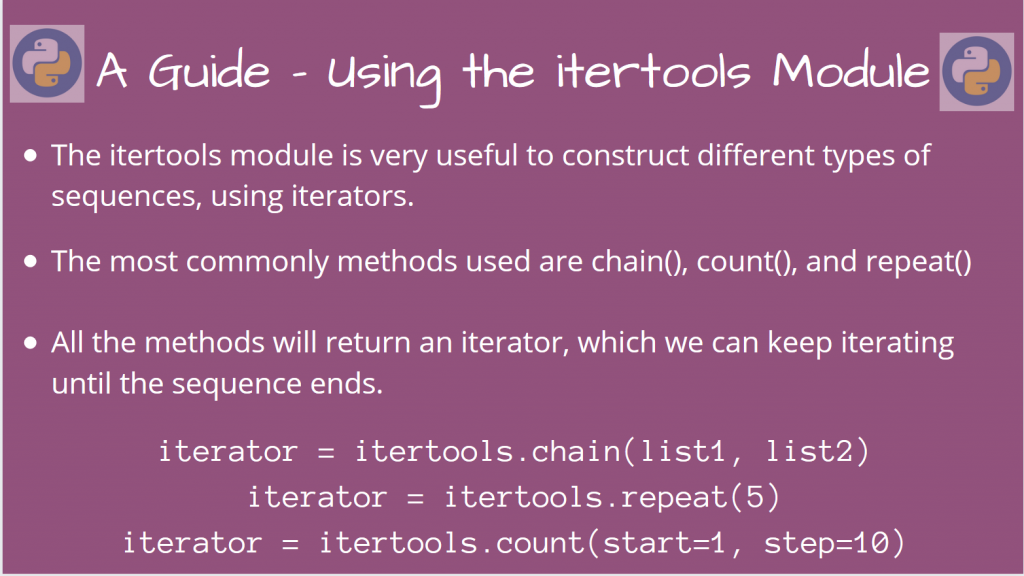

在当今的软件开发领域中,高效的处理数据流是许多应用的核心。Python的`itertools`模块是解决这一需求的得力工具,它提供了一系列用于创建和使用迭代器的函数,能够帮助开发者高效地进行数据处理与分析。

## 1.1 itertools的用途和重要性

`itertools`模块中包含了用于创建复杂迭代器的工具,这些迭代器在处理数据时既节省内存又能提高效率。无论是在数据分析、科学计算还是在日常的编程工作中,`itertools`都能发挥巨大作用。

## 1.2 迭代器和生成器

在深入理解`itertools`之前,需要先掌握迭代器和生成器的概念。迭代器是一种对象,它允许我们遍历容器,如列表或字典中的每一个元素,而不需要把所有元素加载到内存中。生成器是迭代器的一种特殊形式,可以通过简单的函数来实现惰性求值。

```python

# 示例:生成器表达式

numbers = (x*x for x in range(10))

for num in numbers:

print(num)

```

以上代码创建了一个生成器,用于生成前10个整数的平方,并逐个输出,这正是惰性求值的一个典型案例。

## 1.3 数据流的基本概念

数据流是连续的数据序列,通常用于实时分析或流式处理。理解数据流的基本概念对于有效地使用`itertools`至关重要。`itertools`提供了一系列工具来构建、转换和消费这些数据流。

## 1.4 itertool模块的优势

`itertools`最大的优势在于其对内存的高效使用和代码的简洁性。它使得处理大型数据集成为可能,同时又不会给系统带来沉重的负担。此外,`itertools`的函数往往是高度优化的,这为开发者提供了在性能上可信赖的代码库。

在接下来的章节中,我们将深入探讨`itertools`的高级迭代功能,以及如何在实际的数据处理任务中应用这些功能。

# 2. itertools的高级迭代功能

### 2.1 理解生成器和迭代器

生成器(Generators)和迭代器(Iterators)是Python中处理数据流的核心概念。理解这两者的区别和联系,对于深入掌握itertools模块至关重要。

#### 2.1.1 生成器的工作原理

生成器是Python中的一个特殊类型,它允许我们按需生成一系列值,而不是一次性将它们全部计算出来。生成器函数使用`yield`关键字返回值,而不是返回一个完整的列表。

```python

def count_to_three():

yield 1

yield 2

yield 3

counter = count_to_three()

print(next(counter)) # 输出: 1

print(next(counter)) # 输出: 2

print(next(counter)) # 输出: 3

```

在这个例子中,`count_to_three`是一个生成器函数。每次调用`next(counter)`时,生成器继续执行,直到遇到下一个`yield`语句,然后返回一个值。

#### 2.1.2 迭代器协议及应用

迭代器协议是Python中的一种设计模式,它规定了对象在进行迭代时所遵循的接口。任何实现了`__iter__()`和`__next__()`方法的对象都可以成为迭代器。

```python

class RangeIterator:

def __init__(self, start, stop):

self.current = start

self.stop = stop

def __iter__(self):

return self

def __next__(self):

if self.current < self.stop:

value = self.current

self.current += 1

return value

else:

raise StopIteration

range_iter = RangeIterator(1, 4)

for num in range_iter:

print(num)

```

在上述代码中,`RangeIterator`类实现了迭代器协议。调用`__iter__()`返回迭代器对象本身,而`__next__()`方法返回序列中的下一个值,当没有更多元素时抛出`StopIteration`异常。

### 2.2 itertools的组合生成工具

itertools模块提供了多种用于创建复杂迭代器序列的工具。这些工具可以用于生成排列、组合以及笛卡尔积等。

#### 2.2.1 产品、排列与组合

`itertools.product`、`itertools.permutations`和`***binations`是itertools中最常用的组合生成工具。它们可以轻松地从输入的数据集中生成笛卡尔积、排列和组合。

```python

import itertools

# 笛卡尔积

a = [1, 2]

b = [3, 4]

prod = itertools.product(a, b)

print(list(prod)) # 输出: [(1, 3), (1, 4), (2, 3), (2, 4)]

# 排列

perms = itertools.permutations(a)

print(list(perms)) # 输出: [(1, 2), (2, 1)]

# 组合

combs = ***binations(a, 2)

print(list(combs)) # 输出: [(1, 2)]

```

在上述代码中,`product`函数生成了所有可能的元素对,`permutations`生成了a中元素的所有可能排列,而`combinations`生成了a中元素的所有可能组合。

#### 2.2.2 组合生成器的高级用法

这些工具的组合使用可以产生更为复杂的数据结构。例如,使用`product`生成笛卡尔积,再通过`filter`筛选出符合特定条件的元素对。

```python

# 笛卡尔积的高级用法

a = [1, 2, 3]

b = [3, 4]

prod = itertools.product(a, b)

filtered_prod = filter(lambda pair: sum(pair) % 2 == 0, prod)

print(list(filtered_prod)) # 输出: [(1, 3), (2, 4), (3, 3)]

```

在这个例子中,`filter`函数根据lambda表达式中的条件来筛选元素对。这样的组合使得我们能够快速得到符合特定规则的数据对。

### 2.3 断言函数与条件迭代

itertools中还有一些特殊的函数用于基于特定条件进行迭代。这些函数使得数据流的处理更加灵活和高效。

#### 2.3.1 islice和tee的使用技巧

`itertools.islice`和`itertools.tee`是两个常用的断言函数。`islice`允许从迭代器中按需切片数据,而`tee`则用于复制迭代器。

```python

from itertools import islice, tee

counter = count_to_three()

# 使用islice获取前两个元素

first_two = islice(counter, 2)

print(list(first_two)) # 输出: [1, 2]

# 使用tee复制迭代器

counter_copy, counter_copy2 = tee(counter)

print(list(counter_copy)) # 输出: [1, 2, 3]

print(list(counter_copy2)) # 输出: [1, 2, 3]

```

`islice`让我们能够像访问列表切片一样访问迭代器的部分数据,而`tee`则允许我们创建迭代器的副本,这对于多线程处理数据流尤其有用。

#### 2.3.2 filterfalse与takewhile的深入探讨

`itertools.filterfalse`和`itertools.takewhile`是两个用于条件迭代的函数。`filterfalse`返回迭代器中不符合条件的元素,而`takewhile`返回在给定条件为真时的元素序列。

```python

from itertools import filterfalse, takewhile

# 使用filterfalse获取所有偶数

even_numbers = filterfalse(lambda x: x % 2 != 0, [1, 2, 3, 4])

print(list(even_numbers)) # 输出: [2, 4]

# 使用takewhile在数字小于3时获取元素

take_while = takewhile(lambda x: x < 3, [1, 2, 3, 4])

print(list(take_while)) # 输出: [1, 2]

```

这两个函数在数据分析中非常有用,特别是在需要基于特定条件提取或排除数据流中的元素时。

通过本章节的介绍,我们可以看到,itertools模块中的高级迭代功能大大增强了Python在数据处理方面的灵活性和效率。无论是基本的生成器和迭代器的概念,还是组合生成器工具和条件迭代函数,都有助于构建高效且优雅的数据处理流程。在下一章中,我们将进一步探索itertools在实际数据处理中的应用实例,包括数据清洗、复杂数据结构的扁平化处理,以及性能优化方面的技巧。

# 3. itertools在数据处理中的应用实例

数据处理是编程和软件开发中的一个核心环节,尤其是在需要处理复杂数据结构和大型数据集时。itertools模块提供了一组用于创建和使用迭代器的工具,它们特别适合于处理和操作数据流,使数据处理变得更加高效和优雅。接下来,我们将深入探讨itertools在实际数据处理中的应用实例,包括数据清洗与转换、复杂数据结构的扁平化处理,以及性能优化。

## 3.1 数据清洗与转换

在数据处理流程中,数据清洗与转换通常是第一步。数据清洗是指移除数据中的无关项、纠正错误、处理缺失值等。而数据转换则是将数据从一种形式转换为另一种形式,以满足后续处理的需求。itertools在这一过程中可以发挥巨大作用,特别是通过chain和cycle这类工具来处理循环数据,以及通过groupby和starmap组合来应用更复杂的转换逻辑。

### 3.1.1 使用chain和cycle处理循环数据

在处理循环数据结构时,chain可以将多个迭代器连接成一个连续的迭代器,这样就可以在一个循环中处理多个序列。而cycle则可以无限循环一个迭代器的内容,这对于需要重复处理数据的情况非常有用。

假设我们有多个数据序列,需要在一个循环中处理完所有数据,我们可以这样做:

```python

import itertools as it

# 假设我们有四个列表,需要在一个循环中处理完

list1 = [1, 2, 3]

list2 = [4, 5, 6]

list3 = [7, 8, 9]

list4 = [10, 11, 12]

# 使用itertools.chain将列表连接成一个迭代器

combined = it.chain(list1, list2, list3, list4)

# 在循环中处理所有数据

for item in combined:

print(item)

```

输出结果将是这些列表中所有元素的连续输出。

### 3.1.2 groupby与starmap的组合应用

groupby工具可以将数据根据提供的键函数进行分组,而starmap则可以将函数应用于一系列参数元组。这种组合在对数据进行分组并应用转换时非常有用。

假定我们有一个用户数据列表,其中包含用户信息的元组,我们希望根据用户的年龄进行分组,并计算每组用户的平均收入:

```python

import itertools as it

from operator import itemgetter

# 假设我们有用户数据元组,每个元组包含姓名、年龄和收入

users = [('Alice', 25, 30000), ('Bob', 30, 45000), ('Charlie', 25, 40000)]

# 使用itemgetter来获取年龄作为键,starmap来应用函数计算平均值

grouped_users = it.groupby(users, key=itemgetter(1))

for age_group, data in grouped_users:

print(f"Age group: {age_group}, Average income: {sum(x[2] for x in data)/len(list(data))}")

```

这将输出按年龄分组的用户平均收入。

## 3.2 复杂数据结构的扁平化处理

在处理复杂的数据结构时,如嵌套列表或字典,扁平化处理通常是一个重要步骤。扁平化是指将多层嵌套的数据结构转换成一个线性序列。这在数据分析、机器学习预处理等场景中十分常见。itertools提供了一些强大的工具,可以帮助开发者实现这一目标。

### 3.2.1 实现多层嵌套数据的扁平化

为了扁平化处理复杂的嵌套数据结构,我们可以编写一个递归函数,借助itertools的工具来简化任务。

```python

import itertools

# 递归函数,用于扁平化任意深度的嵌套列表

def flatten(nested_iterable):

for element in nested_iterable:

if isinstance(element, (list, tuple)):

# 如果元素是列表或元组,递归地扁平化它

yield from flatten(element)

else:

# 否则,直接产生元素

yield element

# 示例嵌套数据

nested_data = [1, [2, [3, 4], 5], 6, [7, 8]]

# 扁平化处理

flattened_data = list(flatten(nested_data))

print(flattened_data)

```

这段代码将输出扁平化后的数据列表。

### 3.2.2 解决循环引用的扁平化策略

循环引用可能会导致无限递归错误,从而使得扁平化过程失败。解决这一问题,我们可以记录已经访问过的对象,以避免重复的扁平化尝试。

```python

def flatten_unique(nested_iterable, seen=None):

if seen is None:

seen = set()

seen.add(nested_iterable)

for element in nested_iterable:

if isinstance(element, (list, tuple)) and id(element) not in seen:

# 递归地扁平化未见过的对象

yield from flatten_unique(element, seen)

elif element not in seen:

# 如果元素是非列表、非元组且未见过,则产生元素

yield element

seen.add(element)

# 示例循环嵌套数据

circular_data = [1, 2, [3, 4]]

circular_data.append(circular_data)

# 扁平化处理,避免循环引用导致的无限递归

flattened_unique_data = list(flatten_unique(circular_data))

print(flattened_unique_data)

```

这段代码将安全地输出一个扁平化列表,而不涉及循环引用导致的重复。

## 3.3 增强数据处理的性能优化

性能优化是任何数据处理工作的重要组成部分。在处理大规模数据集时,内存管理和算法效率尤为关键。itertools通过生成器提供了惰性计算的能力,这有助于减少内存占用并提高处理速度。我们将通过内存管理和生成器表达式的使用,来探讨itertools在提升数据处理效率方面的应用。

### 3.3.1 内存管理与生成器表达式

内存管理是优化数据处理性能的关键。使用itertools创建的生成器允许我们逐个处理数据项,而不是一次性将整个数据集加载到内存中。

```python

# 使用生成器表达式替代列表推导式来处理数据

data = range(1000000) # 假设这是大规模数据集

# 列表推导式会消耗大量内存

# data_list = [item for item in data if item % 2 == 0]

# 生成器表达式,只在需要时计算每个数据项

data_gen = (item for item in data if item % 2 == 0)

# 逐个处理数据项

for item in data_gen:

# 执行数据处理任务

pass

```

### 3.3.2 利用itertools提升处理效率的案例研究

在实际应用中,可以利用itertools组合各种工具,以实现高效的流处理。比如,在数据分析工作中,我们可能需要对数据进行多步骤的转换和过滤。

```python

import itertools

# 假设我们有一个包含大量数据的文件

with open('large_data.csv', 'r') as ***

* 使用csv模块读取数据

reader = csv.reader(file)

# 使用itertools的工具链处理数据

processed_data = (

itertools.chain.from_iterable(row)

for row in reader

if row # 过滤空行

if not row.startswith('#') # 过滤注释行

)

# 在这里可以进一步应用其他转换逻辑

# 执行后续处理任务

for item in processed_data:

# 执行数据处理任务

pass

```

这段代码展示了如何使用itertools的chain.from_iterable来处理CSV文件中的行,并进行了简单的过滤操作。这样的处理链在处理大规模数据集时既节省内存又提高了效率。

# 4. ```

# 第四章:itertools与函数式编程的结合

## 4.1 函数式编程基础与itertools的协同

### 4.1.1 了解高阶函数与纯函数

函数式编程(Functional Programming)是一种编程范式,它将计算视为数学函数的评估,强调使用无副作用的纯函数和高阶函数来构建程序。在函数式编程中,一个高阶函数是指可以接受其他函数作为参数或将它们作为结果返回的函数。

**纯函数**是指在相同的输入下总是产生相同输出的函数,并且在执行过程中不产生副作用,如修改全局变量或进行I/O操作。它们是函数式编程的基石,因为它们极大地简化了程序的推理和测试。

itertools模块中的很多函数都可以被视为高阶函数,因为它们接受函数作为参数或返回函数。例如,`map()`和`filter()`都是接受函数和其他可迭代对象,应用函数到每个元素上,并返回一个迭代器。

### 4.1.2 itertools中的高阶函数应用

itertools中的`accumulate()`函数是一个很好的例子,它展示了高阶函数的应用。`accumulate()`函数接受一个可迭代对象和一个二元操作函数,然后返回一个迭代器,该迭代器产生累积的值。

```python

import itertools

numbers = [1, 2, 3, 4, 5]

sums = itertools.accumulate(numbers, lambda x, y: x + y)

print(list(sums)) # 输出: [1, 3, 6, 10, 15]

```

在这个例子中,`accumulate()`将函数`lambda x, y: x + y`应用于`numbers`列表的元素,生成从第一个元素开始的累积和。

itertools中的其他高阶函数包括`starmap()`,它可以将一个函数应用于输入列表中的元组的元素;`map()`在Python 3中返回一个迭代器,而不是在Python 2中的列表;`zip_longest()`函数可以接受多个可迭代对象,并用指定的值填充较短的输入。

```python

pairs = [(1, 'a'), (2, 'b'), (3, 'c')]

product = itertools.starmap(lambda x, y: x*y, pairs)

print(list(product)) # 输出: [1, 4, 9]

```

在这个例子中,`starmap()`将匿名函数`lambda x, y: x*y`应用于`pairs`列表中的每个元组,从而生成每个元组中第一个和第二个元素的乘积。

## 4.2 惰性求值与迭代器链

### 4.2.1 惰性求值的概念及其优势

惰性求值(Lazy evaluation),是指只有在需要时才计算表达式值的计算方式。与之相对的是及早求值(Eager evaluation),即一旦输入一个表达式就立即计算其值。

惰性求值的优势在于它能够提高程序的效率,特别是处理大量数据时,不需要一次性将所有数据加载到内存中,而是一次只处理一小部分数据。Python中的迭代器就是惰性求值的一个例子。

itertools模块中的迭代器正是惰性求值的典型应用。例如,使用`count()`函数可以创建一个无限的序列,但实际上它不会立即生成所有数字,而是在迭代过程中才生成。

```python

import itertools

count = itertools.count(1)

print(next(count)) # 输出: 1

print(next(count)) # 输出: 2

```

### 4.2.2 迭代器链的设计模式与最佳实践

迭代器链是一种常见的设计模式,它涉及将多个迭代器串联起来,每个迭代器处理一部分数据,并将结果传递给下一个迭代器。这种方式可以实现复杂的数据处理流程,而不需要创建中间数据结构。

itertools提供了许多工具函数,可以用来创建和组合迭代器链。`chain()`, `chain.from_iterable()`, `islice()`, `tee()` 等都是构建迭代器链的有用工具。

```python

import itertools

# 创建一个迭代器链

numbers = [1, 2, 3, 4, 5]

letters = ['a', 'b', 'c', 'd', 'e']

combined = itertools.chain(numbers, letters)

print(list(combined)) # 输出: [1, 2, 3, 4, 5, 'a', 'b', 'c', 'd', 'e']

```

在这个例子中,`chain()`函数将`numbers`和`letters`两个列表连接起来,形成一个新的迭代器。

最佳实践是在创建迭代器链时尽量减少中间结果的生成,以节省内存。同时,要确保迭代器链的每个环节都能够有效处理数据,避免出现性能瓶颈。

## 4.3 编写自定义的itertools工具

### 4.3.1 创建满足特定需求的迭代器

有时候,标准的itertools工具并不能完全满足特定的需求。在这种情况下,我们可以自己编写函数来生成满足特定需求的迭代器。自定义迭代器的关键是理解如何使用生成器,这是Python中实现迭代器的一种简洁方式。

```python

def custom_count(start=0, step=1):

value = start

while True:

yield value

value += step

counter = custom_count(start=2, step=2)

print(next(counter)) # 输出: 2

print(next(counter)) # 输出: 4

print(next(counter)) # 输出: 6

```

在这个例子中,`custom_count`函数是一个简单的自定义迭代器,它模拟了`itertools.count()`的行为。这个函数使用一个无限循环来生成一个序列,并且可以通过`start`和`step`参数来控制序列的起始值和步长。

### 4.3.2 自定义工具的性能考量与测试

在开发自定义迭代器时,性能是一个重要的考量因素。生成器是一种懒惰求值的机制,它允许我们在需要时才计算下一个值,从而可以处理潜在的无限序列,而不会占用大量内存。

性能测试可以帮助我们了解迭代器的行为和效率,尤其是在数据量大时的表现。我们可以使用Python标准库中的`timeit`模块来进行性能测试。

```python

import timeit

# 测试自定义迭代器的性能

def performance_test():

setup = "counter = custom_count(start=0, step=1)"

test = "next(counter)"

number = 1000000

time = timeit.timeit(setup=setup, stmt=test, number=number)

print(f"执行 {number} 次操作需要 {time} 秒")

performance_test()

```

在这个性能测试示例中,我们使用了`custom_count()`函数来测试生成器的性能。通过改变`number`参数的值,我们可以测试在不同的迭代次数下,执行操作需要多长时间。这个测试对于评估自定义迭代器在大规模数据处理中的性能非常有用。

自定义工具应该考虑到内存使用效率和执行速度,特别是在需要处理大型数据集或实时数据流时。通过精心设计和严格的测试,我们可以确保自定义工具能够高效地满足我们的数据处理需求。

```

# 5. itertools进阶技巧与最佳实践

## 5.1 复杂数据流的构建与管理

itertools 模块不仅能够处理简单的数据流,而且在构建复杂数据流时也能发挥强大的作用。构建高效的流处理管道是数据分析和处理的重要环节,itertools 提供了一系列工具,让我们可以以链式调用的方式组合处理步骤,增强程序的可读性和效率。

### 5.1.1 构建高效的流处理管道

流处理管道通常由多个处理环节组成,每个环节可能包括数据的筛选、转换、合并或分割等操作。使用itertools的组合生成工具,如 `chain`, `product`, 和 `groupby` 等,我们可以高效地构建这样的数据处理管道。

```python

import itertools

# 创建一个数据流处理管道示例

data_stream = itertools.chain(

itertools.product(range(10), repeat=2), # 生成一个笛卡尔积流

itertools.filterfalse(lambda x: sum(x) % 2 == 0, data_stream) # 筛选出奇数和

)

for item in data_stream:

print(item)

```

在上述代码中,`chain`函数用于将多个流连接在一起,而`product`用于生成笛卡尔积,`filterfalse`用于筛选满足特定条件的元素。这种链式组合大大简化了代码,同时提升了处理的效率。

### 5.1.2 处理大规模数据集的策略

当处理大规模数据集时,内存管理和性能优化成为关键问题。itertools 提供了多种优化策略,如生成器表达式和分块读取技术(如`islice`),可以有效地处理大规模数据集,避免一次性将数据加载到内存中。

```python

# 分块读取数据集示例

def read_data块size=100):

with open('large_dataset.txt', 'r') as ***

*** 块size):

yield file.read(块size)

# 使用islice处理大文件

for chunk in itertools.islice(read_data块size=100), 0, 1000):

process_data(chunk)

```

在上述示例中,我们定义了一个生成器函数`read_data`,它分块地读取一个大型文件,并且`islice`用于进一步控制处理数据块的范围,有效管理内存使用。

## 5.2 itertool在并发编程中的角色

随着并发编程在现代软件开发中的重要性不断提升,itertools 也逐步在并发场景下展现了其潜力,尤其是在迭代器链的设计中。

### 5.2.1 分布式迭代器的实现思路

分布式计算通常涉及在多个节点间分配数据处理任务。itertools 模块虽然本身不是为并发设计,但其设计思想可以被借鉴。通过构建一个迭代器链,可以将数据流分解成多个子流,每个子流由一个独立的计算节点处理。

```python

# 示例:分解数据流以进行分布式处理

def distribute_data流, num_workers):

subflows = itertools.islice(数据流, num_workers)

workers = []

for subflow in subflows:

worker = threading.Thread(target=process_subflow, args=(subflow,))

workers.append(worker)

worker.start()

for worker in workers:

worker.join()

# 假设我们有一个需要处理的大型数据流

large_data_stream = itertools.count(start=1, step=1)

distribute_data流(large_data_stream, num_workers=4)

```

在这个例子中,我们通过`islice`将一个大的数据流分解成多个子流,并为每个子流分配一个线程进行处理。

### 5.2.2 高性能并行计算的案例分析

为了进一步说明itertools在高性能并行计算中的应用,我们可以举一个实际的例子,该例子中使用了`multiprocessing`模块与itertools的组合,来实现数据的并行处理。

```python

import itertools

import multiprocessing

def parallel_process流, worker_func):

pool = multiprocessing.Pool(processes=multiprocessing.cpu_count())

return pool.imap_unordered(worker_func, 流)

data_stream = itertools.count(start=1, step=1)

results = parallel_process(data_stream, worker_func)

for result in results:

print(result)

```

在这个案例中,我们使用`Pool`对象的`imap_unordered`方法来并行地处理数据流。`imap_unordered`方法接受一个函数和一个数据流,并返回一个迭代器,该迭代器以任意顺序产生函数应用于数据流中每个元素的结果。

## 5.3 探索itertools的未来发展方向

itertools 模块本身自Python 2.3版本以来就一直在不断地演进。随着Python的持续发展,itertools 也在扩展其功能以满足新的需求。未来的发展方向将结合Python的新特性和社区的创新用法,为数据处理领域带来新的可能性。

### 5.3.1 与Python新特性结合的潜力

随着Python的持续更新,新的语言特性和库被引入。itertools可与这些新特性结合起来,提升数据处理的效率和灵活性。

### 5.3.2 社区驱动的创新用法展望

在社区的推动下,itertools 模块的创新用法也在不断涌现。社区开发者在数据处理、科学计算和机器学习等领域中不断探索itertools的新应用,为这个模块带来了无限的潜力。

在本文的第五章,我们深入探讨了itertools的进阶技巧与最佳实践,包括构建高效的数据流处理管道、处理大规模数据集的策略,以及itertools在并发编程中的角色。通过案例分析和代码演示,我们展示了itertools在处理复杂数据流中的强大功能,以及它与并发编程的结合潜力。同时,我们也展望了itertools在未来的发展方向,包括与Python新特性结合的潜力以及社区驱动的创新用法。

0

0