itertools与文件处理:流式读写与数据转换的高效技巧

发布时间: 2024-10-08 22:30:00 阅读量: 23 订阅数: 27

java计算器源码.zip

# 1. itertools与文件处理概述

在处理大量数据时,尤其是在文件处理场景中,传统的数据处理方法可能面临性能瓶颈。Python的`itertools`模块提供了迭代器构建块,能够以一种高效且内存友好的方式处理序列数据。本章节将介绍`itertools`的基本概念,并探讨其在文件处理中的应用场景。我们将概述`itertools`如何使文件读取更高效、数据处理更灵活,以及在输出文件时如何创建生成器模式来节省资源。通过本章的介绍,读者将对`itertools`在文件处理中的潜力有初步的认识,并为深入学习`itertools`模块打下坚实的基础。

# 2. itertools的核心原理与应用

### 2.1 itertools模块的组成和功能

#### 2.1.1 itertools模块的导入与初步使用

itertools模块是Python标准库中的一个用于创建和处理迭代器的工具包,特别适合处理有限或无限数据序列。利用itertools模块,可以有效地进行数据的组合、分割、过滤、映射等操作,而不需要存储整个数据集在内存中。

导入itertools模块很简单,只需要在Python脚本顶部添加一句:

```python

import itertools

```

初步使用itertools,可以利用模块中的几个基本函数来创建迭代器。举个例子,使用`count`函数创建一个从1开始的无限数字序列:

```python

for i in itertools.count(1):

print(i)

if i > 10: # 假设我们只打印前10个数字

break

```

上述代码会输出1到10的数字。`count`函数实际上创建了一个无限迭代器,但是这里使用了`break`语句来结束循环。

#### 2.1.2 itertools内建函数的分类和作用

itertools模块提供众多内建函数,根据其功能可以大致分为以下几类:

- 无限迭代器

- `count(start=0, step=1)`: 创建一个从`start`开始的整数序列。

- `cycle(iterable)`: 循环遍历一个序列。

- `repeat(object, times=None)`: 无限重复一个值。

- 组合和重复

- `accumulate(iterable[, func, *, initial=None])`: 通过函数累积值。

- `chain(*iterables)`: 创建一个迭代器,将多个迭代器连在一起。

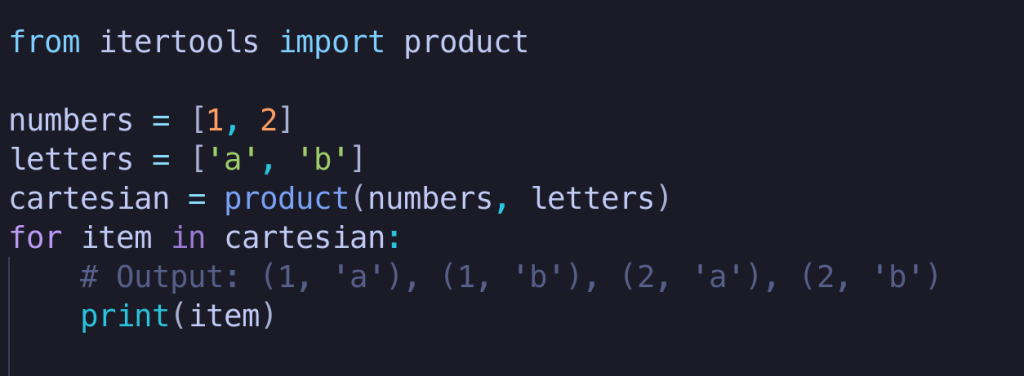

- `product(*iterables, repeat=1)`: 笛卡尔积。

- 分割、筛选和映射

- `filterfalse(predicate, iterable)`: 过滤不符合条件的元素。

- `takewhile(predicate, iterable)`: 只要条件为真,就获取元素。

- `starmap(function, iterable)`: 创建一个迭代器,应用函数到参数列表。

这些内建函数背后都实现了一套高效的数据处理逻辑。通常,这些函数返回的是迭代器对象,不会立即计算出所有元素,而是按需生成。这对于处理大量数据尤其有用,因为它可以大幅降低内存使用。

### 2.2 itertools在文件读写中的应用

#### 2.2.1 利用itertools进行高效文件读取

对于文件处理,itertools可以帮助我们实现高效的数据读取。举个例子,当我们想要处理一个大型的日志文件,但又不希望一次性将整个文件内容加载到内存中时,可以使用`itertools.islice`来实现按块读取数据。

```python

from itertools import islice

# 打开文件并创建一个迭代器

with open('large_file.log', 'r') as ***

* 按块读取每100行

lines = islice(file, 0, None, 100)

for chunk in lines:

print(chunk)

```

#### 2.2.2 文件数据处理:过滤和映射技巧

itertools的组合函数允许在读取文件的同时对数据进行过滤和映射。假设我们需要处理一个文本文件,只保留长度大于10的单词,可以使用`filterfalse`和`starmap`:

```python

from itertools import filterfalse, starmap

import operator

# 定义过滤器函数,保留长度大于10的单词

long_words = filterfalse(lambda x: len(x) <= 10, words)

# 使用starmap应用join函数来连接单词

sentences = starmap(operator.methodcaller('join', ' '), long_words)

# 输出处理后的句子

for sentence in sentences:

print(sentence)

```

#### 2.2.3 文件输出:创建生成器模式

在文件输出方面,我们可以使用itertools的组合函数来创建一个生成器模式,从而允许我们在输出文件时进行复杂的数据处理。以写入排序后的数据为例:

```python

from itertools import groupby

# 假设有一个未排序的数据列表

data = [1, 5, 2, 6, 4, 9, 3]

# 使用groupby函数对数据进行排序,并输出到文件

with open('output.txt', 'w') as ***

***

***

***'{item}\n')

```

### 2.3 itertools与数据流的控制

#### 2.3.1 数据流的创建和管理

itertools提供了强大的工具来创建和管理数据流。例如,使用`chain`函数可以将多个数据源链接起来,而`zip_longest`可以处理不等长的数据流:

```python

from itertools import chain, zip_longest

# 将多个列表链接在一起

combined_lists = chain([1, 2, 3], [4, 5, 6])

for item in combined_lists:

print(item)

# 使用zip_longest处理不等长的列表

data_a = [1, 2, 3]

data_b = [4, 5]

for a, b in zip_longest(data_a, data_b, fillvalue=None):

print(a, b)

```

#### 2.3.2 数据流的合并、分解与重组

itertools能够合并多个数据流,并允许我们按需进行分解或重组。这在处理复杂数据结构时特别有用。例如,使用`tee`函数复制迭代器:

```python

from itertools import tee

# 创建一个迭代器

iterator = iter(range(3))

# 复制迭代器以实现并行处理

dup1, dup2 = tee(iterator)

# 使用复制的迭代器

for item in dup1:

print(f'First iterator: {item}')

for item in dup2:

print(f'Second iterator: {item}')

```

#### 2.3.3 实践案例:复杂数据处理流程

在实际应用中,我们可能会遇到需要对复杂的数据流进行多种处理的情况。假设我们需要从一个大型CSV文件中读取数据,过滤掉不需要的列,并对数据进行分组和汇总:

```python

from itertools import groupby

import csv

# 读取CSV文件并按特定列进行分组汇总

with open('large_data.csv', newline='') as csv***

***

* 根据某列值进行分组

for key, group in groupby(reader, key=lambda x: x['column']):

print(f'Group: {key}')

# 对每个组内的数据进行汇总操作

for record in group:

print(record)

```

通过使用itertools的组合函数,我们可以轻松地将数据读取、处理和输出整合到一个流式处理流程中,有效管理数据流的同时,还能保持代码的简洁性和高效性。

# 3. 文件处理的流式读写技巧

在处理大规模文件时,传统的方法往往会导致内存的大量消耗,尤其对于IT行业从业者来说,当面临超大数据量文件的读写时,如何实现高效的资源利用和快速的处理速度就显得尤为重要。流式读写技巧正是为了解决这类问题而产生的。本章节将深入探讨流式读取和写入文件内容的技巧,以及文件内容转换和处理的方法。

## 3.1 流式读取文件内容

### 3.1.1 按行读取与按块读取的差异

在处理大型文件时,按行读取和按块读取是两种常用的方式。按行读取是逐行读取文件,这种方式适用于文本文件,尤其是日志文件。Python中的`open()`函数配合`readline()`方法即可实现按行读取。然而,这种方式在面对大文件时,由于逐行加载可能会导致性能瓶颈。

```python

# 按行读取文件示例代码

with open('largefile.txt', 'r') as ***

***

*** 处理每一行数据

```

按块读取则是在读取文件时,一次性读取固定大小的数据块。这种方法可以有效减少I/O操作的次数,提高效率,特别是在网络传输和大文件处理中表现出色。通过调整块的大小,可以平衡内存使用和读取速度。

```python

# 按块读取文件示例代码

def read_in_chunks(file_object, chunk_size=1024):

"""从文件对象中按块读取数据"""

while True:

data = file_object.read(chunk_size

```

0

0