【Python中的itertools秘籍】:解锁生成器与迭代器的终极力量

发布时间: 2024-10-08 21:30:59 阅读量: 38 订阅数: 29

详解Python的迭代器、生成器以及相关的itertools包

# 1. 生成器与迭代器基础

## 1.1 生成器的基本概念

在Python编程语言中,生成器是一种高效的内存管理工具,用于在迭代过程中产生一系列的值。它们是函数的一种特殊类型,使用`yield`语句返回值,而不是`return`。生成器的一个关键优势是它们一次只产生一个值,而不是一次性生成整个序列,这在处理大量数据时非常有用,因为它可以节省内存资源。

## 1.2 迭代器协议

迭代器是实现了迭代器协议的对象,意味着它们有一个`__next__()`方法,该方法返回序列的下一个元素,如果没有元素了,则抛出`StopIteration`异常。在Python中,任何遵循这种协议的对象都可以被视为迭代器。与生成器不同,迭代器是一个更为通用的术语,可以是生成器,也可以是实现了迭代器协议的任何对象,例如列表、字典等。

## 1.3 迭代器的创建和使用

要创建一个迭代器,您可以使用内置的`iter()`函数。这个函数接受一个可迭代对象作为参数,并返回一个迭代器。例如,`iter([1, 2, 3])`将返回一个迭代器,可以逐个访问列表中的元素。在Python 3中,使用`next()`函数来获取迭代器的下一个元素,而在Python 2中则使用`.next()`方法。

```python

# 创建迭代器示例

my_list = [1, 2, 3]

iterator = iter(my_list)

# 使用迭代器

print(next(iterator)) # 输出: 1

print(next(iterator)) # 输出: 2

print(next(iterator)) # 输出: 3

# print(next(iterator)) # StopIteration异常: 没有更多元素可以迭代

```

总结而言,生成器是迭代器的一种实现方式,它们简化了迭代过程的内存使用。理解生成器和迭代器的基础是掌握`itertools`模块及其高效数据处理技巧的第一步。

# 2. itertools模块的构建块

## 2.1 创建无限迭代器

### 2.1.1 count, cycle和repeat的用法

Python中的`itertools`模块提供了几种用于创建无限迭代器的函数,它们分别是`count`、`cycle`和`repeat`。

- `count(start=0, step=1)`函数从`start`开始,以`step`为步长,无限生成递增的整数序列。例如:`itertools.count(10)`将会生成一个序列:`10, 11, 12, 13, ...`。

- `cycle(iterable)`函数对传入的可迭代对象进行无限循环迭代。例如:`itertools.cycle('abc')`将会不断重复:`'a', 'b', 'c', 'a', 'b', 'c', ...`。

- `repeat(object, times=None)`函数则会无限次重复同一个对象。如果指定了`times`参数,那么重复次数将会是`times`。如果不指定,它会无限次重复。例如:`itertools.repeat('X', 3)`将重复输出`'X'`三次。

```python

import itertools

# 使用itertools.count

for i in itertools.islice(itertools.count(5), 5):

print(i, end=' ')

# 输出: 5 6 7 8 9

# 使用itertools.cycle

for i in itertools.islice(itertools.cycle('AB'), 10):

print(i, end=' ')

# 输出: A B A B A B A B A B

# 使用itertools.repeat

for i in itertools.repeat(42, 3):

print(i, end=' ')

# 输出: 42 42 42

```

在上面的代码示例中,我们使用`itertools.islice`来限制迭代次数,从而模拟一个有界的迭代器。

### 2.1.2 无限迭代器在实践中的应用

无限迭代器在实践中的应用虽然有限,但在特定的场景下显得非常有用。例如,在需要持续产生事件或样本流的仿真系统中,我们可以使用`cycle`无限循环播放一组事件序列,或者用`count`产生一个连续的ID序列。

一个典型的例子是游戏中的帧更新机制,可以通过`count`在每一帧中增加一个计数器来跟踪帧的顺序。无限迭代器可以使用`break`语句或条件判断来提前终止迭代。

```python

import itertools

# 游戏帧更新机制的简单模拟

frame_id = 0

for _ in itertools.count():

frame_id += 1

print(f"Frame {frame_id} update")

if frame_id >= 5:

break

# 输出:

# Frame 1 update

# Frame 2 update

# Frame 3 update

# Frame 4 update

# Frame 5 update

```

在实际开发中,需要注意的是,无限迭代器不能在没有终止条件的情况下使用,否则会导致无限循环。对于需要终止的情况,应该使用`for`循环来控制迭代次数,或者在适当的时机使用`break`语句提前结束迭代。

## 2.2 组合生成器

### 2.2.1 chain, compress和dropwhile的原理与应用

`itertools`模块提供了多种组合多个迭代器的方法。其中`chain`、`compress`和`dropwhile`是其中重要的函数。

- `chain(*iterables)`函数可以将多个可迭代对象连接在一起,形成一个新的迭代器。例如:`itertools.chain('ABC', 'DEF')`将生成序列`'A', 'B', 'C', 'D', 'E', 'F'`。

- `compress(data, selectors)`根据`selectors`中的布尔值选择`data`中的元素。`data`和`selectors`应该具有相同的长度。例如:`***press('ABCDEF', [1,0,1,0,1,1])`将输出`'A', 'C', 'E', 'F'`。

- `dropwhile(predicate, iterable)`丢弃`iterable`中`predicate`为真的元素,一旦`predicate`为假,则开始输出元素。例如:`itertools.dropwhile(lambda x: x < 5, [1, 4, 6, 4, 1])`将输出`6, 4, 1`。

```python

import itertools

# 使用itertools.chain组合迭代器

for item in itertools.chain([1, 2, 3], [4, 5, 6]):

print(item, end=' ')

# 输出: 1 2 3 4 5 6

# 使用***press选择数据

***press('abcdef', [1, 0, 1, 0, 1, 1]):

print(item, end=' ')

# 输出: a c e f

# 使用itertools.dropwhile过滤数据

for item in itertools.dropwhile(lambda x: x < 5, [1, 4, 6, 4, 1]):

print(item, end=' ')

# 输出: 6 4 1

```

`chain`用于将多个迭代器“串联”起来,可以很方便地遍历多个列表、元组或其他可迭代对象,而不需要编写额外的循环逻辑。`compress`适用于根据某些条件从数据集中选择元素的场景,例如,从一组日志条目中筛选出错误日志。`dropwhile`则常用于跳过序列开头的某些不需要的元素。

### 2.2.2 groupby与takewhile的高级用法

`groupby`和`takewhile`也是组合生成器的一部分,它们分别用于分组和在条件为真时收集元素。

- `groupby(iterable, key=None)`根据`key`函数的结果对`iterable`中的元素进行分组。`key`函数用于指定分组的依据。例如:`itertools.groupby('AAABBBCCDAA')`将按照字符分组,输出`('A', <itertools._grouper object at 0x7fb47414c4f0>)`。

- `takewhile(predicate, iterable)`从`iterable`中取元素,直到`predicate`为假。例如:`itertools.takewhile(lambda x: x < 5, [1, 4, 6, 4, 1])`将输出`1, 4`。

```python

import itertools

# 使用itertools.groupby进行分组

for key, group in itertools.groupby('AAABBBCCDAA'):

for char in group:

print(char, end='')

print(' - ', key, end=' ')

# 输出:

# AAA - A BBB - B CCC - C D - D AA - A

# 使用itertools.takewhile提取数据

for item in itertools.takewhile(lambda x: x < 5, [1, 4, 6, 4, 1]):

print(item, end=' ')

# 输出: 1 4

```

`groupby`非常适用于处理具有重复记录的数据集,例如根据用户的ID对操作日志进行分组,或者对同一事件进行归类统计。`takewhile`则可以用于在满足特定条件时提前终止处理流程,比如读取文件直到遇到特定的分隔符。

## 2.3 迭代器运算

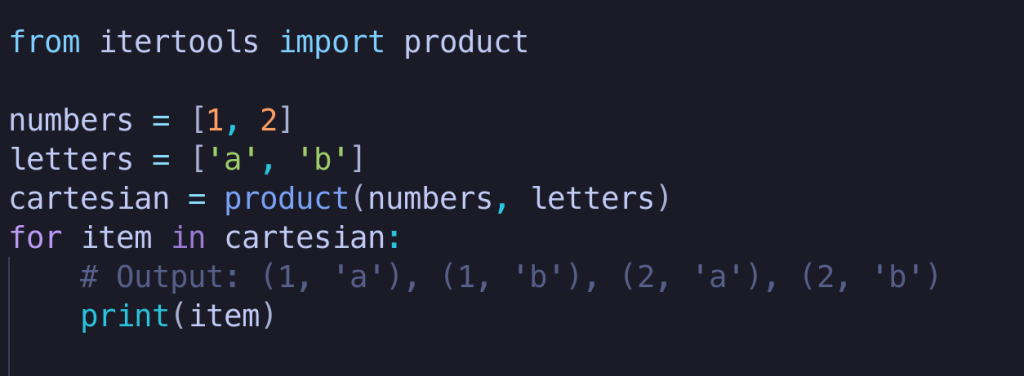

### 2.3.1 product与permutations的构建与功能

`itertools`模块中的`product`和`permutations`函数用于生成笛卡尔积和排列。

- `product(*iterables, repeat=1)`函数返回`iterables`中元素的所有可能的排列组合,相当于嵌套循环。参数`repeat`指定重复使用`iterables`中的元素的次数。例如:`itertools.product('AB', repeat=2)`会生成`('A', 'A'), ('A', 'B'), ('B', 'A'), ('B', 'B')`。

- `permutations(iterable, r=None)`函数返回`iterable`中所有长度为`r`的排列。如果省略`r`,则默认为`iterable`的长度。例如:`itertools.permutations('AB', 2)`生成`('A', 'B'), ('B', 'A')`。

```python

import itertools

# 使用itertools.product生成笛卡尔积

for prod in itertools.product([1, 2], repeat=2):

print(prod)

# 输出:

# (1, 1)

# (1, 2)

# (2, 1)

# (2, 2)

# 使用itertools.permutations生成排列

for perm in itertools.permutations('AB', 2):

print(perm)

# 输出:

# ('A', 'B')

# ('B', 'A')

```

`product`可用于生成多个数据集的组合,这对于测试或探索数据集间的相互关系特别有用。`permutations`则用于需要从一组有限元素中生成所有可能排列的场景,例如在密码学中生成密钥的所有可能性。

### 2.3.2 combinations与combinations_with_replacement的区别与联系

`combinations(iterable, r)`和`combinations_with_replacement(iterable, r)`函数都是返回长度为`r`的元素组合,但它们之间有细微的区别。

- `combinations(iterable, r)`不会返回重复组合,即组合中的元素是唯一的。例如:`***binations('AB', 2)`生成`('A', 'B')`,不会生成重复的`('B', 'A')`。

- `combinations_with_replacement(iterable, r)`则会返回重复组合,即允许组合中的元素可以重复。例如:`***binations_with_replacement('AB', 2)`生成`('A', 'A'), ('A', 'B'), ('B', 'B')`。

```python

import itertools

# 使用***binations生成组合

***binations('AB', 2):

print(combo)

# 输出: ('A', 'B')

# 使用***binations_with_replacement生成组合

***binations_with_replacement('AB', 2):

print(combo)

# 输出: ('A', 'A') ('A', 'B') ('B', 'B')

```

`combinations`在需要生成不考虑元素重复的所有可能组合时非常有用,比如在数学问题中寻找所有不重复的集合组合。`combinations_with_replacement`则适用于那些允许元素重复出现的场景,例如在生成所有可能的密码组合时,每个位置的字符可以重复选取。

# 3. itertools的高级技巧

## 3.1 利用itertools进行高效数据处理

### 3.1.1 islice与tee的优化数据流操作

在处理数据流时,我们常常需要在迭代过程中高效地“切片”或“复制”数据。Python标准库中的 `itertools.islice` 和 `itertools.tee` 正是为了这一目的而设计。`islice` 允许我们在迭代器上执行类似列表切片的操作,而不必真正生成中间列表。`tee` 可以用来复制一个迭代器,这样我们就可以在不重复处理的情况下多次遍历相同的数据集。

**islice**

```python

import itertools

def islice_example():

data = range(10)

sliced = itertools.islice(data, 5, None) # 从索引5到结束

for item in sliced:

print(item)

islice_example()

```

上面的代码块展示了如何使用 `islice` 来“切片”迭代器。我们可以指定起始点和结束点(都是可选的),然后迭代器将只返回指定范围内的元素。

**tee**

```python

def tee_example():

data = itertools.count()

t1, t2 = itertools.tee(data, 2) # 复制迭代器

next(t1) # t1和t2从不同的位置开始迭代

next(t2)

for i in range(4):

print(next(t1), next(t2))

tee_example()

```

在 `tee` 的示例中,我们复制了 `count` 迭代器,并且两个副本可以在不同的时间点开始迭代,但它们是独立的。

**参数说明和代码逻辑**

- `islice(iterable, start, stop[, step])`: 该函数返回一个迭代器,该迭代器生成从 `start` 开始到 `stop` 的元素(不包括 `stop`),每次迭代 `step` 个元素。

- `tee(iterable, n=2)`: 此函数返回一个元组,包含n个独立的迭代器,它们都是对原始迭代器的复制。

这两个函数都可以在数据流处理中节省内存,因为它们不需要创建额外的列表,而是直接在迭代器上工作。

### 3.1.2 starmap与accumulate的使用场景

itertools 模块中的 `starmap` 和 `accumulate` 函数提供了对数据进行高级处理的能力。`starmap` 函数允许将一个函数应用到序列的元素上,这些元素本身是参数的元组或列表。而 `accumulate` 函数则用于累积计算,它接受一个二元操作函数,然后连续地将这个操作应用到序列的元素上,并将结果累积起来。

**starmap**

```python

import operator

def starmap_example():

data = [(1, 2), (3, 4), (5, 6)]

result = itertools.starmap(operator.add, data)

for item in result:

print(item)

starmap_example()

```

在 `starmap` 的例子中,我们使用 `operator.add` 来计算元组中元素的和。

**accumulate**

```python

def accumulate_example():

data = range(1, 5)

result = itertools.accumulate(data)

for item in result:

print(item)

accumulate_example()

```

在 `accumulate` 的例子中,我们对一个范围内的数字进行累加操作。

**参数说明和代码逻辑**

- `starmap(function, iterable)`: `starmap` 将 `function` 应用于 `iterable` 中的每个元组(或列表),并将结果返回为一个新的迭代器。

- `accumulate(iterable[, func, *, initial=None])`: `accumulate` 默认进行加法运算,如果提供了 `func`,则进行 `func` 运算。可选的 `initial` 参数用于指定累积的初始值。

使用 `starmap` 和 `accumulate` 能够在数据处理上提供更灵活的解决方案,特别是当处理复杂数据结构或需要累积运算时。

## 3.2 自定义迭代器模式

### 3.2.1 如何创建自定义的迭代器

在Python中创建自定义迭代器可以让我们更灵活地控制数据的遍历过程。迭代器模式允许我们一次处理一个元素,而不是一次性加载整个数据集,这对于处理大量数据特别有用。

**创建自定义迭代器**

```python

class CustomIterator:

def __init__(self, data):

self.data = data

self.index = 0

def __iter__(self):

return self

def __next__(self):

if self.index < len(self.data):

value = self.data[self.index]

self.index += 1

return value

else:

raise StopIteration

custom_iterator = CustomIterator([1, 2, 3, 4, 5])

for item in custom_iterator:

print(item)

```

在这个例子中,我们创建了一个自定义迭代器 `CustomIterator`,它遍历一个整数列表并打印出来。通过定义 `__iter__` 和 `__next__` 方法,我们实现了迭代器协议,使得类的实例可以被 `for` 循环迭代。

### 3.2.2 自定义迭代器在复杂数据结构中的应用

自定义迭代器不仅仅局限于简单数据结构,它同样适用于复杂的数据结构和算法。例如,在处理图或树的遍历问题时,自定义迭代器可以帮助我们实现深度优先或广度优先搜索。

**树结构中的迭代器应用**

假设我们有一个简单的二叉树结构,我们想用迭代器来实现广度优先搜索(BFS):

```python

class TreeNode:

def __init__(self, value):

self.value = value

self.children = []

def add_child(self, child):

self.children.append(child)

from collections import deque

class TreeIterator:

def __init__(self, root):

self.queue = deque([root])

def __iter__(self):

return self

def __next__(self):

if not self.queue:

raise StopIteration

else:

node = self.queue.popleft()

self.queue.extend(node.children)

return node.value

# 构建一棵树并使用我们的迭代器

root = TreeNode(1)

root.add_child(TreeNode(2))

root.add_child(TreeNode(3))

root.children[0].add_child(TreeNode(4))

root.children[1].add_child(TreeNode(5))

tree_iterator = TreeIterator(root)

for value in tree_iterator:

print(value)

```

在这个例子中,我们使用了队列来实现树的广度优先遍历。通过自定义迭代器,我们可以方便地在树结构上执行BFS,而不需要改变现有的数据结构。

## 3.3 itertool与现代Python特性

### 3.3.1 利用asyncio与itertools处理异步数据流

异步编程是现代Python中的一个重要概念。`asyncio` 模块允许我们编写异步代码,而 `itertools` 可以与之结合,以便高效地处理数据流。

**异步迭代器**

```python

import asyncio

import itertools

async def async_islice(iterable, start, stop):

it = iter(iterable)

for _ in range(start):

next(it, None)

return itertools.islice(it, stop-start)

async def async_print_items():

data = range(10)

async for item in async_islice(data, 5, None):

print(item)

await asyncio.sleep(0.1) # 模拟异步操作

asyncio.run(async_print_items())

```

在上述示例中,我们定义了一个异步迭代器函数 `async_islice`,它可以异步地“切片”数据。然后我们使用 `async for` 循环来异步地打印数据。

**参数说明和代码逻辑**

- `async for item in async_iterator:` 这种语法用于在异步函数中迭代异步迭代器。

- `asyncio.sleep(0.1)`: 这是一个模拟异步操作的函数调用,它在异步函数中用来暂停执行。

结合 `asyncio` 和 `itertools`,我们可以有效地处理那些需要异步处理的复杂数据流。

### 3.3.2 itertool在函数式编程中的作用

函数式编程范式在Python中也越来越受欢迎,而 `itertools` 提供了许多有助于实现函数式编程风格的工具。

**使用itertools实现map-reduce模式**

```python

from itertools import starmap

def add(x, y):

return x + y

data = [(1, 2), (3, 4), (5, 6)]

result = sum(starmap(add, data))

print(result)

```

在这个例子中,我们使用 `starmap` 结合 `sum` 函数来实现 `map-reduce` 模式。首先 `starmap` 将 `add` 函数应用到 `data` 上的每个元组,然后使用 `sum` 来累加结果。

**参数说明和代码逻辑**

- `starmap(function, iterable)`: 将 `function` 应用到 `iterable` 中每个元素的参数上。

- `sum(iterable, start=0)`: 计算 `iterable` 中元素的总和。

通过利用 `itertools` 模块,我们可以在Python中更加简洁地应用函数式编程概念,提高代码的表达性和效率。

# 4. ```markdown

# 第四章:itertools案例研究

## 4.1 解决实际问题中的迭代器模式

迭代器模式为数据处理提供了一种内存高效且灵活的方法。在分析和设计迭代器解决方案时,我们通常从问题的核心需求入手,并通过构建合适的迭代器组合来解决问题。

### 4.1.1 分析并实现一个复杂问题的迭代器解决方案

在解决一个复杂的分组问题时,假设我们需要根据多个字段对数据进行分组。使用itertools中的`groupby`函数可以非常高效地完成这项任务。首先,我们先定义一个数据集:

```python

import itertools

data = [

{'name': 'Alice', 'age': 25, 'group': 'A'},

{'name': 'Bob', 'age': 25, 'group': 'B'},

{'name': 'Alice', 'age': 26, 'group': 'A'},

{'name': 'Bob', 'age': 26, 'group': 'B'},

# ... 更多数据

]

# 根据 name 和 group 分组

for key, group in itertools.groupby(data, lambda x: (x['name'], x['group'])):

print(f"Group: {key}")

for item in group:

print(f" - {item}")

```

### 4.1.2 评估不同迭代器组合的性能表现

在迭代器组合时,性能往往是一个重要的考量因素。例如,如果我们想要计算一个数据集中的元素和,我们可能会考虑使用`accumulate`迭代器:

```python

import random

import itertools

# 创建一个数字列表

numbers = [random.randint(1, 100) for _ in range(10000)]

# 使用 accumulate 迭代器计算累加和

sums = list(itertools.accumulate(numbers))

# 分析性能

import time

start = time.time()

sums = list(itertools.accumulate(numbers))

end = time.time()

print(f"Time taken for accumulate: {end - start} seconds")

```

## 4.2 itertool在数据分析中的应用

### 4.2.1 使用itertools处理大型数据集

在处理大型数据集时,itertools可以帮助我们构建复杂的管道来过滤、映射和聚合数据。假设我们有一个大型CSV文件,我们想要读取并处理每一行,但又不希望一次性加载整个文件到内存中,我们可以这样做:

```python

import csv

from itertools import islice, chain

def process大型CSV文件(file_path, chunk_size=1000):

with open(file_path, 'r') as ***

***

***

***

***

* 在这里对每行数据进行处理

for row in lines:

# 你的数据处理逻辑

pass

# 调用函数处理大型数据集

process大型CSV文件('path/to/large_file.csv')

```

### 4.2.2 构建自定义的数据处理管道

我们可以创建一个自定义的迭代器来构建一个数据处理管道,它对数据进行一系列转换和筛选,例如,对日志文件进行过滤和分析:

```python

# 假设日志数据是一个生成器

def log_data():

# 生成日志数据的逻辑

pass

# 定义一个处理管道

def processing_pipeline(logs):

for log in logs:

if is_valid_log(log):

yield transform_log(log)

# 对日志进行验证和转换

def is_valid_log(log):

# 验证日志的逻辑

return True

def transform_log(log):

# 转换日志数据的逻辑

return transformed_log

# 将日志处理管道应用于生成器

processed_logs = processing_pipeline(log_data())

# 处理完毕后进行输出或其他操作

for processed_log in processed_logs:

print(processed_log)

```

## 4.3 itertool与并发编程

### 4.3.1 利用itertools简化多线程或多进程的数据处理

在进行并发编程时,经常需要处理数据分片来分配给不同的工作线程。我们可以使用itertools来帮助我们分配数据:

```python

import threading

def worker(data_chunk):

# 处理数据的逻辑

pass

data = range(1000) # 假设是需要处理的数据集

# 将数据分割给不同的线程

threads = []

for chunk in itertools.chunks(data, 100):

thread = threading.Thread(target=worker, args=(chunk,))

threads.append(thread)

thread.start()

# 等待所有线程完成

for thread in threads:

thread.join()

```

### 4.3.2 在并发环境下itertools的限制与优化策略

并发环境可能会增加复杂性,特别是在数据处理流水线中。itertools本身是线程安全的,但数据共享和同步需要额外注意。例如,在并发环境下,我们可能需要确保数据不会被多个线程同时修改。优化策略可能包括:

- 使用线程安全的数据结构,如`Queue`。

- 避免不必要的数据复制,通过生成器和迭代器来传递数据引用。

- 考虑使用异步编程,如`asyncio`,来处理I/O密集型任务。

以上是针对本章的详细分析。接下来,我们将探讨第五章,了解itertools模块的未来扩展以及发展趋势。

```

# 5. itertools的扩展与未来

## 5.1 探索itertools的替代品

itertools库提供了强大的迭代器构建块,但并非在所有场景下都是最佳选择。在某些特定的应用中,可能需要寻找功能更丰富的替代品或与之互补的工具。

### 5.1.1 比较itertools与第三方迭代器库

在Python生态系统中,除了标准库中的itertools,还存在许多第三方迭代器库,它们提供了更多的功能或者特定的优化。例如:

- `more-itertools`:提供了itertools库中没有的一些额外工具,如`split_before`和`windowed`等。

- `toolz`:这是一个更广泛的函数式编程库,提供了类似于itertools的迭代工具,以及数据处理功能。

- `numpy`:对于数值计算,`numpy`提供的迭代器可以更加高效,尤其在处理大型数组数据时。

这些库通常与itertools有相似的设计理念,但它们在某些特定的使用案例中提供了更为强大的功能或更好的性能。

### 代码示例:使用more-itertools的扩展功能

```python

import more_itertools

# 示例:使用more-itertools中的split_before函数

numbers = [1, 2, 2, 3, 4, 4, 4, 5]

# 将列表分割成每个连续重复元素为一组

for group in more_itertools.split_before(numbers, lambda x: x != 2):

print(list(group))

# 输出:

# [1]

# [2, 2]

# [3]

# [4, 4, 4]

# [5]

```

在上面的代码中,我们使用了`more-itertools`库中的`split_before`函数来对列表中的连续相同元素进行分组。这是itertools库本身没有提供的功能。

### 5.1.2 评估不同库在特定场景下的优劣

评估不同迭代器库的优劣时,需要考虑到以下几个方面:

- **功能完整性**:库是否提供了所需的所有迭代工具。

- **性能**:在处理大型数据集时,库的执行效率如何。

- **易用性**:库的API设计是否直观易懂,文档是否详尽。

- **社区支持**:社区活跃度,是否能快速找到问题的解决方案。

例如,对于大规模数据处理,numpy的迭代器可能会比itertools更高效,因为它们专为数值计算优化。而在需要功能性增强的场景,`more-itertools`或`toolz`可能是更合适的选择。

## 5.2 预测itertools的发展趋势

随着Python语言及应用场景的不断进步和扩展,itertools库也在不断发展和优化。以下是关于itertools未来发展的两个预测方向。

### 5.2.1 根据Python的发展预测itertools的改进方向

Python在迭代器处理和生成器表达式方面的不断优化为itertools库的发展提供了基础。未来的迭代器模式可能会更加接近Python的异步编程模型,并且在并行计算方面的支持可能会得到加强。

- **异步迭代器**:随着Python 3.6引入的异步for循环,itertools可以考虑支持异步迭代器,使异步数据处理更为流畅。

- **并行计算集成**:为了更好地适应多核处理器和并行计算的需求,itertools可能需要引入更多的并行处理工具或改进现有的工具。

### 5.2.2 探讨itertools在新兴技术中的应用潜力

随着大数据、机器学习等领域的迅速发展,itertools库可能会通过集成到更高级的数据处理框架中,例如Pandas和Dask,从而在新兴技术中发挥更大的作用。

- **数据科学集成**:itertools可能会提供更紧密的集成方式与数据科学工具,如Pandas的Series和DataFrame,以便更有效地进行数据预处理和分析。

- **分布式计算支持**:在分布式系统中,itertools需要支持数据的切分和聚合,以便在分布式环境中执行迭代操作。

总之,itertools作为Python编程中重要的组成部分,其未来的发展趋势将紧密依赖于Python语言的演进以及计算需求的不断变化。持续关注这些变化,可以帮助我们更好地利用itertools解决各种迭代处理问题。

0

0