NLTK与深度学习:使用NLTK准备数据以适应神经网络

发布时间: 2024-10-04 18:15:15 阅读量: 2 订阅数: 8

# 1. NLTK与深度学习概述

## 1.1 自然语言处理的崛起

随着信息技术的不断进步,自然语言处理(NLP)已成为AI研究领域的一大热点。借助NLP技术,机器能够理解和解释人类语言,从而实现语言交互与智能化应用。NLTK(Natural Language Toolkit)作为一个强大的Python库,在NLP中占据着举足轻重的地位,提供了丰富的接口进行文本处理、分析与建模。深度学习的兴起进一步推动了NLP的发展,使得从大量文本数据中提取有效信息和深层语义成为可能。

## 1.2 NLTK的作用与深度学习的融合

NLTK库不仅简化了文本数据的处理流程,还因其直观的接口和丰富的算法,成为语言数据处理的首选工具之一。它覆盖了从文本的导入、清洗、预处理、到向量化等各个阶段,为后续的算法应用打下了坚实的基础。随着深度学习技术的渗透,NLTK也开始与深度学习框架结合,共同推动NLP技术的进步。通过深度学习模型,我们能够实现复杂的语言理解和生成任务,如文本分类、情感分析、机器翻译等,这些都是传统机器学习方法难以匹敌的。

## 1.3 本文内容梳理

本文旨在探讨NLTK在数据处理中的应用,并着重分析深度学习如何与之结合,进一步提升文本分析的效果。从基础的文本处理流程到深度学习模型的构建,再到实际案例分析,我们将逐一展开讨论。通过本文的学习,读者不仅可以掌握NLTK的使用方法和深度学习的基本知识,还能了解如何将这两种技术整合,应用于解决实际问题。

# 2. NLTK库的数据处理基础

NLTK(Natural Language Toolkit)是Python中最为流行的自然语言处理库之一,它为用户提供了一系列的数据处理工具,以便进行语言分析、数据清洗、文本分词、词性标注、语义理解等任务。对于从事文本处理的IT行业从业者来说,掌握NLTK的数据处理基础是实现高效自然语言处理项目的前提。

## 2.1 文本数据的导入与清洗

### 2.1.1 数据导入方法

数据导入是处理自然语言数据的第一步,通常涉及到从各种数据源中读取文本信息,比如文件、数据库、网络资源等。在Python中,NLTK库提供了丰富的工具来处理这些数据导入任务。

在导入数据前,需要先安装NLTK库,这可以通过Python的包管理工具pip来完成:

```python

pip install nltk

```

接下来,使用NLTK提供的方法导入数据:

```python

import nltk

from nltk.corpus import stopwords

# 从本地文件中读取数据

with open('example.txt', 'r') as ***

***

* 从网络资源导入数据

import urllib.request

url = '***'

response = urllib.request.urlopen(url)

data = response.read().decode('utf-8')

# 使用nltk.corpus模块导入标准数据集

nltk.download('punkt')

sentences = nltk.corpus.gutenberg.sents('shakespeare-macbeth.txt')

```

### 2.1.2 文本清洗技巧

文本清洗的主要目的是为了去除数据中的噪声,如无关字符、特殊符号、数字等,以及规范化文本为后续处理提供便利。文本清洗技巧通常包含以下几个方面:

- 转换文本格式:将文本统一转换为小写或大写,以便进行规范化处理。

- 去除特殊字符:例如标点符号、HTML标签等。

- 数字处理:将数字转换为特定形式,或者直接移除。

- 词形还原:将单词还原为词根形式,便于后续的分析。

在NLTK中,可以使用以下方法进行文本清洗:

```python

import string

# 将所有字符转为小写,并去除标点

cleaned_data = data.lower().translate(str.maketrans('', '', string.punctuation))

# 移除数字

cleaned_data = ''.join(filter(lambda x: not x.isdigit(), cleaned_data))

# 词形还原,需要先下载nltk的wordnet词库

nltk.download('wordnet')

from nltk.stem import WordNetLemmatizer

lemmatizer = WordNetLemmatizer()

lemmatized_data = [lemmatizer.lemmatize(word) for word in cleaned_data.split()]

```

## 2.2 文本数据的预处理

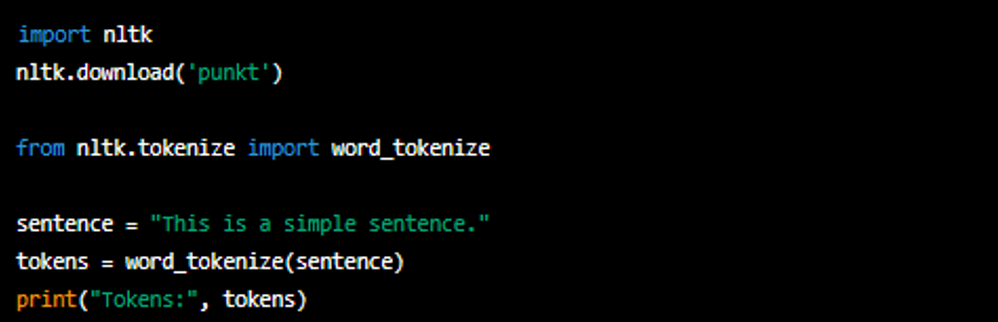

### 2.2.1 分词与标记化

分词是将一段文本分解为单词或其他有意义的元素的过程。标记化(Tokenization)是分词之后的一步,指的是将文本分割成更小的单位(通常是单词或短语),这些单位称为“标记”(Token)。

NLTK提供了`word_tokenize`函数进行分词:

```python

from nltk.tokenize import word_tokenize

# 示例文本

text = "NLTK is a leading platform for building Python programs to work with human language data."

# 分词

tokens = word_tokenize(text)

print(tokens)

```

### 2.2.2 停用词处理

停用词是语言中的常见词,如英语中的“the”、“is”、“at”等,这些词在文本中频繁出现,但通常对于文本的语义理解帮助不大。因此,在文本分析中,常常需要去除停用词:

```python

# 获取英文停用词列表

nltk.download('stopwords')

stop_words = set(stopwords.words('english'))

# 移除停用词

filtered_tokens = [word for word in tokens if word.lower() not in stop_words]

print(filtered_tokens)

```

### 2.2.3 词干提取和词形还原

词干提取(Stemming)和词形还原(Lemmatization)都是将词汇还原到基本形式的过程,但词干提取通常更为简单粗暴,而词形还原则使用词汇学的知识。

```python

from nltk.stem import PorterStemmer

# 词干提取

stemmer = PorterStemmer()

stemmed_tokens = [stemmer.stem(word) for word in filtered_tokens]

# 词形还原

lemmatized_tokens = [lemmatizer.lemmatize(word) for word in filtered_tokens]

```

## 2.3 文本数据的向量化

### 2.3.1 Bag-of-Words模型

Bag-of-Words模型是一种简单但有效的文本表示方法,它忽略掉文本中单词的顺序,只将文本视为单词的集合,并统计每个单词出现的频率。NLTK提供了`CountVectorizer`工具来进行BoW模型的向量化操作:

```python

from sklearn.feature_extraction.text import CountVectorizer

# 将多个句子合并为一个字符串

corpus = ' '.join(filtered_tokens)

# 创建向量化器对象

vectorizer = CountVectorizer()

# 转换文本数据为向量化格式

bow_vector = vectorizer.fit_transform([corpus])

print(bow_vector.toarray())

```

### 2.3.2 TF-IDF权重计算

TF-IDF(Term Frequency-Inverse Document Frequency)是一种用于信息检索与文本挖掘的常用加权技术。该方法考虑了词在文档中的频率和其在文档集中出现的频率,以评估一个词对一个文档集或一个语料库中的其中一份文档的重要性。

```python

from sklearn.feature_extraction.text import TfidfVectorizer

# 创建TF-IDF向量化器对象

tfidf_vectorizer = TfidfVectorizer()

# 转换文本数据为TF-IDF向量化格式

tfidf_vector = tfidf_vectorizer.fit_transform([corpus])

print(tfidf_vector.toarray())

```

### 2.3.3 Word2Vec词嵌入

Word2Vec是一种通过训练学习得到词的分布式表示的模型,通过学习词语之间的关系,可以将词语映射到一个连续的向量空间中。词向量是现代自然语言处理的基石,它为更复杂的深度学习模型提供了丰富的特征表示。

在Python中,可以使用`gensim`库来训练Word2Vec模型:

```python

from gensim.models import Word2Vec

# 训练Word2Vec模型

model = Word2Vec([filtered_tokens], min_count=1)

# 获取词向量

word_vectors = model.wv['example_word']

print(word_vectors)

```

以上就是NLTK库在文本数据导入、清洗、预处理以及向量化方面的基础知识。掌握这些技能,不仅有助于提升文本数据处理的效率,也为后续的深度学习模型训练提供了可靠的数据基础。在下一章节中,我们将深入探讨深度学习的基础理论以及神经网络的构建与训练过程。

# 3. 深度学习基础与神经网络

深度学习作为机器学习的一个分支,通过构建多层的人工神经网络来学习数据的高级特征。在自然语言处理(NLP)任务中,深度学习已经取得了巨大的成功,其能力在于能够捕捉文本中的复杂模式。本章节将深入探讨深度学习的理论基础,并详细分析神经网络的构建、训练及优化过程。

## 3.1 深度学习理论简介

### 3.1.1 深度学习基本概念

深度学习的出现让机器能够处理复杂的输入数据并输出有用的结果。它依赖于大量数据的可用性和计算资

0

0