NLTK插件与扩展:探索NLTK生态系统中的工具

发布时间: 2024-10-04 18:08:49 阅读量: 52 订阅数: 24

# 1. NLTK的基础知识和安装

## NLTK是什么

自然语言处理工具包(Natural Language Toolkit,简称NLTK)是一个开源的Python库,专门用于处理人类语言数据。NLTK提供了易于使用的接口,支持文本分类、语义理解和句法分析等多种自然语言处理任务。

## 安装NLTK

在Python环境中安装NLTK非常简单。推荐使用pip进行安装:

```shell

pip install nltk

```

安装完成后,可以通过Python的交互式环境导入并检查版本:

```python

import nltk

print(nltk.__version__)

```

## NLTK的结构

NLTK由多个模块组成,主要包括:

- Tokenization:将文本分割成有意义的单元,如单词或句子。

- Tagging:标记每个单词的词性,如动词、名词等。

- Parsing:分析句子的句法结构。

- Classification:将文本分类到不同的类别中。

- Semantics:理解文本的含义。

NLTK的安装是开始自然语言处理旅程的第一步,接下来,我们将深入探讨如何使用NLTK进行更复杂的文本分析工作。

# 2. NLTK的核心功能

### 2.1 词法分析和处理

#### 2.1.1 分词技术

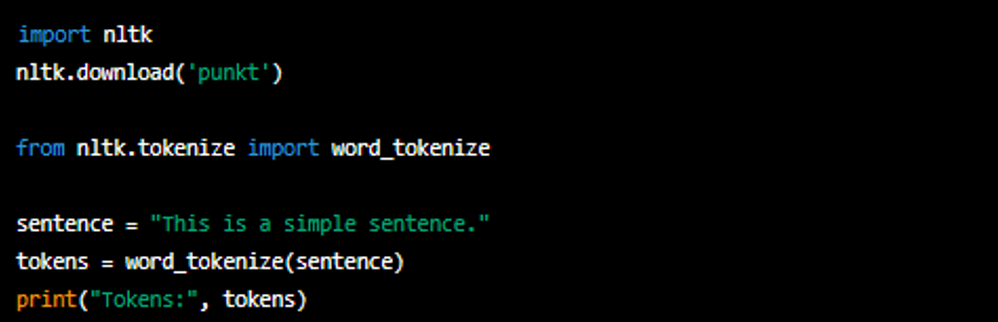

分词技术是自然语言处理中的一个基础环节,用于将一段文本拆分成一系列有意义的单位,这些单位通常是单词、短语或者其他词汇。在处理英语时,分词相对简单,因为它多以空格来分隔单词。但是在处理中文时,由于缺乏空格作为明显的分隔符,分词变得更加复杂。NLTK提供了多种分词工具,其中较为著名的有基于规则的`RegexpTokenizer`和基于统计模型的`PunktTokenizer`。

```python

from nltk.tokenize import RegexpTokenizer, MWETokenizer

# 使用正则表达式进行分词

tokenizer = RegexpTokenizer(r'\w+|\$[\d\.]+|\S+')

text = "NLTK is a leading platform for building Python programs to work with human language data."

tokens = tokenizer.tokenize(text)

print(tokens)

```

上述代码展示了如何使用`RegexpTokenizer`对包含货币符号、数字以及普通文本的字符串进行分词。在参数解释中,“r”表示原始字符串,避免Python对反斜杠的特殊处理。“\w+”匹配一个或多个字母数字字符,“\$[\d\.]+”匹配以美元符号开始的数字(可能包含小数点),“\S+”匹配任何非空白字符。

`MWETokenizer`(多词表达式分词器)是另一种分词工具,适用于需要识别词汇组合的情况。例如,它可以识别缩写词如“I.B.M.”而不会将其误分为“I B M”。

```python

# 使用MWETokenizer对特定词汇组合进行分词

tokenizer = MWETokenizer(['Mr.', 'Mrs.', 'Dr.'])

tokenizer.add_mwe(('New', 'York'))

text = "Dr. Smith and Mrs. Jones are from New York."

tokens = tokenizer.tokenize(text.split())

print(tokens)

```

在该代码示例中,`MWETokenizer`首先被初始化为识别常见的英文缩写,然后添加了一个多词表达式“New York”。之后对一句英文进行分词,其中"New York"被正确识别为一个单元。

#### 2.1.2 词性标注

词性标注是将单词分配一个语法角色的过程,例如名词、动词、形容词等。NLTK提供了多个预训练的词性标注模型,可以用于英文文本的标注。一个常用的是PENN Treebank 标注集,该标注集包含了36个不同的词性标签。

```python

import nltk

from nltk.tokenize import word_tokenize

from nltk import pos_tag

text = "NLTK is a leading platform for building Python programs to work with human language data."

tokens = word_tokenize(text)

tagged_tokens = pos_tag(tokens)

print(tagged_tokens)

```

代码首先导入了`nltk`库和相关的分词函数,然后定义了一段文本,用`word_tokenize`函数对其进行分词,最后用`pos_tag`函数进行词性标注。输出的`tagged_tokens`为一个包含元组的列表,每个元组包含一个单词和其对应的词性标签。

词性标注对于理解句子结构、提取信息和建立更复杂的自然语言处理应用至关重要。例如,了解一个词是动词还是名词,可以帮助确定句子中的主语和谓语,这对于句子解析是基础性的。

### 2.2 句法分析和解析

#### 2.2.1 依存句法分析

依存句法分析关注词与词之间的语法依赖关系,而不是短语结构。在依存句法分析中,每个词都与另一个词相连,连接词被称为“头”,而被连接的词被称为“修饰语”,它们通过修饰关系相连。

NLTK提供了`DependencyParser`类来实现依存句法分析。在NLTK 3.0及以后的版本中,使用了Stanford Parser的接口进行依存句法分析。

```python

import nltk

from nltk.parse.stanford import StanfordDependencyParser

nltk.download('stanford_parser')

nltk.download('punkt')

# 使用Stanford的依存句法分析器

text = "The quick brown fox jumped over the lazy dog."

parser = StanfordDependencyParser(model_path='path/to/stanford-parser.jar', path_to_jar='path/to/stanford-parser-full-2015-12-08.jar')

tree = parser.raw_parse(text)

result = list(tree.subtrees(filter=lambda t: t.label() == 'ROOT'))

for subtree in result:

print(subtree)

```

在代码示例中,首先导入了必要的NLTK模块,然后下载了斯坦福解析器所需的模型和分词器。接着,对一段文本进行解析,最终打印出依存句法分析的结果。

依存句法分析对于理解句子中单词之间的依赖关系非常重要,它能揭示句子的内在结构,对于机器翻译、情感分析等应用来说是核心功能。

#### 2.2.2 组块分析

组块分析是将句子划分为多个短语块的过程,这些短语块可以是名词短语(NP)、动词短语(VP)等。组块分析通常作为句法分析的前期步骤,有助于简化句法树的复杂性,并为后续处理如信息抽取提供支持。

NLTK通过`nltk.chunk`模块提供了组块分析的功能,其中`RegexpParser`类允许使用正则表达式定义组块规则。

```python

import nltk

from nltk.chunk import RegexpParser

nltk.download('treebank')

text = "The president is expected to veto the bill."

tagged_text = nltk.pos_tag(nltk.word_tokenize(text))

chunker = RegexpParser(r'NP: {<DT>?<NNP>+}')

tree = chunker.parse(tagged_text)

print(tree)

```

在上述代码中,首先对一段文本进行分词和词性标注。然后,`RegexpParser`使用正则表达式定义了一个简单的名词短语规则,规则中`DT`和`NNP`表示词性,`+`表示一个或多个这样的词性。最后,应用这个规则并打印出生成的组块树。

组块分析有助于在解析整个句子之前快速识别和提取重要的短语信息,对自然语言处理应用中提取有用信息特别有用。

### 2.3 文本分类和主题建模

#### 2.3.1 常用分类算法

文本分类是指将文本分配到一个或多个类别中。在自然语言处理中,最常见的文本分类任务包括情感分析、垃圾邮件检测和新闻分类。NLTK提供了多种机器学习算法,可以用于文本分类。

```python

import nltk

from nltk.corpus import movie_reviews

from nltk.classify import NaiveBayesClassifier

nltk.download('movie_reviews')

nltk.download('punkt')

nltk.download('stopwords')

# 加载电影评论数据集

reviews = [(list(movie_reviews.words(fileid)), category)

for category in movie_reviews.categories()

for fileid in movie_reviews.fileids(category)]

# 分词并移除停用词

stop_words =

```

0

0