NLTK数据可视化:展示NLP结果的创新方法

发布时间: 2024-10-04 18:41:53 阅读量: 54 订阅数: 24

# 1. NLTK和数据可视化的基础知识

在探索自然语言处理(NLP)的世界之前,了解基础的数据可视化概念和技术是至关重要的。本章将介绍NLTK(Natural Language Toolkit)库的基本概念,并概述数据可视化的重要性。我们将探讨为什么数据可视化是NLP项目中不可或缺的一环,以及如何使用NLTK来处理和展示数据。

## 1.1 NLTK库简介

NLTK是一个强大的Python库,它为NLP提供了一系列工具和接口。从文本的预处理到复杂的语言建模,NLTK为开发者提供了丰富的函数和方法来处理文本数据。它包括了词性标注、分词、句子切分、语义分析等模块,是初学者和专家处理自然语言数据的首选库。

## 1.2 数据可视化的意义

数据可视化是将数据以图表、图形等形式展示出来的过程。在NLP领域,适当的可视化可以帮助我们直观地理解语言数据的模式、趋势和关系。好的可视化不仅仅是美观,更需要传达出数据背后的洞察。使用NLTK可以轻松地与数据可视化库如Matplotlib和Seaborn等进行整合,进而创建出各种直观的图表。

## 1.3 理解基础的可视化图形

在我们深入NLTK的数据可视化之前,需要了解一些基础的可视化图形类型。例如,条形图能很好地展示分类数据的频率;折线图适用于观察数据随时间的变化趋势;散点图能揭示变量之间的关系。这些图形类型为我们后续的NLP数据可视化打下了基础,让我们能够准确地选择合适的图形来呈现我们的分析结果。

# 2. NLTK数据可视化前的数据处理

### 2.1 数据的收集和清洗

#### 2.1.1 采集NLP数据的方法

在自然语言处理(NLP)任务中,数据是构建模型的基础。数据的采集方法多样,包括但不限于网络爬虫、API调用、数据库导出、公开数据集等。对于网络数据,我们可以使用Python库如`requests`或`BeautifulSoup`抓取网页内容,再利用`lxml`或`html.parser`进行解析。API调用则可以通过`requests`库直接获取JSON或XML格式数据。在处理API和爬虫采集的数据时,确保遵守相关网站的使用条款和抓取策略。

```python

import requests

from bs4 import BeautifulSoup

# 使用requests获取网页内容

url = "***"

response = requests.get(url)

html_content = response.content

# 使用BeautifulSoup解析网页内容

soup = BeautifulSoup(html_content, 'html.parser')

data = soup.find_all('div', class_='target-class') # 假设我们要抓取所有的div元素

```

在上述代码中,我们使用`requests.get`获取了目标网页的内容,并使用`BeautifulSoup`解析这些内容,之后通过`find_all`方法提取了具有特定class属性的div元素。

#### 2.1.2 清洗数据的策略

清洗数据旨在去除无用信息,纠正错误,并使数据结构一致,便于后续处理。常见的清洗步骤包括:

1. 移除或纠正编码错误。

2. 删除HTML标签和脚本,仅保留纯文本内容。

3. 去除无意义的符号,如HTML实体、特殊符号等。

4. 转换文本为小写,以便统一处理。

5. 移除或填充缺失值。

6. 标准化文本格式,例如,统一日期格式、货币单位等。

7. 分词和去除停用词。

### 2.2 数据的预处理和标注

#### 2.2.1 文本预处理技术

文本预处理技术通常包括:

- 分词(Tokenization):将文本分割成词或句子。

- 去除停用词(Stopword Removal):停用词如“的”、“是”等在语言中非常常见,通常不携带重要信息。

- 词干提取或词形还原(Stemming/Lemmatization):将词还原为基本形式。

- 词性标注(POS Tagging):给每个词标记其在句子中的词性。

- 向量化(Vectorization):将文本转换为数值形式,便于机器学习算法处理。

```python

from nltk.tokenize import word_tokenize, sent_tokenize

from nltk.corpus import stopwords

from nltk.stem import WordNetLemmatizer

nltk.download('punkt')

nltk.download('stopwords')

nltk.download('wordnet')

nltk.download('averaged_perceptron_tagger')

# 分词示例

text = "NLTK is a leading platform for building Python programs to work with human language data."

word_tokens = word_tokenize(text)

# 去除停用词示例

stop_words = set(stopwords.words('english'))

filtered_words = [w for w in word_tokens if not w.lower() in stop_words]

# 词形还原示例

lemmatizer = WordNetLemmatizer()

lemmatized_words = [lemmatizer.lemmatize(w) for w in filtered_words]

# 词性标注示例

tagged = nltk.pos_tag(lemmatized_words)

```

#### 2.2.2 使用NLTK进行文本标注

NLTK(Natural Language Toolkit)是一个强大的Python库,专门用于处理人类语言数据。使用NLTK进行文本标注包括给文本数据打上各种标记(如名词、动词等)。NLTK库中包含有预训练的词性标注器,可以很方便地应用于NLP任务。

```python

# 使用NLTK进行词性标注

tagged = nltk.pos_tag(lemmatized_words)

print(tagged)

```

### 2.3 数据集的构建和特征工程

#### 2.3.1 构建NLP数据集的步骤

构建NLP数据集通常遵循以下步骤:

1. 选定目标问题和数据集规模。

2. 数据采集,可能需要自定义采集策略。

3. 数据清洗,包括去除无关数据、纠正格式、填补缺失值。

4. 文本预处理,包括分词、词性标注等。

5. 标注数据,为监督学习任务创建标签。

6. 数据集划分,将数据集分为训练集、验证集和测试集。

```python

from sklearn.model_selection import train_test_split

# 将数据集分为训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(lemmatized_words, tags, test_size=0.2)

```

#### 2.3.2 特征提取与转换方法

特征提取是将文本转化为数值向量的过程。常用的特征提取方法包括:

- 词袋模型(Bag of Words):将文本转换为词频向量。

- TF-IDF(Term Frequency-Inverse Document Frequency):通过词频和逆文档频率的乘积衡量词汇重要性。

- Word Embeddings:使用预训练词向量如Word2Vec或GloVe,将词映射到稠密向量空间。

```python

from sklearn.feature_extraction.text import TfidfVectorizer

# 使用TF-IDF方法转换文本数据

vectorizer = TfidfVectorizer()

X_train_tfidf = vectorizer.fit_transform(X_train)

X_test_tfidf = vectorizer.transform(X_test)

```

以上步骤和代码仅作为示例,实际操作中还需要对数据集进行详细分析,并根据具体情况进行调整。NLP数据处理和特征工程是构建模型前至关重要的一步,它直接影响到后续模型的性能和准确性。

# 3. NLTK实现的基础数据可视化

## 3.1 基于文本的可视化方法

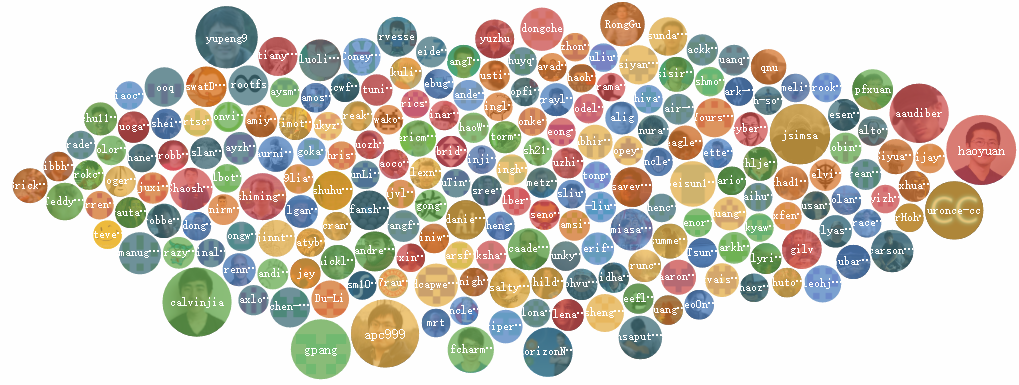

### 3.1.1 文本云和词频图的生成

在NLP(自然语言处理)中,文本云(word cloud)和词频图是两种常用且直观的数据可视化方法。它们可以快速揭示文本数据中最常见的词汇及其频率,从而为后续的

0

0