【解读diffusion模型中的数据收集与处理】: 解读diffusion模型中的数据收集与处理方法

发布时间: 2024-04-20 13:43:36 阅读量: 91 订阅数: 68

# 1. diffustion模型概述

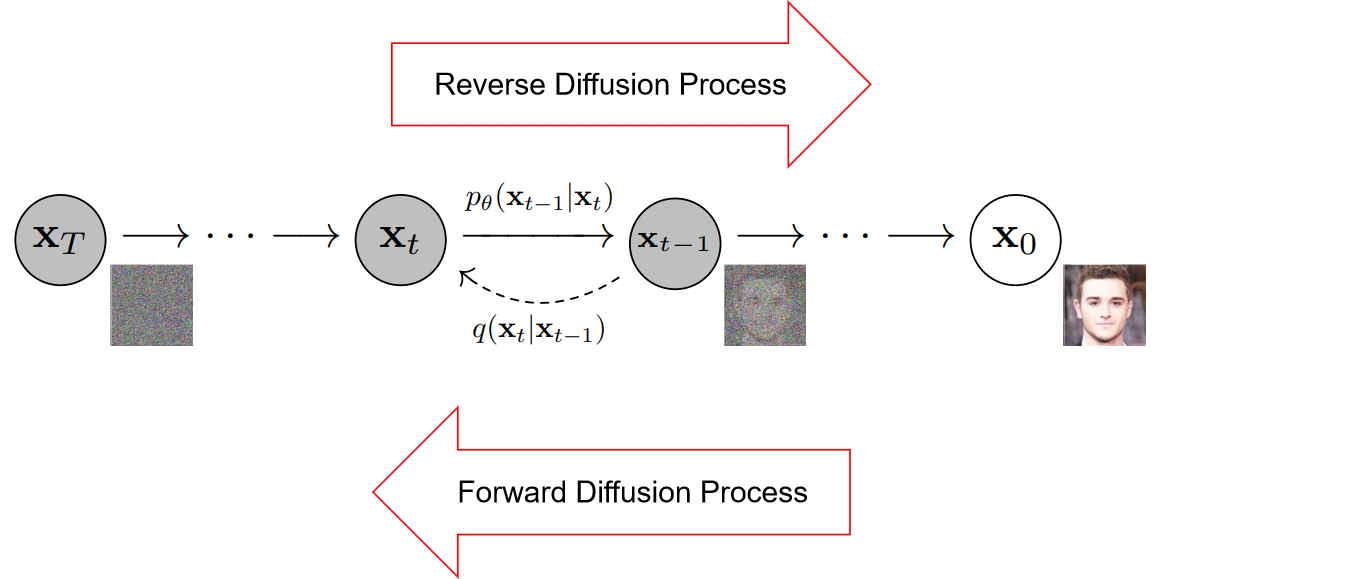

扩散模型,又称扩散过程模型,是一种抽象的数学模型,用于研究在空间中传播的现象。在这种模型中,节点代表个体或者事物,边代表它们之间的关系或者联系,而模型的目标则是研究信息、疾病、文化等在网络中的传播规律。通过了解扩散模型,我们可以更好地理解信息在社交网络中的传播路径,为后续的数据收集、处理和分析提供基础。在撰写文章时,我们需要阐明扩散模型的基本原理、应用场景和研究意义,使读者对后续内容有清晰的认识和期待。

# 2. 数据收集

数据收集是数据分析的第一步,合适的数据源选择以及有效的数据采集技术对后续数据处理和分析至关重要。

### 2.1 数据源选择

在进行数据收集之前,我们需要考虑数据源的选择,包括内部数据源和外部数据源。

#### 2.1.1 内部数据源

内部数据源指的是组织内部已有的数据,可以是数据库、日志文件、应用程序输出的数据等。这些数据通常包含了组织内部的核心信息,对于进行业务分析非常有帮助。

#### 2.1.2 外部数据源

外部数据源则是指从外部获取数据,比如公开数据集、开放API、互联网上的数据等。外部数据源可以帮助我们拓展数据来源,获取更全面的信息。

### 2.2 数据采集技术

数据采集技术包括了抓取爬取技术和API接口获取,根据不同的数据源选择合适的采集技术是关键。

#### 2.2.1 抓取爬取技术

抓取爬取技术通过爬虫程序从网页中抓取信息,常见的工具有Python中的Scrapy、BeautifulSoup等。使用抓取爬取技术可以获取互联网上的数据信息。

```python

# 示例代码:使用Scrapy爬取网页信息

import scrapy

class MySpider(scrapy.Spider):

name = 'example'

start_urls = ['http://example.com']

def parse(self, response):

# 提取信息的逻辑代码

pass

```

#### 2.2.2 API接口获取

许多网站和服务提供API接口,通过调用API接口可以方便地获取数据。使用API接口获取数据可以获得结构化的信息,减少数据清洗的工作。

```python

# 示例代码:使用Requests库调用API接口

import requests

url = 'https://api.example.com/data'

response = requests.get(url)

data = response.json()

```

### 2.3 数据清洗与整理

数据采集回来的数据往往包含了噪音和不规范的信息,数据清洗与整理是为了让数据变得更加结构化和清晰。

#### 2.3.1 缺失值处理

缺失值是数据中常见的问题,我们需要考虑如何处理缺失值,可以选择删除缺失值、填充缺失值等方法。

#### 2.3.2 异常值处理

异常值可能会对数据分析结果产生影响,因此需要对异常值进行识别和处理,可以采用统计方法或者规则方法来处理异常值。

通过以上步骤,我们可以完成对数据的收集工作,并为后续的数据处理和分析做好准备。

# 3. 数据处理

### 3.1 数据预处理

数据预处理在数据处理过程中扮演着至关重要的角色,可确保数据质量,为后续分析和建模奠定基础。以下是数据预处理的具体步骤:

#### 3.1.1 数据去重

数据去重是清洗数据的一项重要任务,可以消除数据集中的重复记录,避免对分析结果造成干扰。以下是数据去重的代码示例:

```python

# 导入pandas库

import pandas as pd

# 加载数据集

data = pd.read_csv('data.csv')

# 去重处理

data.drop_duplicates(inplace=True)

```

通过以上代码,我们使用了 Pandas 库加载数据集,并对数据集进行了去重处理。

#### 3.1.2 数据归一化

数据归一化是将不同维度、不同量纲的数据统一到相同的尺度上,以避免模型受到特征间不同量纲的影响。以下是数据归一化的代码示例:

`

0

0