AUC深度分析:不平衡数据集中如何调整与表现

发布时间: 2024-11-21 10:08:18 阅读量: 26 订阅数: 29

# 1. AUC的基本概念和重要性

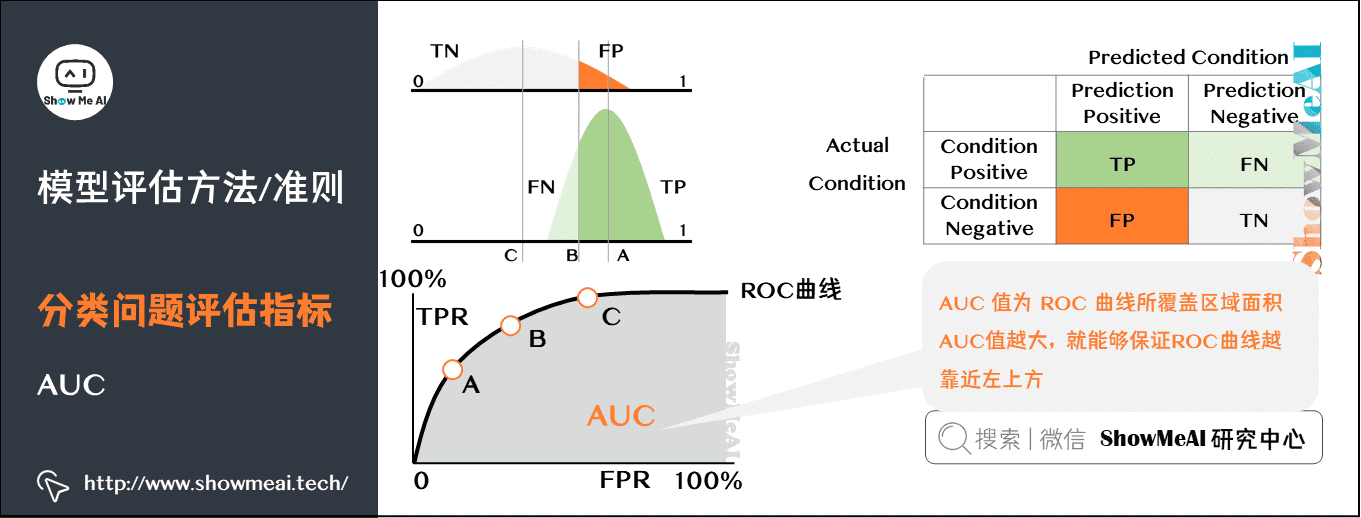

在机器学习领域,模型性能的评估至关重要,AUC(Area Under the Curve)是一种广泛使用的评价标准,它与ROC曲线紧密相关。AUC值衡量的是模型对正负样本的分类能力,特别是对于二分类问题,AUC值提供了一个在不同分类阈值下的综合评价指标。一个高AUC值表明模型能够较好地将正类和负类分离开来,因此,它成为衡量分类器性能的一个重要指标,尤其是在不平衡数据集中的表现尤为关键。

## 1.1 AUC的定义和计算原理

AUC代表了在随机选择一个正样本和一个负样本的情况下,分类器能正确判断出哪一个样本属于正类的概率。计算AUC时,通常会生成一个ROC曲线(Receiver Operating Characteristic Curve),这条曲线的横轴是假正例率(False Positive Rate, FPR),纵轴是真正例率(True Positive Rate, TPR)。AUC值是通过计算ROC曲线下面积来获得的。

## 1.2 AUC的重要性

在数据不平衡的情况下,传统的准确率(Accuracy)等指标往往不能真实反映模型的性能,因为即使模型仅仅预测样本为多数类,也可能获得较高的准确率。AUC由于关注了不同分类阈值下的性能表现,能够提供更为全面的模型评估。特别是在数据科学竞赛、风险评估等领域,AUC的高低往往直接关系到模型的竞争力和决策的有效性。

# 2. 不平衡数据集的挑战

## 2.1 不平衡数据集的定义和影响

### 2.1.1 数据不平衡的类型和特征

在机器学习领域,数据不平衡是指不同类别的样本数量存在显著差异。这种不平衡可以分为两类:全局不平衡和局部不平衡。

- **全局不平衡**指的是整体数据集中的类别分布不均衡。例如,在一个二分类问题中,如果正类样本有1000个,而负类样本仅有100个,则称这个数据集是全局不平衡的。

- **局部不平衡**则发生在数据集的局部区域,意味着即使总体上类别分布均匀,但在某些局部区域内,类别分布可能会表现出显著的不平衡。这种情况在样本空间的划分不均匀时尤为常见。

### 2.1.2 数据不平衡对模型性能的影响

数据不平衡对模型性能的影响主要体现在以下几个方面:

1. **准确性评估失效**:在不平衡数据集中,模型倾向于预测多数类,导致少数类的预测性能被低估,这使得准确率等常规评估指标变得不准确。

2. **模型偏差**:传统的机器学习算法往往假设数据分布是平衡的,不平衡数据会使得模型偏向多数类,导致少数类分类性能下降。

3. **训练困难**:不平衡数据集上训练模型时,模型难以捕捉到少数类的特征,因此,对于少数类的预测准确性会降低。

## 2.2 不平衡数据集的识别和评估

### 2.2.1 识别不平衡数据集的方法

识别数据集是否不平衡,可以采用以下几种方法:

- **直观分析**:通过绘制各类别样本数量的柱状图,可以直观地看出数据集是否平衡。

- **计算比例**:计算每个类别的样本数占总样本数的比例,如果比例差异较大,则数据集不平衡。

- **统计测试**:例如卡方检验,可以用来判断样本是否是随机分布的。

### 2.2.2 不平衡数据集的评估指标

评估不平衡数据集的影响,通常使用以下指标:

- **精确率(Precision)**:模型预测为正类的样本中实际为正类的比例。

- **召回率(Recall)**:模型实际预测为正类的样本占实际正类样本总数的比例。

- **F1 分数**:精确率和召回率的调和平均数,用于衡量模型的平衡性。

## 2.3 不平衡数据集的处理方法

### 2.3.1 重采样技术

重采样技术是处理不平衡数据集的一种常用方法,包括欠采样和过采样。

- **欠采样(Undersampling)**:减少多数类样本的数量,使多数类样本数量与少数类相匹配。

- **过采样(Oversampling)**:增加少数类样本的数量,使少数类样本数量与多数类相匹配。

### 2.3.2 修改分类阈值

在模型预测时,通过调整决策阈值来提高对少数类的识别。例如,在二分类问题中,通常以0.5作为阈值,将预测概率大于0.5的样本判定为正类。若调整阈值至较低值,则可以增加正类的判定,从而提高召回率。

### 2.3.3 成本敏感学习

成本敏感学习方法考虑了每个类别错误分类的代价,通过为不同类别赋予不同的权重来调整模型学习过程。通常,少数类错误分类的代价会设定得更高,从而使得模型更加重视少数类的预测。

下一章:AUC在不平衡数据集中的调整方法

# 3. AUC在不平衡数据集中的调整方法

在机器学习中,AUC是评价模型性能的重要指标,尤其在不平衡数据集中,它能够提供比准确率更加客观的性能评估。但是,AUC本身并非直接针对不平衡数据集进行优化,因此,当面对这类数据时,我们可能需要调整AUC的计算方法或者调整数据本身来获得更加可靠的结果。

## 3.1 AUC的计算原理

### 3.1.1 ROC曲线与AUC的定义

ROC曲线(Receiver Operating Characteristic)是基于真正率(True Positive Rate, TPR)和假正率(False Positive Rate, FPR)绘制而成。它通过将不同分类阈值下的TPR和FPR绘制成曲线,能够直观地展示模型的分类性能。每个点代表了一个特定的分类阈值。

AUC(Area Under Curve)是ROC曲线下的面积,取值范围为[0,1],值越大表示模型性能越好。AUC可以视为在不同阈值下模型正确分类正负样本的概率。

### 3.1.2 AUC的计算方法和特点

AUC的计算通常采用梯形法,通过将ROC曲线下的面积分成若干梯形,再将各梯形面积相加得到。此外,AUC对样本的排序能力有很好的表示,即便在类别分布极不平衡的情况下,也能够反映模型的排序质量。

AUC的主要特点包括类别不敏感,即使类别不平衡,它仍能够提供一致的性能评价。但其不足在于不考虑预测概率的具体值,无法反映出预测为正的样本中有多少是正类。

## 3.2 调整AUC的策略

### 3.2.1 欠采样和过采样的AUC调整

在不平衡数据集中,调整数据集的平衡性是改善AUC的重要策略。欠采样和过采样是两种常用的方法。欠采样是减少多数类样本的数量,而过采样是增加少数类样本的数量,两者都是为了达到正负样本的平衡。

在应用欠采样时,AUC通常会得到改善,因为模型不再过度偏向多数类。而过采样则通过增加少数类样本来提高模型对少数类的识别能力。需要注意的是,过采样可能会引入过拟合的风险。

### 3.2.2 集成学习与AUC调整

集成学习是将多个模型的预测结果结合起来进行最终决策。在不平衡数据集的处理中,可以使用集成学习来提高AUC。典型的集成方法包括Bagging和Boosting。

Bagging通过自助抽样(bootstrap sampling)创建多个训练集,可以降低过拟合的风险,并可能改善AUC。Boosting方法通过重点关注之前模型分类错误的样本来提高少数类的识别率,也有助于AUC的提升。

### 3.2.3 损失函数与AUC调整

在模型训练的过程中,损失函数的选择直接影响模型的优化方向。针对不平衡数据集,可以调整损失函数来优化AUC。

例如,可以使用加权的交叉熵损失函数,给予少数类更高的权重,使得模型在训练时更加关注少数类。另外,可以使用Focal Loss等设计来减少易分类样本的损失贡献,增加难分类样本的权重,从而调整AUC。

## 3.3 AUC调整的实践技巧

### 3.3.1 实际案例分析

在实际操作中,我们会遇到多种多样的不平衡数据集,每个数据集的情况都可能不同,这就需要我们对数据集进行深入的分析。下面是一个案例分析:

假设有一个信用卡欺诈检测的数据集,数据集中正样本(欺诈)只有千分之一,是一个典型的不平衡数据集。我们首先需要识别数据集的不平衡情况,可以使用如下Python代码来分析正负样本的比例:

```python

impor

```

0

0