比较AUC与其他性能指标:掌握其重要性的关键

发布时间: 2024-11-21 10:11:01 阅读量: 5 订阅数: 14

# 1. AUC的定义和计算方法

## 1.1 AUC的定义

AUC,全称为Area Under Curve,是评估分类模型性能的重要指标之一。它代表了在不同阈值下,模型将正类和负类区分开的能力。

## 1.2 AUC的计算方法

计算AUC通常涉及绘制一个ROC曲线(Receiver Operating Characteristic曲线),该曲线下的面积即为AUC值。ROC曲线通过改变阈值来获得不同的真正例率(TPR)和假正例率(FPR),而AUC值就是这些点构成的曲线下的面积。

在实际计算中,可以通过`scikit-learn`库中的`roc_auc_score`函数,传入模型预测的概率和真实标签,直接计算AUC值。

```python

from sklearn.metrics import roc_auc_score

# 假设y_true是真实的标签,y_score是模型预测的概率

y_true = [1, 0, 1, 1, 0]

y_score = [0.9, 0.2, 0.8, 0.3, 0.6]

roc_auc = roc_auc_score(y_true, y_score)

print(f'AUC Value: {roc_auc}')

```

AUC值的范围是0到1,值越高,表示模型的分类性能越好。

# 2. AUC与其他性能指标的比较

## 2.1 AUC与准确率的比较

### 2.1.1 准确率的定义和计算方法

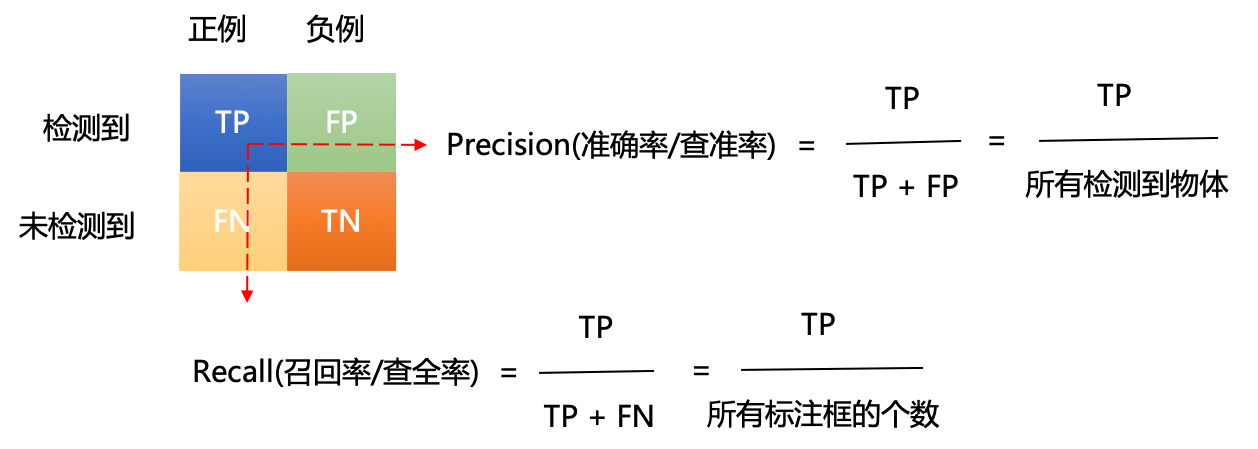

准确率(Accuracy)是分类问题中最直观也是最常用的性能指标之一,它表示模型正确预测的样本数占总样本数的比例。准确率的计算公式如下:

```

准确率 = (真正例 + 真负例) / (真正例 + 假正例 + 真负例 + 假负例)

```

其中,真正例(True Positives, TP)是被正确预测为正类的样本数,真负例(True Negatives, TN)是被正确预测为负类的样本数,假正例(False Positives, FP)是被错误预测为正类的样本数,假负例(False Negatives, FN)是被错误预测为负类的样本数。

### 2.1.2 AUC与准确率的优缺点比较

AUC(Area Under the Curve)是指在接收者操作特征曲线(ROC Curve)下的面积,它衡量了模型在不同阈值下预测正类的能力。与准确率相比,AUC对不平衡数据更加鲁棒。

准确率的优点在于简单易懂,直观反映了模型的预测准确性。然而,准确率在数据不平衡的情况下可能存在误导性。例如,在正负样本比例严重失衡的情况下,即使模型总是预测样本为多数类(负类),也能获得较高的准确率,但这样的模型实际上并没有很好地识别出少数类(正类)。

相比之下,AUC是一个更全面的指标,它考虑了所有可能的分类阈值,并且可以直观地通过ROC曲线来展示模型的性能。AUC不会因为样本分布的不同而产生太大波动,因此它能更好地评估模型的泛化能力。

## 2.2 AUC与召回率的比较

### 2.2.1 召回率的定义和计算方法

召回率(Recall),又称敏感性(Sensitivity)或真正率(True Positive Rate, TPR),表示模型识别出的正类样本占实际正类样本的比例。召回率的计算公式如下:

```

召回率 = 真正例 / (真正例 + 假负例)

```

召回率关注的是模型对正类的识别能力,特别是对于正类样本的覆盖情况,这在医疗诊断、欺诈检测等领域尤为重要。

### 2.2.2 AUC与召回率的优缺点比较

召回率的高值表示模型能够有效地识别出正类样本,但有时候会以牺牲精确度(Precision)为代价,即模型可能将一些负类样本错误地识别为正类。高召回率可能伴随高假正率。

AUC与召回率相比,对模型的整体性能进行评价,不关注单一的阈值选择,而是通过ROC曲线反映出模型在不同阈值下的性能。AUC考虑了真正例和假正例的比例关系,是对模型整体性能的度量,而不仅仅是单一阈值下的表现。

## 2.3 AUC与F1分数的比较

### 2.3.1 F1分数的定义和计算方法

F1分数是精确度(Precision)和召回率(Recall)的调和平均数,用于平衡二者的性能。其计算公式如下:

```

F1分数 = 2 * 精确度 * 召回率 / (精确度 + 召回率)

```

其中,精确度(Precision)表示模型预测为正类的样本中真正为正类的比例,计算公式为:

```

精确度 = 真正例 / (真正例 + 假正例)

```

F1分数是一个综合指标,它在精确度和召回率之间取得了平衡,适用于正负样本分布不均衡的情况。

### 2.3.2 AUC与F1分数的优缺点比较

F1分数对不平衡数据集的适应性比准确率和召回率要好,但其仍然受阈值选择的影响。也就是说,F1分数只能反映单一阈值下的性能,而不是在所有可能阈值下的平均性能。

AUC作为对模型整体性能的衡量,在评估分类模型方面具有优势,它不需要预先设定阈值,可以全面反映模型在不同阈值下的表现。尽管如此,F1分数在特定阈值下调整模型性能方面仍然具有实用价值,特别是在需要同时考虑精确度和召回率的场景中。

AUC和F1分数都可以作为评估模型性能的指标,选择哪一个取决于具体的应用场景和需求。在一些情况下,可能需要综合考虑多个指标来评估模型的全面性能。

# 3. AUC在实际应用中的重要性

在了解了AUC的定义、计算方法以及与其他性能指标的比较之后,我们将探讨AUC在实际应用中的重要性。AUC不仅是一种衡量模型性能的有效工具,而且在分类问题和排序问题中扮演着关键角色。接下来,我们将深入挖掘AUC在这些问题中的应用和优势。

## 3.1 AUC在分类问题中的应用

### 3.1.1 分类问题的定义和重要性

分类问题是机器学习中最常见和最基础的问题之一,它的目标是将实例数据分配到两个或更多个类别中。在众多分类任务中,如何区分正负样本是核心挑战。分类问题在众多领域中有着广泛的应用,如垃圾邮件检测、疾病诊断、信用评估等。

0

0