AUC在深度学习中的角色:神经网络性能评估的实战指南

发布时间: 2024-11-21 10:59:51 阅读量: 9 订阅数: 14

# 1. AUC的基础概念和重要性

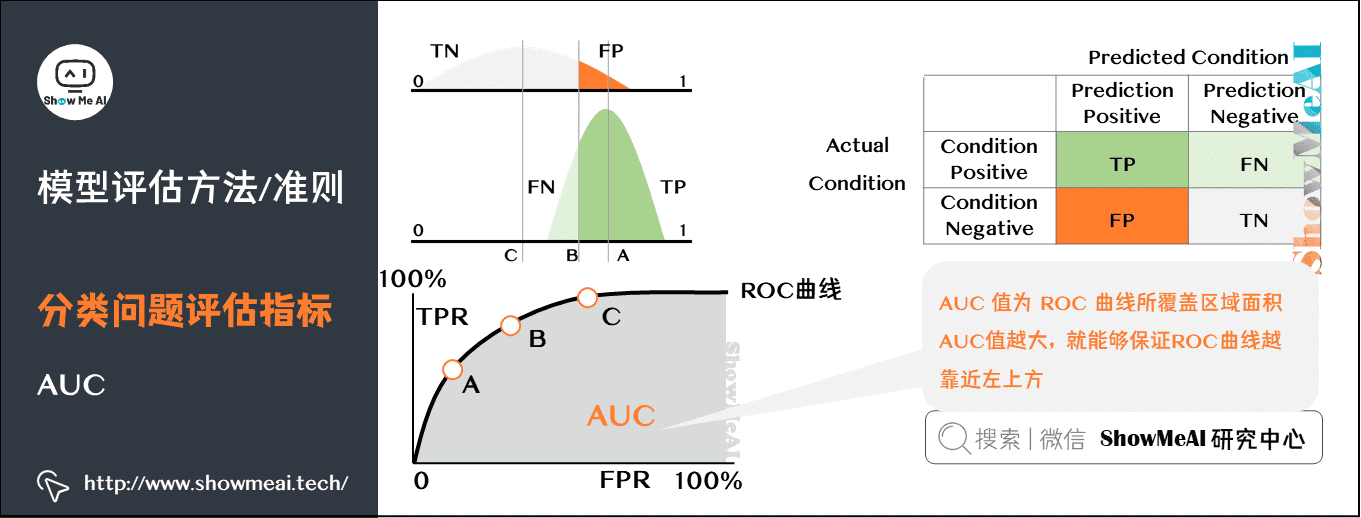

在机器学习和数据挖掘领域,AUC(Area Under the Curve)作为评估分类模型性能的关键指标之一,其重要性不言而喻。AUC值衡量的是在所有可能的正负样本对中,模型能够正确区分的概率。换言之,AUC表征了模型对正样本给予更高预测分数的概率。不仅限于二分类问题,多分类问题中也能通过处理为二分类来计算AUC。本章将介绍AUC的定义、计算方法,以及为何在诸多评价指标中,AUC显得尤为重要。

# 2. 理解AUC-ROC曲线

## 2.1 AUC-ROC曲线的理论基础

### 2.1.1 曲线的构成和解读

ROC曲线(Receiver Operating Characteristic Curve)是评估二分类问题中分类模型性能的一种重要工具。它通过在不同阈值下计算真正率(True Positive Rate, TPR)和假正率(False Positive Rate, FPR)来构建。ROC曲线上的每个点表示了模型在特定阈值下的TPR和FPR。理想的分类器,即完美区分正负样本的分类器,其ROC曲线会紧贴左上角,而随机猜测的分类器的ROC曲线则会贴近45度对角线。AUC值,即ROC曲线下面积,可以量化模型的分类能力。

### 2.1.2 AUC值的统计学意义

AUC(Area Under Curve)值是一种评估模型性能的方法,它的值介于0和1之间。AUC值越接近1,表示模型的分类能力越强;越接近0.5,表明模型性能接近随机猜测。当AUC值大于0.7时,通常认为模型表现良好;AUC值高于0.9则表示模型性能优秀。值得注意的是,AUC值只在两个类别分布具有统计意义时才有价值,如果样本极度不平衡,则可能需要结合其他指标一起评估模型性能。

## 2.2 AUC-ROC曲线的计算方法

### 2.2.1 真正率和假正率的计算

真正率(TPR)和假正率(FPR)是ROC曲线的两个基础指标。计算公式如下:

- 真正率(TPR)= 真正例数量 / (真正例数量 + 假反例数量)

- 假正率(FPR)= 假正例数量 / (假反例数量 + 真反例数量)

其中,真正例和假正例是基于模型预测的二分类结果计算得出,而真正例数量加上假反例数量等于正类别的总数,假正例数量加上真反例数量等于负类别的总数。

### 2.2.2 曲线下面积的计算

AUC值是通过计算ROC曲线下方的面积来获得的。这个面积可以通过梯形法则或者数值积分的方式求得。如果使用梯形法则,其基本原理是将ROC曲线下的面积分割成若干个小梯形,计算每个梯形的面积然后求和。

### 2.2.3 使用Python中的sklearn计算AUC

在Python中,我们可以使用`sklearn`库来计算ROC曲线和AUC值。以下是一个使用`sklearn`计算AUC的代码示例:

```python

import numpy as np

from sklearn.metrics import roc_curve, auc

import matplotlib.pyplot as plt

# 假设y_true是真实的标签,y_score是模型预测的概率

y_true = np.array([1, 0, 1, 0, 1])

y_score = np.array([0.9, 0.3, 0.8, 0.4, 0.6])

# 计算ROC曲线

fpr, tpr, thresholds = roc_curve(y_true, y_score)

# 计算AUC值

roc_auc = auc(fpr, tpr)

# 绘制ROC曲线

plt.figure()

plt.plot(fpr, tpr, color='darkorange', lw=2, label='ROC curve (area = %0.2f)' % roc_auc)

plt.plot([0, 1], [0, 1], color='navy', lw=2, linestyle='--')

plt.xlim([0.0, 1.0])

plt.ylim([0.0, 1.05])

plt.xlabel('False Positive Rate')

plt.ylabel('True Positive Rate')

plt.title('Receiver Operating Characteristic')

plt.legend(loc="lower right")

plt.show()

```

在这段代码中,`roc_curve`函数用于生成ROC曲线上的点,`auc`函数用于计算这些点形成的曲线下面积,即AUC值。通过绘制ROC曲线,我们可以直观地看到模型的性能表现,并通过AUC值进行量化评估。

# 3. AUC在深度学习中的计算和应用

深度学习已成为机器学习领域的强大工具,广泛应用于图像识别、语音识别、自然语言处理等多个领域。在这些任务中,深度学习模型的性能评估是一个重要环节。AUC(Area Under Curve,曲线下面积)作为评估模型性能的一种指标,在深度学习中尤其受到重视。本章节将详细探讨AUC在深度学习模型中的计算和应用,同时提供实践指导和案例分析。

## 3.1 深度学习模型中的性能评估

在深度学习中,模型的性能评估与传统的机器学习模型评估有所区别,主要是因为深度学习模型的复杂性和高维特征。以下是几个关键点的深入探讨。

### 3.1.1 分类问题和评估指标

在深度学习领域,分类问题尤为常见,如二分类、多分类等。对于这些任务,常用评估指标包括准确率(Accuracy)、精确率(Precision)、召回率(Recall)、F1分数(F1 Score)等。这些指标虽然重要,但它们都无法全面地反映模型在不同阈值下的性能。

### 3.1.2 AUC在深度学习中的角色和应用

AUC是一个不依赖于分类阈值的指标,它通过ROC曲线(Receiver Operating Characteristic curve)来评估模型的分类性能。AUC值接近1表示模型的预测性能越好。在深度学习中,尤其是在处理具有不平衡数据集时,AUC可以为模型提供更加全面和公平的评估。

## 3.2 实践:深度学习模型的AUC计算

### 3.2.1 使用TensorFlow计算AUC

TensorFlow是深度学习领域的一个常用框架,其提供了直接计算AUC的方法。

```python

import tensorflow as tf

# 假设我们有一个模型的预测结果和真实标签

# predictions是模型的预测概率,labels是真实的0/1标签

predictions = tf.constant([0.2, 0.8, 0.4, 0.6])

labels = tf.constant([0, 1, 1, 0])

# 使用tf.metrics.auc来计算AUC值

auc, update_op = tf.metrics.auc(labels, predictions, num_thresholds=200)

# 初始化全局变量

init_op = tf.group(tf.local_variables_initializer(), tf.global_variables_initializer())

# 使用会话来运行模型

with tf.Session() as sess:

sess.run(init_op)

sess.run(update_op)

print("AUC is:", auc.eval())

```

此代码块中的`tf.metrics.auc`函数计算了预测结果和真实标签之间的AUC值。`num_thresholds`参数定义了曲线下的阈值数量,决定了曲线的精度。

### 3.2.2 使用PyTorch计算AUC

PyTorch是另一个流行的深度学习框架,它同样支持AUC的计算。以下是如何在PyTorch中计算AUC的示例。

```python

import torch

from sklearn.metrics import roc_auc_score

# 假设我们有一个模型的预测结果和真实标签

# predictions是模型的预测概率,labels是真实的0/1标签

predictions = torch.tensor([0.2, 0.8, 0.4, 0.6], dtype=torch.float32)

labels = torch.tensor([0, 1, 1, 0], dtype=torch.float32)

# 使用sklearn中的roc_auc_score来计算AUC值

a

```

0

0