AUC在特征选择中的作用:如何提升模型预测能力

发布时间: 2024-11-21 10:45:21 阅读量: 24 订阅数: 24

# 1. AUC指标的理论基础

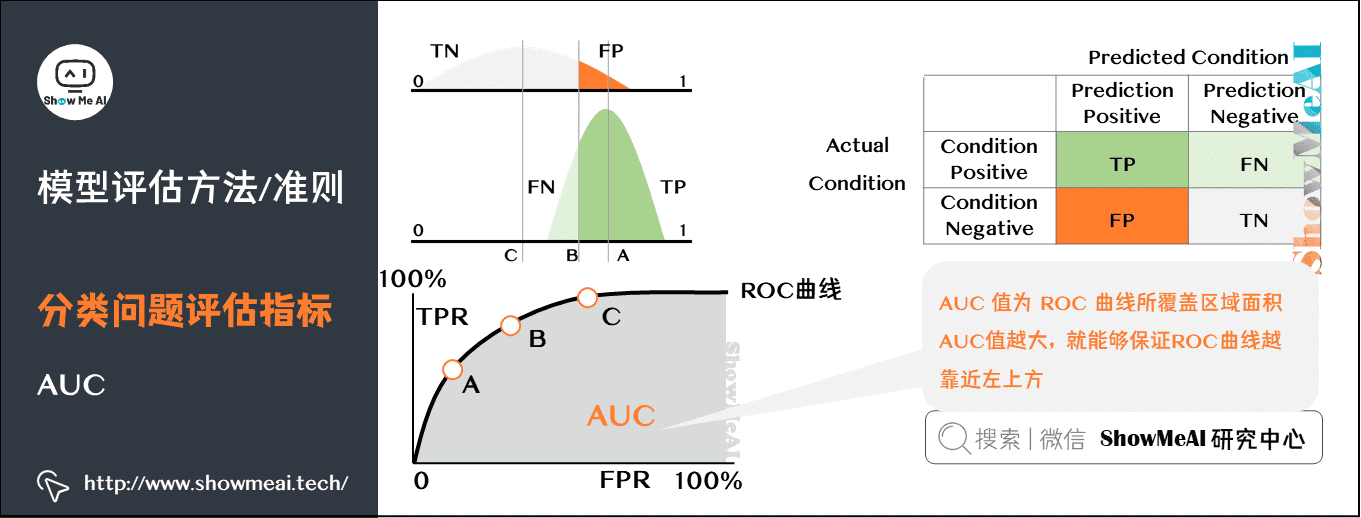

在机器学习和数据挖掘领域,模型的评估和选择是至关重要的一环。在这其中,AUC(Area Under the Curve)作为一个评估分类性能的关键指标,被广泛应用在多种场景中。AUC值的大小能够直观地反映一个分类模型对于正负样本的区分能力,其值域在0到1之间,值越高表示模型区分能力越强。

## 1.1 AUC指标的定义和数学基础

AUC是ROC曲线(Receiver Operating Characteristic Curve)下的面积,ROC曲线本身是一个描述真阳性率(True Positive Rate, TPR)与假阳性率(False Positive Rate, FPR)之间关系的工具。AUC值通过量化ROC曲线下方的面积,提供了单一数值来评价分类器的整体性能。理想状态下,一个完美的分类器的ROC曲线将穿过左上角,其AUC值为1;而一个随机分类器的AUC值则为0.5。

## 1.2 AUC指标的优势与应用场景

与准确率、精确率和召回率等其他指标相比,AUC的优势在于它能够综合考虑不同阈值下的分类性能,对不平衡数据集的分类任务也具有良好的评估效果。因此,AUC特别适用于那些对假正例和假负例的代价不同的场景,例如在疾病诊断、欺诈检测和金融信贷审核等领域中,AUC的应用尤为广泛。

随着数据量的增加和数据复杂度的提高,AUC的重要性持续增加,它已成为评价机器学习模型性能的不可或缺的指标之一。接下来的章节中,我们将深入了解AUC指标在特征选择、模型评估和实际应用中的细节和深入应用。

# 2. 特征选择的重要性与方法论

## 2.1 特征选择的理论基础

### 2.1.1 特征选择的目的和挑战

特征选择(Feature Selection)是指从原始特征集合中选择一个特征子集的过程,其目的是去除无关特征、冗余特征以及噪声特征,从而提高模型的泛化能力、减少训练时间、提高模型的可解释性。特征选择在机器学习和数据挖掘中扮演着重要的角色,尤其在以下方面具有显著意义:

1. **提高模型精度**:去除不相关特征后,模型可以更加专注于重要的信息,进而提高预测准确率。

2. **减少模型复杂度**:精简后的特征集可以减少模型的复杂度,避免过拟合现象。

3. **加快训练时间**:特征选择可以显著减少模型训练时的计算量,提高训练效率。

4. **提高模型可解释性**:一个简洁的特征集有助于我们理解模型的决策逻辑,尤其是在金融、医疗等领域中,可解释性尤为重要。

然而,在实际操作中,特征选择面临诸多挑战:

1. **特征之间的相互依赖性**:真实数据集中特征间往往存在高度相关性,导致特征选择算法难以判断哪些特征是真正有用的。

2. **非线性关系和交互作用**:一些特征可能在与其他特征组合时才有价值,单一特征本身可能并不重要。

3. **特征维度高于样本数的情况**:在高维数据(特征数量远大于样本数量)中进行特征选择尤为复杂,容易出现维数的诅咒。

### 2.1.2 特征选择的影响因素

特征选择的成功与否受到许多因素的影响,主要包括以下几点:

1. **数据质量**:高质量的数据是特征选择成功的关键。数据中的噪声、缺失值等都会对特征选择过程造成负面影响。

2. **特征的表达能力**:特征所包含的信息量以及能否有效地表达问题的本质特征。

3. **选择方法的适用性**:不同的特征选择方法适用于不同类型的问题,选择合适的方法对于取得好的特征选择效果至关重要。

4. **模型的类型**:不同的机器学习模型对特征有不同的要求和偏好,因此模型的选择也会影响特征选择的效果。

5. **计算资源和时间限制**:特征选择的过程需要大量的计算资源和时间,资源和时间的限制往往制约着选择方法的复杂度和深度。

## 2.2 特征选择的常用方法

### 2.2.1 过滤式特征选择方法

过滤式(Filter)特征选择方法通过统计测试来选取特征,这些测试独立于任何学习算法。常见的统计测试包括卡方检验、互信息、ANOVA等。过滤式方法的主要优点是简单高效,易于实现,主要缺点是忽略了特征之间的相互作用。

以卡方检验为例,它是一种统计方法,用于检验分类变量间是否独立。其基本假设是:如果两个变量独立,则在各分类上的分布应该是一致的。因此,卡方检验可以用来评估特征和目标变量之间的关系强度。在Python中可以使用`scikit-learn`库中的`SelectKBest`类配合`chi2`检验来进行特征选择。

```python

from sklearn.feature_selection import SelectKBest, chi2

# 假设X是特征集,y是目标变量

X_new = SelectKBest(chi2, k='all').fit_transform(X, y)

```

### 2.2.2 包裹式特征选择方法

包裹式(Wrapper)特征选择方法将特征选择过程看作是机器学习模型的训练过程。它使用一个学习算法,根据特征对模型性能的影响,通过增加或删除特征来迭代地构建模型。

包裹式方法通常利用模型的预测性能作为特征选择的标准,例如递归特征消除(Recursive Feature Elimination, RFE)。该方法从所有特征开始,构建模型,并根据特征的重要性排名去掉最不重要的特征。然后重复这个过程,直到剩下的特征数达到用户设定的数目。

以下是使用RFE进行特征选择的一个示例:

```python

from sklearn.feature_selection import RFE

from sklearn.ensemble import RandomForestClassifier

# 假设X是特征集,y是目标变量

estimator = RandomForestClassifier(n_estimators=100)

selector = RFE(estimator, n_features_to_select=5, step=1)

selector = selector.fit(X, y)

# 获取选中的特征

selected_features = X.columns[selector.support_]

```

### 2.2.3 嵌入式特征选择方法

嵌入式(Embedded)特征选择方法结合了过滤式和包裹式方法的特点,它在模型训练过程中同时进行特征选择。例如,L1正则化(Lasso回归)可以直接嵌入到模型训练过程中,通过惩罚参数对特征权重进行压缩,实现特征的自动选择和模型的训练。

```python

from sklearn.linear_model import LassoCV

# 假设X是特征集,y是目标变量

lasso = LassoCV(cv=5)

lasso.fit(X, y)

# 输出每个特征的系数

print("特征的L1正则化系数:", lasso.coef_)

```

## 2.3 特征选择的性能评估

### 2.3.1 评估标准和常用指标

特征选择的性能评估主要基于模型的预测性能,包括准确率、精确率、召回率、F1分数和AUC等。其中,AUC(Area Under the Curve)作为一种重要的评估指标,对于不平衡数据集或者需要一个统一的评价标准的情况尤为重要。

在特征选择的上下文中,评估指标的选取取决于具体问题的业务需求,以及数据集的特性和特点。以下为一些常见的评估指标:

- **准确率(Accuracy)**:模型正确预测的样本数占总样本数的比例。

- **精确率(Precision)**:模型预测为正的样本中,实际为正的比例。

- **召回率(Recall)**:实际为正的样本中,模型正确预测为正的比例。

- **F1分数(F1 Score)**:精确率和召回率的调和平均数,可以平衡二者的重要性。

- **AUC(Area Under the Curve)**:ROC曲线下的面积,可以度量分类器对正负样本的区分能力。

### 2.3.2 AUC在特征选择中的应用

AUC在特征选择中的应用体现在其作为评估模型性能的一个标准,可以用于指导特征选择的方向。例如,在递归特征消除(RFE)的过程中,可以将AUC作为模型性能的评价指标,通过不断迭代选择使得AUC最高的特征子集。

具体实现时,可以通过交叉验证的方法计算每个特征子集下的平均AUC值,以此作为评估特征子集好坏的标准。在`scikit-learn`中,可以使用`cross_val_score`函数来计算交叉验证的AUC值,并结合特征选择算法进行特征筛选。

```python

from sklearn.model_selection import cross_val_score

from sklearn.ensemble import RandomForestClassifier

# 假设X是特征集,y是目标变量

estimator = RandomForestClassifier(n_estimators=100)

# 计算AUC作为评估指标

auc_scores = cross_val_score(estimator, X, y, cv=5, scoring='roc_auc')

print("交叉验证的平均AUC得分:", auc_scores.mean())

```

在上述示例中,我们使用了一个随机森林分类器来评估数据集的AUC得分,并通过交叉验证来降低过拟合的风险。通过比较不同特征子集的AUC得分,可以有效地指导特征选择过程,选取那些能够提高模型AUC得分的特征。

# 3. AUC在模型评估中的应用

在模型评估领域,AUC(Area Under Curve)是一个极为重要的性能指标,特别是在不平衡数据集的分类问题中。AUC衡量的是在所有可能的正负样本配对中,分类器能够正确区分它们的概率。本章将详细探讨AUC的计算方法,对比AUC与其他性能指标,并分析AUC在不同场景下的应用。

## 3.1 AUC指标的计算方法

### 3.1.1 ROC曲线介绍

ROC曲线是 Receiver Operating Characteristic(接收者操作特征曲线)的简称,是一种用于分类问题性能评价的工具。ROC曲线通过展示不同分类阈值下,模型对正负样本的识别能力,来进行模型性能的可视化评估。ROC曲线上的每个点表示了对应阈值下的真正类率(True Positive Rate, TPR)和假正类率(False Positive Rate, FPR)。

真正类率(TPR)也被称为“召回率”,表示模型正确预测为正的样本占实际正样本总数的比例;假正类率(FPR)表示模型错误预测为正的样本占实际负样本总数的比例。

### 3.1.2 AUC的计算过程

AUC是ROC曲线下的面积,其值介于0到1之间。理想模型的AUC值为1,表示模型能够完美地分辨出正负样本;而随机模型的AUC值为0.5,表示模型无法区分正负样本。计算AUC的方法可以分为直接积分法和梯形法等。

直接积分法是根据ROC曲线上的点,计算T-P点与F-P点之间的面积之和。梯形法则通过

0

0