Pandas在机器学习预处理中的角色:特征工程的完整攻略

发布时间: 2024-09-18 13:45:04 阅读量: 143 订阅数: 55

# 1. Pandas简介与数据预处理基础

## Pandas简介

Pandas是一个功能强大的Python数据分析库,提供了高性能、易于使用的数据结构和数据分析工具。它允许快速的数据分析和预处理,是数据科学领域不可或缺的工具之一。Pandas主要的数据结构包括Series(一维数据)和DataFrame(二维数据),它们支持多种数据操作,如选择、过滤、分组、合并等。

## 数据预处理基础

数据预处理是数据分析流程中的第一步,也是至关重要的一步。预处理主要包括数据清洗、数据转换和数据规整化。数据清洗涉及处理缺失值、异常值,以及数据格式的统一。数据转换则关注于数据的类型转换,例如字符串到日期时间的转换,或者对数据进行规范化和标准化。数据规整化往往需要对数据进行重组,如重塑、透视等操作,以便于后续分析。

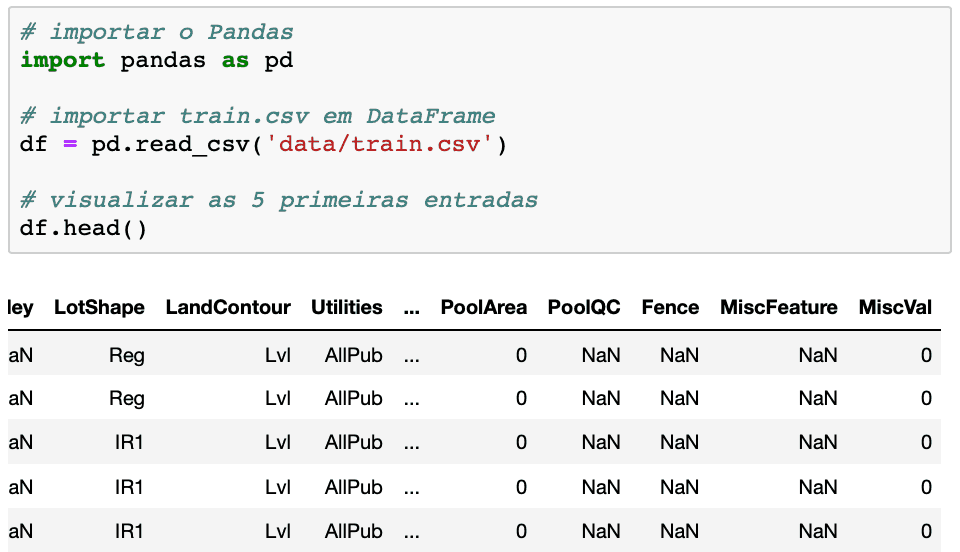

以下是一个使用Pandas进行数据预处理基础操作的简单示例:

```python

import pandas as pd

# 假设我们有一个简单的CSV文件数据

df = pd.read_csv('data.csv')

# 显示前几行数据

print(df.head())

# 简单的数据清洗操作,删除缺失值

df_cleaned = df.dropna()

# 数据类型转换,例如将字符串类型的'age'列转换为整数

df_cleaned['age'] = df_cleaned['age'].astype(int)

# 数据转换,如对某列进行标准化处理

from sklearn.preprocessing import StandardScaler

scaler = StandardScaler()

df_cleaned['age_scaled'] = scaler.fit_transform(df_cleaned[['age']])

# 展示处理后的数据

print(df_cleaned.head())

```

这个例子展示了Pandas如何加载数据、清洗缺失值、转换数据类型并进行简单的数据转换。这仅是数据预处理的冰山一角,随着数据复杂性的增加,Pandas提供了更多高级的数据预处理功能。接下来的章节中,我们将详细探讨Pandas中的数据清洗技巧,深入解析数据预处理的各个方面。

# 2. Pandas的数据清洗技巧

数据清洗是数据分析过程中一个至关重要且耗时的步骤。Pandas库提供了强大的工具来识别和处理数据集中的问题,包括缺失值、异常值和数据转换需求。在这部分中,我们将深入探讨如何使用Pandas进行高效且有效的数据清洗。

### 2.1 缺失值处理

#### 2.1.1 识别和定位缺失数据

Pandas中处理缺失数据的第一步是识别它们。Pandas提供了一些非常便捷的函数,可以帮助我们快速找到数据集中的缺失值。

```python

import pandas as pd

# 创建一个示例数据集

data = {'A': [1, 2, None, 4, 5],

'B': [None, 2, 3, None, 5],

'C': [1, None, None, 4, 5]}

df = pd.DataFrame(data)

# 检查缺失值

missing_values = df.isnull()

print(missing_values)

```

执行上述代码,我们可以得到一个布尔型DataFrame,其中`True`表示缺失值。`isnull()`方法可以快速地告诉我们哪些元素是缺失的。接下来,我们可以使用`sum()`方法得到每个列的缺失值计数。

```python

# 每列的缺失值计数

missing_count = df.isnull().sum()

print(missing_count)

```

#### 2.1.2 填充和删除缺失值的方法

识别出缺失值后,接下来我们需要决定如何处理这些缺失值。Pandas提供了多种方法来填充或者删除这些缺失值。

**填充缺失值**:通常我们使用`fillna()`方法来填充缺失值。Pandas允许我们使用一个具体的值或者用某种统计方法来填充。

```python

# 使用列的平均值填充缺失值

df_filled_mean = df.fillna(df.mean())

print(df_filled_mean)

```

**删除缺失值**:如果数据集中缺失值太多,我们可能会选择删除这些行或列。`dropna()`方法可以实现这一操作。

```python

# 删除包含缺失值的行

df_dropped = df.dropna()

print(df_dropped)

```

### 2.2 异常值处理

#### 2.2.1 异常值检测技术

异常值是那些显著偏离其他观测值的数据点,它们可能会影响数据分析的结果。在Pandas中,我们可以通过可视化或统计方法来检测异常值。

使用箱形图是一种直观的方法来识别异常值。Pandas可以与matplotlib集成来快速绘制箱形图。

```python

import matplotlib.pyplot as plt

# 绘制箱形图

df.boxplot()

plt.show()

```

异常值通常位于箱形图的“须”外,或者远低于Q1-1.5*IQR(下四分位数减去1.5倍的四分位距)或高于Q3+1.5*IQR(上四分位数加上1.5倍的四分位距)。

#### 2.2.2 处理异常值的策略

一旦识别出异常值,我们可以选择不同的策略来处理它们。一种方法是修改这些值,将其替换为某种统计数据(比如均值、中位数或众数)。另一种方法是删除包含异常值的观测。

```python

# 替换异常值为该列的中位数

df['B'] = df['B'].replace(df['B'].quantile(0.05), df['B'].median())

# 删除包含异常值的观测

# 假设异常值定义为低于第一百分位或高于第99百分位

df = df[(df > df.quantile(0.01)).all(axis=1)]

df = df[(df < df.quantile(0.99)).all(axis=1)]

```

### 2.3 数据转换和规范化

#### 2.3.1 数据类型转换

在数据预处理阶段,常常需要将数据从一种类型转换成另一种类型,比如将字符串转换为日期类型或浮点数。Pandas的`astype()`函数可以实现这一目标。

```python

# 假设'A'列原本是字符串类型,我们需要将其转换为浮点数

df['A'] = df['A'].astype(float)

```

#### 2.3.2 数据规范化与标准化

数据规范化和标准化是将数据压缩到一定范围内,或者调整其分布,以便算法能够更好地工作。例如,我们可以使用最小-最大规范化或Z-score标准化。

```python

# 最小-最大规范化

min_max_scaled = (df - df.min()) / (df.max() - df.min())

# Z-score标准化

z_score = (df - df.mean()) / df.std()

```

#### 2.3.3 类别变量的编码技术

在机器学习模型中,处理类别变量需要特别注意。我们通常需要将类别变量转换为数值型。常用的类别变量编码技术包括标签编码、独热编码和频率编码。

```python

from sklearn.preprocessing import LabelEncoder, OneHotEncoder

# 标签编码

label_encoder = LabelEncoder()

df['类别列'] = label_encoder.fit_transform(df['类别列'])

# 独热编码

onehot_encoder = OneHotEncoder()

df_encoded = onehot_encoder.fit_transform(df[['类别列']]).toarray()

```

通过本章节的介绍,我们了解了在Pandas中进行数据清洗的多种技巧,包括缺失值的处理、异常值的识别与处理,以及数据转换和规范化的方法。这些技巧能够帮助我们在数据预处理阶段构建出更优质的数据集,为后续的数据分析和模型训练打下坚实的基础。

# 3. Pandas在特征工程中的应用

### 3.1 特征构造技术

特征构造是特征工程的核心内容,通过对原始数据的转换、组合、衍生等方法,构造出对预测任务更为有用的特征。在这一部分中,我们会详细介绍如何使用Pandas进行特征构造。

#### 3.1.1 基于规则的特征生成

基于规则的特征生成是指根据领域知识或经验,设计一些规则来创建新的特征。例如,我们可以根据时间戳数据生成星期几、是否是工作日、节假日等特征。

```pyt

```

0

0