Python中的正则化技术:防止过拟合的有效策略

发布时间: 2024-12-06 16:04:37 阅读量: 12 订阅数: 17

多项式拟合 采用了L2正则化来减小过拟合的风险

# 1. 正则化技术概述

正则化技术是机器学习领域中用于防止模型过拟合、提高模型泛化能力的关键技术。在训练过程中,模型往往会过度学习训练数据的细节和噪声,导致在新数据上的表现不佳。正则化通过引入额外的约束或惩罚项,强迫模型学习更加简洁的结构,从而改善模型在未见数据上的表现。

在本章中,我们将介绍正则化的基本概念、目标和原理。我们会探讨不同类型的正则化方法,如L1和L2正则化,以及它们是如何在模型优化过程中发挥作用的。我们还将展示正则化技术的理论基础,以及它与过拟合之间的关系。

随后,我们将进入正则化技术的实际应用环节,通过Python编程语言的库函数,如scikit-learn和TensorFlow,展示如何在实践中实现和应用正则化。这一章节将为理解后续章节中正则化技术的更深层次应用打下坚实的基础。

# 2. ```

# 第二章:过拟合的基本概念和影响

## 2.1 过拟合的定义和表征

### 2.1.1 过拟合的定义

过拟合是机器学习领域中的一个常见问题,特别是在模型训练过程中。它指的是模型在训练数据上表现良好,预测准确度非常高,但是在未知的测试数据上却表现糟糕,预测准确度大幅下降。这种现象发生是因为模型学习到了训练数据中的噪声和细节,而不是潜在的、更具普遍性的数据分布。换句话说,模型变得太“依赖”于训练数据,失去了泛化能力。

### 2.1.2 过拟合的识别方法

识别过拟合的一个直观方法是在独立的验证集上评估模型性能。如果模型在训练集上的表现显著优于验证集,那么过拟合可能已经发生。更高级的方法包括绘制学习曲线(在训练集和验证集上绘制误差随训练进度的变化图)和使用正则化技术的诊断工具。一旦识别出过拟合,就需要采取措施来解决这个问题,比如增加数据量、减少模型复杂度或者应用正则化方法。

## 2.2 过拟合对模型性能的影响

### 2.2.1 泛化能力的下降

泛化能力是指模型对未见过的数据的处理能力。过拟合意味着模型在训练集上过于“专注”,导致它在面对新数据时失去了预测的准确性。过拟合的模型可能会记住训练数据中的噪声和异常值,而不是学习到数据的真实分布。这就使得模型在实际应用中变得不可靠,尤其是在数据分布变化的环境中。

### 2.2.2 预测准确性的波动

当模型过拟合时,其预测准确性会在不同的数据集上产生较大的波动。这通常是因为模型对于新数据的微小变化非常敏感。例如,在图像识别任务中,过拟合的模型可能会错误地依赖于图像中的特定像素点,而这些点在新图片中可能不具有可预测性,从而导致预测准确率的不稳定。为了使模型能够更好地泛化到新的数据集,需要采取一些方法来限制模型复杂度或增加数据的多样性。

```

在接下来的文章中,我们将深入探讨如何使用正则化技术来缓解过拟合问题,并通过具体代码实现来展示这一技术的应用。

# 3. 正则化技术的理论基础

## 3.1 正则化技术的目标和原理

### 3.1.1 正则化的目标

正则化技术的目标是通过引入额外的信息来解决机器学习模型的过拟合问题。具体来说,这些方法尝试在模型的复杂度和预测精度之间找到一个平衡点,通过增加模型对于训练数据中噪声的鲁棒性来提高模型的泛化能力。正则化通常以模型的参数范数作为惩罚项加入到损失函数中,迫使模型权重的分布向量更加平滑或稀疏,以此来减少模型复杂度。

### 3.1.2 正则化的工作原理

从数学角度来看,正则化通过向损失函数添加一个额外的项来实现其目标,即:

L(θ) = L_data(θ) + λR(θ)

其中,L_data(θ) 是标准损失函数(如均方误差或交叉熵损失),R(θ) 是正则项,通常为参数的L1或L2范数。参数 λ > 0 控制正则化强度,也就是模型复杂度的惩罚程度。

- L1正则化会导致模型参数中的一些元素变为零,使得模型具有特征选择的性质,即自动进行特征选择。

- L2正则化倾向于使参数值接近于零,但不会完全为零。它鼓励模型参数取较小的值,从而减少模型复杂度,但不会排除任何一个特征。

正则化的工作原理可以进一步从优化理论角度理解,它相当于在损失函数的等高线图中引入了摩擦力,使得梯度下降的过程更加平滑,不易于在局部最小值处停留,从而更容易找到全局最小值。

## 3.2 常用正则化方法对比

### 3.2.1 L1正则化(Lasso回归)

L1正则化,也被称为Lasso(Least Absolute Shrinkage and Selection Operator)回归,是正则化技术中的一种,它在损失函数中引入参数的绝对值之和作为惩罚项:

R(θ) = ||θ||1 = Σ|θi|

L1正则化的独特之处在于它能够产生稀疏的解,即一些参数的值可能会被优化到零,这种性质使得L1正则化在特征选择方面表现得尤为出色。它适用于当数据集特征非常多,而我们又希望减少模型复杂性并识别出关键特征时。

### 3.2.2 L2正则化(Ridge回归)

L2正则化,也被称为Ridge回归,其在损失函数中引入参数的平方和作为惩罚项:

R(θ) = ||θ||2 = Σθi²

L2正则化的惩罚项倾向于使参数值均匀缩小,而不会像L1正则化那样达到零。这种性质使得L2正则化有助于防止模型参数的过度增长,同时允许模型学习到所有特征的影响,避免了特征的完全排除。L2正则化特别适用于特征数量较多但每个特征都有一定意义时。

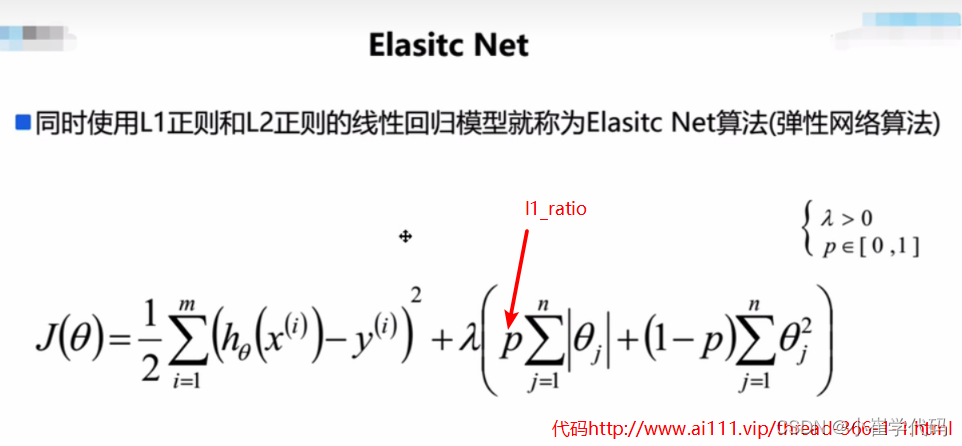

### 3.2.3 弹性网络(Elastic Net)

弹性网络是一种综合了L1和L2正则化的正则化方法,其损失函数中的惩罚项为:

R(θ) = ρ||θ||1 + (1 - ρ)||θ||2²

其中,ρ 是介于0和1之间的混合参数,它控制着L1和L2正则化项的相对重要性。弹性网络结合了L1正则化的特征选择能力和L2正则化的平滑性质,使得模型既能够进行特征选择,又能保持对噪声的鲁棒性。弹性网络在特征数量非常大,而特征之间的相关性也很高的情况下效果尤为显著。

### 正则化方法的选择与应用场景

选择合适的正则化方法对于模型性能至关重要。在实际应用中,若模型中存在大量不相关的特征,L1正则化可能是较好的选择;而在特征数量庞大但每个特征都有潜在价值时,L2正则化可能是更合适的选择。如果同时面对特征选择和特征相关性问题,则弹性网络可能是最佳折中方案。

在下文

0

0