【实战技巧】:ROC曲线与AUC值在PyTorch模型评估中的应用

发布时间: 2024-12-11 13:03:12 阅读量: 14 订阅数: 22

# 1. ROC曲线与AUC值的基本概念

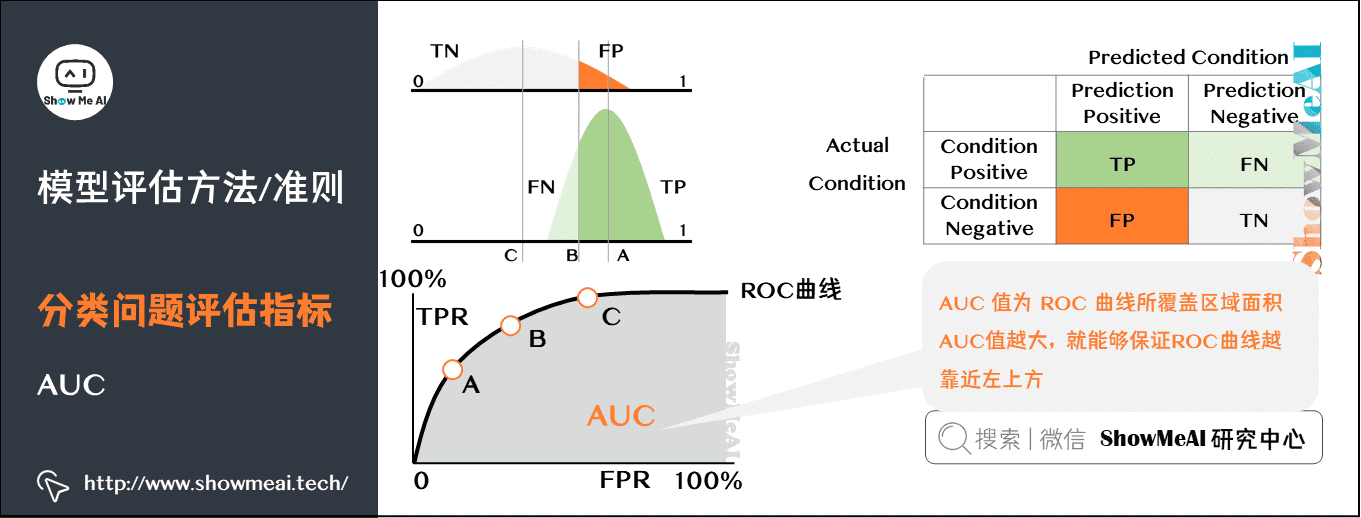

在机器学习和数据挖掘领域,模型评估是一项核心任务。ROC曲线(接收者操作特征曲线)与AUC值(曲线下面积)是评价分类模型性能的两个重要工具,尤其在不平衡数据集的场景下,它们提供了更为全面和直观的视角。

## 1.1 ROC曲线的定义与作用

ROC曲线通过绘制真正率(True Positive Rate, TPR)和假正率(False Positive Rate, FPR)在不同分类阈值下的变化,来评估模型的分类能力。它能够直观地显示不同分类阈值下模型的性能平衡,而不受类别不平衡的影响。

## 1.2 AUC值的意义

AUC值是衡量分类器性能的标尺,其取值范围在0和1之间。值越接近1,表明模型分类效果越好。AUC值实际上是对ROC曲线下的面积进行积分得出的,它为模型的性能提供了一个单一的数值指标。

在了解ROC曲线与AUC值的基础知识后,我们就可以更深入地探讨如何在PyTorch等深度学习框架中应用这些概念进行模型评估。

# 2. PyTorch模型评估基础

## 2.1 PyTorch模型评估的理论基础

### 2.1.1 模型评估的意义和方法

在机器学习模型的开发过程中,评估是一个不可或缺的环节。模型评估的意义在于确定模型在未知数据上的泛化能力,即模型对未见过的新数据的预测准确性。如果没有适当的评估方法,就无法判断模型的性能,可能会导致模型在实际应用中表现不佳,甚至完全失效。

通常,模型评估的方法依赖于具体任务的类型。对于分类任务,常用的评估指标包括准确率、精确率、召回率和F1分数等。对于回归任务,常用的评估指标包括均方误差(MSE)、均方根误差(RMSE)和平均绝对误差(MAE)等。此外,ROC曲线与AUC值作为评估二分类问题的重要指标,在众多机器学习领域,尤其是在不平衡数据集的分类问题上,具有显著的应用价值。

### 2.1.2 混淆矩阵和基本指标

混淆矩阵是一种特定的表格布局,用于可视化模型性能,特别是用于比较分类模型的预测结果与实际结果。对于二分类问题,混淆矩阵通常如下表所示:

| 模型\真实值 | 阳性 (P) | 阴性 (N) |

|------------|----------|----------|

| 预测阳性 (P) | 真阳性 (TP) | 假阳性 (FP) |

| 预测阴性 (N) | 假阴性 (FN) | 真阴性 (TN) |

基于混淆矩阵,可以计算出以下基本指标:

- 准确率 (Accuracy):正确预测的样本数占总样本数的比例。

- 精确率 (Precision):预测为正的样本中实际为正的比例。

- 召回率 (Recall) 或 真阳性率 (TPR):实际为正的样本中被预测为正的比例。

- 假阳性率 (FPR):实际为负的样本中被错误预测为正的比例。

准确率和精确率体现了模型预测的准确性和可靠性,而召回率和假阳性率则与模型预测的完整性和容忍度相关。理想情况下,我们希望这些指标都能达到最优,但在实际应用中往往需要根据具体场景进行权衡。

## 2.2 PyTorch中ROC曲线的绘制

### 2.2.1 ROC曲线的计算过程

ROC曲线全称为接收者操作特征曲线,它通过绘制不同分类阈值下假阳性率(FPR)与真阳性率(TPR)的关系图来评估分类模型的性能。ROC曲线越接近左上角,表示模型性能越好。

计算ROC曲线的过程可以分为以下几个步骤:

1. 对于给定的分类模型,计算出所有样本的概率预测值,按概率值从高到低排序。

2. 逐步提高分类阈值,对于每一个阈值,计算当前阈值下的TPR和FPR。

3. 将计算得到的(FPR, TPR)坐标点在坐标图上绘制出来。

4. 连接所有点,形成ROC曲线。

### 2.2.2 PyTorch实现ROC曲线绘制的步骤

在PyTorch中,可以使用标准库中的函数和自定义脚本来绘制ROC曲线。下面是绘制ROC曲线的基本步骤:

1. 导入必要的库:

```python

import torch

from sklearn.metrics import roc_curve, auc

import matplotlib.pyplot as plt

```

2. 假设`y_pred`为模型预测的概率值张量,`y_true`为真实标签张量(0或1):

```python

# y_true, y_pred = ...

fpr, tpr, thresholds = roc_curve(y_true, y_pred)

roc_auc = auc(fpr, tpr)

```

3. 绘制ROC曲线:

```python

plt.figure()

lw = 2

plt.plot(fpr, tpr, color='darkorange',

lw=lw, label='ROC curve (area = %0.2f)' % roc_auc)

plt.plot([0, 1], [0, 1], color='navy', lw=lw, linestyle='--')

plt.xlim([0.0, 1.0])

plt.ylim([0.0, 1.05])

plt.xlabel('False Positive Rate')

plt.ylabel('True Positive Rate')

plt.title('Receiver Operating Characteristic')

plt.legend(loc="lower right")

plt.show()

```

注意,`roc_curve`和`auc`函数是scikit-learn库提供的功能,可以很方便地与PyTorch集成使用。此外,使用matplotlib绘制ROC曲线可以帮助直观地理解模型性能。

## 2.3 AUC值的计算与解读

### 2.3.1 AUC值的含义及其重要性

AUC值即ROC曲线下的面积,它提供了一个单一的数值来量化模型的整体性能。AUC值的范围从0到1,其中:

- AUC值为0.5表示模型的预测效果与随机猜测一样;

- AUC值为1表示模型可以完美地区分两类样本;

- AUC值介于0.5到1之间表示模型的分类能力优于随机猜测。

AUC值的重要性在于,它不依赖于具体的分类阈值,因此可以作为评价模型整体性能的有效指标。对于二分类问题,特别是在样本不均衡的情况下,AUC值具有很好的鲁棒性。

### 2.3.2 PyTorch中的AUC值计算方法

在PyTorch中,通常利用scikit-learn库来计算AUC值。以下是一个计算AUC值的简单示例:

```python

import torch

from sklearn.metrics import roc_auc_score

# 假设y_true是包含真实标签的张量(0或1),y_pred是模型预测的概率值张量

y_true = torch.tensor([0, 1, 1, 0, 1])

y_pred = torch.tensor([0.1, 0.4, 0.35, 0.8, 0.7])

# 计算AUC值

auc_value = roc_auc_score(y_true, y_pred)

print('The AUC value is:', auc_value)

```

在上述代码中,`roc_auc_score`函数将返回计算得到的AUC值。当处理多类分类问题时,该函数也可以计算每个类别的一对多(one-vs-rest)AUC值。由于AUC值不依赖于分类阈值,因此是评估分类模型性能的有效工具,尤其是在处理不平衡数据集时。

# 3. ROC曲线与AUC值的实战应用

## 3.1 数据预处理与模型构建

### 3.1.1 数据集的选取和预处理

数据预处理是机器学习流程中的重要环节,对于模型的性能和评估准确性有着决定性的影响。选取合适的数据集是预处理的第一步。根据应用场景的不同,数据集可能来自不同的渠道,如公开数据集、实验数据或者实际生产环境中的数据。数据集选取时需要考虑数据的代表性和质量。

在预处理阶段,要完成以下任务:

- 清洗数据:去除噪声和异常值,处理缺失数据。

- 数据变换:包括归一化、标准化等,使数据特征在同一量级,便于模型处理。

- 特征提取:提取对预测任务有帮助的特征,去除冗余特征。

- 数据集划分:将数据集分为训练集、验证集和测试集。

以一个信用评分模型为例,你可能需要从历史交易记录中提取用户的消费习惯、收入水平、还款记录等特征,并将数据集划分为训练集和测试集。以下是一个使用Python进行数据预处理的示例:

```python

import pandas as pd

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import StandardScaler

# 加载数据集

data = pd.read_csv('credit_data.csv')

# 清洗数据

data.dropna(inplace=True) # 删除缺失值

# 特征提取

features = data[['amount', 'frequency', 'duration', 'age', 'job', 'marital']]

labels = data['default']

# 数据归一化

scaler = StandardScaler()

features_scaled = scaler.fit_transform(features)

# 划分数据集

X_train, X_test, y_train, y_test = train_test_split(features_scaled, labels, test_size=0.2, random_state=42)

```

### 3.1.2 PyTorch模型的搭建和训练

在数据预处理完成后,下一步是搭建并训练PyTorch模型。在PyTorch中,模型通常以`nn.Module`类的形式定义。构建模型时,我们可以使用预定义的层(如`nn.Linear`)来搭建网络结构,并定义适当的损失函数和优化器。

以一个二分类问题为例,我们需要构建一个简单的线性分类器:

```python

import torch

import torch.nn as nn

import torch.optim as optim

# 定义模型

class SimpleClassifier(n

```

0

0