【避免损失函数选择误区】:揭秘常见的错误及影响

发布时间: 2024-09-06 00:13:55 阅读量: 93 订阅数: 44

Pytorch十九种损失函数的使用详解

# 1. 损失函数的理论基础

损失函数是机器学习与深度学习中不可或缺的一环,它衡量了模型预测值与真实值之间的差异。理解损失函数的基础概念对于构建有效的学习模型至关重要。

## 1.1 损失函数的定义

损失函数,也称为代价函数或误差函数,其核心作用是量化模型预测的准确性。简而言之,它定义了在给定一个数据集的情况下,模型预测的代价。通过最小化损失函数,模型可以学习到从输入到输出的映射关系。

## 1.2 损失函数的目的

在机器学习的训练过程中,我们的主要目的是调整模型参数,以减少损失函数的值。这意味着我们的模型在预测新数据时会更加准确。通过这种方式,损失函数成为训练算法迭代优化的依据。

## 1.3 损失函数与优化算法的关系

优化算法,如梯度下降法,利用损失函数关于模型参数的梯度信息,指导参数更新的方向和步长。损失函数的梯度越大,模型参数调整的幅度也就越大,反之亦然。因此,选择合适的损失函数对模型学习至关重要。

总结而言,损失函数是连接数据和模型训练的桥梁,通过最小化损失函数可以实现模型的参数优化,最终达成预测目标。

# 2. 损失函数的类型及应用场景

### 2.1 回归问题的损失函数

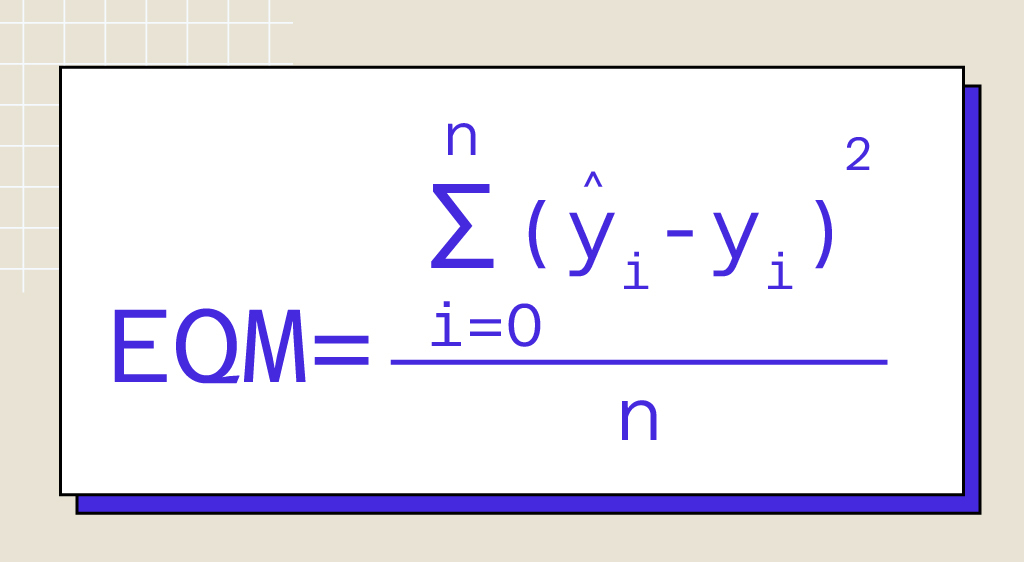

#### 2.1.1 均方误差损失(MSE)

均方误差损失(Mean Squared Error, MSE)是回归问题中最常用的损失函数之一。它通过计算预测值与实际值差的平方的均值来衡量模型的性能。MSE 对大的误差更加敏感,因此它对异常值的惩罚更为严重。MSE的数学表达式如下:

\[ MSE = \frac{1}{n} \sum_{i=1}^{n} (y_i - \hat{y}_i)^2 \]

其中,\( y_i \) 是实际值,\( \hat{y}_i \) 是模型预测值,n 是样本数量。

```python

import numpy as np

def mse_loss(y_true, y_pred):

return np.mean((y_true - y_pred) ** 2)

# 示例数据

y_true = np.array([1, 2, 3, 4, 5])

y_pred = np.array([1.1, 2.1, 2.9, 4.1, 5.1])

# 计算MSE

loss = mse_loss(y_true, y_pred)

print(f"MSE loss: {loss}")

```

#### 2.1.2 平均绝对误差损失(MAE)

平均绝对误差损失(Mean Absolute Error, MAE)是另一种常见的回归问题损失函数。它计算的是预测值与实际值之差的绝对值的平均。与MSE相比,MAE对异常值不那么敏感,因此在含有异常值的数据集上表现更为稳健。

```python

def mae_loss(y_true, y_pred):

return np.mean(np.abs(y_true - y_pred))

# 使用与MSE相同的示例数据

# 计算MAE

loss = mae_loss(y_true, y_pred)

print(f"MAE loss: {loss}")

```

### 2.2 分类问题的损失函数

#### 2.2.1 交叉熵损失(Cross-Entropy)

交叉熵损失是分类问题,特别是二分类和多分类问题中的首选损失函数。它测量了预测概率分布与实际标签概率分布之间的差异。对于二分类问题,交叉熵损失函数表达式如下:

\[ CE = -\frac{1}{n} \sum_{i=1}^{n} [y_i \cdot \log(\hat{y}_i) + (1 - y_i) \cdot \log(1 - \hat{y}_i)] \]

其中,\( y_i \) 是实际标签,\( \hat{y}_i \) 是模型预测的概率值,n 是样本数量。

```python

def cross_entropy_loss(y_true, y_pred):

return -np.mean(y_true * np.log(y_pred) + (1 - y_true) * np.log(1 - y_pred))

# 示例数据

y_true = np.array([1, 0, 1, 1, 0])

y_pred = np.array([0.9, 0.1, 0.8, 0.65, 0.3])

# 计算交叉熵损失

loss = cross_entropy_loss(y_true, y_pred)

print(f"Cross-Entropy loss: {loss}")

```

#### 2.2.2 对数损失(Log-Loss)

对数损失,有时也称为逻辑损失,是交叉熵损失的另一种表述形式。在二分类问题中,如果\( p \)是正面类的预测概率,则损失函数可以表达为:

\[ Logloss = -\frac{1}{n} \sum_{i=1}^{n} [y_i \cdot \log(p) + (1 - y_i) \cdot \log(1 - p)] \]

它与交叉熵损失等价,只是在数学表达上稍有不同。

### 2.3 其他特定问题的损失函数

#### 2.3.1 排序损失(Ranking Loss)

在机器学习的排序问题中,排序损失通常用来优化模型对数据排序的能力,而不是预测一个确切的值。排序损失的目的是确保模型能够将相关项排在不相关项之前。常用的一个损失函数是 pairwise ranking loss,它关注的是点对之间的排序:

\[ RankingLoss = \frac{1}{N} \sum_{(x^+, x^-) \in S} \max(0, m - f(x^+) + f(x^-)) \]

其中,\( N \) 是样本对的数量,\( S \) 是包含所有样本对的集合,\( x^+ \) 是正例,\( x^- \) 是反例,\( f(x) \) 是模型对样本的打分函数,\( m \) 是一个超参数,表示正例和反例之间的边界。

```python

def pairwise_ranking_loss(y_true, scores):

N = len(scores) // 2

loss = 0.0

for i in range(N):

x_pos, x_neg = scores[2*i], scores[2*i+1]

loss += max(0.0, 1.0 - x_pos + x_neg)

return loss / N

# 示例数据

scores = [0.9, 0.3, 0.8, 0.4]

y_true = [1, 0, 1, 0] # 正例标签为1,反例标签为0

# 计算排序损失

loss = pairwise_ranking_loss(y_true, scores)

print(f"Ranking Loss: {loss}")

```

#### 2.3.2 结构化预测的损失函数

在结构化预测问题中,如序列标注或图像分割等,模型的输出通常是一个复杂的数据结构。损失函数需要能够评估这些结构化输出的准确性。常用的损失函数包括条件随机场(CRF)中的损失,以及在图像分割中常见的交叉熵损失函数的变体,如Dice Loss或IoU Loss。

```python

def crf_loss(y_true, y_pred):

# 此处省略CRF损失函数的复杂实现,通常需要借助专门的库如pycrfsuite。

pass

# 示例数据

y_true = np.array([[1, 0, 0], [0, 1, 0], [0, 0, 1]])

y_pred = np.array([[0.7, 0.1, 0.2], [0.1, 0.8, 0.1], [0.1, 0.1, 0.8]])

# 计算CRF损失

loss = crf_loss(y_true, y_pred)

print(f"CRF Loss: {loss}")

```

在处理结构化输出的问题时,通常需要利用到复杂模型和特殊的损失函数设计,这是未来深度学习技术发展的一个重要方向。

# 3. 损失函数选择的常见误区

## 3.1 误区一:混淆不同问题的损失函数

### 3.1.1 误解回归与分类问题的损失函数选择

在机器学习项目中,正确地选择损失函数对于模型的性能至关重要。然而,一个常见的误区是在选择损失函数时混淆了不同类型的问题,尤其是回归(regression)和分类(classification)问题。

回归问题旨在预测一个连续值的输出,例如预测房屋价格或气温。对于这类问题,均方误差损失(MSE)和平均绝对误差损失(MAE)是较为常用的选择。均方误差损失函数计算预测值与实际值之差的平方和,倾向于惩罚大的误差,而平均绝对误差损失则计算预测值与实际值之差的绝对值和。

与之相反的是,分类问题的目标是预测某个样本属于特定类别的概率。分类问题通常会用到交叉熵损失(Cross-Entropy)和对数损失(Log-Loss)。交叉熵损失衡量的是模型预测的概率分布与实际标签的分布之间的差异,而对数损失是交叉熵损失的另一种表述形式,常用于二分类问题。

### 3.1.2 忽略问题特性对损失函数的影响

选择损失函数时,需要密切注意问题的特性。例如,某些情况下,均方误差可能会对离群点过分敏感,从而导致模型对这些异常值过于关注,而不是试图捕捉整体趋势。同样地,交叉熵损失对于分类问题中类别不平衡较为敏感,因此在类别分布不均匀时,需要通过适当的重采样或修改损失函数来平衡各类别的权重。

理解损失函数与问题特性之间的关系是避

0

0