【多任务学习】:设计与应用多任务神经网络中的损失函数

发布时间: 2024-09-06 00:37:02 阅读量: 148 订阅数: 51

图像识别中的多任务学习:提升模型泛化能力

# 1. 多任务学习与神经网络基础

## 1.1 多任务学习简介

多任务学习是一种机器学习范式,它通过共同学习相关任务来提升模型的性能和泛化能力。这种学习方式允许模型同时解决多个任务,任务之间通过共享表示而受益,从而实现知识的迁移和利用。在多任务学习中,神经网络充当了极其重要的角色,通过构建多层的神经网络结构,能够有效捕捉数据中的复杂模式,为不同的学习任务提供支持。

## 1.2 神经网络基础

神经网络是模仿人脑结构和功能的计算模型,它由大量的神经元(或称为节点)组成,通过层与层之间的连接传递信息。简单来说,神经网络通过前向传播来获取输出,并通过反向传播算法来调整网络内部的权重,以此最小化损失函数,从而达到学习的目的。在多任务学习中,神经网络的结构设计尤为重要,需要考虑到不同任务间的依赖关系和特征共享。

## 1.3 多任务学习中的神经网络

在多任务学习中应用神经网络时,我们通常会构建一个共享的底层网络结构,然后在该结构上构建多个任务特定的上层网络。这种结构设计能够使得共享层学习到跨任务的通用特征,而任务层则根据各个任务的特定需求,对共享特征进行不同的加工和利用。这种共享与独立相结合的网络设计,既利用了多任务之间的相关性,也保障了任务学习的灵活性和效率。

以上就是多任务学习与神经网络基础的核心内容,接下来章节会继续深入探讨损失函数设计理论,以及如何在多任务学习中应用和优化神经网络。

# 2. 损失函数设计理论

## 2.1 损失函数的基本概念

### 2.1.1 损失函数在机器学习中的作用

在机器学习中,损失函数是衡量模型预测值和真实值之间差异的函数,是优化算法中不可或缺的部分。损失函数的目标是通过最小化其值来提升模型的预测性能。更具体地说,损失函数提供了一个量化模型误差的方法,使得机器学习算法可以利用这些信息来进行模型参数的调整。

模型训练过程中,损失函数的值会随着参数的更新而减少,这通常通过梯度下降或其他优化算法实现。随着损失值的降低,模型的预测准确性提高。因此,损失函数对模型的性能和优化方向起着决定性作用。

### 2.1.2 单任务与多任务学习中损失函数的差异

在单任务学习中,损失函数相对简单,它通常衡量模型在一个单独任务上的性能。例如,在图像分类任务中,交叉熵损失函数可以用来衡量预测的概率分布和真实的标签之间的差异。

而多任务学习涉及同时训练多个相关任务,每个任务都有自己的损失函数,这时需要一个综合机制来协调这些不同的损失函数。多任务损失函数可能会采用加权和的方式,将各任务的损失函数值进行加权汇总。也可以采用逐步添加任务的方式,先训练一个任务的损失函数,然后引入下一个任务的损失函数,并逐渐平衡各个任务的损失权重。不同方法的选择对模型性能有重大影响。

## 2.2 损失函数的数学原理

### 2.2.1 损失函数的数学表述

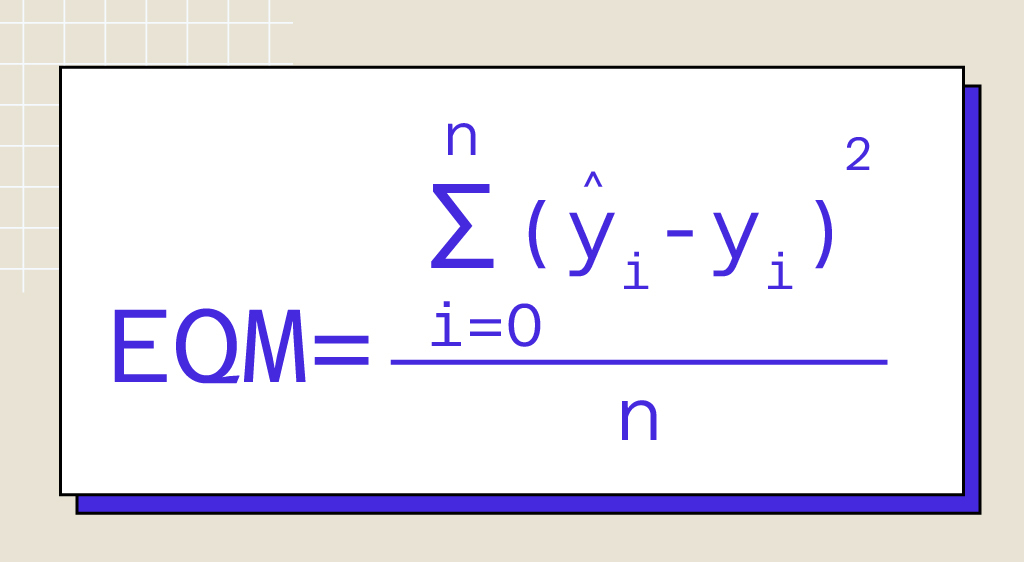

从数学的角度来看,损失函数通常表示为一个关于模型参数的函数L(w),其中w代表模型的参数集合。在监督学习中,损失函数可以表达为:

L(w) = (1/n) ∑_{i=1}^{n} l(y_i, f(x_i; w))

这里的l是样本损失函数,f(x_i; w)是模型对输入x_i给出的预测值,y_i是真实的标签值,n是样本总数。

### 2.2.2 损失函数的性质和选择标准

一个有效的损失函数应该满足以下性质:一致性(反映性能好坏)、鲁棒性(对异常值不敏感)、可区分性(具有可导性质以便优化)和可计算性(计算高效)。

在选择损失函数时,还必须考虑任务的性质,如回归任务通常使用均方误差(MSE),分类任务常使用交叉熵损失。对于多任务学习,设计损失函数时还应考虑任务之间的关系和损失值的均衡。

## 2.3 损失函数优化算法

### 2.3.1 常见的优化算法概述

在多任务学习中,优化算法是调整模型参数以最小化损失函数的关键。常用的优化算法包括:

- **梯度下降(GD)**:基础的优化方法,通过计算损失函数相对于参数的梯度来更新参数。

- **随机梯度下降(SGD)**:每次迭代使用一个样本或一个小批量样本来估计梯度。

- **动量(Momentum)**:利用历史梯度的信息来加速SGD并减少震荡。

- **自适应学习率算法(如Adam, RMSprop)**:自适应调整每个参数的学习率以改善收敛速度和性能。

### 2.3.2 损失函数优化的实践技巧

在实践中,优化算法的选择和参数调整(如学习率和动量)对模型性能至关重要。一些提升优化效果的技巧包括:

- **学习率衰减**:随着训练进程的推进逐渐减小学习率。

- **批量归一化(Batch Normalization)**:加速训练过程并允许更高的学习率。

- **使用正则化方法**:如L1和L2正则化,防止模型过拟合。

- **梯度裁剪**:防止梯度爆炸问题,特别是在训练深度神经网络时。

接下来的章节将详细讨论多任务学习中损失函数的实际应用,如何在实践中设计和调整损失函数,并讨论损失函数在不同任务组合中的应用和优化策略。

# 3. 多任务神经网络损失函数实践

## 3.1 常见多任务损失函数实例分析

在多任务学习中,损失函数是衡量模型预测值与真实值之间差异的重要工具。一个合适的损失函数不仅可以提升模型在各个任务上的表现,还可以帮助解决任务间的竞争和冲突问题。

### 3.1.1 平均损失

平均损失是最简单的多任务损失函数,它通过对每个任务的损失进行平均化处理来优化所有任务。假设我们有 M 个任务,每个任务的损失函数表示为 L_m(x, y_m) (其中 m=1,2,...,M),那么平均损失函数可以定义为:

```math

L_{avg}(x, y) = \frac{1}{M} \sum_{m=1}^{M} L_m(x, y_m)

```

这个方法的一个优点是简单易实现,易于平衡不同任务的重要性。然而,它的一个主要缺点是它无法区分各个任务的重要性,对于一些关键任务和非关键任务会给予相同的权重,这可能会影响模型的整体性能。

### 3.1.2 加权和损失

与平均损失不同,加权和损失允许为每个任务指定不同的权重。这可以解决任务重要性不同的问题。公式如下:

```math

L_{sum}(x, y) = \sum_{m=1}^{M} w_m L_m(x, y_m)

```

其中,w_m 是第 m 个任务的权重,这些权重可以根据先验知识或者前期实验来设定。加权和损失提供了一定的灵活性,通过权重的调整可以更精细地控制模型在不同任务上的表现。

### 3.1.3 逐步添加任务的损失函数

在多任务学习中,逐步添加任务的策略是一个有趣的方法。它首先训练网络仅专注于最重要的任务,然后逐步引入其他任务。这种方法类似于迁移学习中的逐步微调策略。其损失函数可以表示为:

```math

L_{step}(x, y) = \sum_

```

0

0