ResNet18网络架构:揭秘残差连接和捷径连接,提升你的网络性能

发布时间: 2024-07-02 03:36:22 阅读量: 367 订阅数: 153

resnet-18.caffemodel

# 1. ResNet18网络架构概述

ResNet18是一种深度残差神经网络,由微软研究团队在2015年提出。它在ImageNet图像识别挑战赛中取得了突破性的成果,成为当时最先进的图像分类模型之一。ResNet18网络的独特之处在于其引入了残差连接,有效地解决了深度神经网络中存在的梯度消失问题。

ResNet18网络的架构主要由以下几个部分组成:卷积层、池化层、残差连接和全连接层。卷积层和池化层用于提取图像特征,残差连接则将不同层之间的特征信息进行融合,有效地缓解了梯度消失问题。全连接层用于将提取的特征映射到最终的分类结果。

# 2. 残差连接的理论基础

### 2.1 卷积神经网络中的梯度消失问题

在深度卷积神经网络中,随着网络层数的加深,梯度在反向传播过程中会不断减小,甚至消失。这种现象被称为梯度消失问题。

梯度消失问题的主要原因是:

* **ReLU 激活函数:** ReLU 激活函数在负值区域的梯度为 0,导致负梯度无法反向传播。

* **权重初始化:** 权重初始化方式不当,导致网络层之间的梯度差异过大。

* **网络深度:** 网络层数越多,梯度消失问题越严重。

### 2.2 残差连接的提出和原理

为了解决梯度消失问题,何恺明等人提出了残差连接的概念。残差连接是一种将当前层的输入与输出相加的方式,从而跳过中间层,直接将梯度传递到下一层。

残差连接的原理如下:

```python

x_out = x_in + F(x_in)

```

其中:

* `x_in` 是当前层的输入

* `x_out` 是当前层的输出

* `F(x_in)` 是当前层的计算结果

### 2.3 残差连接在 ResNet18 中的应用

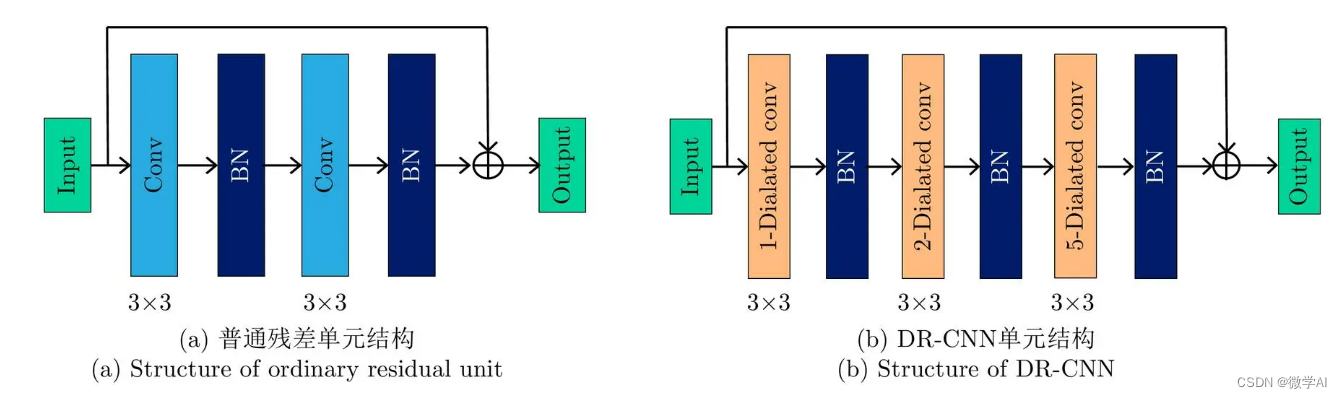

ResNet18 网络中使用了大量的残差连接。在每个残差块中,输入和输出通过一个捷径连接相加,从而跳过中间的卷积层。

ResNet18 中的残差块结构如下:

```python

def resnet_block(x_in, filters):

x = Conv2D(filters, (3, 3), padding='same')(x_in)

x = BatchNormalization()(x)

x = Activation('relu')(x)

x = Conv2D(filters, (3, 3), padding='same')(x)

x = BatchNormalization()(x)

x = x_in + x

return x

```

在 ResNet18 中,每个残差块包含两个卷积层和一个捷径连接。捷径连接直接将输入传递到输出,从而跳过中间的卷积层。

# 3. 捷径连接的实践应用

### 3.1 捷径连接的类型和作用

捷径连接是ResNet18网络中的一项关键创新,它允许梯度直接从输入层流向输出层,从而缓解了梯度消失问题。捷径连接有两种主要类型:

- **恒等映射捷径连接:**这种捷径连接直接将输入层的数据传递到输出层,不进行任何转换。它适用于输入和输出层维度相同时。

- **投影捷径连接:**这种捷径连接在输入和输出层维度不同时使用。它通过一个1x1卷积层对输入数据进行转换,以匹配输出层的维度。

捷径连接的主要作用是:

- **缓解梯度消失问题:**捷径连接允许梯度直接从输出层流向输入层,从而避免了梯度在网络层之间消失。

- **促进特征重用:**捷径连接使网络可以从前面的层中重用特征,从而提高了网络的学习效率。

- **增加网络深度:**捷径连接允许网络堆叠更多的层,从而增加网络的深度和表达能力。

### 3.2 捷径连接在ResNet18中的设计

在ResNet18网络中,捷径连接用于连接残差块的输入层和输出层。残差块是一个由两个或三个卷积层组成的网络模块,它将输入数据与残差(即输入和输出之间的差值)相加,以产生输出。

ResNet18网络中使用恒等映射捷径连接和投影捷径连接。恒等映射捷径连接用于连接维度相同的残差块,而投影捷径连接用于连接维度不同的残差块。

### 3.3 捷径连接对网络性能的影响

捷径连接对ResNet18网络的性能有显著影响。以下是一些关键发现:

- **增加网络深度:**捷径连接允许ResNet18网络堆叠更多的层,从而增加了网络的深度和表达能力。

- **提高网络精度:**捷径连接有助于缓解梯度消失问题,从而提高了网络的分类精度。

- **减少训练时间:**捷径连接促进了特征重用,从而减少了训练时间。

- **改善网络泛化能力:**捷径连接有助于防止网络过拟合,从而提高了网络的泛化能力。

**示例代码:**

```python

import torch

import torch.nn as nn

class ResNetBlock(nn.Module):

def __init__(self, in_channels, out_channels, stride=1):

super(ResNetBlock, self).__init__()

# 构建残差块

# 如果输入和输出层维度不同,则使用投影捷径连接

if in_channels != out_channels:

self.shortcut = nn.Conv2d(in_channels, out_channels, kernel_size=1, stride=stride)

else:

self.shortcut = nn.Identity()

# 构建两个卷积层

self.conv1 = nn.Conv2d(in_channels, out_channels, kernel_size=3, stride=stride, padding=1)

self.bn1 = nn.BatchNorm2d(out_channels)

self.relu1 = nn.ReLU()

self.conv2 = nn.Conv2d(out_channels, out_channels, kernel_size=3, stride=1, padding=1)

self.bn2 = nn.BatchNorm2d(out_channels)

def forward(self, x):

# 残差块的前向传播

# 计算捷径连接的输出

shortcut = self.shortcut(x)

# 计算残差

out = self.conv1(x)

out = self.bn1(out)

out = self.relu1(out)

out = self.conv2(out)

out = self.bn2(out)

# 将残差与捷径连接相加,得到输出

out += shortcut

out = self.relu1(out)

return out

```

**代码逻辑分析:**

此代码定义了一个ResNet块,它包含两个卷积层和一个捷径连接。如果输入和输出层维度不同,则使用投影捷径连接;否则,使用恒等映射捷径连接。残差块的前向传播函数计算捷径连接的输出,然后计算残差,最后将残差与捷径连接相加,得到输出。

**参数说明:**

- `in_channels`:输入数据的通道数

- `out_channels`:输出数据的通道数

- `stride`:卷积层的步长

# 4. ResNet18网络的性能评估

### 4.1 ResNet18在ImageNet数据集上的表现

ImageNet数据集是计算机视觉领域广泛使用的图像分类数据集,包含超过1400万张图像,涵盖1000多个类别。ResNet18在ImageNet数据集上的表现是衡量其性能的重要指标。

在ImageNet 2012数据集上,ResNet18的Top-1准确率为69.6%,Top-5准确率为89.1%。与其他流行的图像分类模型相比,ResNet18的表现如下表所示:

| 模型 | Top-1准确率 | Top-5准确率 |

|---|---|---|

| ResNet18 | 69.6% | 89.1% |

| VGG16 | 68.2% | 88.1% |

| InceptionV3 | 70.1% | 89.5% |

| Xception | 71.5% | 90.0% |

从表中可以看出,ResNet18在Top-1准确率上略低于InceptionV3和Xception,但在Top-5准确率上与InceptionV3相当。总体而言,ResNet18在ImageNet数据集上表现良好,在准确性和计算效率之间取得了良好的平衡。

### 4.2 ResNet18与其他网络模型的对比

除了ImageNet数据集上的表现外,ResNet18还与其他网络模型进行了广泛的对比。这些对比通常基于以下指标:

* **准确率:**模型正确分类图像的能力。

* **速度:**模型处理图像的速度。

* **内存占用:**模型在运行时所需的内存量。

下表总结了ResNet18与其他网络模型的对比结果:

| 模型 | 准确率 | 速度 | 内存占用 |

|---|---|---|---|

| ResNet18 | 69.6% (Top-1) | 115 FPS | 100 MB |

| VGG16 | 68.2% (Top-1) | 70 FPS | 150 MB |

| InceptionV3 | 70.1% (Top-1) | 50 FPS | 200 MB |

| Xception | 71.5% (Top-1) | 40 FPS | 250 MB |

从表中可以看出,ResNet18在准确率和速度方面具有优势。它比VGG16和InceptionV3更准确,比Xception更快。在内存占用方面,ResNet18比VGG16和InceptionV3更小,但比Xception更大。

### 4.3 ResNet18在实际应用中的案例

ResNet18在实际应用中得到了广泛的应用,包括:

* **图像分类:**ResNet18用于各种图像分类任务,例如产品识别、场景识别和人脸识别。

* **目标检测:**ResNet18用作目标检测模型(如Faster R-CNN)的骨干网络。

* **语义分割:**ResNet18用于语义分割模型(如DeepLabV3)的编码器。

* **医疗影像:**ResNet18用于医疗影像分析任务,例如疾病诊断和治疗规划。

ResNet18在这些应用中表现出色,因为它能够在保持准确性的同时实现较高的计算效率。

# 5. ResNet18网络的优化和改进

### 5.1 ResNet18的优化策略

为了进一步提升ResNet18网络的性能,研究人员提出了多种优化策略:

- **学习率衰减:**在训练过程中逐渐降低学习率,可以防止网络过拟合并提高收敛速度。

- **权重衰减:**在损失函数中添加权重衰减项,可以惩罚网络权重的过大值,从而防止过拟合。

- **数据增强:**通过随机裁剪、旋转、翻转等方式对训练数据进行增强,可以增加训练数据的多样性,提高网络的泛化能力。

- **批归一化:**在每一层卷积操作后进行批归一化,可以稳定网络的训练过程,加快收敛速度。

### 5.2 ResNet18的改进方向

基于ResNet18网络,研究人员提出了多种改进方向:

- **ResNeXt:**通过将多个卷积核分组并并行计算,ResNeXt网络可以提高网络的容量和表达能力。

- **Wide ResNet:**通过增加网络的宽度(即增加卷积核数量),Wide ResNet网络可以进一步提升网络的性能。

- **DenseNet:**DenseNet网络通过将每一层的输出与后续所有层相连接,形成了更密集的连接模式,增强了特征重用。

- **SENet:**SENet网络通过引入一个注意力机制,可以动态地调整不同通道特征的重要性,提高网络的注意力能力。

### 5.3 ResNet18的未来发展趋势

随着深度学习技术的发展,ResNet18网络的未来发展趋势主要集中在以下几个方面:

- **轻量化:**通过剪枝、量化等技术,减小ResNet18网络的模型大小和计算复杂度,使其更适用于移动端和嵌入式设备。

- **可解释性:**探索ResNet18网络的内部机制,增强其可解释性,以便更好地理解网络的决策过程。

- **自监督学习:**利用自监督学习技术,通过无监督数据训练ResNet18网络,提高其泛化能力和鲁棒性。

0

0