ResNet18中的残差连接:揭示其背后的原理和好处,助你理解模型架构的精髓

发布时间: 2024-07-02 04:26:29 阅读量: 163 订阅数: 127

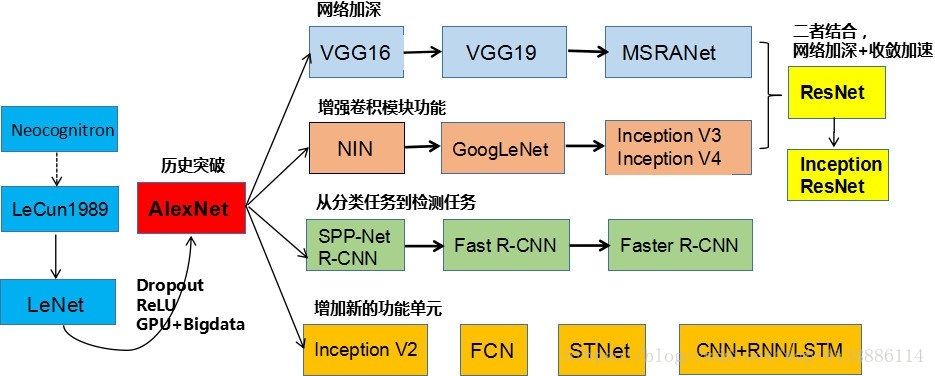

ResNet残差网络

# 1. 残差连接的基本原理**

残差连接是一种神经网络中的连接方式,它将输入直接传递到后续层,同时将前一层输出的残差(即输入与输出的差值)添加到后续层的输出中。这种连接方式可以有效缓解梯度消失问题,并提升网络容量。

残差连接的数学表达式为:

```

y = F(x) + x

```

其中:

* x 为输入

* F(x) 为后续层输出

* y 为最终输出

残差连接的直观解释是,后续层学习输入和输出之间的残差,而不是直接学习输出。这使得网络可以更轻松地学习恒等映射(即输入和输出相等),从而缓解梯度消失问题。

# 2. ResNet18中残差连接的具体实现

ResNet18是ResNet家族中较为基础的网络结构,其包含18个残差模块。本章节将详细介绍ResNet18中残差连接的具体实现,包括网络结构、残差模块的组成以及残差连接的计算过程。

### 2.1 ResNet18的网络结构

ResNet18的网络结构主要由卷积层、池化层和残差模块组成。网络的输入为224x224x3的RGB图像,经过一系列卷积层和池化层后,得到一个7x7x512的特征图。随后,网络进入残差模块部分,包含18个残差模块。最后,通过一个全局平均池化层和一个全连接层得到最终的分类结果。

#### 2.1.1 卷积层和池化层

ResNet18的卷积层主要采用3x3的卷积核,步长为1。池化层采用2x2的最大池化,步长为2。网络的前几层卷积层负责提取图像的基本特征,如边缘、纹理等。池化层则用于缩小特征图的尺寸,同时增强特征的鲁棒性。

#### 2.1.2 残差模块

残差模块是ResNet18的核心组成部分,其主要由两个3x3的卷积层和一个恒等映射组成。恒等映射直接将输入特征图传递到输出,而卷积层则对输入特征图进行非线性变换。残差模块的输出是输入特征图和卷积层输出的和。

### 2.2 残差连接的计算过程

#### 2.2.1 前向传播

残差连接的前向传播过程如下:

1. 将输入特征图`x`通过两个3x3的卷积层,得到卷积输出`F(x)`。

2. 将输入特征图`x`直接传递到输出,得到恒等输出`x`。

3. 将卷积输出`F(x)`和恒等输出`x`相加,得到残差模块的输出`y`:`y = F(x) + x`。

#### 2.2.2 反向传播

残差连接的反向传播过程如下:

1. 计算残差模块输出`y`对输入特征图`x`的梯度:`dy/dx = 1`。

2. 计算残差模块输出`y`对卷积输出`F(x)`的梯度:`dy/dF(x) = 1`。

3. 根据链式法则,计算残差模块输出`y`对输入特征图`x`的梯度:`dx/dF(x) = dy/dF(x) * dy/dx = 1`。

残差连接的计算过程表明,残差连接不会影响输入特征图的梯度,从而缓解了梯度消失问题。

# 3.1 梯度消失问题的缓解

#### 3.1.1 梯度消失的原理

在深度神经网络中,梯度消失问题是指随着网络层数的增加,反向传播过程中梯度的值逐渐减小,导致深层网络难以训练。梯度消失的根本原因在于激活函数的性质。

常用的激活函数,如 sigmoid 和 tanh,在输入值较大时梯度接近于 0,导致反向传播过程中梯度值

0

0