ResNet18与其他CNN模型的比较:性能和效率评估,助你选择最优模型

发布时间: 2024-07-02 03:51:29 阅读量: 148 订阅数: 113

# 1. ResNet18简介

ResNet18是一种深度残差网络,在图像识别任务中表现出色。它由18个残差块组成,每个残差块包含两个3x3卷积层和一个快捷连接。快捷连接允许梯度在网络中直接传播,从而缓解了梯度消失问题。ResNet18在ImageNet数据集上的top-1准确率为69.6%,在CIFAR-10数据集上的top-1准确率为95.4%。

# 2. ResNet18的理论基础

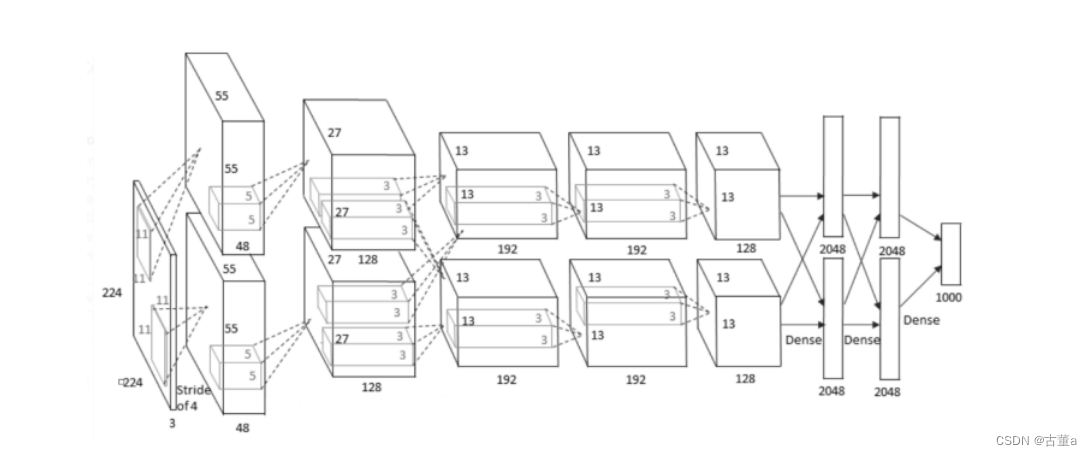

### 2.1 卷积神经网络(CNN)的原理

卷积神经网络(CNN)是一种深度学习模型,专门用于处理具有网格状结构的数据,例如图像。CNN的架构由以下关键组件组成:

- **卷积层:**卷积层使用一组称为内核或滤波器的权重矩阵,在输入数据上滑动。内核与输入数据元素逐元素相乘,然后求和并应用非线性激活函数(如ReLU),生成特征图。

- **池化层:**池化层通过对特征图中的相邻元素进行下采样(如最大池化或平均池化)来减少空间维度。这有助于减少计算成本并控制过拟合。

- **全连接层:**全连接层将卷积层和池化层的输出展平为一维向量,并使用全连接权重矩阵进行线性变换。全连接层通常用于分类或回归任务。

### 2.2 残差网络(ResNet)的结构和优势

残差网络(ResNet)是一种深度CNN架构,引入了残差连接,以解决深度神经网络中的梯度消失问题。ResNet的结构如下:

- **残差块:**残差块是ResNet的基本构建块,包含两个卷积层和一个恒等映射。恒等映射允许输入数据直接跳过残差块。

- **跳跃连接:**残差连接将残差块的输入与输出相加,形成最终的输出。这允许梯度直接从输出流向输入,从而缓解了梯度消失问题。

ResNet的优势包括:

- **更深的网络:**残差连接允许训练更深的网络,而不会遇到梯度消失问题。

- **更好的性能:**ResNet在各种视觉任务中都取得了最先进的性能,包括图像分类、目标检测和语义分割。

- **更快的收敛:**跳跃连接有助于加快训练过程,因为梯度可以更有效地传播到网络的早期层。

**代码块 2.1:ResNet块的实现**

```python

import torch

import torch.nn as nn

class ResNetBlock(nn.Module):

def __init__(self, in_channels, out_channels, stride=1):

super(ResNetBlock, self).__init__()

# 第一层卷积

self.conv1 = nn.Conv2d(in_channels, out_channels, kernel_size=3, stride=stride, padding=1)

self.bn1 = nn.BatchNorm2d(out_channels)

self.relu1 = nn.ReLU()

# 第二层卷积

self.conv2 = nn.Conv2d(out_channels, out_channels, kernel_size=3, stride=1, padding=1)

self.bn2 = nn.BatchNorm2d(out_channels)

# 恒等映射

self.identity = nn.Identity()

# 跳跃连接

if in_channels != out_channels or stride != 1:

self.downsample = nn.Sequential(

nn.Conv2d(in_channels, out_channels, kernel_size=1, stride=stride),

nn.BatchNorm2d(out_channels)

)

else:

self.downsample = None

def forward(self, x):

# 第一层卷积

out = self.conv1(x)

out = self.bn1(out

```

0

0