ResNet18的训练技巧:超参数优化、数据增强和正则化,助你提升模型泛化能力

发布时间: 2024-07-02 04:28:14 阅读量: 272 订阅数: 146

ResNet代码详解,内含论文中提到的各种数据增强的方法

# 1. ResNet18网络简介**

ResNet18网络是一种深度残差网络,因其在图像分类任务中的出色表现而闻名。它由18个卷积层组成,采用残差连接来解决梯度消失问题。残差连接允许信息直接从网络的较早层流向较深层,从而缓解了训练深度网络的困难。

ResNet18网络的输入是一个大小为224x224x3的RGB图像。网络使用卷积、池化和激活函数等操作来提取图像特征。卷积层负责学习图像中的局部模式,而池化层则用于减少特征图的大小。激活函数,如ReLU,引入非线性,使网络能够学习复杂的关系。

通过堆叠多个卷积层,ResNet18网络能够提取越来越高级别的特征。网络的最后几层通常是全连接层,用于将提取的特征分类为特定类别。

# 2. 超参数优化

### 2.1 学习率优化

学习率是神经网络训练过程中最重要的超参数之一,它控制着权重更新的步长。过高的学习率会导致模型不稳定,甚至发散;过低的学习率会导致训练缓慢,甚至停滞。因此,选择合适的学习率对于训练一个高性能的模型至关重要。

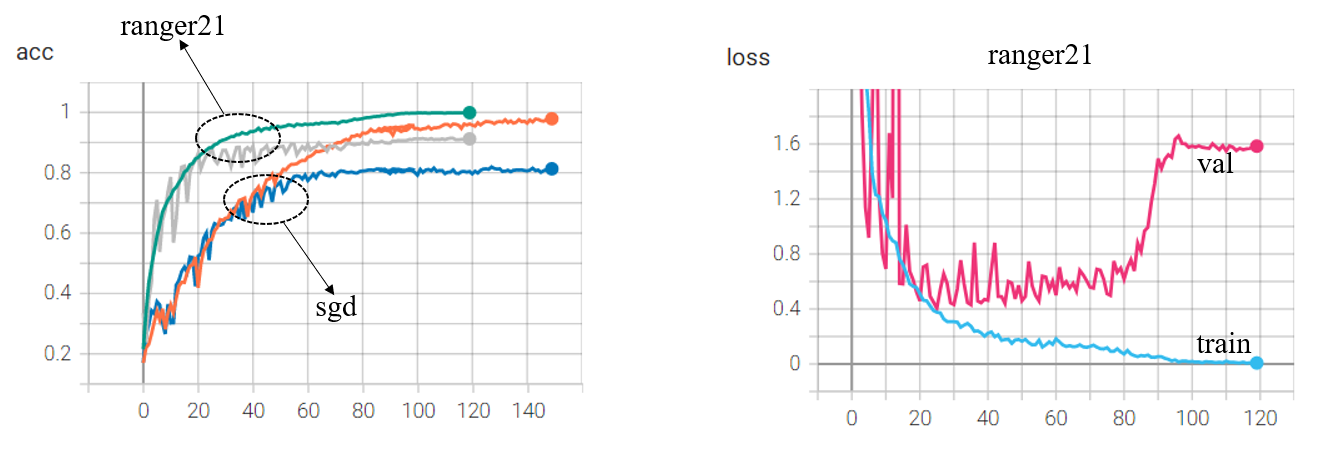

#### 2.1.1 常用优化算法

常用的优化算法包括:

- **梯度下降(GD)**:最简单的优化算法,沿着梯度负方向更新权重。

- **动量梯度下降(MGD)**:在GD的基础上加入动量项,可以加速收敛。

- **RMSprop**:自适应学习率算法,根据梯度的二阶矩调整学习率。

- **Adam**:一种结合了MGD和RMSprop优点的优化算法,目前最常用的优化算法之一。

#### 2.1.2 学习率衰减策略

随着训练的进行,学习率通常需要逐渐减小,以提高模型的稳定性和泛化能力。常用的学习率衰减策略包括:

- **固定衰减**:每隔一定步数或epoch将学习率乘以一个常数。

- **指数衰减**:每隔一定步数或epoch将学习率乘以一个小于1的常数。

- **余弦衰减**:学习率随着训练的进行而呈余弦曲线下降。

### 2.2 正则化超参数优化

正则化是防止模型过拟合的一种技术,通过向损失函数中添加惩罚项来约束模型的复杂度。常用的正则化方法包括:

#### 2.2.1 L1正则化与L2正则化

L1正则化(Lasso)和L2正则化(Ridge)是两种最常用的正则化方法。

- **L1正则化**:向损失函数中添加权重绝对值的惩罚项,可以使模型的权重稀疏,从而提高模型的可解释性。

- **L2正则化**:向损失函数中添加权重平方和的惩罚项,可以使模型的权重分布更加平滑,从而提高模型的稳定性。

#### 2.2.2 Dropout正则化

Dropout正则化是一种随机丢弃神经网络中部分神经元的方法,

0

0