TensorFlow GPU 加速配置详解

发布时间: 2024-05-03 00:55:45 阅读量: 108 订阅数: 36

# 1. TensorFlow GPU 加速简介**

TensorFlow GPU 加速是一种利用图形处理单元 (GPU) 来提高 TensorFlow 训练和推理性能的技术。GPU 是专门设计用于处理大量并行计算的硬件,使其成为加速深度学习模型训练和推理的理想选择。通过利用 GPU 的并行计算能力,TensorFlow 可以显著减少训练时间,提高模型推理速度。

# 2. TensorFlow GPU 加速理论基础

### 2.1 GPU 架构和并行计算

#### 2.1.1 GPU 的硬件组成和工作原理

GPU(图形处理单元)是一种专门用于加速图形和视频处理的硬件设备。与 CPU(中央处理单元)相比,GPU 具有以下特点:

- **并行处理能力强:** GPU 拥有大量并行处理单元(CUDA 核心),可以同时处理多个任务,提高计算效率。

- **内存带宽高:** GPU 具有高速的内存带宽,可以快速读取和写入数据,减少数据传输延迟。

- **专门的指令集:** GPU 拥有针对图形和视频处理优化的指令集,可以高效地执行相关计算。

GPU 的基本工作原理如下:

1. **数据加载:** GPU 从系统内存中加载数据到自己的显存中。

2. **并行处理:** GPU 的 CUDA 核心并行处理数据,执行计算任务。

3. **结果输出:** 计算结果从显存中写回到系统内存中。

#### 2.1.2 GPU 的并行计算模型

GPU 的并行计算模型主要有两种:

- **SIMD(单指令多数据):** 所有 CUDA 核心同时执行相同的指令,但处理不同的数据。

- **MIMD(多指令多数据):** 不同的 CUDA 核心可以执行不同的指令,处理不同的数据。

SIMD 模型更适合于数据并行计算,即对同一份数据进行相同的操作。MIMD 模型更适合于模型并行计算,即对模型的不同部分进行不同的操作。

### 2.2 TensorFlow GPU 加速原理

#### 2.2.1 TensorFlow 的计算图机制

TensorFlow 是一个基于计算图的深度学习框架。计算图是一种数据流图,表示了模型的计算流程。计算图中的节点代表操作,边代表数据流。

#### 2.2.2 GPU 加速的实现方式

TensorFlow GPU 加速通过以下方式实现:

- **CUDA 内核:** TensorFlow 将计算图中的操作编译为 CUDA 内核,在 GPU 上执行。

- **数据并行:** TensorFlow 可以将模型的数据并行到多个 GPU 上,每个 GPU 处理模型的不同部分。

- **模型并行:** TensorFlow 可以将模型的权重并行到多个 GPU 上,每个 GPU 负责更新模型的不同部分。

通过这些方式,TensorFlow 可以充分利用 GPU 的并行计算能力,提高模型训练和推理的效率。

# 3.1 GPU 环境配置

#### 3.1.1 NVIDIA CUDA 的安装和配置

**CUDA 简介**

CUDA(Compute Unified Device Architecture)是 NVIDIA 开发的并行计算平台和编程模型,用于利用 GPU 的并行计算能力。它提供了一组 API 和工具,使开发人员能够编写在 GPU 上运行的代码。

**CUDA 安装**

1. 访问 NVIDIA 官方网站下载适用于您操作系统的 CUDA 工具包。

2. 按照安装程序中的说明进行安装。

3. 验证安装是否成功:打开命令行并输入 `nvcc -V`,如果显示 CUDA 版本信息,则安装成功。

**CUDA 环境变量配置**

安装完成后,需要配置 CUDA 环境变量以使系统能够找到 CUDA 库和工具。

1. 打开环境变量设置(在 Windows 中为“系统属性”->“高级”->“环境变量”;在 Linux 中为 `/etc/profile`)。

2. 添加以下环境变量:

- `CUDA_HOME`:指向 CUDA 安装目录的路径(例如,`/usr/local/cuda`)。

- `PATH`:添加 `$CUDA_HOME/bin` 到路径中。

- `LD_LIBRARY_PATH`:添加 `$CUDA_HOME/lib64` 到路径中(在 Linux 中)。

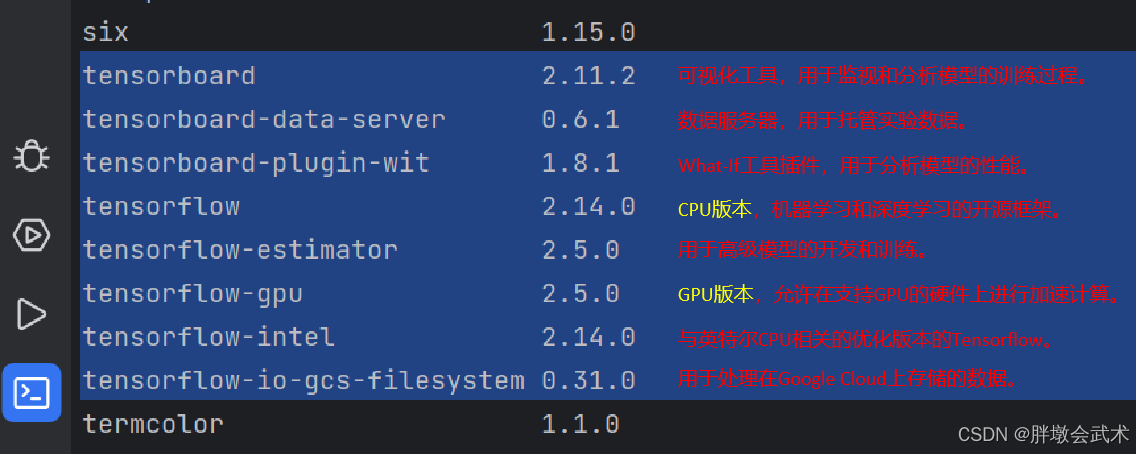

#### 3.1.2 TensorFlow GPU 版本的安装

**安装 TensorFlow GPU**

1. 创建一个新的 Python 虚拟环境。

2. 使用 pip 安装 TensorFlow GPU 版本:`pip install tensorflow-gpu`。

3. 验证安装是否成功:打开 Python 解释器并输入 `import tensorflow as tf; print(tf.__version__)`,如果显示 TensorFlow GPU 版本信息,则安装成功。

**安装注意事项**

* 确保您的系统满足 TensorFlow GPU 的系统要求,包括支持 CUDA 的 GPU。

* TensorFlow GPU 版本需要与您安装的 CUDA 版本兼容。

* 如果您遇到安装问题,请参考 TensorFlow 官方文档或社区论坛寻求帮助。

# 4. TensorFlow GPU 加速高级应用

### 4.1 TensorFlow GPU 与其他框架的集成

#### 4.1.1 TensorFlow GPU 与 PyTorch 的互操作

PyTorch 是另一个流行的深度学习框架,它以其动态计算图和灵活的 API 而闻名。TensorFlow GPU 和 PyTorch 可以通过以下方式进行互操作:

- **转换工具:**可以使用 `tf2pytorch` 和 `pytorch2tf` 等工具将 TensorFlow 模型转换为 PyTorch 模型,反之亦然。

- **混合模型:**可以在单个项目中同时使用 TensorFlow 和 PyTorch,通过 `torch.nn.Module` 和 `tf.keras.Model` 之间的转换进行互操作。

- **自定义操作:**可以通过编写自定义操作来将 TensorFlow 操作集成到 PyTorch 模型中,或将 PyTorch 操作集成到 TensorFlow 模型中。

#### 4.1.2 TensorFlow GPU 与 Keras 的集成

Keras 是一个高级神经网络 API,它建立在 TensorFlow 之上,提供用户友好的界面和预构建的模型。TensorFlow GPU 与 Keras 无缝集成,允许用户利用 GPU 加速来训练和部署 Keras 模型。

- **Keras 模型的 GPU 加速:**可以通过将 `tf.keras.backend.set_floatx('float32')` 添加到代码中来启用 Keras 模型的 GPU 加速。

- **自定义 Keras 层:**可以通过继承 `tf.keras.layers.Layer` 类并使用 TensorFlow GPU 操作来创建自定义 Keras 层。

- **Keras 回调:**可以使用 Keras 回调来监视和优化 TensorFlow GPU 训练过程。

### 4.2 TensorFlow GPU 在分布式训练中的应用

#### 4.2.1 分布式训练的原理和架构

分布式训练是一种在多台机器上并行训练模型的技术。它可以显着缩短训练时间,特别是在处理大型数据集时。

- **数据并行:**将训练数据拆分为多个部分,并在不同的机器上同时训练模型的不同部分。

- **模型并行:**将模型拆分为多个部分,并在不同的机器上同时训练模型的不同部分。

- **混合并行:**结合数据并行和模型并行以实现最佳性能。

#### 4.2.2 TensorFlow GPU 在分布式训练中的实现

TensorFlow 提供了分布式训练的内置支持,允许用户在多台机器上轻松训练模型。

- **`tf.distribute` 模块:**提供用于创建和管理分布式策略的 API。

- **`tf.data.Dataset`:**提供用于创建和处理分布式数据集的 API。

- **`tf.keras.Model`:**可以通过使用 `tf.distribute.MirroredStrategy` 策略来分布式训练 Keras 模型。

### 4.3 TensorFlow GPU 在云计算中的应用

#### 4.3.1 云平台的 GPU 资源管理

云平台提供按需访问 GPU 资源的能力,允许用户在需要时扩展或缩减其计算能力。

- **AWS EC2 G4 实例:**提供基于 NVIDIA Tesla GPU 的高性能计算实例。

- **Azure NV 系列 VM:**提供基于 NVIDIA Tesla GPU 的虚拟机,具有高内存和低延迟。

- **Google Cloud Compute Engine N2 实例:**提供基于 NVIDIA Tesla GPU 的计算实例,具有高性能和可扩展性。

#### 4.3.2 TensorFlow GPU 在云平台上的部署和使用

TensorFlow 提供了用于在云平台上部署和使用 GPU 加速模型的工具和服务。

- **TensorFlow Serving:**一个用于部署和服务 TensorFlow 模型的框架,支持 GPU 加速。

- **Google Cloud AI Platform:**一个托管式平台,提供用于训练和部署 TensorFlow 模型的工具和服务,包括 GPU 加速。

- **Azure Machine Learning:**一个托管式平台,提供用于训练和部署 TensorFlow 模型的工具和服务,包括 GPU 加速。

# 5. TensorFlow GPU 加速常见问题解答

### 5.1 GPU 加速失败的常见原因

**原因 1:CUDA 版本不兼容**

* 确保安装的 CUDA 版本与 TensorFlow GPU 版本兼容。

* 检查 CUDA 和 TensorFlow 版本是否匹配。

**原因 2:驱动程序问题**

* 更新到最新版本的 GPU 驱动程序。

* 检查驱动程序是否与 CUDA 版本兼容。

**原因 3:显存不足**

* 确保 GPU 具有足够的显存来处理模型和数据。

* 考虑使用较小的模型或减少训练数据量。

**原因 4:内存泄漏**

* 检查 TensorFlow 代码是否存在内存泄漏。

* 使用内存分析工具(如 Valgrind)来识别泄漏。

### 5.2 GPU 性能瓶颈的分析和解决

**瓶颈 1:数据传输**

* 优化数据加载和预处理过程。

* 使用异步数据加载和预取。

**瓶颈 2:内存管理**

* 优化张量转换和内存分配。

* 使用 TensorFlow 的 `tf.data` API 来管理数据。

**瓶颈 3:计算效率**

* 优化计算图,减少不必要的操作。

* 使用 TensorFlow 的 `tf.function` API 来加速计算。

### 5.3 TensorFlow GPU 版本更新和兼容性

**版本更新**

* 定期更新 TensorFlow GPU 版本以获得最新功能和性能改进。

* 确保更新过程不会破坏现有代码。

**兼容性**

* 检查新版本 TensorFlow GPU 与现有代码和环境的兼容性。

* 使用 TensorFlow 的兼容性工具来验证兼容性。

**代码修改**

* 如果更新后出现兼容性问题,可能需要修改代码以适应新版本。

* 参考 TensorFlow 的迁移指南以获取具体指导。

# 6. TensorFlow GPU 加速未来展望

### 6.1 GPU 硬件的发展趋势

随着人工智能技术的发展,GPU 硬件也在不断演进,以满足日益增长的计算需求。未来的 GPU 硬件将朝着以下几个方向发展:

- **计算能力提升:** GPU 将采用更先进的工艺制程,集成更多的计算单元,从而显著提升计算能力。

- **内存带宽优化:** GPU 将配备更高带宽的内存,以满足大型模型训练和推理的需求。

- **能效提升:** GPU 将采用更节能的设计,以降低功耗和提高能效。

- **异构计算:** GPU 将与其他计算单元(如 CPU、FPGA)集成,形成异构计算平台,实现更灵活高效的计算。

### 6.2 TensorFlow GPU 加速技术的创新

TensorFlow GPU 加速技术也在不断创新,以充分利用 GPU 硬件的优势。未来的 TensorFlow GPU 加速技术将重点关注以下方面:

- **自动并行化:** TensorFlow 将引入更多自动并行化技术,简化并行代码的编写,提高代码效率。

- **混合精度训练:** TensorFlow 将支持混合精度训练,使用不同的精度级别进行计算,以提高训练效率和模型精度。

- **分布式训练优化:** TensorFlow 将优化分布式训练性能,支持更大型的模型和更复杂的训练任务。

- **云原生集成:** TensorFlow 将与云平台深度集成,提供无缝的 GPU 加速体验,简化部署和管理。

### 6.3 TensorFlow GPU 加速在人工智能领域的应用前景

TensorFlow GPU 加速在人工智能领域具有广阔的应用前景,将推动人工智能技术的发展和应用。未来的 TensorFlow GPU 加速将在以下领域发挥重要作用:

- **自然语言处理:** TensorFlow GPU 加速将使自然语言处理模型能够处理更大量的数据,实现更准确的文本理解和生成。

- **计算机视觉:** TensorFlow GPU 加速将使计算机视觉模型能够处理更高分辨率的图像和视频,实现更精细的物体检测和识别。

- **语音识别:** TensorFlow GPU 加速将使语音识别模型能够处理更复杂的语音信号,实现更准确的语音转录和合成。

- **自动驾驶:** TensorFlow GPU 加速将使自动驾驶模型能够处理海量的传感器数据,实现更安全的决策和控制。

- **医疗保健:** TensorFlow GPU 加速将使医疗保健模型能够处理大量患者数据,实现更精准的疾病诊断和治疗。

0

0