深入理解机器学习:正则化技术与参数范数惩罚

发布时间: 2024-11-24 21:56:45 阅读量: 38 订阅数: 33

正则化方法在机器学习的应用及实现详解

# 1. 机器学习中的过拟合问题

机器学习模型的训练过程中,不可避免地会遇到过拟合的问题,它是指模型在训练数据上表现良好,但在新的、未见过的数据上表现不佳的情况。过拟合发生时,模型过于复杂,捕捉了训练数据中的噪声和细节,而不是背后的潜在规律。

## 过拟合和欠拟合概念

### 定义及其影响

过拟合是模型对训练数据学习得太彻底,以至于捕捉到了数据中的随机误差和噪声,失去了泛化能力。相反,欠拟合指的是模型过于简单,未能捕捉到数据中的有效结构。

### 识别过拟合与欠拟合

识别过拟合与欠拟合的方法包括:通过在独立的验证集上评估模型性能,绘制学习曲线,和检查模型的预测误差是否随训练数据量增加而减小等。当模型在训练集上的性能远优于验证集时,过拟合的可能性就很高。如果两者性能都很差,模型可能出现了欠拟合。

## 正则化技术基础

### 正则化的目的和功能

正则化是缓解过拟合的一个重要手段,通过在损失函数中增加一个额外的惩罚项,限制模型的复杂度,促使模型学习到更平滑的函数,减少对训练数据的过度拟合。

### 正则化与模型复杂度

引入正则化后,模型的复杂度不再是单纯地增加模型容量,而是需要在模型的拟合能力和复杂度之间找到平衡点,以避免过拟合同时保证模型具有足够的拟合能力。

# 2. 正则化技术基础

### 2.1 过拟合和欠拟合概念

#### 2.1.1 定义及其影响

在机器学习中,过拟合和欠拟合是两个必须了解和处理的重要概念。过拟合是指模型在训练数据上学习得太好,以至于它开始捕捉数据中的噪声和异常值,而不是潜在的通用模式。这通常会导致模型在未见数据上的表现不佳。过拟合的模型具有高度的复杂性,而这种复杂性并不是对问题本质的反映,而是对训练数据特定性质的过度拟合。

欠拟合发生在模型过于简单,无法捕捉数据中的潜在规律和趋势时。与过拟合相反,欠拟合的模型可能无法在训练集上实现良好的性能,更不用说新的、未见过的数据了。欠拟合通常表现为模型的容量不足,无法适应数据的复杂性。

识别过拟合或欠拟合对于优化机器学习模型至关重要。一些诊断工具,比如学习曲线,可以帮助我们判断模型是否正在过拟合或欠拟合。

#### 2.1.2 识别过拟合与欠拟合

识别过拟合和欠拟合的典型方法是绘制学习曲线。学习曲线是模型在训练集和验证集上的性能随训练样本数量增加而绘制的图表。

- 在欠拟合的情况下,模型对训练集和验证集上的表现都会很差。

- 在过拟合的情况下,模型在训练集上的性能会很好,但验证集上的性能会显著下降。

下面是一个学习曲线的示例代码,使用Python中的matplotlib库来绘制:

```python

import numpy as np

import matplotlib.pyplot as plt

from sklearn.model_selection import learning_curve

from sklearn.datasets import make_classification

from sklearn.linear_model import Perceptron

# 生成模拟数据

X, y = make_classification(n_samples=1000, random_state=42)

# 训练模型

train_sizes, train_scores, test_scores = learning_curve(Perceptron(), X, y, cv=5, scoring='accuracy', train_sizes=np.linspace(.1, 1.0, 5))

# 计算平均准确率和标准差

train_mean = np.mean(train_scores, axis=1)

train_std = np.std(train_scores, axis=1)

test_mean = np.mean(test_scores, axis=1)

test_std = np.std(test_scores, axis=1)

# 绘制学习曲线

plt.plot(train_sizes, train_mean, '--', color="#111111", label="Training score")

plt.plot(train_sizes, test_mean, color="#111111", label="Cross-validation score")

# 填充区域表示标准差

plt.fill_between(train_sizes, train_mean - train_std, train_mean + train_std, color="#DDDDDD")

plt.fill_between(train_sizes, test_mean - test_std, test_mean + test_std, color="#DDDDDD")

# 绘制图表

plt.title("Learning Curve")

plt.xlabel("Training Set Size"), plt.ylabel("Accuracy Score"), plt.legend(loc="best")

plt.tight_layout()

plt.show()

```

### 2.2 正则化技术的引入

#### 2.2.1 正则化的目的和功能

正则化是一种用于防止机器学习模型过拟合的技术。它的目的是加入额外的信息,以减少模型的复杂性,使模型更加泛化。正则化通过向模型的损失函数添加一个额外的项来工作,这个项惩罚模型的某些参数值,迫使它们趋向于零。这样,正则化就可以通过减少模型中参数的数量或减少参数值的大小来减少过拟合。

例如,L2正则化(也称为权重衰减)会惩罚大的权重值,倾向于创建更平滑的模型边界,从而使模型在新的数据点上具有更好的泛化能力。

#### 2.2.2 正则化与模型复杂度

正则化的核心在于平衡模型的性能和复杂度。模型复杂度高会导致过拟合,而复杂度低则可能导致欠拟合。正则化参数控制着对复杂度的惩罚程度:

- 在正则化强度较低时,模型可能倾向于过拟合。

- 增加正则化强度会限制模型复杂度,以达到更好的泛化效果,但强度过大又可能导致欠拟合。

### 2.3 正则化在机器学习中的应用

#### 2.3.1 常见正则化方法

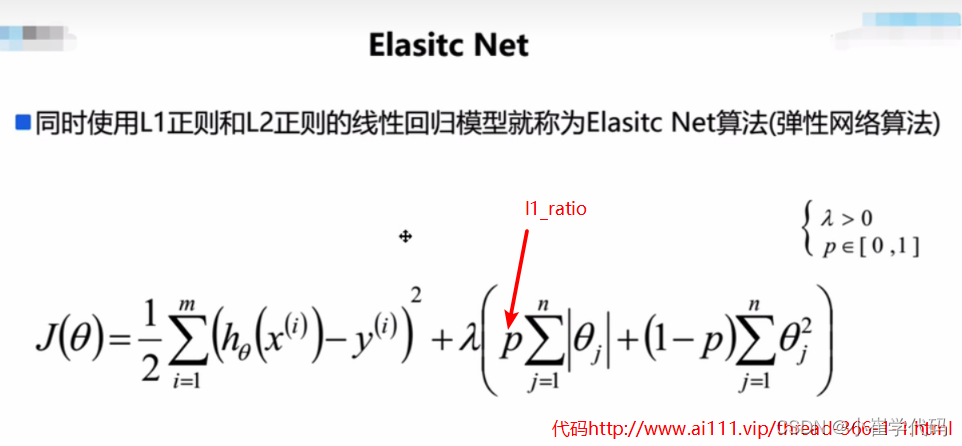

在机器学习中,最常见的一些正则化方法包括L1和L2正则化,以及弹性网络(Elastic Net),这些方法在不同的算法中以不同的方式实现。

- L1正则化为参数的绝对值之和加罚项,它倾向于产生稀疏模型,因此可以用于特征选择。

- L2正则化是参数的平方和的罚项,倾向于产生平滑的决策边界,避免过大的权重值。

下面是一个实现L2正则化(Ridge回归)的Python代码示例:

```python

from sklearn.linear_model import Ridge

from sklearn.model_selection import train_test_split

from sklearn.metrics import mean_squared_error

from sklearn.datasets import make_regression

# 生成模拟数据

X, y = make_regression(n_samples=1000, n_features=20, noise=0.1, random_state=42)

# 分割数据集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 设置Ridge回归模型

ridge_reg = Ridge(alpha=1)

# 训练模型并计算MSE

ridge_reg.fit(X_train, y_train)

y_pred = ridge_reg.predict(X_test)

mse = mean_squared_error(y_test, y_pred)

print(f"Mean Squared Error of Ri

```

0

0