【贪心算法入门】:数据结构与算法的初步探索

发布时间: 2024-09-10 05:54:58 阅读量: 168 订阅数: 44

用python学习数据结构与算法 教程

# 1. 贪心算法概述

在计算机科学与算法研究中,贪心算法(Greedy Algorithm)是一种在每一步选择中都采取在当前状态下最好或最优(即最有利)的选择,从而希望导致结果是全局最好或最优的算法。它是一类简单而又具有深远意义的算法思想。

贪心算法的基本特点是在决策过程中仅考虑当前状态下最好的选择,而不考虑后续步骤可能带来的影响,因此,其解决策略并不保证会得到最优解,但通常可以得到局部最优解。尽管如此,贪心算法在处理特定类型的问题时,如最小生成树问题、活动选择问题等,却能高效地找到问题的最优解。

## 1.1 贪心算法的应用场景

贪心算法广泛应用于优化问题,尤其是那些具有“贪心选择性质”的问题,即局部最优选择能决定全局最优解的情况。例如,在排序和搜索算法中,贪心算法能够有效地找到数据的最优排序。在资源分配和任务调度等问题中,贪心策略也常常被用来简化决策过程,降低计算复杂度。

通过本章的学习,我们将对贪心算法有一个全面的认识,为后续章节中探讨贪心算法的理论基础、具体应用和优化策略打下坚实的基础。

# 2. 贪心算法基础理论

### 2.1 贪心算法的定义和原理

#### 2.1.1 贪心算法的基本概念

贪心算法是一种在每一步选择中都采取在当前状态下最好或最优(即最有利)的选择,从而希望导致结果是全局最好或最优的算法。贪心算法不一定能解决所有问题,但它在某些问题上能够找到最优解,特别是在问题具有“贪心选择性质”时。

贪心算法的三个基本要素为:

1. **最优子结构**:一个问题的最优解包含其子问题的最优解。

2. **贪心选择性质**:通过局部最优解能产生全局最优解。

3. **构造问题的解**:通过一系列的贪心选择,最终构造出问题的解。

#### 2.1.2 贪心选择性质与最优子结构

贪心选择性质和最优子结构是贪心算法能够工作的核心。

- **贪心选择性质**:在解决问题的过程中,所做的每一个决定都是当前状态下的最佳选择,且这种选择不依赖于后续步骤的决策。

- **最优子结构**:一个问题的最优解包含其子问题的最优解。也就是说,问题可以分解为几个子问题,而这些子问题的解可以通过某种方式组合起来,形成原问题的解。

在实际应用中,证明贪心选择性质和最优子结构的存在性是至关重要的步骤。没有这个证明,就不能保证贪心算法得到的是最优解。

### 2.2 贪心策略分析

#### 2.2.1 贪心策略的分类和选择

贪心策略根据问题的不同,可以分为多种类型,如活动选择问题的最优策略、硬币找零问题中的最少硬币数策略等。选择贪心策略时,需要考虑以下因素:

1. **问题的类型**:根据问题是否有贪心选择性质来判断是否适用贪心算法。

2. **策略的效果**:不同的贪心策略可能会产生不同的解,选择时需考虑策略带来的效益和计算复杂度。

3. **策略的适用范围**:同一策略可能仅适用于特定类型的问题。

#### 2.2.2 贪心策略的适用性分析

贪心策略的成功应用依赖于两个关键因素:

- **问题的特性**:问题必须满足贪心选择性质和最优子结构。如果问题不满足这两个特性,贪心算法可能无法找到最优解。

- **贪心策略的验证**:即使问题满足贪心算法的适用条件,也需要对选定的策略进行严格证明。证明可以通过数学归纳法或构造反例来完成。

### 2.3 贪心算法的时间复杂度

#### 2.3.1 时间复杂度的基本概念

时间复杂度是评价算法运行时间的一个度量标准,用于描述算法执行所需要的基本操作数。它通常用大O符号表示,如O(n)、O(log n)等。

- **大O符号**:表示的是算法运行时间随输入规模增加的增长速度。

- **渐进时间复杂度**:忽略了常数系数和低阶项,关注算法运行时间随输入规模增长的趋势。

#### 2.3.2 常见贪心算法的时间复杂度分析

贪心算法的时间复杂度一般相对较低,因为它只关注于局部最优解,并且通常不需要递归或者回溯。

- **排序算法**:如堆排序、快速排序的贪心实现,其时间复杂度为O(n log n)。

- **图论算法**:如Dijkstra算法和Prim算法,在最坏情况下时间复杂度为O(E log V),其中E是边数,V是顶点数。

- **字符串处理**:如Huffman编码的贪心算法实现,其时间复杂度取决于构建树的过程,通常是O(n log n),其中n是字符集的大小。

贪心算法虽然通常具有较低的时间复杂度,但是它并不总是能找到最优解。因此,在使用贪心算法时需要仔细评估问题是否适合使用贪心策略。

通过本章节的介绍,我们将深入理解贪心算法的基础理论,为后续章节中探讨贪心算法在不同领域中的应用以及实际案例分析奠定坚实的理论基础。

# 3. 贪心算法经典问题与解法

## 3.1 贪心算法在排序问题中的应用

### 3.1.1 堆排序的贪心实现

堆排序是一种基于比较的排序算法,它利用堆这种数据结构来进行排序。堆是一个近似完全二叉树的结构,并同时满足堆积的性质,即子节点的键值或索引总是小于(或者大于)它的父节点。

堆排序的过程分为两个步骤:

1. 构建最大堆:将给定无序数据调整为最大堆,这样最大元素就位于堆的顶端。

2. 堆调整:将堆顶元素(最大元素)与堆的最后一个元素交换,然后缩小堆的范围,对新的堆顶元素执行下沉操作,使其满足最大堆的性质。

```python

import heapq

def heapify(arr, n, i):

largest = i

left = 2 * i + 1

right = 2 * i + 2

if left < n and arr[i] < arr[left]:

largest = left

if right < n and arr[largest] < arr[right]:

largest = right

if largest != i:

arr[i], arr[largest] = arr[largest], arr[i]

heapify(arr, n, largest)

def heapSort(arr):

n = len(arr)

# Build a maxheap.

for i in range(n // 2 - 1, -1, -1):

heapify(arr, n, i)

# One by one extract elements

for i in range(n-1, 0, -1):

arr[i], arr[0] = arr[0], arr[i] # swap

heapify(arr, i, 0)

arr = [12, 11, 13, 5, 6, 7]

heapSort(arr)

n = len(arr)

print("Sorted array is:")

for i in range(n):

print("%d" % arr[i], end=" ")

```

这段代码首先构建一个最大堆,然后通过交换堆顶元素与最后一个元素并进行下沉操作来构建最终的有序数组。每一次迭代,数组的有序度越来越高。

### 3.1.2 桶排序与计数排序的贪心策略

**桶排序**利用了散列函数,将数据分布到有限数量的桶里,每个桶再分别排序(有可能再使用别的排序算法或是以递归方式继续使用桶排序进行排序)。

**计数排序**是一种非比较型排序算法,用于整数排序。它利用数组下标来确定元素的正确位置。计数排序的核心在于将输入的数据值转化为键存储在额外开辟的数组空间里。

#### 桶排序的步骤

1. 遍历输入数组,确定其范围。

2. 创建足够数量的桶来存储每个键值。

3. 分配每个元素到相应的桶中。

4. 对每个非空桶应用其他排序算法。

5. 拼接有序的桶。

#### 计数排序的步骤

1. 找出待排序的数组中最大和最小的元素。

2. 统计数组中每个值为i的元素出现的次数,存入数组C的第i项。

3. 对所有的计数累加(从C中的第一个元素开始,每一项和前一项相加)。

4. 反向填充目标数组:将每个元素i放在新数组的第C(i)项,每放一个元素就将C(i)减去1。

桶排序和计数排序都是非比较型排序算法,适用于一定范围内的整数排序。通过将值分配到有限数量的桶中,然后对每个桶分别进行排序,贪心地利用了数据的分布特性。

## 3.2 贪心算法在图论中的应用

### 3.2.1 最小生成树问题

在图论中,最小生成树问题是指在一个加权无向图中找到一个边的子集,使得这个子集构成的树包含图中的所有顶点,并且边的权值之和最小。这类问题在许多实际场景中都非常常见,如设计电信网络、交通网络等。

#### Prim算法

Prim算法是一种贪心算法,用于最小生成树的构建。它的基本思想是:

1. 从任意一个顶点开始,选择与它相连的最小边(权重最小),将这条边以及它的另一个顶点加入到已选择的顶点集合中。

2. 重复步骤1,直到选择了n-1条边,包含了所有的顶点。

```python

import sys

class Graph():

def __init__(self, vertices):

self.V = vertices

self.graph = [[0 for column in range(vertices)]

for row in range(vertices)]

def printMST(self, parent):

print("Edge \tWeight")

for i in range(1, self.V):

print(parent[i], "-", i, "\t", self.graph[i][parent[i]])

def minKey(self, key, mstSet):

min = sys.maxsize

for v in range(self.V):

if key[v] < min and mstSet[v] == False:

min = key[v]

min_index = v

return min_index

def primMST(self):

key = [sys.maxsize] * self.V

parent = [None] * self.V

key[0] = 0

mstSet = [False] * self.V

for cout in range(self.V):

u = self.minKey(key, mstSet)

mstSet[u] = True

for v in range(self.V):

if self.graph[u][v] > 0 and mstSet[v] == False and key[v] > self.graph[u][v]:

key[v] = self.graph[u][v]

parent[v] = u

self.printMST(parent)

g = Graph(5)

g.graph = [[0, 2, 0, 6, 0],

[2, 0, 3, 8, 5],

[0, 3, 0, 0, 7],

[6, 8, 0, 0, 9],

[0, 5, 7, 9, 0]]

g.primMST()

```

#### Kruskal算法

另一种构建最小生成树的贪心算法是Kruskal算法。它的基本思想是:

1. 将所有边按权重从小到大排序。

2. 遍历排序后的边,选择不会与已选择的边构成环的最小边加入最小生成树。

3. 重复步骤2,直到最小生成树中有n-1条边。

```python

class Graph():

def __init__(self, vertices):

self.V = vertices

self.graph = []

def find(self, parent, i):

if parent[i] == i:

return i

return self.find(parent, parent[i])

def union(self, parent, rank, x, y):

xroot = self.find(parent, x)

yroot = self.find(parent, y)

if rank[xroot] < rank[yroot]:

parent[xroot] = yroot

elif rank[xroot] > rank[yroot]:

parent[yroot] = xroot

else:

parent[yroot] = xroot

rank[xroot] += 1

def KruskalMST(self):

result = []

i = 0

e = 0

self.graph = sorted(self.graph, key=lambda item: item[2])

parent = []

rank = []

for node in range(self.V):

parent.append(node)

rank.append(0)

while e < self.V - 1:

u, v, w = self.graph[i]

i = i + 1

x = self.find(parent, u)

y = self.find(parent, v)

if x != y:

e = e + 1

result.append([u, v, w])

self.union(parent, rank, x, y)

for u, v, weight in result:

print("%d - %d: %d" % (u, v, weight))

g = Graph(4)

g.graph = [[0, 1, 10],

[0, 2, 6],

[0, 3, 5],

[1, 3, 15],

[2, 3, 4]]

g.KruskalMST()

```

在这段代码中,边是按权重排序后被处理的,并通过`find`和`union`函数来确保构成的树是无环的。

### 3.2.2 最短路径问题的贪心解法

在图论中,最短路径问题旨在找到图中两个顶点之间的最短路径。贪心算法在这里的一个经典解法是Dijkstra算法。

Dijkstra算法的基本思想是贪心地选择距离起始点最近的顶点,然后更新其他顶点到起始点的距离。

#### Dijkstra算法步骤

1. 创建两个集合:已处理的集合S和未处理的集合U。

2. 将起始顶点d的距离设置为0,其他所有顶点到d的距离设置为无穷大。

3. 当未处理的顶点不为空时:

- 从未处理的顶点集合中选择一个距离起始顶点d最近的顶点u。

- 将顶点u移动到已处理的集合S中。

- 更新顶点u的邻居顶点的最短距离。

```python

import sys

class Graph():

def __init__(self, vertices):

self.V = vertices

self.graph = [[0 for column in range(vertices)]

for row in range(vertices)]

def minDistance(self, dist, sptSet):

min = sys.maxsize

for v in range(self.V):

if dist[v] < min and sptSet[v] == False:

min = dist[v]

min_index = v

return min_index

def dijkstra(self, src):

dist = [sys.maxsize] * self.V

dist[src] = 0

sptSet = [False] * self.V

for cout in range(self.V):

u = self.minDistance(dist, sptSet)

sptSet[u] = True

for v in range(self.V):

if self.graph[u][v] > 0 and sptSet[v] == False and \

dist[v] > dist[u] + self.graph[u][v]:

dist[v] = dist[u] + self.graph[u][v]

self.printSolution(dist)

def printSolution(self, dist):

print("Vertex \t Distance from Source")

for node in range(self.V):

print(node, "\t", dist[node])

g = Graph(9)

g.graph = [[0, 4, 0, 0, 0, 0, 0, 8, 0],

[4, 0, 8, 0, 0, 0, 0, 11, 0],

[0, 8, 0, 7, 0, 4, 0, 0, 2],

[0, 0, 7, 0, 9, 14, 0, 0, 0],

[0, 0, 0, 9, 0, 10, 0, 0, 0],

[0, 0, 4, 14, 10, 0, 2, 0, 0],

[0, 0, 0, 0, 0, 2, 0, 1, 6],

[8, 11, 0, 0, 0, 0, 1, 0, 7],

[0, 0, 2, 0, 0, 0, 6, 7, 0]]

g.dijkstra(0)

```

这段代码实现了Dijkstra算法,并展示了如何通过贪心策略找到图中从源顶点到其他所有顶点的最短路径。

## 3.3 贪心算法在字符串处理中的应用

### 3.3.1 字符串哈夫曼编码

哈夫曼编码是一种广泛使用的数据压缩的贪心算法。它基于字符出现频率来构造最优的前缀编码,这种编码具有最小的预期编码长度。

#### 哈夫曼编码的步骤

1. 统计每个字符的频率。

2. 根据频率构建优先队列(最小堆)中的树节点。

3. 构建哈夫曼树:

- 当堆中只剩下一个节点时,构造完成。

- 否则,从堆中取出两个频率最低的节点作为新节点的左右子节点,新节点的频率为左右子节点频率之和。

- 将新节点加入优先队列。

4. 生成哈夫曼编码:

- 从哈夫曼树的根节点开始,向左走记为0,向右走记为1。

- 从根节点到每个叶节点的路径构成一个字符的编码。

```python

import heapq

import string

class Node:

def __init__(self, char, freq):

self.char = char

self.freq = freq

self.left = None

self.right = None

def __lt__(self, other):

return self.freq < other.freq

def calculate_frequency(text):

frequency = {}

for char in text:

if char not in frequency:

frequency[char] = 0

frequency[char] += 1

return frequency

def build_huffman_tree(frequency):

priority_queue = [Node(char, freq) for char, freq in frequency.items()]

heapq.heapify(priority_queue)

while len(priority_queue) > 1:

left = heapq.heappop(priority_queue)

right = heapq.heappop(priority_queue)

merged = Node(None, left.freq + right.freq)

merged.left = left

merged.right = right

heapq.heappush(priority_queue, merged)

return priority_queue[0]

def generate_codes(node, prefix="", code={}):

if node is not None:

if node.char is not None:

code[node.char] = prefix

generate_codes(node.left, prefix + "0", code)

generate_codes(node.right, prefix + "1", code)

return code

def huffman_encoding(text):

frequency = calculate_frequency(text)

huffman_tree = build_huffman_tree(frequency)

huffman_code = generate_codes(huffman_tree)

encoded_text = ""

for char in text:

encoded_text += huffman_code[char]

return encoded_text, huffman_code

text = "this is an example for huffman encoding"

encoded_text, huffman_code = huffman_encoding(text)

print("Huffman Codes are:")

for char, code in huffman_code.items():

print(f"{char}: {code}")

print("\nOriginal text was:")

print(text)

print("\nEncoded text is:")

print(encoded_text)

```

### 3.3.2 字符串匹配问题的贪心解法

在字符串匹配问题中,一个著名且有效的贪心算法是KMP算法(Knuth-Morris-Pratt)。它通过一个预处理步骤构建部分匹配表(也称为失败函数或next数组),这样在不匹配时能够跳过尽可能多的字符。

#### KMP算法的步骤

1. 构建部分匹配表:

- 部分匹配表记录了模式字符串中前后缀的最长公共元素长度。

2. 进行文本匹配:

- 遍历文本字符串,同时使用模式字符串和部分匹配表。

- 如果当前字符匹配成功(即,`text[i] == pattern[j]`),则i++和j++。

- 如果不匹配(即`text[i] != pattern[j]`),利用部分匹配表找到模式字符串的下一个匹配位置。

```python

def compute_prefix_function(pattern):

prefix = [0] * len(pattern)

k = 0

for q in range(1, len(pattern)):

while k > 0 and pattern[k] != pattern[q]:

k = prefix[k - 1]

if pattern[k] == pattern[q]:

k += 1

prefix[q] = k

return prefix

def kmp_search(text, pattern):

m, n = len(text), len(pattern)

if m < n:

return -1

prefix = compute_prefix_function(pattern)

q = 0

for i in range(m):

while q > 0 and pattern[q] != text[i]:

q = prefix[q - 1]

if pattern[q] == text[i]:

q += 1

if q == n:

return i - n + 1

return -1

text = "ABABDABACDABABCABAB"

pattern = "ABABCABAB"

index = kmp_search(text, pattern)

print(f"Pattern found at index {index}")

```

这段代码展示了如何构建部分匹配表,并在实际字符串中高效地进行模式匹配。

通过上述内容的介绍,我们展示了贪心算法在排序、图论和字符串处理三个领域的经典问题及其解决方案。贪心算法通过在每一步都做出最优的选择,能够以较短的路径达到问题的局部最优解。然而,在下一章中,我们将探讨贪心算法的局限性,以及如何在特定情况下结合其他算法技术来克服这些局限性。

# 4. 贪心算法实践案例分析

## 4.1 贪心算法在资源调度中的应用

贪心算法在资源调度问题中的应用是将有限的资源分配给若干个任务,以达到某种优化目标,比如最大化资源利用效率、最小化完成时间等。资源调度问题广泛存在于工业生产、交通运输、计算机系统等多个领域。

### 4.1.1 任务调度问题的贪心解决方案

任务调度问题通常指的是在资源有限的情况下,如何高效地安排任务以满足特定的时间和资源约束。贪心算法在这里可以用来决定任务的执行顺序和资源的分配。

一个典型的问题是单处理器调度问题,其中任务有各自的执行时间,目标是最小化完成所有任务的总时间。解决这类问题的一种贪心策略是将任务按照最短处理时间优先的规则进行排序,然后依次执行。

```python

import heapq

def schedule_tasks(tasks):

# 根据任务执行时间创建最小堆

min_heap = [(time, i) for i, time in enumerate(tasks)]

heapq.heapify(min_heap)

# 总时间初始化为0

total_time = 0

while min_heap:

# 取出当前执行时间最短的任务

time, task_id = heapq.heappop(min_heap)

total_time += time

print(f"Executing Task {task_id}, Time: {time}")

return total_time

# 示例任务执行时间列表

tasks = [2, 1, 3, 4]

schedule_time = schedule_tasks(tasks)

print(f"Total Time: {schedule_time}")

```

在这段Python代码中,我们使用了一个最小堆来存储任务的执行时间,每次从堆中取出最小的执行时间,保证了任务总是按照最短执行时间优先的原则进行调度。这种方式是一种贪心策略,尽管它并不能保证全局最优解,但在很多情况下可以得到不错的结果。

### 4.1.2 资源分配问题的贪心策略

资源分配问题涉及到将一定数量的资源分配给若干个请求,目标是满足请求的同时保证资源利用率最大化。贪心算法在这个场景下的一个应用是多处理器调度问题。

一个多处理器调度问题的贪心策略可能基于任务优先级分配处理器资源。具体地,可以将任务按照某个优先级规则排序,然后为每个任务分配空闲的处理器资源。如果所有处理器都忙,则将任务放入等待队列。

```python

from collections import defaultdict

def resource_allocation(tasks, resources):

# 按照资源需求对任务进行排序

sorted_tasks = sorted(tasks, key=lambda x: x[1], reverse=True)

# 分配资源的字典

allocations = defaultdict(int)

# 等待队列

waiting_queue = []

for task_id, task_res in sorted_tasks:

if sum(allocations.values()) + task_res <= resources:

# 分配资源

allocations[task_id] = task_res

else:

# 放入等待队列

waiting_queue.append((task_id, task_res))

return allocations, waiting_queue

# 示例任务列表和资源总数

tasks = [(0, 3), (1, 4), (2, 5)]

resources = 10

allocations, waiting_queue = resource_allocation(tasks, resources)

print(f"Allocations: {allocations}")

print(f"Waiting Queue: {waiting_queue}")

```

以上代码展示了如何使用贪心策略解决资源分配问题。首先根据任务所需资源量对任务进行排序,然后为每个任务分配资源。如果资源不足,就将任务加入等待队列。

## 4.2 贪心算法在金融领域的应用

金融领域是贪心算法应用的另一个重要领域,特别是在组合优化问题、金融衍生品定价、风险管理等方面。

### 4.2.1 投资组合优化问题

投资组合优化问题涉及选取若干种金融资产以构成最优的投资组合。这里的“最优”通常指在给定风险水平下收益最大化,或者在给定收益目标下风险最小化。

贪心算法在这个问题中的应用通常是利用贪心选择性质,逐步选择能够最大化期望收益或最小化风险的资产。通过迭代改进,最终获得一个近似的最优解。

```python

def portfolio_optimization(assets):

# 假设assets是一个包含资产收益的列表

sorted_assets = sorted(assets, key=lambda x: x[1]/x[0], reverse=True)

portfolio = []

for asset in sorted_assets:

portfolio.append(asset[0])

return portfolio

# 示例资产列表,每个元素为(资产数量, 资产收益)

assets = [(1000, 0.12), (500, 0.15), (750, 0.13)]

optimal_portfolio = portfolio_optimization(assets)

print(f"Optimal Portfolio: {optimal_portfolio}")

```

在这个例子中,我们使用贪心策略通过最大化收益与风险比来构建最优投资组合。尽管贪心策略不一定能获得全局最优解,但在某些情况下可以接近最优解。

### 4.2.2 货币兑换问题的贪心算法实现

货币兑换问题也是金融领域中贪心算法应用的一个典型案例。问题的目标是在给定一组货币兑换率的情况下,将一笔钱兑换成另一种货币,使得最终获得的货币尽可能多。

贪心策略在这个问题中的应用是按照兑换率从高到低的顺序进行兑换。尽管这个方法在一般情况下不能保证最优解,但对于一些特定的汇率设置,例如没有通货膨胀或汇率之间的乘法关系,这种方法可能有效。

```python

def exchange_money(currencies, amount):

# 对货币兑换率进行排序

sorted_currencies = sorted(currencies.items(), key=lambda x: x[1], reverse=True)

exchange_amount = amount

for currency, rate in sorted_currencies:

if exchange_amount >= rate:

exchange_amount = exchange_amount // rate

else:

break

return exchange_amount

# 示例货币兑换表,键为货币单位,值为兑换率

currencies = {'USD': 1, 'EUR': 1.1, 'GBP': 1.3, 'JPY': 0.009}

amount = 100

exchanged_amount = exchange_money(currencies, amount)

print(f"Exchanged Amount: {exchanged_amount}")

```

此代码段通过贪心算法实现货币兑换。它首先按照兑换率排序,然后循环兑换,直到不能进一步兑换为止。

## 4.3 贪心算法在实际开发中的应用

贪心算法在软件开发中同样有着广泛的应用,特别是在需要高效解决问题的场景。

### 4.3.1 软件工程中的贪心应用案例

软件工程中的贪心算法应用可以表现在诸如软件部署、任务分配等方面。例如,在一个分布式系统中,我们希望在多个服务器上分配任务,目标是最小化任务完成时间。

一种贪心策略是按服务器剩余计算能力分配任务,总是选择当前剩余能力最多的服务器来部署任务,这种方式往往可以达到较好的负载均衡效果。

### 4.3.2 贪心算法在数据压缩中的应用

数据压缩领域也常见贪心算法的身影。例如,霍夫曼编码(Huffman Coding)就是一种广泛使用的贪心算法。霍夫曼编码通过构建最优二叉树来对数据进行压缩,其中每个字符由不同长度的位串表示,出现频率较高的字符使用较短的位串。

以下是构建霍夫曼树的过程,这个过程是贪心策略的典型应用:

```python

from queue import PriorityQueue

class Node:

def __init__(self, char, freq):

self.char = char

self.freq = freq

self.left = None

self.right = None

def __lt__(self, other):

return self.freq < other.freq

def huffman_encoding(data):

frequency = {}

for char in data:

frequency[char] = frequency.get(char, 0) + 1

priority_queue = PriorityQueue()

for key in frequency:

node = Node(key, frequency[key])

priority_queue.put((node.freq, node))

while priority_queue.qsize() > 1:

freq1, node1 = priority_queue.get()

freq2, node2 = priority_queue.get()

merged = Node(None, freq1 + freq2)

merged.left = node1

merged.right = node2

priority_queue.put((merged.freq, merged))

root = priority_queue.get()[1]

# 生成霍夫曼编码

huffman_code = {}

def _generate_codes(node, code):

if node is not None:

if node.char is not None:

huffman_code[node.char] = code

_generate_codes(node.left, code + "0")

_generate_codes(node.right, code + "1")

_generate_codes(root, "")

return huffman_code

# 示例数据字符串

data = "this is an example for huffman encoding"

encoding = huffman_encoding(data)

print(f"Huffman Encoding: {encoding}")

```

在这个代码示例中,我们首先统计数据中每个字符的频率,然后使用一个最小优先队列来创建最优二叉树,最终为每个字符生成一个唯一的霍夫曼编码。贪心策略在这里体现在每次选择最小频率的两个节点合并,从而构造出一个最优的霍夫曼树。

贪心算法以其简单性、快速性和易于实现的特性,在各种资源调度、金融决策、软件工程和数据压缩等领域中广泛应用于解决特定问题。尽管它在许多情况下不能保证最优解,但其优点通常足以让开发者在许多实际场景中选择贪心方法作为一种高效的问题解决方案。

# 5. 贪心算法的局限性与挑战

贪心算法是一种在每一步选择中都采取当前状态下最优选择的算法,它能解决很多优化问题。然而,贪心算法并不总是能够得到全局最优解。为了更深入理解贪心算法在实际应用中可能遇到的挑战,以及如何优化其局限性,本章将探讨贪心算法的局限性、优化策略以及未来的研究方向。

## 5.1 贪心算法的局限性

### 5.1.1 贪心算法无法保证全局最优解的原因

贪心算法之所以在某些问题上无法保证得到全局最优解,主要是因为贪心选择并不总是导致全局最优解。贪心算法在每一步都做出在当前看来最优的选择,但这种选择可能会忽略未来的可能性和约束。例如,在解决旅行商问题(TSP)时,贪心算法可能会选择一条局部较短的路径,但这条路径最终可能延长旅行总距离。

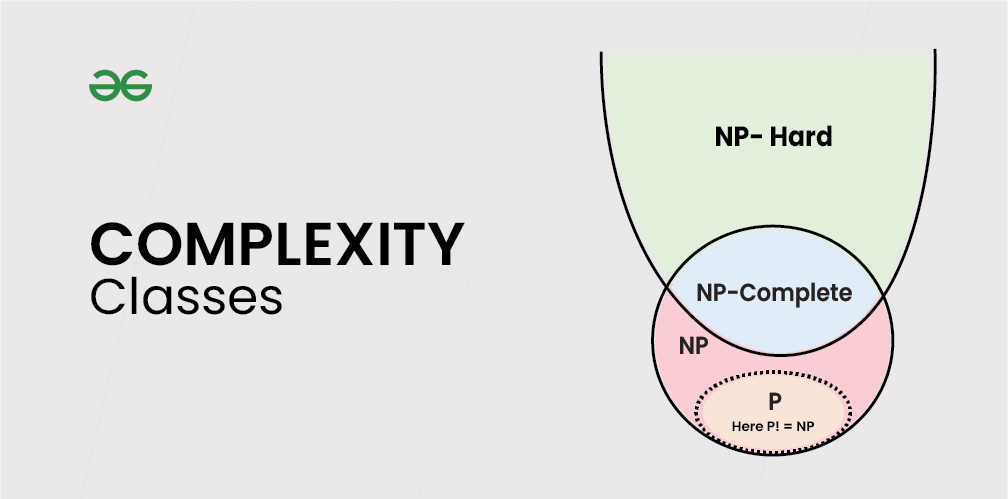

### 5.1.2 贪心算法与动态规划、回溯算法的比较

与贪心算法不同,动态规划和回溯算法能够考虑到问题的整体结构,动态规划通过保存子问题的解以避免重复计算,并最终得到全局最优解;回溯算法则是通过遍历所有可能的解空间来寻找最优解。这三种算法各有优势和适用场景,而贪心算法通常适用于具有最优子结构的问题,在这种问题中,局部最优解能够构建出全局最优解。

## 5.2 贪心算法的优化策略

### 5.2.1 如何结合其他算法优化贪心算法

为了克服贪心算法的局限性,我们可以通过与其他算法结合的方式来优化。例如,在某些图论问题中,可以先使用贪心算法找出一个近似解,然后利用回溯算法对这个解进行微调,以获得更好的结果。此外,在使用贪心算法进行初步求解后,也可以通过局部搜索算法进行优化,以提高解的质量。

### 5.2.2 贪心算法优化的常见方法与实践

贪心算法的优化方法多种多样,常见的有:

- 对贪心策略的选择进行更细致的分析,以确保其适用性;

- 将贪心算法与启发式算法结合,设计出更有效的搜索策略;

- 在解决问题前,先预处理数据,从而减少算法的搜索空间;

- 引入额外的参数来调整贪心策略,使其在不同阶段能够适应不同的情况。

## 5.3 贪心算法未来研究方向

### 5.3.1 新兴应用场景下的贪心算法研究

随着数据科学和人工智能的不断发展,贪心算法在新兴领域如机器学习、大数据分析等方面的应用日益增多。例如,在深度学习中,贪心算法可以用来加速神经网络的训练过程,或者在数据聚类问题中寻找局部最优解。研究者需要不断探索贪心算法在这些新领域中的应用和潜在改进。

### 5.3.2 理论框架的发展与完善

除了实际应用,贪心算法的理论基础也需要不断地发展与完善。这意味着需要对贪心算法的适用条件进行更加深入的理论分析,明确其边界条件,并探究新的贪心策略。研究者们应当致力于设计出更加精确的分析方法,以便更好地理解贪心算法在各种情况下的行为和性能。

贪心算法在解决某些类型的问题时非常高效,但其局限性和挑战性也需要被重视。通过结合其他算法优化和理论框架的发展,我们可以扩展贪心算法的应用范围,并提高其在实际问题中的解决能力。未来的研究将为我们提供更多的洞见,帮助我们更好地利用贪心算法解决日益复杂的问题。

0

0