【Python算法效率分析入门】:掌握基础工具与方法

发布时间: 2024-09-01 06:26:19 阅读量: 236 订阅数: 64

# 1. Python算法效率分析概述

在现代软件开发中,算法效率分析是衡量程序性能的关键。本章将简要概述Python算法效率分析的重要性及其对编程实践的影响。我们将从理解算法效率的必要性开始,探讨如何通过不同的方法来评估和优化Python代码。

## 1.1 理解算法效率的重要性

算法效率衡量的是算法执行所需资源的数量,包括时间复杂度和空间复杂度。高效率的算法可以大幅度减少资源消耗,提高软件的响应速度和处理能力。对于开发者而言,掌握算法效率的分析技巧,对于编写高性能的Python应用程序至关重要。

## 1.2 算法效率与软件性能的关系

算法效率直接影响软件的整体性能。一个高效的算法可以更快速地处理大量数据,响应用户请求,使得软件在面对大规模数据处理时仍能保持高效稳定。因此,算法效率分析不仅是理论上的探讨,更是实践中提升产品竞争力的必要步骤。

通过本章的介绍,我们将为读者铺设理解后续章节的基础,使读者能够在接下来的章节中更深入地探讨Python算法效率的具体分析和优化方法。

# 2. Python算法效率分析基础

### 2.1 时间复杂度和空间复杂度

#### 2.1.1 理解时间复杂度和空间复杂度的概念

在算法领域,时间复杂度和空间复杂度是用来衡量算法效率的两个基本指标。它们描述了算法运行所需要的时间和内存空间如何随着输入数据量的增长而变化。时间复杂度通常用来评估算法执行速度,而空间复杂度用来评估算法所消耗的存储资源。

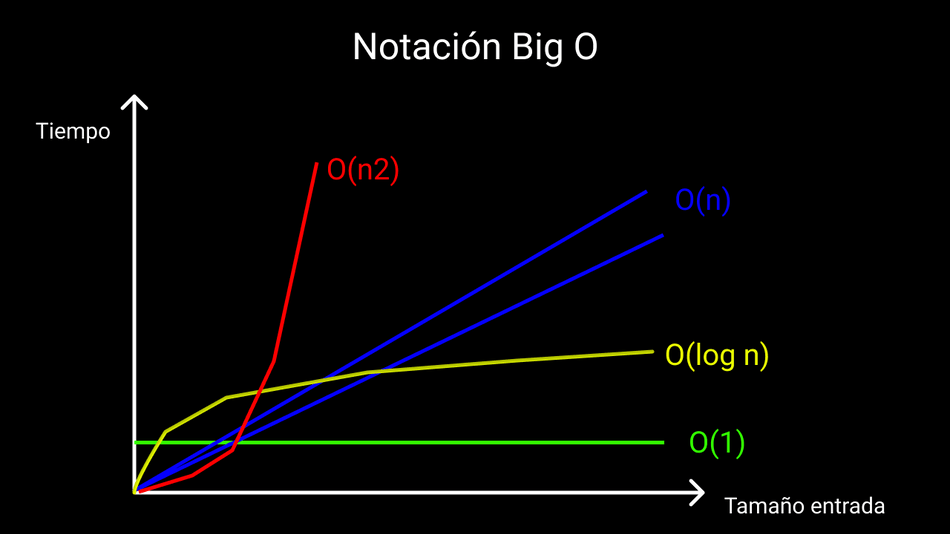

时间复杂度关注的是算法运行次数与输入规模的关系,常以大O符号表示,如O(n),它不会精确计算算法的运行次数,而是描述算法运行时间的增长趋势。空间复杂度则是算法在执行过程中临时占用存储空间的大小,它也以大O符号表示,例如O(1)表示固定的空间需求。

理解和计算时间复杂度和空间复杂度对于编写效率高的代码至关重要。在实际应用中,开发者往往需要在算法效率和资源消耗之间做出权衡。

#### 2.1.2 常见的时间复杂度和空间复杂度分析

下面是常见的时间复杂度和空间复杂度,它们在算法设计和分析中经常被提及:

- O(1):常数时间复杂度,执行时间不随输入数据规模变化。

- O(log n):对数时间复杂度,算法性能与数据规模的对数有关。

- O(n):线性时间复杂度,执行时间与数据规模成正比。

- O(n log n):线性对数时间复杂度,常见于排序算法,如快速排序。

- O(n^2):二次时间复杂度,常见于简单的嵌套循环。

- O(2^n):指数时间复杂度,算法性能随输入数据规模呈指数级增长。

- O(n!):阶乘时间复杂度,是效率最低的常见时间复杂度,常出现在某些问题的所有可能情况都需要考虑的算法中。

空间复杂度亦可类似地分析,其中O(1)是固定的内存需求,而O(n)、O(n^2)等表示随着数据量增加,空间需求按比例增长。

### 2.2 大O表示法

#### 2.2.1 大O表示法的定义和应用

大O表示法(Big O notation)是算法分析中用来描述算法性能的数学表达方式。它简化了计算过程,只关注算法执行时间或空间需求随输入规模增长的趋势,忽略了低阶项和常数因子的影响。比如,一个算法执行操作100次还是50次,对于大O表示法而言是不关心的,只关心操作的次数与输入规模n的关系。

在实际应用中,大O表示法帮助我们区分哪些算法更适合解决大规模问题。例如,排序算法中,冒泡排序的时间复杂度是O(n^2),而快速排序或归并排序的时间复杂度是O(n log n)。在大数据量下,快速排序和归并排序的性能通常优于冒泡排序。

#### 2.2.2 如何通过大O表示法分析算法效率

使用大O表示法分析算法效率通常遵循以下步骤:

1. 确定算法的基本操作,通常是循环的次数或递归的深度。

2. 计算基本操作的次数与输入规模n的关系。

3. 保留最高阶项,忽略低阶项和常数因子。

4. 将操作的数量用大O表示法描述。

例如,对于以下简单代码片段:

```python

for i in range(n):

for j in range(n):

# 基本操作

```

基本操作的次数是n * n,即n^2。因此,该循环的时间复杂度是O(n^2)。

### 2.3 基本数据结构效率分析

#### 2.3.1 列表、元组和字典的操作效率

Python中的列表、元组和字典是常用的数据结构,它们各自有不同的操作效率:

- **列表(List)**:

- 访问元素:O(1) —— 通过索引直接访问。

- 插入/删除元素:O(n) —— 需要移动后续所有元素。

- 追加元素:O(1) —— 列表末尾添加元素通常很快。

- **元组(Tuple)**:

- 访问元素:O(1) —— 与列表相同。

- 不支持元素的插入和删除,因为元组是不可变的。

- **字典(Dictionary)**:

- 访问元素:O(1) —— 哈希表实现,平均情况下访问迅速。

- 插入/删除元素:O(1) —— 通常很快,除非哈希冲突需要调整。

- 字典键的查找速度非常快,但是如果使用不恰当的键类型或出现大量哈希冲突,性能会下降。

#### 2.3.2 集合和字符串操作的时间复杂度

- **集合(Set)**:

- 集合在Python中基于字典实现,因此其访问、插入和删除操作的时间复杂度与字典相同。

- 集合的运算,如并集、交集等,通常都是O(min(len(s), len(t))),其中s和t是操作的集合。

- **字符串(String)**:

- 访问元素:O(1) —— 字符串的索引访问与列表和元组相同。

- 连接字符串:O(n) —— 字符串连接涉及到创建新的字符串。

- 字符串的切片操作:O(k),其中k是要切片的长度。

- 字符串方法如`find()`、`replace()`等时间复杂度取决于具体实现和字符串长度。

通过分析这些基本数据结构的操作效率,我们可以更有针对性地选择合适的数据结构来优化算法性能。

# 3. ```

# 第三章:Python算法效率分析进阶

## 3.1 递归算法的效率分析

递归算法是一种常见的编程技巧,其核心思想是函数调用自身。虽然递归在表达上简洁明了,但如果不恰当使用,可能会导致效率低下,甚至造成栈溢出。对于递归算法的效率分析,需要特别关注时间复杂度的推导和可能的优化策略。

### 3.1.1 递归算法的时间复杂度推导

递归算法的时间复杂度推导通常依赖于递归方程的解法。例如,著名的斐波那契数列问题:

```python

def fibonacci(n):

if n <= 1:

return n

else:

return fibonacci(n-1) + fibonacci(n-2)

```

上述实现的时间复杂度是指数级的,因为每个函数调用都产生两个子调用,直到达到基本情况。随着n的增加,调用次数会以指数方式增长。

为了更准确地推导时间复杂度,我们可以使用递归树来分析。递归树是一个树形结构,它表示了递归函数的每次调用和返回。

推导斐波那契数列的时间复杂度:

1. 在递归树的每一层,调用次数加倍。

2. 树的深度是log(n),因为每次递归调用都将问题规模缩小一半。

3. 每一层的调用总数是2的幂,即2^log(n)。

4. 整个递归调用的次数是n次。

因此,原始递归实现的斐波那契数列的时间复杂度是O(2^n)。

### 3.1.2 优化递归算法的效率技巧

为了优化递归算法的效率,我们可以采用备忘录法(Memoization)或者动态规划法。

备忘录法是存储已经计算过的结果,避免重复计算。以下为斐波那契数列使用备忘录法的代码示例:

```python

def fibonacci_memo(n, memo={}):

if n in memo:

return memo[n]

if n <= 1:

return n

memo[n] = fibonacci_memo(n-1, memo) + fibonacci_memo(n-2, memo)

return memo[n]

```

动态规划法则是将问题分解成小问题,并存储这些小问题的结果。递归调用的过程可以被看作从顶部到底部的构建过程,而动态规划则是从底部到顶部的构建过程。

递归算法的优化往往依赖于对问题深刻的理解和适当的算法设计。正确地应用备忘录法或者动态规划法,可以将原本指数级时间复杂度的递归算法优化到多项式时间复杂度。

## 3.2 动态规划算法的效率分析

动态规划算法是解决复杂问题的方法之一,它将大问题分解为小问题,并利用这些小问题的解来构造大问题的解。动态规划的关键在于找到合适的子结构以及子结构之间的递推关系。

### 3.2.1 动态规划算法的原理

动态规划算法的基本原理是将一个复杂的问题分解成更小的子问题,并存储子问题的解(通常是在一个数组或者哈希表中),以避免重复计算。典型的动态规划算法包含以下步骤:

1. **定义状态**:确定问题的子结构,定义状态变量。

2. **找出状态转移方程**:这是动态规划的核心,描述了不同状态之间的关系。

3. **确定初始条件**:找到动态规划中可以直接求得的基本情况。

4. **确定边界条件**:避免在动态规划过程中出现非法索引。

### 3.2.2 动态规划算法的时间和空间复杂度

动态规划算法的时间复杂度通常与状态转移方程有关。设状态转移方程中涉及到的状态数为k,计算每个状态所需的时间为t,则总的时间复杂度为O(kt)。

空间复杂度通常与存储状态所用的空间有关。如果所有状态都能被存储在一张表中,那么空间复杂度是O(n),其中n是状态表的大小。然而,在某些情况下,可以通过使用滚动数组来降低空间复杂度。

考虑斐波那契数列的动态规划实现:

```python

def fibonacci_dp(n):

dp = [0] * (n+1)

dp[1] = 1

for i in range(2, n+1):

dp[i] = dp[i-1] + dp[i-2]

return dp[n]

```

这个版本的时间复杂度是O(n),因为它涉及一次遍历从2到n的所有数字。空间复杂度也是O(n),因为需要一个大小为n的数组来存储中间结果。

需要注意的是,动态规划算法的空间复杂度可以通过优化存储来降低。比如,在斐波那契数列的例子中,我们不需要存储所有的状态,只需要保留最近两个状态即可。

## 3.3 分治算法的效率分析

分治算法是将复杂问题分解成相似的子问题,并递归地解决这些子问题,然后合并子问题的解以得到原问题的解。分治策略是递归算法的一种形式,但它更强调问题的分割和子问题的独立性。

### 3.3.1 分治策略的理论基础

分治算法的基本步骤包括:

1. **分割**:将原问题划分为若干个规模较小但类似于原问题的子问题。

2. **解决**:递归地解决各个子问题。如果子问题足够小,则直接求解。

3. **合并**:将子问题的解合并为原问题的解。

分治算法的关键在于第三步,也就是合并阶段,它决定了算法的效率。例如,在归并排序中,分治策略将数组分为两半,分别进行排序,然后将排序好的两半归并在一起。

### 3.3.2 分治算法案例分析和效率评估

以归并排序为例,我们分析其效率:

```python

def merge_sort(arr):

if len(arr) > 1:

mid = len(arr) // 2

left_half = arr[:mid]

right_half = arr[mid:]

merge_sort(left_half)

merge_sort(right_half)

i = j = k = 0

while i < len(left_half) and j < len(right_half):

if left_half[i] < right_half[j]:

arr[k] = left_half[i]

i += 1

else:

arr[k] = right_half[j]

j += 1

k += 1

while i < len(left_half):

arr[k] = left_half[i]

i += 1

k += 1

while j < len(right_half):

arr[k] = right_half[j]

j += 1

k += 1

return arr

```

归并排序的时间复杂度分析:

1. 分割步骤的时间复杂度是O(1)。

2. 解决步骤中,每次递归都将数组分为两半,总共需要log(n)层递归。

3. 合并步骤在每层递归中需要O(n)时间。

因此,归并排序的总体时间复杂度是O(nlogn)。

从效率评估的角度,分治算法适合于解决可以自然分割的问题,并且子问题之间的合并步骤是有效的。归并排序在最坏、平均和最佳情况下都保持了O(nlogn)的时间复杂度,这使得它成为一种非常稳定的排序算法。此外,分治算法还适用于快速排序、二分搜索等其他经典算法的实现。

```mermaid

graph TD

A[开始归并排序] --> B[分割数组]

B --> C[递归排序左半部分]

B --> D[递归排序右半部分]

C --> E[合并左半部分]

D --> F[合并右半部分]

E --> G[合并左右两部分]

F --> G

G --> H[结束归并排序]

```

分治算法的一个关键优势是它通常可以提供较优的时间复杂度,但它对子问题的独立性要求较高。在实际应用中,除了评估算法的时间复杂度,还要考虑算法的稳定性和实际内存使用情况,以确保算法在不同的应用场景下都能高效运行。

```

# 4. Python算法效率优化实践

在上一章中,我们深入了解了递归、动态规划和分治算法的效率分析方法。现在,我们将通过实践案例来探讨如何优化Python算法的效率。我们将重点关注时间复杂度的优化、数据结构选择以及利用现有工具和库来提升算法性能。

## 4.1 利用算法优化减少时间复杂度

### 4.1.1 优化策略和方法

在编程中,时间复杂度是我们关注的核心指标之一。为了减少算法的时间复杂度,我们可以采取以下策略:

- **优化算法逻辑**:在设计算法时,尽可能地简化步骤,减少不必要的计算。

- **使用有效的数据结构**:不同的数据结构有不同的操作效率,例如,使用哈希表(字典)来替代列表进行快速查找。

- **避免递归**:递归算法虽然简洁,但往往伴随着较高的时间复杂度,可以通过循环替代递归减少计算。

- **使用高级算法**:对于特定的问题,使用已经优化过的高级算法,如快速排序比冒泡排序效率高。

### 4.1.2 实际案例分析:排序算法优化

让我们通过一个经典案例来实践这些策略,这里以排序算法为例进行分析。假设我们需要实现一个排序功能,原始的冒泡排序算法时间复杂度为O(n^2),我们尝试优化它。

```python

def optimized_bubble_sort(arr):

n = len(arr)

for i in range(n):

swapped = False

for j in range(0, n-i-1):

if arr[j] > arr[j+1]:

arr[j], arr[j+1] = arr[j+1], arr[j]

swapped = True

# 如果一次遍历中没有发生交换,则数组已经排序完成,可以提前结束循环

if not swapped:

break

return arr

```

在上述代码中,我们添加了一个`swapped`变量来检测在内层循环中是否有元素交换。如果没有元素交换,意味着数组已经排序完成,我们可以提前结束排序过程。这样,在最理想的情况下(数组已经排序),时间复杂度可以减少到O(n)。

## 4.2 利用数据结构优化空间复杂度

### 4.2.1 选择合适的数据结构

在Python中,选择合适的数据结构对于优化空间复杂度至关重要。下面,我们将探讨如何根据需求选择合适的数据结构以减少空间消耗。

- **使用集合(set)代替列表(list)**:当你需要进行成员检查且不关心顺序时,使用集合会更节省空间。

- **使用字典(dict)优化查找操作**:字典提供了平均时间复杂度为O(1)的快速查找功能。

- **使用双端队列(deque)优化队列操作**:当需要频繁的从队列两端进行添加和删除操作时,collections模块的deque是一个很好的选择。

### 4.2.2 空间复杂度优化的实际例子

接下来,我们通过一个空间复杂度优化的例子来说明如何应用上述原则。考虑实现一个函数,用于从一组数据中找出所有的重复元素,原始方法可能需要额外的空间来存储这些重复数据。

```python

def find_duplicates(nums):

seen = set()

duplicates = set()

for num in nums:

if num in seen:

duplicates.add(num)

else:

seen.add(num)

return list(duplicates)

```

在这个函数中,我们使用集合`seen`来记录已经遇到的数字,并且用另一个集合`duplicates`来记录重复的数字。由于集合在Python中是基于哈希表实现的,它的查找和插入操作的时间复杂度为O(1)。

## 4.3 算法效率优化工具和库的使用

### 4.3.1 Python内建分析工具介绍

Python提供了一些内建的工具来帮助开发者分析代码的效率。`timeit`模块就是用来测量小段代码的执行时间的工具,非常适合于比较不同算法的效率。

```python

import timeit

def test_timeit():

# 使用timeit来测试执行时间

setup_code = '''

def function_to_test():

return [x**2 for x in range(1000)]

test_code = "function_to_test()"

number = 100

time = timeit.timeit(test_code, setup=setup_code, number=number)

print(f"{test_code} executed {number} times takes {time} seconds")

```

### 4.3.2 第三方库在算法效率分析中的应用

除了内建工具,还有许多第三方库可以帮助我们分析和优化Python代码。例如,`line_profiler`是一个非常有用的工具,可以精确地测量每一行代码的执行时间。

安装`line_profiler`:

```shell

pip install line_profiler

```

使用`line_profiler`对代码进行分析:

```python

import line_profiler

def my_function():

# 一些代码

pass

if __name__ == "__main__":

profiler = line_profiler.KernelTimer()

profiler.add_function(my_function)

profiler.print_stats()

```

`line_profiler`通过使用装饰器来追踪函数的运行时间,并以详细的报告形式呈现每一行代码的性能消耗,这对优化算法非常有帮助。

以上就是第四章“Python算法效率优化实践”的内容,我们通过具体的案例分析和工具应用,学习了如何优化算法的时间和空间复杂度。在下一章中,我们将探讨更高级的优化话题,包括并行算法和多线程优化以及大数据和机器学习算法的效率分析。

# 5. Python算法效率分析的高级话题

## 5.1 并行算法和多线程优化

### 5.1.1 并行算法的基本原理

随着计算机硬件的发展,CPU的多核处理能力日益增强。并行算法利用多核处理器的能力,通过同时执行多个计算任务来提高计算效率。并行算法的基本原理是将大任务分解为小任务,分配给不同的处理单元并行处理,然后将结果汇总。

在Python中,可以使用`threading`模块实现多线程,并用`multiprocessing`模块实现多进程。多线程适用于I/O密集型任务,因为Python的全局解释器锁(GIL)限制了多线程在CPU密集型任务上的表现。而多进程不受GIL限制,适合CPU密集型任务。

### 5.1.2 Python中的多线程编程和性能提升

多线程编程的典型模式是创建一个主线程,然后根据需要创建多个工作线程。下面是一个简单的Python多线程示例代码:

```python

import threading

import time

def print_numbers():

for i in range(1, 6):

time.sleep(1)

print(i)

def print_letters():

letters = ['a', 'b', 'c', 'd', 'e']

for letter in letters:

time.sleep(1.5)

print(letter)

if __name__ == "__main__":

t1 = threading.Thread(target=print_numbers)

t2 = threading.Thread(target=print_letters)

t1.start()

t2.start()

t1.join()

t2.join()

```

在使用多线程时,需要注意线程同步和数据一致性问题,这通常通过锁(Locks)、信号量(Semaphores)、事件(Events)等同步机制来解决。Python提供了`threading`模块中的`Lock`类来防止资源竞争。

### 5.1.3 Python中的多进程编程和性能提升

多进程通过创建多个进程来分配任务,由于每个进程拥有自己的内存空间,它们之间不会受到GIL的限制。`multiprocessing`模块提供了一种方便的方法来创建和管理进程。

下面是一个简单的Python多进程示例代码:

```python

from multiprocessing import Process

import time

def print_numbers():

for i in range(1, 6):

time.sleep(1)

print(i)

if __name__ == "__main__":

processes = []

for _ in range(5):

p = Process(target=print_numbers)

processes.append(p)

p.start()

for p in processes:

p.join()

```

多进程适用于CPU密集型任务,因为它们可以并行运行在多核心上,从而提升程序运行效率。然而,创建和销毁进程是有开销的,所以在处理小型任务时,进程的创建和销毁时间可能会超过任务本身的执行时间,反而降低效率。

## 5.2 大数据与算法效率

### 5.2.1 大数据环境下算法效率的挑战

大数据环境下,数据量级往往达到TB甚至PB级别。这些数据的存储、传输、处理都需要高效的算法支持。大数据带来的算法效率挑战包括:

- 数据读写速度:传统硬盘I/O性能成为瓶颈。

- 内存限制:单机内存难以容纳大数据,需要分布式处理。

- 数据并行处理:需要将数据分布式存储,并行处理。

### 5.2.2 面向大数据的高效算法设计

面向大数据的高效算法设计需要考虑以下几个方面:

- 数据预处理:例如,使用MapReduce模型先对数据进行过滤、排序等。

- 分布式存储:采用如Hadoop分布式文件系统(HDFS)等技术来存储数据。

- 并行计算框架:使用如Apache Spark、Apache Flink等框架来进行大规模数据处理。

例如,在MapReduce模型中,大数据集首先被分割成较小的块,并由多个Map任务并行处理。然后将结果汇总并进行Reduce操作,最终得到期望的结果。

## 5.3 机器学习算法效率分析

### 5.3.1 机器学习算法的时间复杂度特点

机器学习算法通常涉及大量的矩阵运算和优化问题。这些运算在时间复杂度上往往是非常高的,尤其是深度学习模型。例如,神经网络前向传播和反向传播的时间复杂度通常与层数和每层的节点数的乘积成正比。

为了优化这些算法的时间复杂度,可以采取以下措施:

- 优化数据结构和算法逻辑,减少不必要的计算。

- 使用高效的数学库,比如NumPy,可以利用底层优化提升计算速度。

- 使用GPU加速计算,特别适用于矩阵运算。

### 5.3.2 如何评估和优化机器学习算法的效率

评估机器学习算法的效率可以从以下几个维度:

- 训练时间:算法从开始训练到收敛所需的时间。

- 预测时间:算法生成预测结果的时间。

- 模型大小:模型占用的存储空间。

- 准确性:模型预测结果的准确性。

为了优化机器学习算法的效率,可以考虑以下策略:

- 使用更加高效的算法和模型结构,例如卷积神经网络(CNN)用于图像识别。

- 应用正则化技术,如L1、L2正则化,减少过拟合,提升训练效率。

- 使用剪枝、量化等技术减少模型的存储空间和计算量。

通过这些方法,可以在保证模型性能的前提下,有效地提高机器学习算法的效率。

0

0