【协同机器学习技术】:验证集与其他技术的完美结合,提升模型效率

发布时间: 2024-11-23 07:44:14 阅读量: 27 订阅数: 37

VB+ACCESS大型机房学生上机管理系统(源代码+系统)(2024n5).7z

# 1. 协同机器学习技术概述

## 协同机器学习的定义

协同机器学习是一种分布式学习框架,允许多个学习者(模型或节点)共同训练和优化一个模型,通过分享彼此的知识来提高学习效率和模型性能。其核心思想是通过合作而不是竞争来提升机器学习的整体效果。

## 协同机器学习的背景与应用场景

该技术起源于分布式计算和协作学习的概念,主要应用于数据隐私要求高的场景,以及在大规模数据集上训练模型时,无法将所有数据集中到单个计算中心的场合。通过协同学习,各个节点可以仅使用局部数据进行训练,并通过一个协调器来进行全局模型的更新。

## 协同机器学习的技术优势

协同机器学习技术相较于传统集中式学习方法,有诸多优势,例如减少了对中心数据存储的依赖,降低了通信成本,并且提高了系统的鲁棒性和可扩展性。同时,它还可以帮助保护数据的隐私和安全,这对于多个行业,尤其是金融和医疗行业,具有极其重要的意义。

通过本章的介绍,我们将奠定协同机器学习技术的基础框架,并为后续章节深入探讨数据集在该技术中的作用打下理论基础。

# 2. 数据集在机器学习中的作用

## 2.1 训练集、验证集和测试集的理论基础

### 2.1.1 数据集划分的目的和原则

在机器学习中,将可用的数据集划分为不同的子集是至关重要的。数据集的划分能够让我们更加准确地评估模型的泛化能力。根据划分的目的,数据集主要可以分为三类:训练集、验证集和测试集。训练集用于模型的参数学习,验证集用于模型选择和调参,测试集则用于最终评估模型的性能。

划分数据集应遵循的原则包括:

- **独立同分布**:训练集、验证集和测试集都应当是从原始数据集独立同分布地抽取,以保证模型对数据的泛化能力。

- **不重叠原则**:三个子集之间不应有重叠,以避免评估时数据的泄漏。

- **比例原则**:三个子集的大小应根据具体任务的需求来划分,通常训练集占比最大,验证集和测试集根据实验设计来分配。

### 2.1.2 不同数据集的特点与作用

每个数据集在机器学习流程中扮演着不同的角色。

- **训练集**:训练集的作用是让模型通过它来学习数据中的规律性。训练集中的数据量通常决定了模型能否捕捉到足够多的特征。

- **验证集**:在模型的训练过程中,使用验证集来评估模型的性能,帮助选择最佳的模型参数。在超参数调整和模型选择时,验证集起到关键作用。

- **测试集**:测试集用于在模型训练完成后评估模型对未知数据的预测能力。测试集应保持在模型训练过程中未被查看,以确保评估的公正性和准确性。

## 2.2 验证集的重要性及其选择方法

### 2.2.1 验证集在模型训练中的角色

在模型训练过程中,验证集扮演着“老师”的角色,帮助模型学习和调整。每经过一轮模型更新后,我们使用验证集对模型进行测试,并根据测试结果调整模型的参数或选择更合适的模型架构。这种方法可以防止模型过度适应训练集,即避免过拟合。

### 2.2.2 验证集选择的策略和技巧

选择验证集的方法会直接影响到模型的最终表现。

- **随机划分法**:这是最简单的划分方法,它随机地将数据集划分为训练集和验证集。随机划分简单易行,但可能会受到数据分布不均的影响。

- **分层划分法**:考虑到数据的分布,分层划分法按照类别或某个属性保持各子集的分布与原始数据集一致。这有助于在验证集上更好地评估模型性能。

- **时间序列划分法**:在时间序列数据中,这种划分方法将早期数据作为训练集,后期数据作为验证集。这种方法特别适用于预测未来趋势的场景。

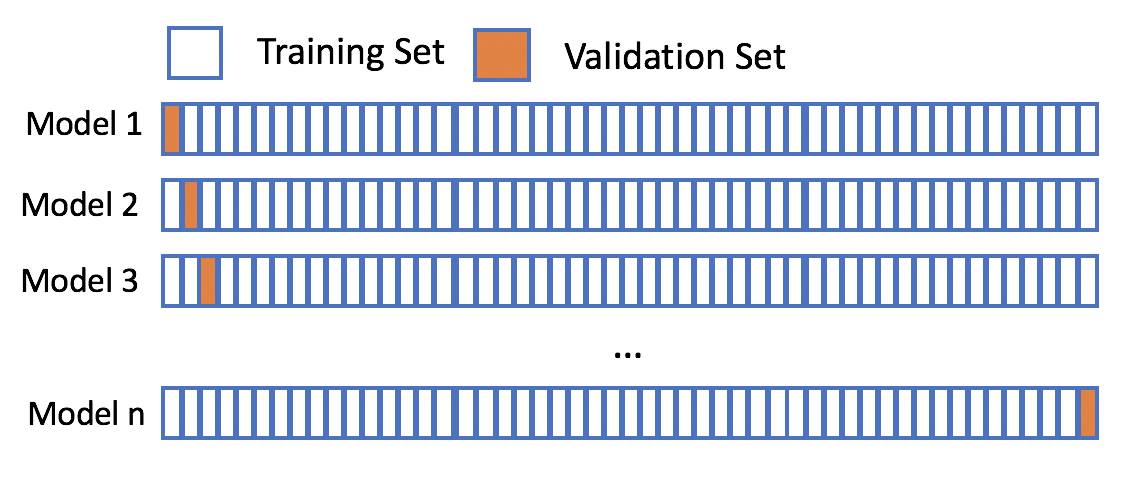

验证集选择的一个重要策略是K折交叉验证,它通过多次划分数据集,并在每次划分中选择不同的验证集,然后将多次验证的结果平均,得到更加稳定可靠的性能评估。

```python

from sklearn.model_selection import KFold

# 假设有一个训练数据集X和标签y

X = ... # 训练数据集特征

y = ... # 训练数据集标签

kf = KFold(n_splits=5) # 使用5折交叉验证

for train_index, val_index in kf.split(X):

X_train, X_val = X[train_index], X[val_index]

y_train, y_val = y[train_index], y[val_index]

# 在这里进行模型训练和验证

...

```

以上代码展示了如何使用`sklearn`库中的`KFold`进行5折交叉验证。在每次迭代中,`train_index`和`val_index`指示了训练集和验证集的索引,使得我们可以分离出当前的训练集和验证集进行模型训练和验证。

下面是一个具体的mermaid流程图,详细描述了K折交叉验证的过程。

```mermaid

graph LR

A[开始交叉验证] --> B[划分训练集和验证集]

B --> C[训练模型]

C --> D[验证模型]

D --> E{所有折数完成?}

E -- 是 --> F[计算平均性能指标]

E -- 否 --> B

F --> G[结束交叉验证]

```

在这个流程中,模型在每一折的训练集上被训练,在对应的验证集上被验证,直到所有的折数都完成,最后计算模型在各次验证中的平均性能指标。这种方法可以减少因数据划分不同导致的模型性能评估误差。

# 3. 协同机器学习技术与验证集的结合

## 3.1 协同机器学习的基础与优势

### 3.1.1 协同学习的概念和发展历程

协同学习是一种机器学习范式,它允许多个学习者(或模型)合作以提高整体的性能。不同于传统的集中式学习,协同学习强调的是多个学习者之间通过某种形式的通信机制进行信息共享和学习。这种范式在提高模型性能的同时,还能保证数据隐私和分布式计算的优势。

在发展过程中,协同学习经历了从简单的集成学习到复杂的网络协同学习模型的演变。早期的集成学习模型如Bagging和Boosting,为协同学习的发展奠定了基础。随后,更多专注于分布式环境下模型训练的算法被提出,如联邦学习、差分隐私学习等,这

0

0